背景:某头部电商平台在双十一大促期间,通过精准的 QPS、TPS 评估和容量规划,成功将系统承载能力从每秒 10 万请求提升至 50 万+,同时保持 99.99%的服务稳定性。本文将深入解析 QPS、TPS 与系统容量规划的关系,并结合实际案例提供落地指南。

一、QPS、TPS 的核心概念与关系

1.1 核心定义

# 关键术语

1. **QPS(Queries Per Second)**:每秒查询数,衡量系统的请求处理能力。

2. **TPS(Transactions Per Second)**:每秒事务数,通常指完整的业务逻辑操作。

3. **系统容量**:系统能承载的最大QPS/TPS,受硬件资源、软件设计、网络带宽等限制。

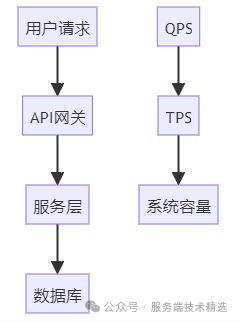

1.2 QPS 与 TPS 的关系

-

关键点:

-

一个 QPS 可能包含多个 TPS(如一次请求触发多步事务)。

-

容量规划需综合考虑 QPS 与 TPS 的比例关系。

-

二、实战案例:电商订单系统的容量规划 🔥

2.1 业务背景

- 需求描述:

每秒需处理50万+订单请求,保障库存扣减准确性和支付成功率。 -

原始痛点:

-

数据库连接池耗尽,高峰期服务不可用。

-

缓存击穿导致热点商品查询超时。

-

系统瓶颈难以量化,扩容缺乏依据。

-

2.2 解决方案

压测评估 QPS 与 TPS

使用 JMeter 进行压测

<!-- JMeter配置文件 -->

<TestPlan>

<ThreadGroup guiclass="ThreadGroupGui" testclass="ThreadGroup">

&l

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1528

1528

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?