GUP计算是目前比较热门的处理并行计算的一种方式,使用这个方式可以通过多种方法,其中微软封装的AMP是对C++开发者最友善的一种模式。

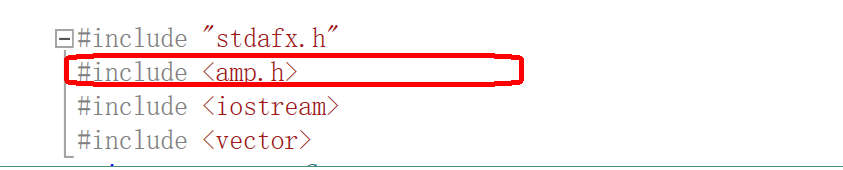

AMP需要至少在Visual Studio 2012版本上运行,引用方式非常的简单,如下:

只要在Window程序中添加引用<amp.h>头文件即可调用AMP方式的GPU运算。

同时,执行方式也很简单,采用了一种C++循环头的模式来自动使程序在GPU环境下运行,只需要把要计算的数据值填入AMP的array_view数组中即可使用,array_view数组可以1维的,也可以是多维的,可以通过array_view数组传入或是传出数据,这样就让编程变的异常简单,但同时由于数据要通过array_view在CPU运行空间和GPU运行空间中进行数据的转换,因此也造成了效率的损失。

我写的一段测试代码就出现了这个问题,我把代码贴出来,大家可以看看这个代码的运行情况,以及运行效率,大佬们可以给些意见和建议。

#include "stdafx.h"

#include <amp.h>

#include <iostream>

#include <vector>

using namespace Concurrency;

const double PI = 3.14159265358979323846;

const size_t size = 10000000;//循环次数

//GPU计算

void GPUCompute(std::vector<double> vec)

{

DWORD t1, t2;

t1 = GetTickCount();

std::vector<double> resultVec;

resultVec.resize(size);

array_view<const double, 1> array1(size, vec);

array_view<const double, 1> array2(size, vec);

array_view<double, 1> result(size, resultVec);

t2 = GetTickCount();

std::cout << "GPU Use Time Init:" << (t2 - t1)*1.0 / 1000 << "\n";

t1 = GetTickCount();

//GPU计算部分

parallel_for_each(result.extent, [=](index<1> idx) restrict(amp)

{

result[idx] = array1[idx] * array1[idx] * array2[idx] / array2[idx];

});

result.synchronize();

t2 = GetTickCount();

std::cout << "GPU Use Time Cal:" << (t2 - t1)*1.0 / 1000 << "\n";

}

//CPU计算

void CPUCompute(std::vector<double> vec)

{

DWORD t1, t2;

t1 = GetTickCount();

std::vector<double> result;

result.resize(size);

std::vector<double> array1 = vec;

std::vector<double> array2 = vec;

t2 = GetTickCount();

std::cout << "CPU Use Time Init:" << (t2 - t1)*1.0 / 1000 << "\n";

t1 = GetTickCount();

for (size_t i = 0; i < size; i++)

{

result[i] = array1[i] * array1[i] * array2[i] / array2[i];

}

t2 = GetTickCount();

std::cout << "CPU Use Time Cal:" << (t2 - t1)*1.0 / 1000 << "\n";

}

int _tmain(int argc, _TCHAR* argv[])

{

std::vector<double> nums;

for (size_t i = 0; i < size; i++)

{

nums.push_back(PI);

}

GPUCompute(nums);

CPUCompute(nums);

system("PAUSE ");

}执行结果:

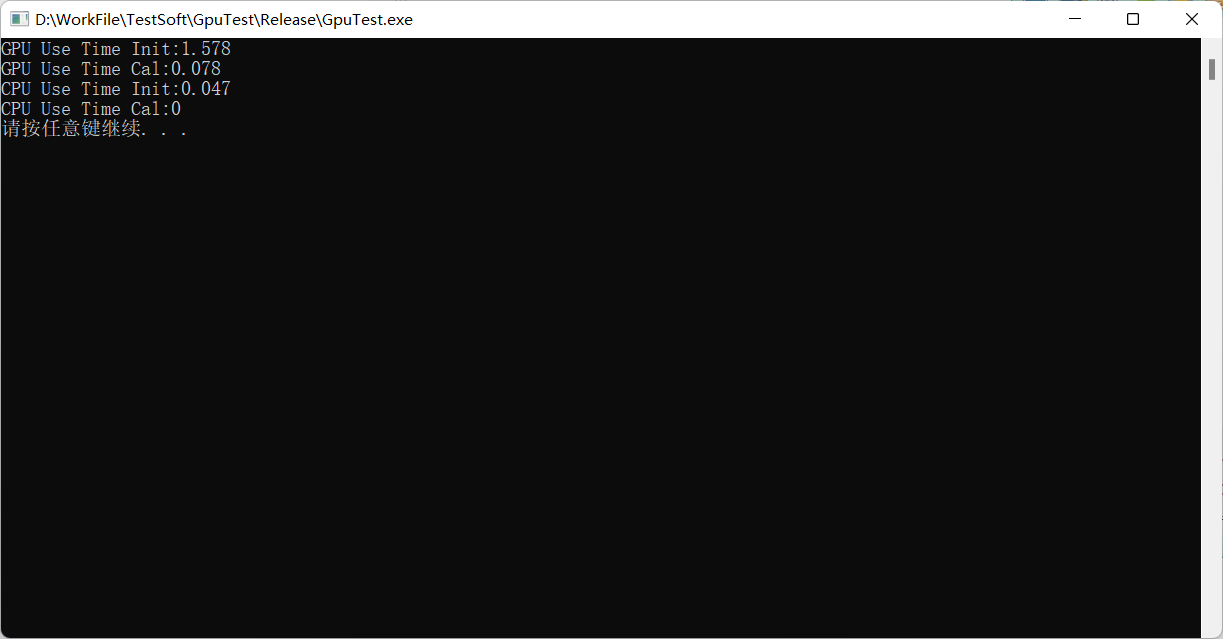

从运行结果上看CPU运行明显要快于GPU。我也试过把计算过程调整为比较复杂的运算,这种情况下,在数量较小时GPU没有优势,在达到一定数量时,GPU会优于CPU,但数量继续增大,优于拷贝过于费时,GPU的效率又变差了。

仅是我个人的一些测试,望大家指正。

文章通过一个简单的测试代码展示了使用微软的AMP库进行GPU计算的过程,与CPU计算进行对比。在数据量较小的情况下,CPU计算可能更快,因为GPU计算涉及数据在CPU和GPU间转换的开销。当数据量增加到一定程度,GPU的优势显现,但随着数据量进一步增大,拷贝时间增加导致GPU效率下降。

文章通过一个简单的测试代码展示了使用微软的AMP库进行GPU计算的过程,与CPU计算进行对比。在数据量较小的情况下,CPU计算可能更快,因为GPU计算涉及数据在CPU和GPU间转换的开销。当数据量增加到一定程度,GPU的优势显现,但随着数据量进一步增大,拷贝时间增加导致GPU效率下降。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?