题目:FEED-FORWARD NETWORKS WITH ATTENTION CAN SOLVE SOME LONG-TERM MEMORY PROBLEMS” (Raffel 和 Ellis, 2016, p. 1)

“带有注意力的前馈网络可以解决一些长期记忆问题” (Raffel 和 Ellis, 2016, p. 1) (pdf)

这篇论文提出了一种适用于前馈神经网络的简化注意力模型,并展示了这个模型可以解决序列长度比已发布的最佳结果更长和变化范围更广的合成“加法”和“乘法”长期记忆问题

这篇论文提出了一种适用于前馈神经网络的简化注意力模型,并展示了这个模型可以解决序列长度比已发布的最佳结果更长和变化范围更广的合成“加法”和“乘法”长期记忆问题【19†source】。

原理

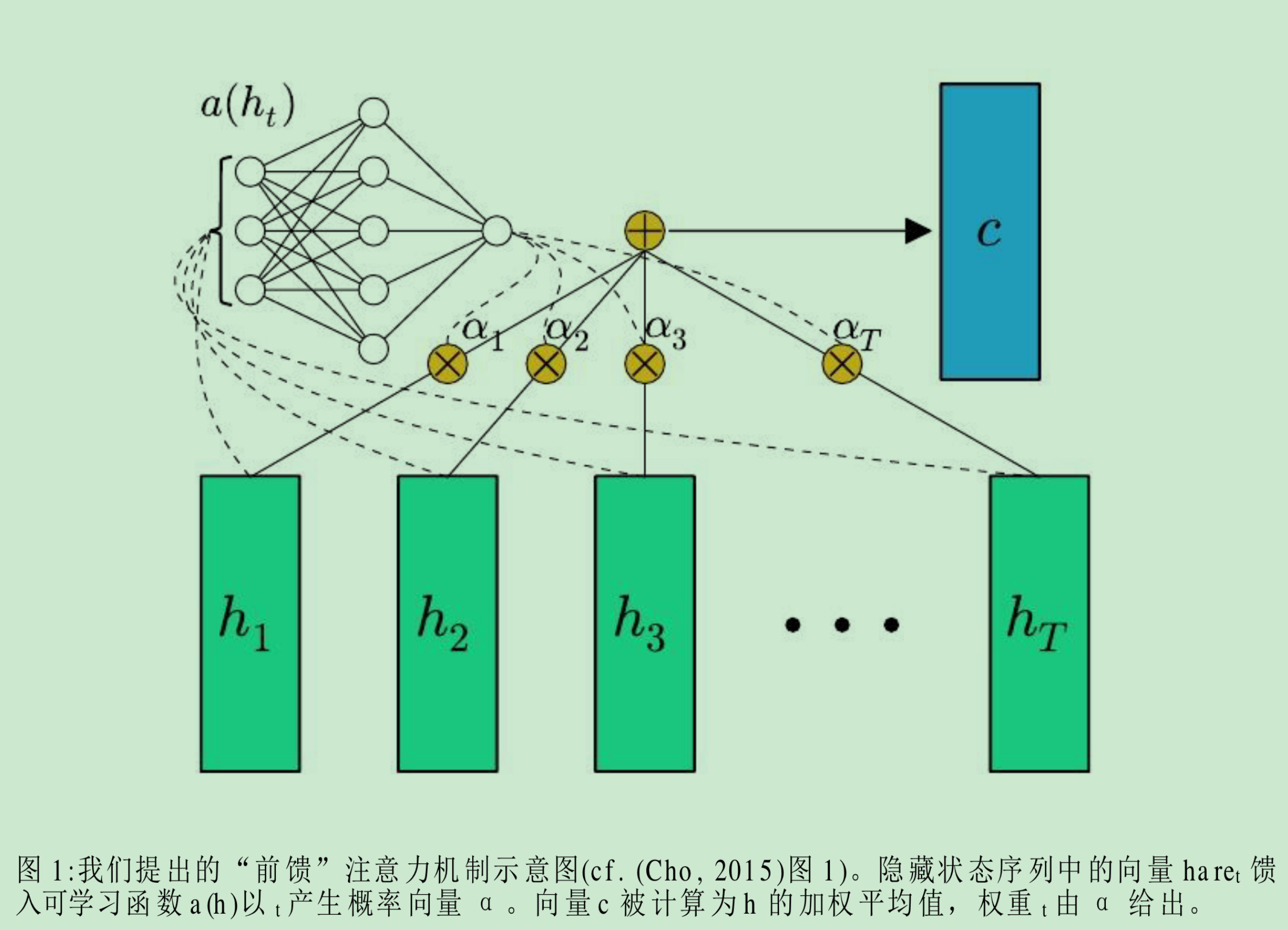

注意力机制允许模型的不同时间点状态之间有更直接的依赖关系。在这篇论文中,注意力基础模型在每个时间步骤产生一个隐藏状态 ( h_t ),然后计算一个作为状态序列加权平均的“上

论文介绍了一种简化注意力模型,应用于前馈神经网络,能处理更长且变化范围广的序列。注意力机制增强模型处理长序列的能力,但对时间顺序敏感的任务有所限制。作者认为在某些场景中,如文本文档分类,这种方法有效。代码开源可供研究者参考。

论文介绍了一种简化注意力模型,应用于前馈神经网络,能处理更长且变化范围广的序列。注意力机制增强模型处理长序列的能力,但对时间顺序敏感的任务有所限制。作者认为在某些场景中,如文本文档分类,这种方法有效。代码开源可供研究者参考。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

4040

4040

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?