该模块基于我们提出的一种结合经典级联结构和多层神经网络的人脸检测方法[1]实现,其所采用的漏斗型级联结构(Funnel-Structured Cascade,FuSt)专门针对多姿态人脸检测而设计,其中引入了由粗到精的设计理念,兼顾了速度和精度的平衡。如图1所示,FuSt级联结构在顶部由多个针对不同姿态的快速LAB级联分类器[2]构成,紧接着是若干个基于SURF特征的多层感知机(MLP)级联结构,最后由一个统一的MLP级联结构(同样基于SURF特征)来处理所有姿态的候选窗口,整体上呈现出上宽下窄的漏斗形状。从上往下,各个层次上的分类器及其所采用的特征逐步变得复杂,从而可以保留人脸窗口并排除越来越难与人脸区分的非人脸候选窗口。

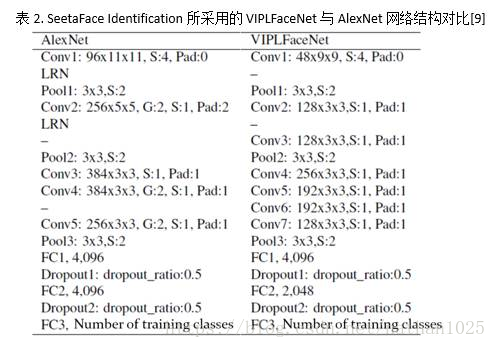

SeetaFace开源的人脸特征提取模块也是基于卷积神经网络的。具体地说,其实现的是[9]中所描述的深度卷积神经网络VIPLFaceNet:一个包含7个卷积层与2个全连接层的DCNN。其直接修改自Hinton教授的学生Alex Krizhevsky等于2012年设计的AlexNet(即引爆CNN在视觉中广泛应用的网络)。如表2对比所示,与AlexNet相比,VIPLFaceNet将5x5的卷积核拆分为两层3x3的卷积核,从而增加了网络深度,而并没有增加计算量;VIPLFaceNet还减少了每个卷积层的kernel数目以及FC2层的节点数。同时,通过引入Fast Normalization Layer(FNL),加速了VIPLFaceNet的收敛速度,并在一定程度上提升了模型的泛化能力。测试表明,在相同训练集情况下,VIPLFaceNet在LFW测试集上识别错误率比AlexNet降低了40%,而训练和测试时间分别为AlexNet的20%和60%。

本文介绍了一种结合经典级联结构与多层神经网络的人脸检测方法,该方法利用漏斗型级联结构实现多姿态人脸的有效检测。此外,还介绍了基于深度卷积神经网络VIPLFaceNet的人脸特征提取技术,该网络通过对AlexNet的改进,在保持较高识别精度的同时显著降低了计算成本。

本文介绍了一种结合经典级联结构与多层神经网络的人脸检测方法,该方法利用漏斗型级联结构实现多姿态人脸的有效检测。此外,还介绍了基于深度卷积神经网络VIPLFaceNet的人脸特征提取技术,该网络通过对AlexNet的改进,在保持较高识别精度的同时显著降低了计算成本。

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?