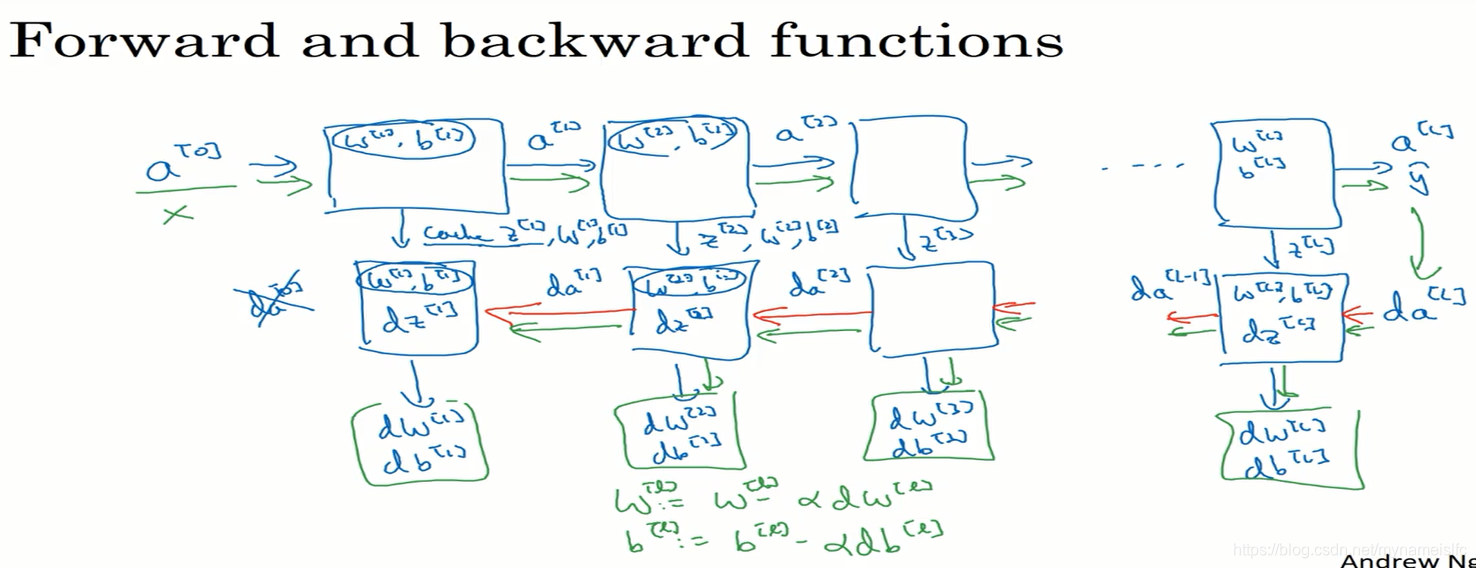

此次主要学习了在搭建一个深层神经网络模块时,需要注意到哪些内容,本文将通过下图进行说明:

上图描述的是一个深层神经网络模型正向和反向传播的过程。每一个方框代表着一个隐藏层。

从图中得出,有几处要点需要注意:

(1)正向传播过程中,需要将每一层的z[l]、w[l]、b[l]z^{[l]}、w^{[l]}、b^{[l]}z[l]、w[l]、b[l]进行缓存,方便反向传播时使用(尤其是在编写代码时须注意)。

(2)正向传播是由a[0]a^{[0]}a[0]得到a[l]a^{[l]}a[l]的过程,反向传播是由da[l]da^{[l]}da[l]得到da[1]da^{[1]}da[1]的过程。

(3)反向传播中,每一个层会输出dw[l]、db[l]dw^{[l]}、db^{[l]}dw[l]、db[l],用于梯度下降,即更新参数。

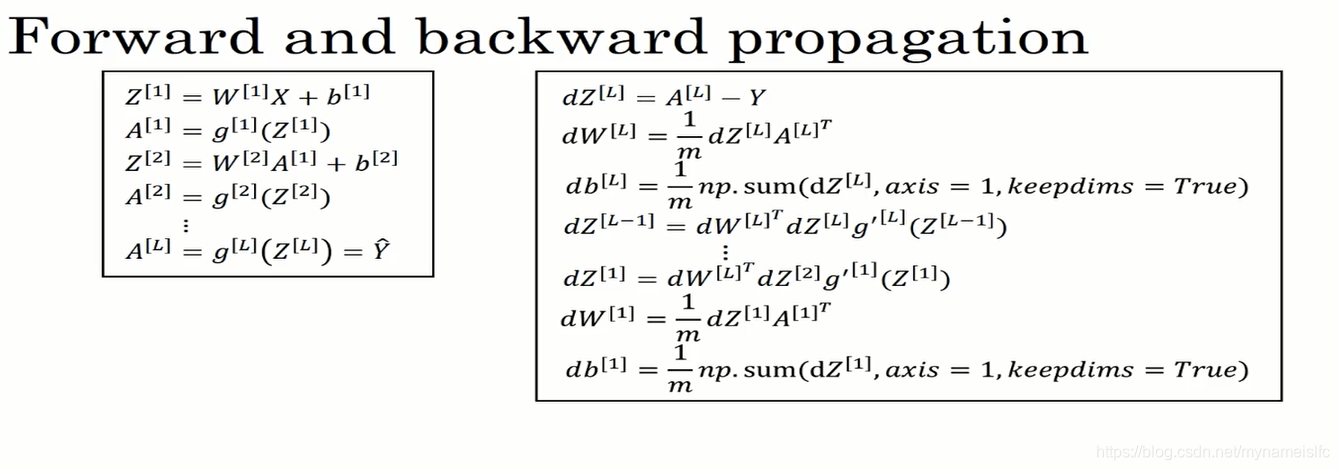

具体的公式表达形式如下图所示:

什么是超参数?

超参数是指能影响w、bw、bw、b的参数,如:学习率:α\alphaα、隐藏层数:L、隐藏单元数:n[l]n^{[l]}n[l]等等超参数决定了最终得到的参数w、bw、bw、b。因此,可以这样说,超参数是一种用于控制参数的参数。

在实际的神经网络学习中,超参数的选择有许多的可能性,所以需要尝试许多不同的值。

本文详细解析了深层神经网络的正向与反向传播过程,强调了缓存z、w、b的重要性,以及如何通过da[l]回溯到da[1]。同时,介绍了超参数的概念,包括学习率α、隐藏层数L及隐藏单元数n[l],并讨论了它们对最终参数w、b的影响。

本文详细解析了深层神经网络的正向与反向传播过程,强调了缓存z、w、b的重要性,以及如何通过da[l]回溯到da[1]。同时,介绍了超参数的概念,包括学习率α、隐藏层数L及隐藏单元数n[l],并讨论了它们对最终参数w、b的影响。

2292

2292

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?