1.各组件版本之间的的选择

https://www.cloudera.com/downloads/manager/5-16-2.html

https://docs.cloudera.com/documentation/enterprise/release-notes/topics/rn_consolidated_pcm.html#c516_supported_os

CDH5.16.2的文档地址

从下图选择相应的版本

地址为:https://docs.cloudera.com/documentation/index.html

2 CDH的正常启动和停止顺序

2.1 启动顺序

2.1.1 启动MySQL

su - mysqladmin

service mysql start

2.1.1 启动CDHserver和agent

/opt/cloudera-manager/cm-5.16.2/etc/init.d/cloudera-scm-server start 1个节点(主节点)

/opt/cloudera-manager/cm-5.16.2/etc/init.d/cloudera-scm-agent start 所有节点

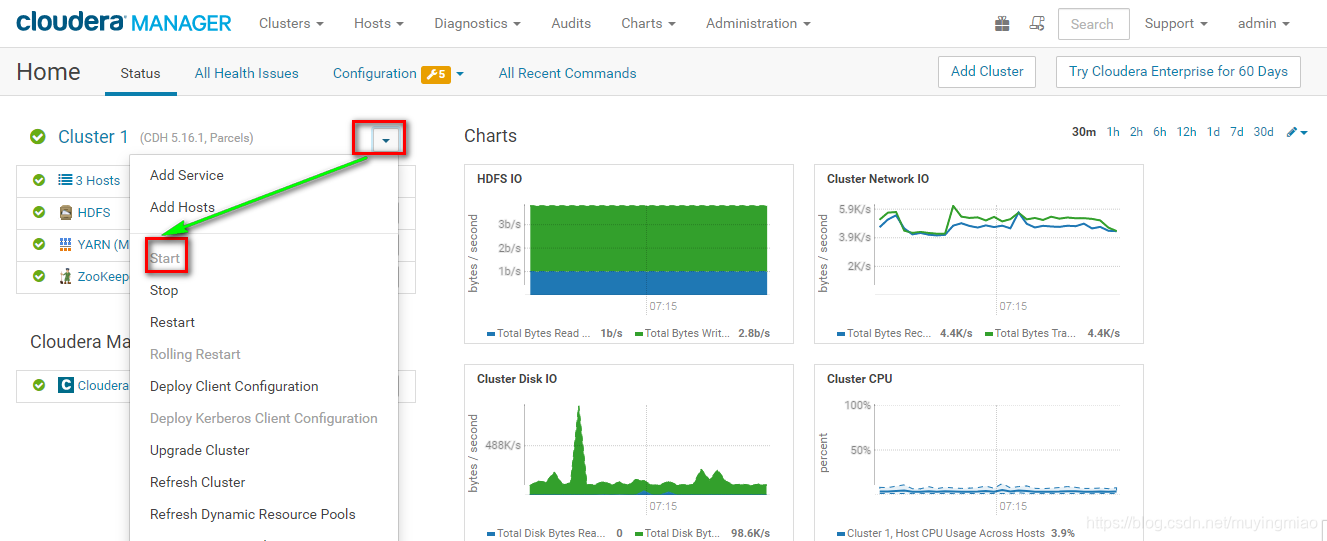

2.1.3 进入web7180,先启动 CMS 5个进程服务

启动后单击

2.1.4 启动Cluster1服务(可以全部同时启动,或者选择下面单个组件单独启动): HDFS YARN ZK KAFKA HBASE

2.2 停止顺序为启动的相反顺序

3 CDH 的架构图

Admin Console 只得是web7180的页面

API:CM的api

Management Service:CDH的5个服务

DB :元数据

仓库

修改配置CDH内部的执行步骤:client->server->DB

client->server->agent-supervisord(监督人)->各组件

配置的路径:

服务端:/opt/cloudera-manager/cm-5.16.2/run/cloudera-scm-agent/process/366-hdfs-NAMENODE

客户端Hadoop: /etc/hadoop/conf

修改配置的步骤:

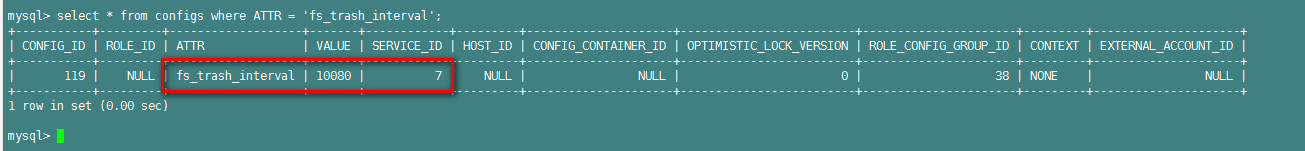

1.cmf.config表

2.服务端的配置文件带序号的

3.客户端的配置文件不带序号,默认的

PS:对于CDH,所有参数的修改都要通过WebUI修改。每次修改的参数都要生成带序号的参数文件

例子:

修改HDFS的namenode的fs.trash.interval并保存

重启HDFS使之生效

服务端的配置文件

[root@hadoop001 40-hdfs-NAMENODE]# cd /opt/cloudera-manager/cm-5.16.1/run/cloudera-scm-agent/process/40-hdfs-NAMENODE

客户端的配置(还是默认参数):

客户端gateway的使用

应用开发像spark作业要提交到Hadoop上,则spark的客户端要配置 /etc/hadoop/conf,在CDH中,客户端叫gateway

假如一台额外的机器(独立的非集群节点)需要提交作业到CDH,那么要先给此机器添加gateway,使其拥有/etc/组件名称/conf , 以便与集群打通。假如该机器正好是CDH集群的某个几点,无需部署gateway。

gateway添加步骤

gateway的state为N/A

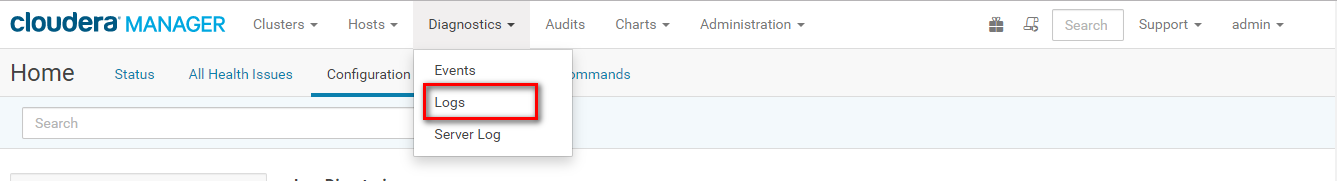

日志

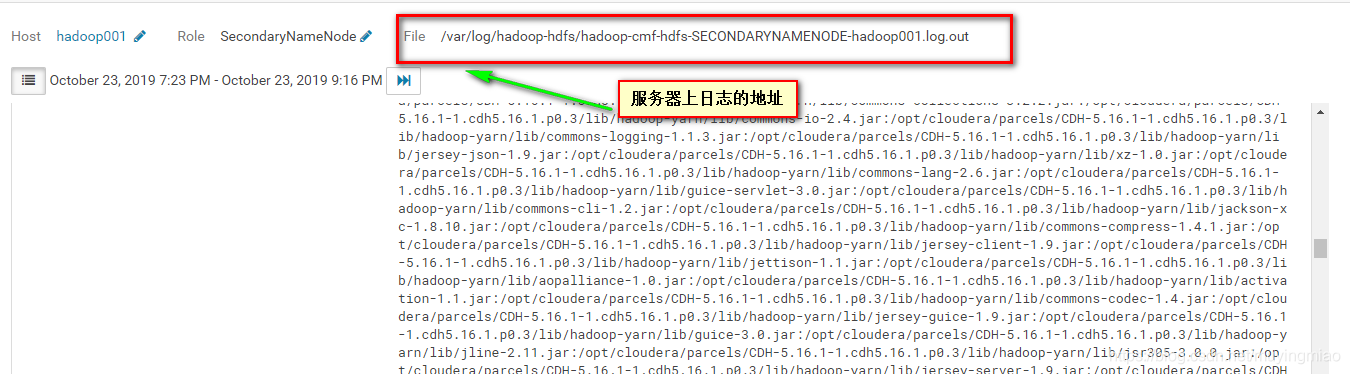

在webUI界面查看各组件的log日志目录

Server的日志目录

TAR CM的 /opt/cloudera-manager/cm-5.16.2/log/cloudera-scm-server

/opt/cloudera-manager/cm-5.16.2/log/cloudera-scm-agent

RPM部署CM :/var/log/cloudera-scm-server

/var/log/cloudera-scm-agent

WebUI界面查看日志(.log或者.out进程日志)

另外还要关注stderr和Role log的这两种日志

5.界面解读

进程 :process instance role 在CDH中是一个概念

自定义参数配置

NameNode Advanced Configuration Snippet (Safety Valve) for hdfs-site.xml

本文介绍了CDH 5.16.2的版本选择、启动与停止顺序、架构、配置修改及日志查看等核心内容。重点讲述了如何启动和停止CDH服务,以及客户端配置和gateway的设置,强调了所有参数修改必须通过WebUI进行。

本文介绍了CDH 5.16.2的版本选择、启动与停止顺序、架构、配置修改及日志查看等核心内容。重点讲述了如何启动和停止CDH服务,以及客户端配置和gateway的设置,强调了所有参数修改必须通过WebUI进行。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?