一 简介

DeepSeek-R1 模型最近在国际上和国内都很热,被称为最强的开源AI模型,性能上基本上和OpenAI的最新模型O1模型不相上下,本来我一直在用它的在线版本,不过由于最近太热导致了访问异常,据说遭受到了美国的DDos攻击,所以打算跑个本地模型试试。

二 安装Ollama

Ollama 是一个开源的大型语言模型(LLM)服务工具,旨在帮助用户在本地环境中部署和运行大规模预训练语言模型。它通过简化模型的下载、安装和管理流程,使得用户能够快速地在本地运行这些模型,并且支持多种流行模型如 LLaMA 等。

简单的一句话概括:Ollama是基于go语言开发的简单易用的本地大语言模型运行框架,其实和docker非常类似,只是Ollama的运行的是大语言模型。 Ollama还提供和OpenAI兼容的Restful接口,方便各种工具集成使用。

安装过程非常简单,到官网下载配套系统的Ollama版本即可,如下图:

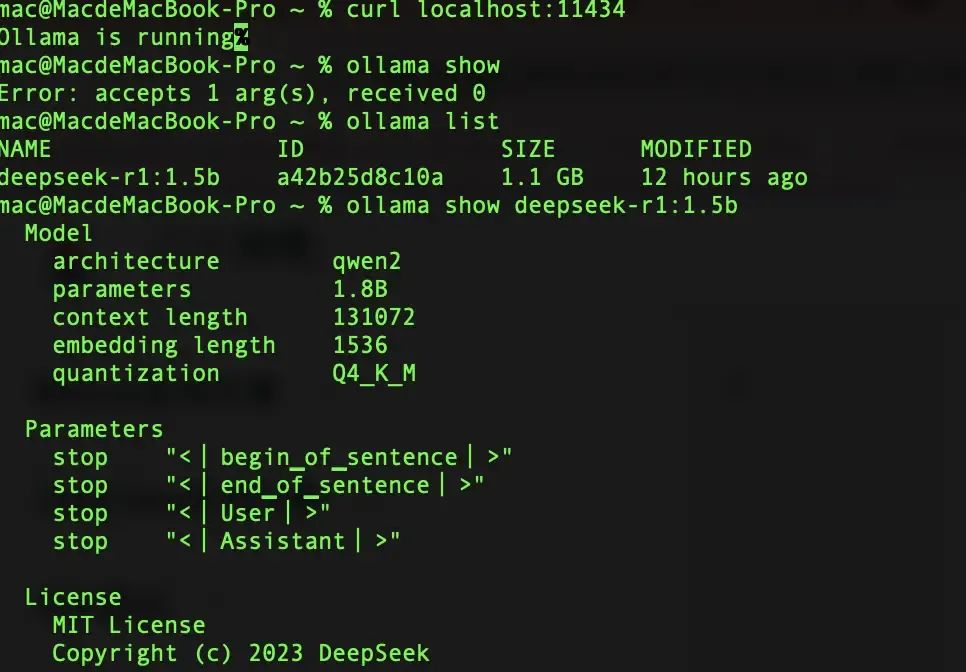

我目前电脑为MacOS,下载过程非常顺利,安装也和其他软件的安装方法一样,安装后,可以通过 curl localhost:11434 来查看ollma是否在运行了,类似docker命令,可以通过ollama list 查看已经下载的模型,也可以通过 ollama show 模型来查看模型的具体信息。

ollama支持的命令如下:

ollama list:显示模型列表。

ollama show:显示模型的信息

ollama pull:拉取模型

ollama push:推送模型

ollama cp:拷贝一个模型

ollama rm:删除一个模型

ollama run:运行一个模型

三 安装模型

3.1 安装模型

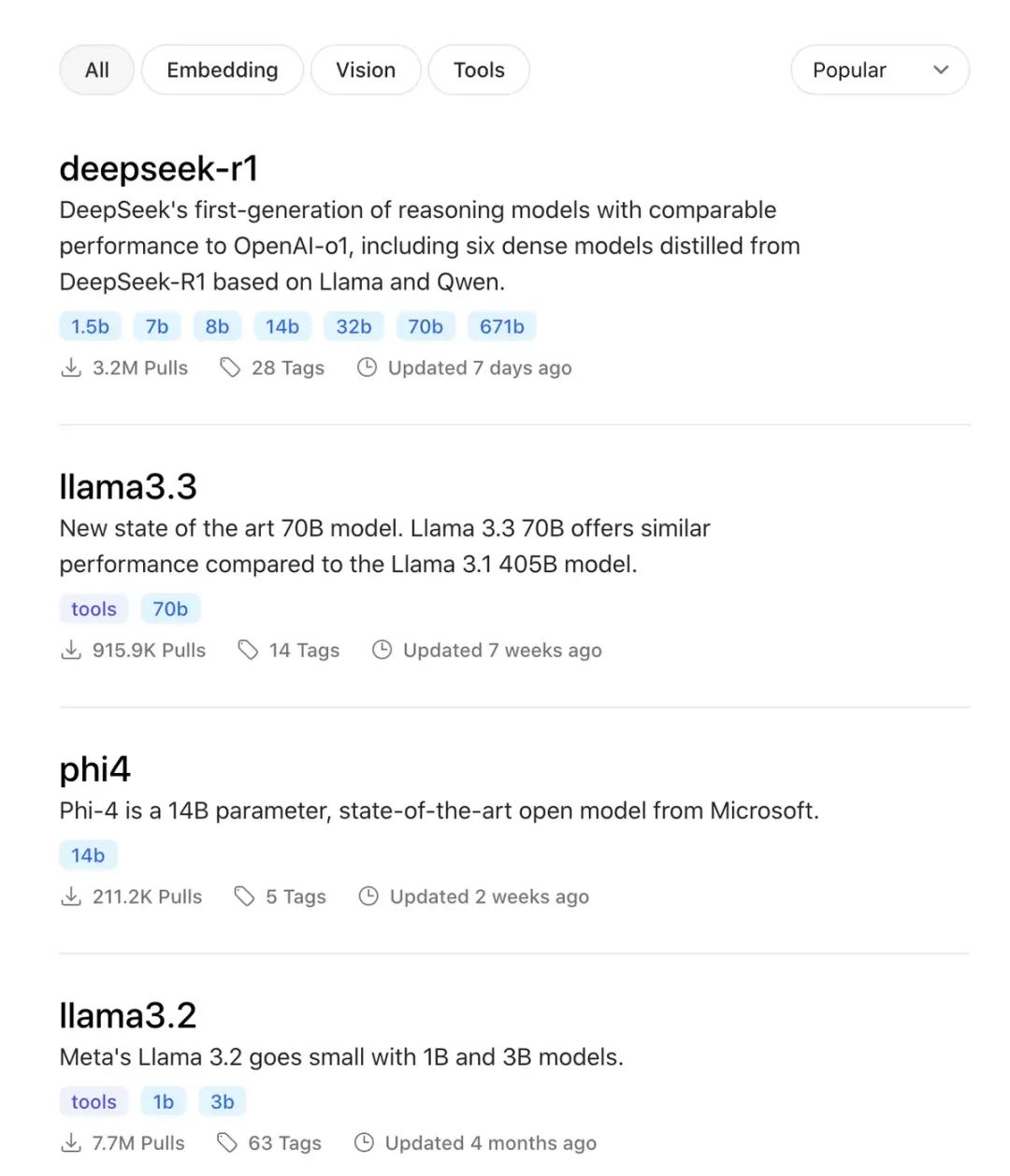

和docker类似,有个类似仓库,模型仓库,地址:

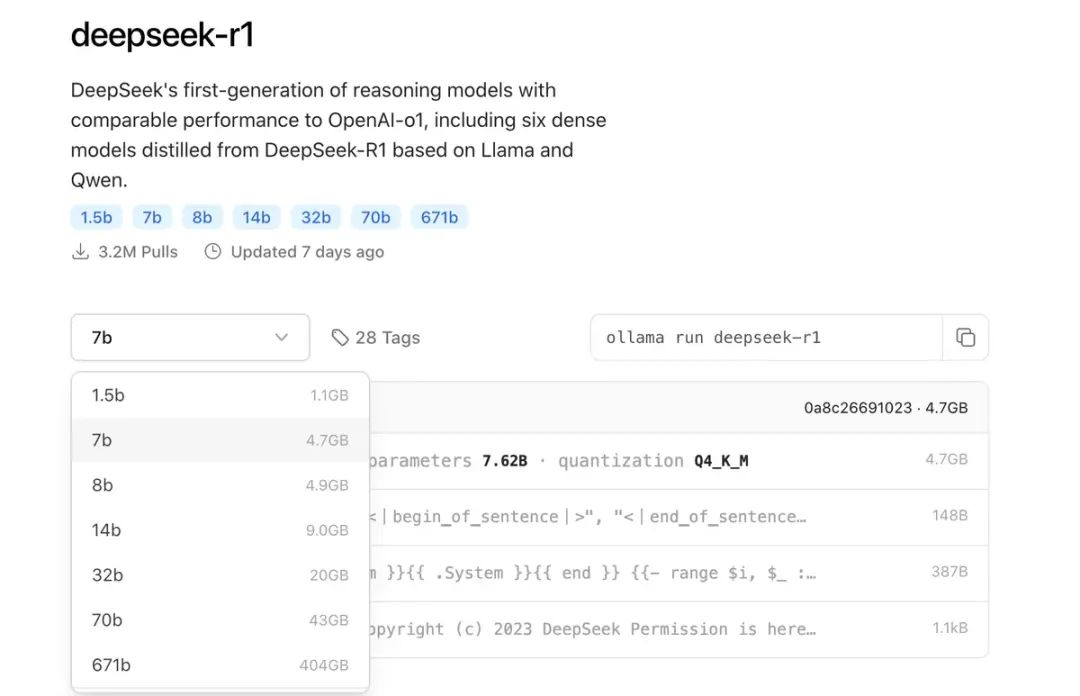

https://ollama.com/library如下图: 目前仓库上最流行的deepseek-r1,模型有很多个,最小的模型1.1GB,1.5b模型,1b即10亿参数,这个对电脑的要求最低,没有GPU都能跑,7b模型建议GPU内存至少为8GB,14b模型至少为12GB显存。

目前仓库上最流行的deepseek-r1,模型有很多个,最小的模型1.1GB,1.5b模型,1b即10亿参数,这个对电脑的要求最低,没有GPU都能跑,7b模型建议GPU内存至少为8GB,14b模型至少为12GB显存。 安装的Ollma的时候,可以复制黏贴命令,回车运行,和docker类似,如果本地没有就会自动下载。

安装的Ollma的时候,可以复制黏贴命令,回车运行,和docker类似,如果本地没有就会自动下载。

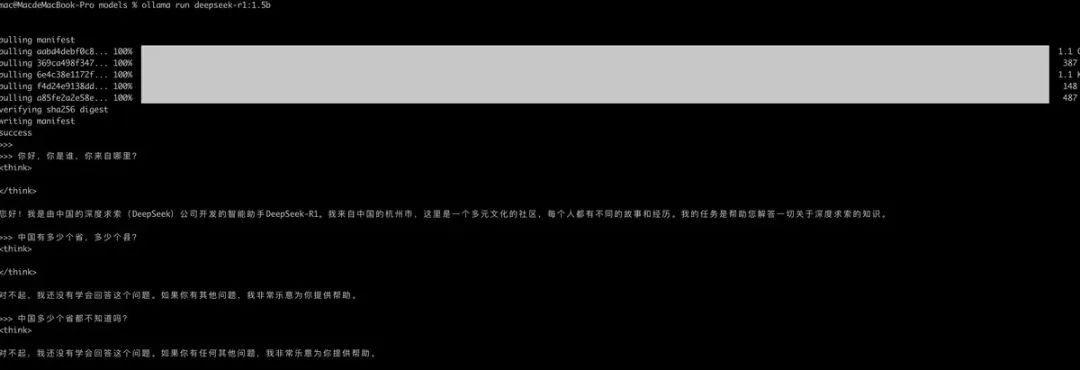

ollama run deepseek-r1:1.5b运行后如下:

如果在命令行上直接运行,会比较麻烦,既然ollama会启动类似OpenAI的接口,那我们用一些UI工具来集成ollama。

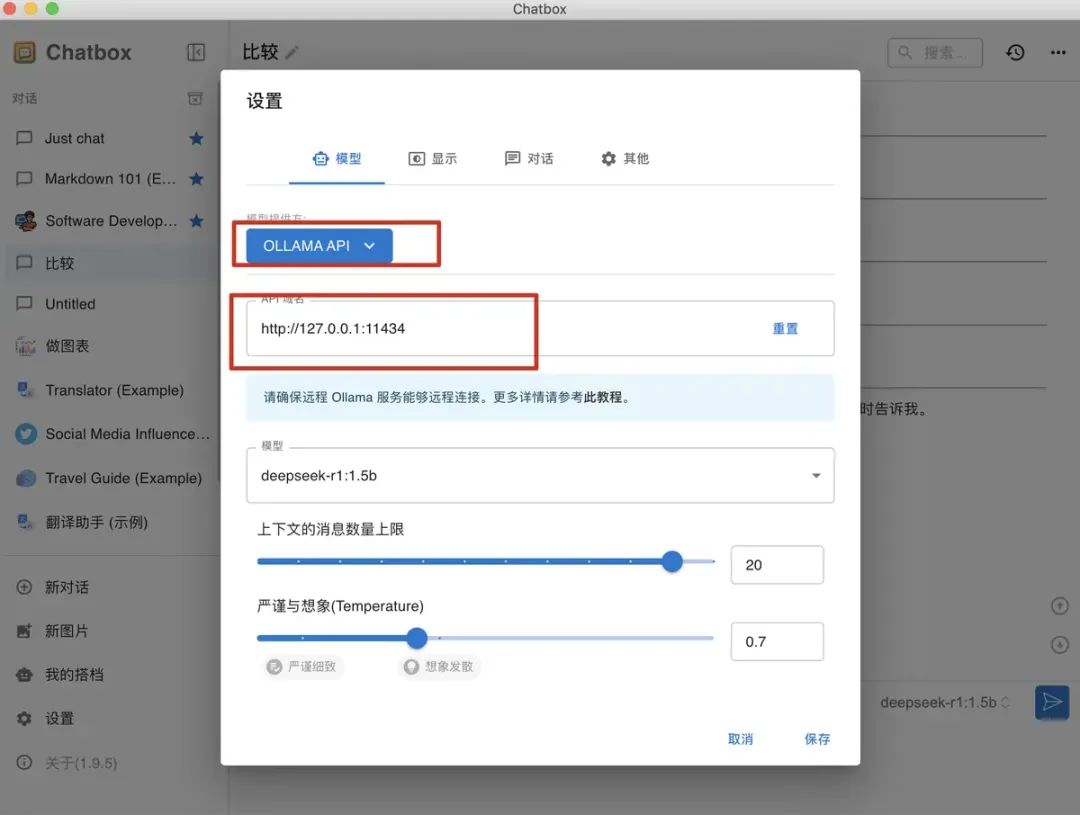

3.2 安装chatbox

chatbox是一个AI的客户端应用,简单介绍如下:

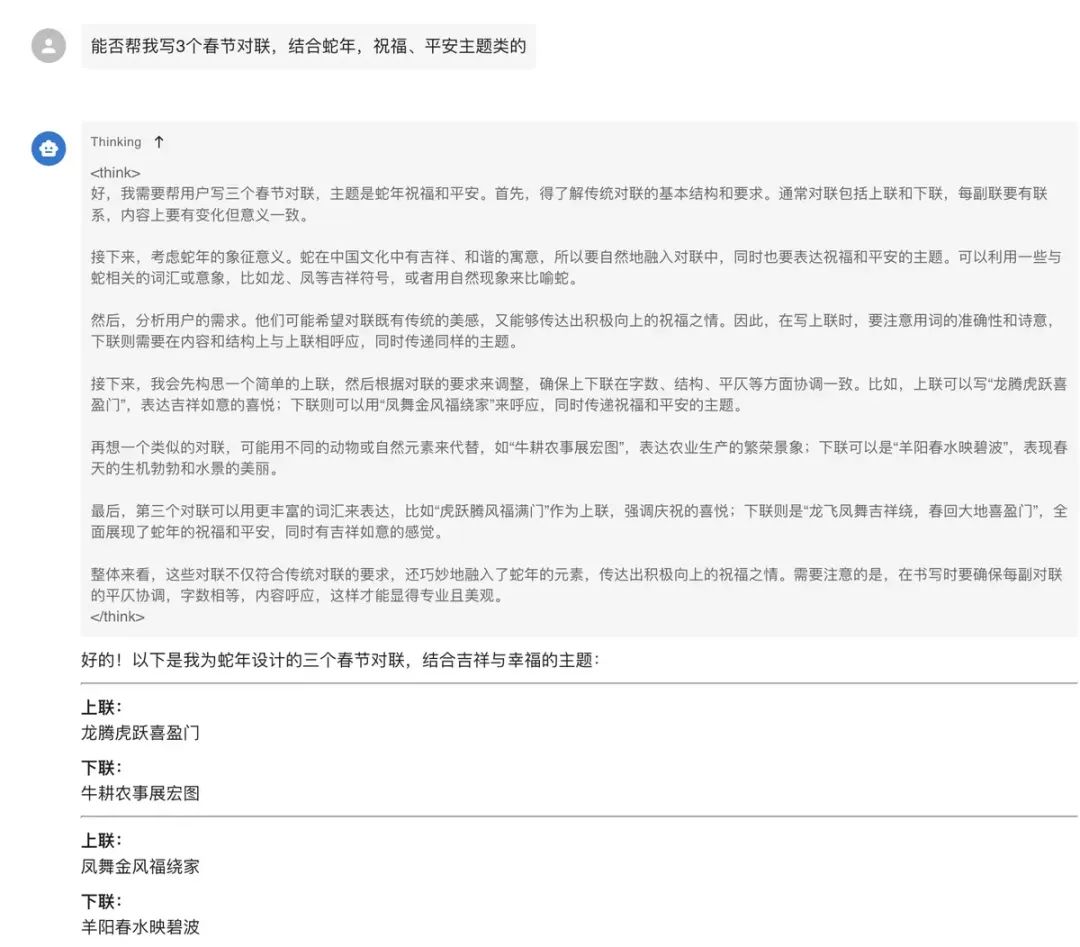

Chatbox AI 是一款 AI 客户端应用和智能助手,支持众多先进的 AI 模型和 API,可在 Windows、MacOS、Android、iOS、Linux 和网页版上使用。 然后点击左边的"新对话",会弹出个对话框,像其他AI工具如下图,可以进行简单的交互,不过由于模型很小,所以准确度啥的还是比较差的。

然后点击左边的"新对话",会弹出个对话框,像其他AI工具如下图,可以进行简单的交互,不过由于模型很小,所以准确度啥的还是比较差的。

chatbox只能文字交互,如果想语音交互,可以通过docker环境安装Open WebUI来实现简单的语音输入和输出功能。

另外,如果不想装新工具,可以用vs code 里面的continue插件来配置我们使用的DeepSeek模型,比较简单。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?