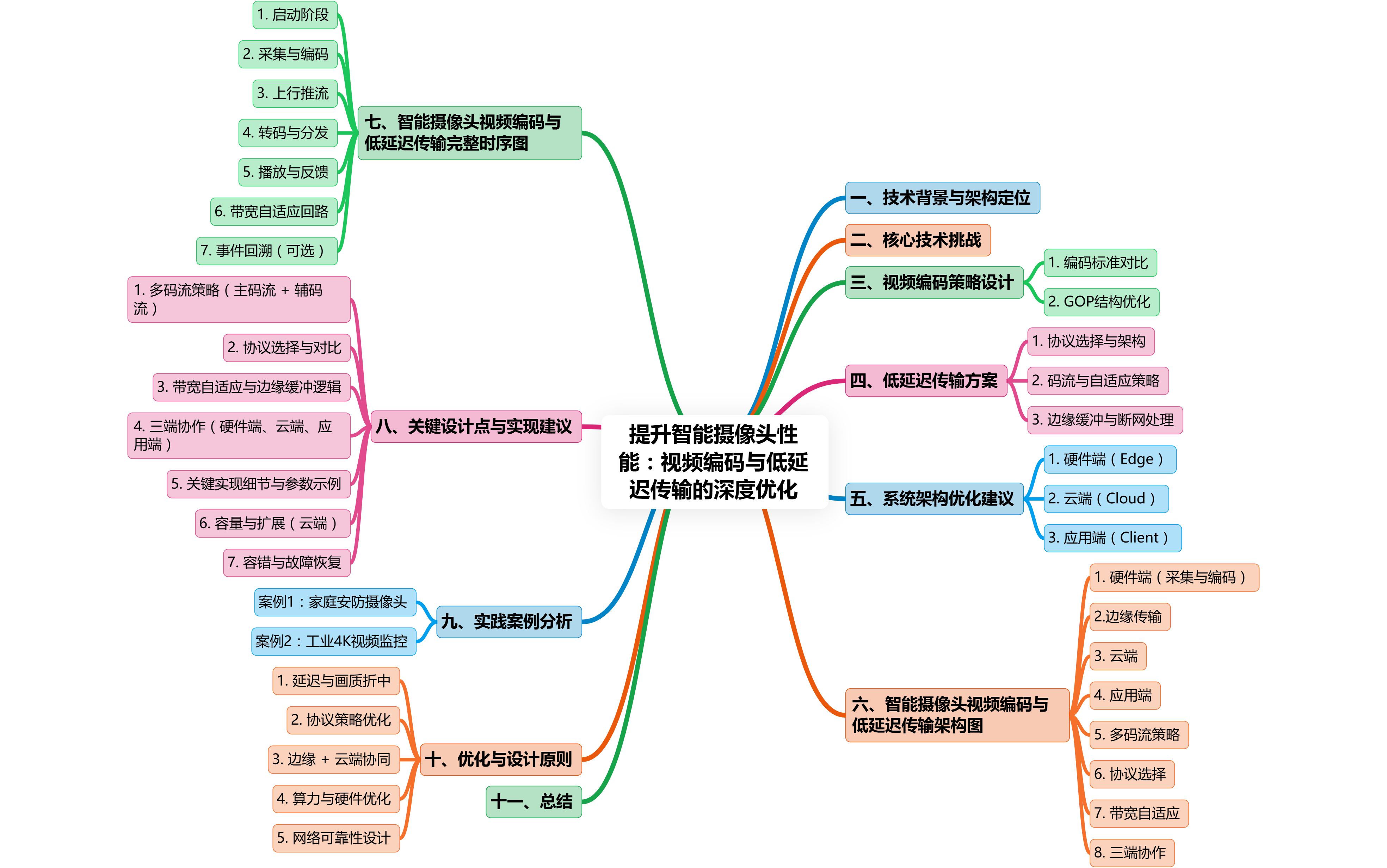

目录

一、技术背景与架构定位

在智能摄像头系统中,视频编码和低延迟传输是 整个三端架构(硬件端 + 云端 + 应用端)的核心环节。系统架构设计必须同时满足以下要求:

-

低延迟:移动端或监控端实时预览延迟 ≤ 1 秒(家庭安防)或 ≤ 2 秒(工业监控)。

-

高画质:4K/2K 高清视频采集,同时保证帧率 ≥ 25fps。

-

带宽适配:在 Wi-Fi/4G/5G 网络波动下仍能保证流畅性。

-

跨平台兼容:支持 iOS、Android、Web 与 PC 端访问。

-

可扩展性:支持多设备并发、大规模部署及云端 AI 分析。

智能摄像头的 三端技术架构如下:

-

硬件端(Edge):摄像头采集视频、硬件编码、边缘 AI 处理、缓存与初步流控。

-

云端(Cloud):流媒体分发、存储管理、事件分析与 AI 深度计算。

-

应用端(Client):视频播放、控制命令下发、事件推送与回放展示。

二、核心技术挑战

从架构师角度,视频编码与低延迟传输存在五大核心挑战:

| 技术维度 | 主要问题 | 工程挑战 |

| 编码与算力 | 高分辨率编码延迟大 | SoC 算力有限,CPU/GPU 占用高 |

| 网络传输 | 丢包、抖动、NAT穿透 | UDP/TCP传输选择,P2P直连率低 |

| 多终端适配 | iOS/Android/Web支持差异 | 协议兼容性、解码能力差异 |

| 低延迟保障 | 实时预览延迟超标 | 协议选择、边缘缓冲与码流策略 |

| 存储与回放 | 云端存储成本高,回放延迟 | 冷/热数据分层、索引化检索 |

三、视频编码策略设计

1.编码标准对比

| 编码标准 | 硬件支持 | 压缩效率 | 适用场景 | 注意点 |

| H.264 | 广泛 | 中等 | 辅码流、低功耗设备 | 老旧设备兼容性好,但带宽消耗高 |

| H.265/HEVC | 较好 | 高 (~50% 优于 H.264) | 主码流、高分辨率 | 算力需求高,部分老设备不支持 |

| AV1 | 较少 | 高 (>H.265) | 云端转码或未来设备 | 编码延迟高,硬件加速尚未普及 |

架构设计建议:

-

主码流采用 H.265/HEVC,保证高清画质和带宽节约。

-

辅码流使用 H.264,保证低延迟预览和终端兼容性。

-

支持 VBR(可变码率)+ CBR(固定码率)组合策略,根据场景动态切换。

2.GOP 结构优化

-

短 GOP:降低延迟,但码率略高,适合实时预览。

-

长 GOP:压缩效率高,适合存储或云端录像。

-

架构建议:主码流长 GOP,辅码流短 GOP,实现低延迟预览 + 高压缩存储共存。

四、低延迟传输方案

1.协议选择与架构

| 协议 | 优势 | 工程注意点 |

| WebRTC | P2P、UDP传输、延迟 <1s | NAT穿透依赖 STUN/TURN,直连率需监控 |

| LL-HLS | HTTP兼容、延迟1-3s | 切片优化必须,适合 Web 回放 |

| SRT | 丢包补偿、自适应带宽 | 适合长距离工业监控 |

| RTMP | 成熟、稳定 | 延迟约2-5秒,适合直播场景 |

架构建议:

-

实时预览使用 WebRTC 或 SRT,保证低延迟。

-

回放和直播兼容性场景使用 LL-HLS 或 RTMP。

-

可采用 多协议组合架构,满足不同终端和场景需求。

2.码流与自适应策略

-

主码流:高分辨率、高码率,云端存储或回放使用。

-

辅码流:低分辨率、低延迟,移动端实时预览。

-

动态码率:带宽波动时自动调整辅码流码率,保证流畅。

3.边缘缓冲与断网处理

-

边缘缓冲:摄像头本地缓存 10–30 秒视频,避免网络抖动导致画面丢失。

-

断网录像:断网情况下仍可录像,恢复后自动上传云端。

-

事件触发上传:运动检测或 AI 事件触发录像,减少无效上传流量。

五、系统架构优化建议

从架构师角度,需要将编码与传输策略与 三端系统架构紧密结合:

1.硬件端(Edge)

-

视频采集 + 编码 + 边缘 AI + 缓存

-

采用硬件加速编码,减轻 CPU/GPU 负载

-

实现事件触发录像、辅码流预览

-

本地缓存与断网同步机制

2.云端(Cloud)

-

实时流转发、事件分析、存储管理

-

使用负载均衡、多节点部署保证并发访问

-

事件索引化,支持快速回放和 AI 深度分析

-

数据分层存储:冷热分离 + 事件触发上传

3.应用端(Client)

-

实时预览 + 控制命令下发 + 回放展示

-

SDK 层统一管理多协议(WebRTC/LL-HLS/SRT)

-

动态码流选择和自适应码率处理

-

提供移动端、PC/Web 跨平台一致体验

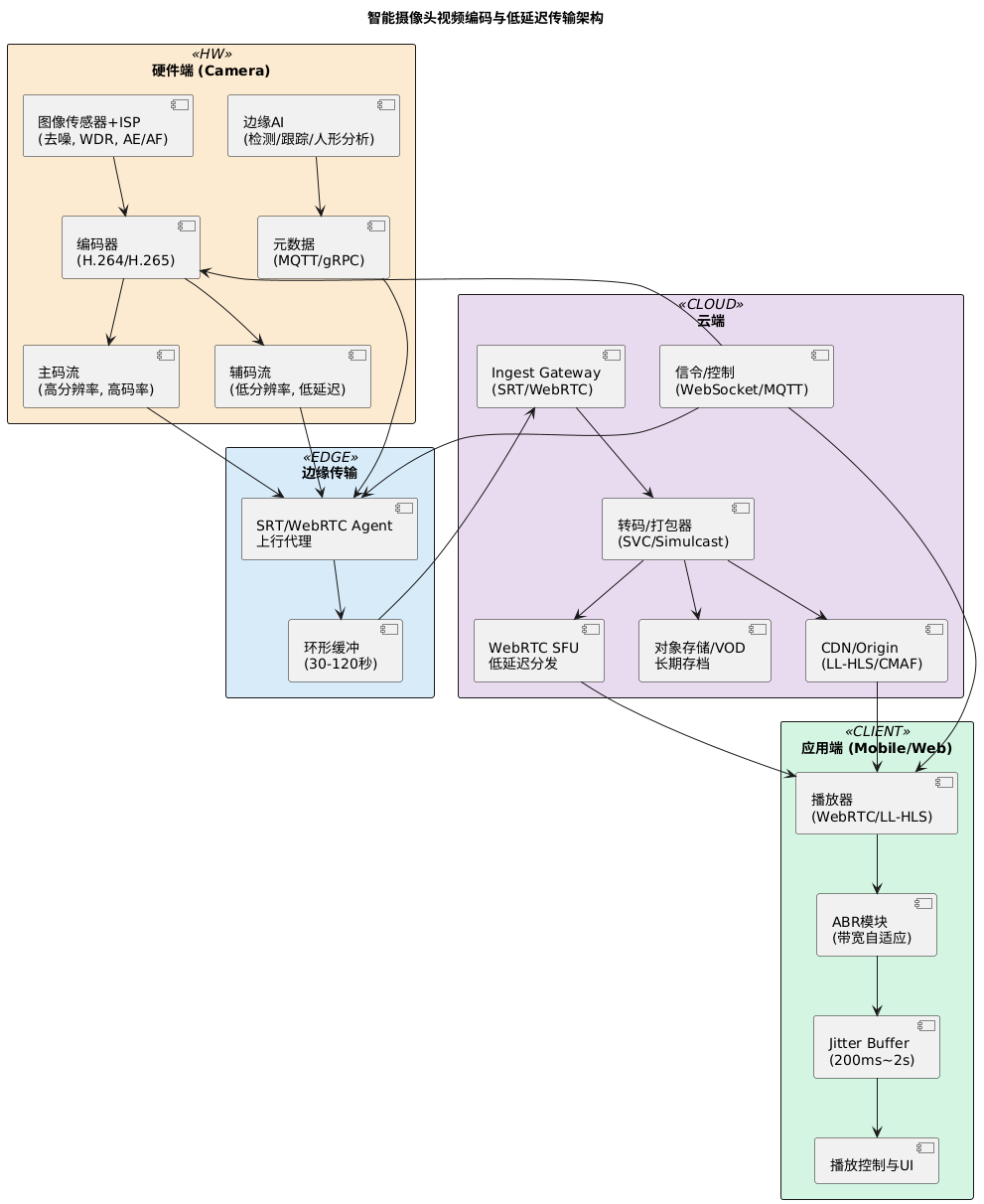

六、智能摄像头视频编码与低延迟传输架构图

包含 硬件端采集→编码→边缘 AI→云端分发→应用端播放 的全链路流程,以及 主码流+辅码流策略、协议选择、带宽自适应、三端协作 等核心要素。

架构解析

1.硬件端(采集与编码)

-

ISP/传感器:负责图像采集与基础处理(降噪、宽动态、曝光/对焦)。

-

编码器:输出主码流(高分辨率/高码率)+ 辅码流(低分辨率/低延迟)+ 缩略帧。

-

边缘AI:执行人形检测、移动侦测、目标跟踪等分析,并生成事件元数据。

-

缓冲区:采用环形缓冲(30–120s)存储近期视频,保障断网续传与回溯。

2.边缘传输

-

SRT/WebRTC Agent:根据场景选择 SRT(上行可靠性优先)或 WebRTC(低延迟交互优先)。

-

支持 多码流策略:主码流走 SRT/RTMP/HTTP-FLV,辅码流走 WebRTC/SRT 低延迟链路。

3.云端

-

Ingest Gateway:接收多协议上行流。

-

Transcoder:进行转码/打包(SVC 或 simulcast)。

-

SFU:用于低延迟互动播放(WebRTC)。

-

CDN/Origin:用于 LL-HLS/CMAF 大规模分发。

-

控制通道:通过 WebSocket/MQTT 实现码率控制、关键帧请求、带宽自适应指令。

-

存储:用于长期录像存档与回放。

4.应用端

-

播放器:支持 WebRTC(超低延迟 <500ms)与 LL-HLS(1–3s 延迟)。

-

ABR 模块:根据网络带宽动态切换主/辅流,或调整 HLS bitrate ladder。

-

Jitter Buffer:平滑网络抖动;WebRTC 200–500ms,HLS 1–3s。

-

UI 控制:提供回放、缩放、事件回溯。

5.多码流策略

-

主码流:高质量录像、云端存储、AI 后处理。

-

辅码流:低带宽/低延迟播放,优先保证实时性。

-

可扩展 SVC(分层编码)以支持 SFU 按需转发。

6.协议选择

-

上行:SRT 优先(4G/5G/WAN 场景),WebRTC 可选(互动场景)。

-

下行:WebRTC + SFU(互动场景),LL-HLS(大规模直播场景)。

7.带宽自适应

-

客户端上报下载速率、丢包率(RTCP/HTTP Stats)。

-

云端聚合后控制码率(控制通道下发)。

-

编码器动态调整 GOP/码率,优先辅码流。

8.三端协作

-

硬件端:负责多码流编码、事件检测。

-

云端:负责转码、分发、QoS 控制。

-

应用端:负责 ABR、QoE 反馈、低延迟播放。

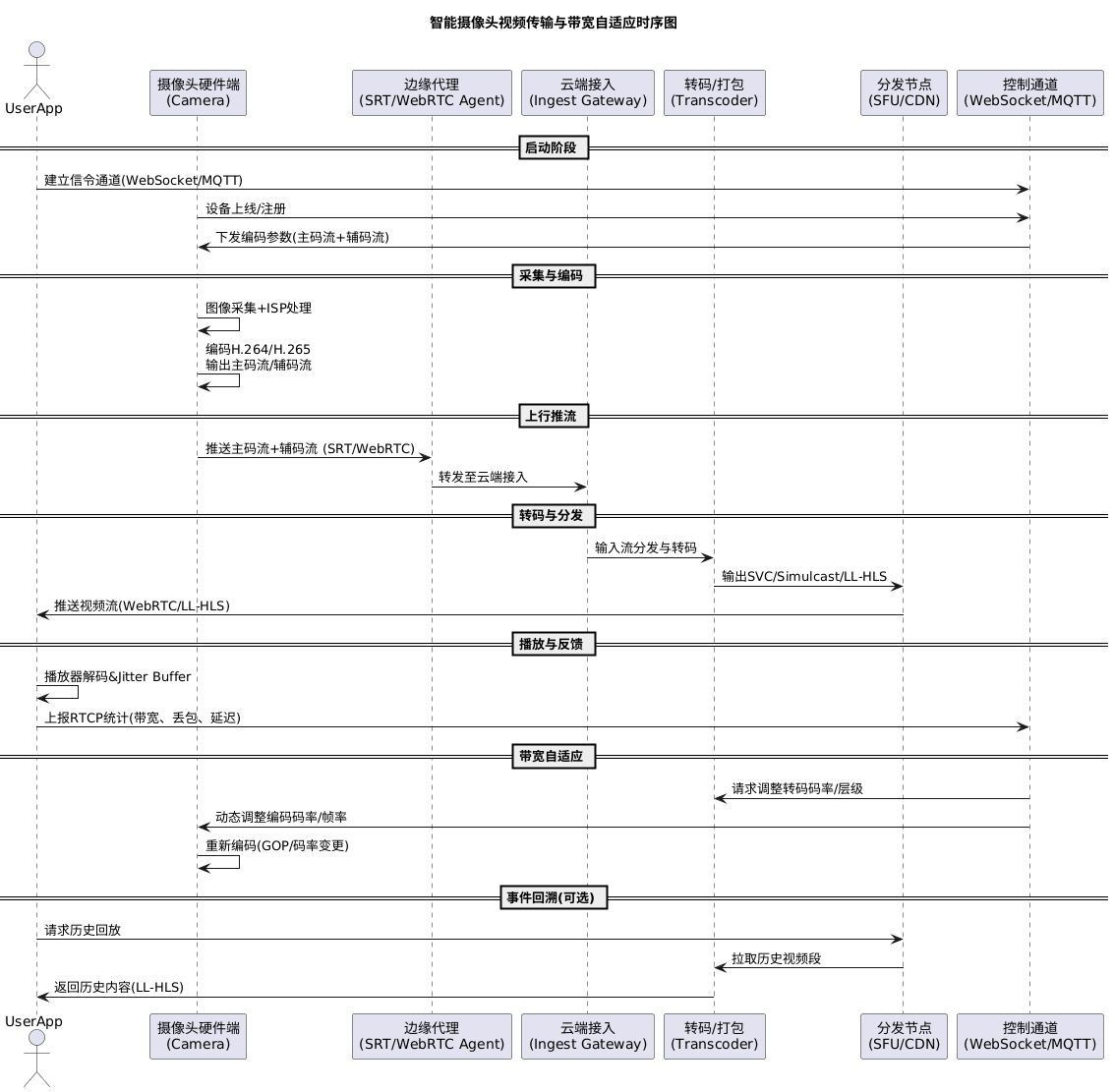

七、智能摄像头视频编码与低延迟传输完整时序图

涵盖 采集、上传、转码、分发、播放、信令、RTCP反馈、带宽自适应回路 的端到端流程。

时序图解析

1.启动阶段

-

App 建立控制信令通道:通常基于 WebSocket 或 MQTT。

-

摄像头注册上线:硬件端上报设备信息、码流能力、分辨率列表。

-

云端返回 编码参数策略:包括主码流(高分辨率)、辅码流(低延迟)、GOP 长度、初始码率。

2.采集与编码

-

摄像头完成 图像采集→ISP预处理→视频编码(H.264/H.265/SVC)。

-

输出 双码流:主码流(存档+高画质)和辅码流(低延迟播放)。

3.上行推流

-

摄像头将主/辅码流通过 SRT 或 WebRTC 推送至边缘节点。

-

SRT:容错强、适合公网与弱网。

-

WebRTC:低延迟、适合互动场景。

4.转码与分发

-

云端 Ingest Gateway 接入视频流并进行路由。

-

转码器 (Transcoder):

-

对主码流进行转码封装(LL-HLS/CMAF)。

-

对辅码流进行 Simulcast/SVC 编码处理,支持多分辨率层。

-

-

分发节点 (SFU/CDN):

-

SFU(WebRTC 多方低延迟)。

-

CDN(大规模 LL-HLS/CMAF 分发)。

-

5.播放与反馈

-

客户端播放器(WebRTC/LL-HLS)解码视频。

-

Jitter Buffer 处理网络抖动:WebRTC (200–500ms),LL-HLS (1–3s)。

-

客户端周期性发送 RTCP 统计/带宽反馈(包括丢包、延迟、可用带宽)。

6.带宽自适应回路

-

云端分析反馈数据后,通过控制通道发送码率调整指令。

-

摄像头端动态调整 编码码率、GOP、帧率,优先保证辅码流低延迟。

-

转码器可切换至低码率层,减少拥塞。

7.事件回溯(可选)

-

客户端可通过 API 请求历史录像。

-

云端返回存档内容(HLS/LL-HLS)用于回放。

八、关键设计点与实现建议

1.多码流策略(主码流 + 辅码流)

-

主码流(主分辨率)

-

目的:高质量录像、回放、AI 后处理(VOD)

-

编码:H.265(能效高)或 H.264(兼容性更好);Profile 使用低延迟 preset(

tune=zerolatency或 x265--tune=fastdecode) -

码率/分辨率示例:1080p @ 2.5–5 Mbps(可根据场景调整)

-

包装:会上传到云端作存储与转码

-

-

辅码流(低延迟/低带宽)

-

目的:实时预览、互动控制、弱网络环境下播放

-

编码策略:短 GOP(例如 GOP 10 或更短),或使用 SVC/Simulcast(temporal/spatial layers)

-

码率/分辨率示例:480p @ 300–800 kbps 或 360p @ 150–400 kbps

-

传输优先级高:用于实时交互(低延迟通路)

-

-

第三类流(缩略/分析帧/metadata)

-

仅关键帧或低分辨率缩略图,供快速预览与AI验证

-

2.协议选择与对比

-

WebRTC(推荐用于互动实时场景)

-

优点:端到端低延迟(目标 <200–500ms),内建 NAT/ICE、SRTP + RTCP 反馈、内建带宽估计与 congestion control,可做 simulcast/SVC。

-

缺点:对大规模广播需要 SFU/MCU 层或转封装;浏览器原生支持。

-

适用场景:实时视频对讲、远程控制、双向交互监控。

-

-

SRT(推荐用于边缘→云的可靠贡献链路)

-

优点:专为不稳定网络设计(ARQ + packet retransmit、拥塞控制),适合 4G/5G uplink。

-

缺点:客户端(嵌入式)实现需额外库,浏览器端不直接支持。

-

适用场景:摄像头上行到云端的稳定传输(尤其跨互联网的边缘摄像头)。

-

-

LL-HLS / CMAF(推荐用于大规模低延迟分发)

-

优点:基于 HLS 的低延迟扩展(chunked CMAF),易于通过现有 CDN 横向扩展到大量观众,兼容现有播放器生态。

-

缺点:延迟通常在 1–3 秒(较 WebRTC 更高),对实时性要求极高的交互不适合。

-

适用场景:直播观众量大但可接受几秒延迟的场景(监控回放直播、公告类直播)。

-

实战建议:

-

边缘到云(摄像头→云)用 SRT(更可靠)或 WebRTC DataChannel(若要直接实现低延迟且摄像头支持);

-

云到观众(分发)用两套链路:WebRTC SFU(低延迟小规模互动) + LL-HLS via CDN(大规模分发)。

-

对同一流同时提供 simulcast(多分辨率并行编码)或 SVC(单编码多层)以便不同客户端选择。

3.带宽自适应与边缘缓冲逻辑

-

带宽估计点:在客户端(RTCP/ABR)、SFU(聚合反馈)、边缘Agent(上行估计)三处进行协同。

-

ABR 实现选项:

-

WebRTC: 用其内建带宽估计 + simulcast(客户端选择订阅哪一层)

-

HLS/DASH: 传统 ABR(manifest + chunk 切换)

-

-

边缘缓冲(Edge Buffer)策略:

-

短环形 buffer(硬件端):保存 N 秒原始帧(例如 30–120s)用于回溯、快速本地回放与云端回传请求。

-

拥塞缓冲(Encode-side):根据上行带宽调整编码码率(CBR 或 constrained VBR),并在网络抖动时优先发送关键帧与低分层。

-

客户端 jitter buffer:自适应大小(初始 200ms–2s),根据网络波动自动增减;对于 WebRTC 可非常短(<200–500ms),对于 LL-HLS 可设置较大(1–3s)。

-

-

缓冲控制逻辑:

-

客户端持续上报下载速度 / packet loss(RTCP / HTTP stats)

-

云端或 SFU 聚合 QoE 指标并通过 Signaling(WebSocket)发送 ABR 指令或请求关键帧(PLI/FIR)

-

边缘Agent收到指令后:立即触发 I-frame 或切到更低分辨率流(辅码流优先)

-

若上行严重抖动,启用 FEC(前向纠错)或 ARQ(取决协议)

-

4.三端协作(硬件端、云端、应用端)

-

信令通道(Control Plane):使用 WebSocket / gRPC / MQTT 作为控制通道(心跳、配置、I-frame 请求、授权、时间同步)。

-

同步机制:NTP/PTP 或应用层 timestamp 保证日志和录像的一致性,边缘和云端对齐时间戳用于 AI 事件回溯。

-

QoE 反馈与自动调优:客户端周期性上报(bufferedDuration, frameDelay, packetLoss, rtt)→ 云端聚合 → 下发全局或边缘配置(码率上限、关键帧频率)。

-

安全与鉴权:TLS + SRTP(WebRTC)/ SRT AES;使用设备证书(mTLS)或短期 token(JWT)进行设备身份验证。

-

元数据与AI协作:检测到事件(motion, person, license plate)在边缘产生 metadata 并优先发到云端(MQTT),同时触发关键帧上云与事件推送至客户端。

5.关键实现细节与参数示例

-

GOP / Keyframe:GOP 频率可设 1s(低延迟)或 2s;对于极低延迟互动,采用

keyint = 15(30fps)或 shorter。 -

Codec 设置:

x264 -preset veryfast -tune zerolatency -x264opts keyint=15:min-keyint=1或 x265 对应低延迟参数。 -

Packetization:RTP (WebRTC), SRT (contribution), HLS chunked CMAF for LL-HLS.

-

FEC / Retransmit:SRT ARQ + optional SRT FEC;WebRTC uses retransmit (RTX) + FEC (flexfec) depending on implementation.

-

Latency targets:WebRTC <200–500ms; SRT typical 200–800ms depending on network & buffering; LL-HLS 1–3s (with modern CDNs can approach ~1s)。

6.容量与扩展(云端)

-

SFU (Selective Forwarding Unit):用于多观众低延迟分发(WebRTC),只转发必要的 RTP 包,减少服务器转码压力;结合 simulcast 可让 SFU 为每客户端选择流。

-

Transcoder Pool:把主码流按需转为 LL-HLS 或为不同 CDN 提供多码率 manifest。使用自动伸缩(Kubernetes + HPA)按负载扩容。

-

CDN & Edge Cache:LL-HLS 分段(chunked CMAF)需要 CDN 支持 chunked transfer;对接多个 CDN 提供全球分发与故障域隔离。

7.容错与故障恢复

-

边缘本地回环:若网络中断,摄像头继续本地录制并在链接恢复后批量上传。

-

冗余上行:同时支持 4G/5G 与备用 WAN,SRT 可以自动切换路径/重连。

-

监控与告警:端到端统计(packet loss, jitter, RTT, bitrate)上报到 Prometheus + Grafana,设 QoE 告警阈值。

九、实践案例分析

案例1:家庭安防摄像头

-

需求:移动端延迟 <1 秒,跨平台访问,事件告警实时推送。

-

架构实现:

-

主码流:H.265,1080p,长 GOP,云端存储

-

辅码流:H.264,720p,短 GOP,低延迟实时预览

-

协议:WebRTC P2P 优先,TURN fallback

-

边缘 AI:运动检测触发事件录像

-

-

效果:移动端延迟 0.8 秒,事件回放快速跳转,网络抖动下辅码流保障连续预览。

案例2:工业 4K 视频监控

-

需求:4K 高清视频,低延迟实时异常检测,云端存储。

-

架构实现:

-

主码流:H.265,4K/25fps,长 GOP

-

辅码流:1080p,短 GOP,用于移动端低延迟预览

-

协议:SRT 优先,UDP 优先,TCP fallback

-

云端 AI:缺陷检测与异常行为分析

-

-

效果:延迟控制在 1–2 秒,异常事件 2 秒内推送至操作员端,支持多摄像头并发访问。

十、优化与设计原则

1.延迟与画质折中

-

高分辨率码流延迟高,需主辅码流分离,GOP、码率可动态调整。

2.协议策略优化

-

实时预览使用低延迟协议,回放或直播使用兼容性协议

-

多协议组合实现跨终端适配

3.边缘 + 云端协同

-

边缘预处理减少云端压力

-

云端提供精细 AI 分析和事件索引化管理

4.算力与硬件优化

-

硬件加速 H.265 编码

-

边缘 AI 使用轻量化模型

-

动态码率和缓冲策略降低延迟波动

5.网络可靠性设计

-

心跳检测、自动重连

-

控制命令 QoS 优先

-

UDP优先 + HTTP fallback

十一、总结

针对智能摄像头的 视频编码与低延迟传输优化,关键在于:

-

多码流编码策略:H.265 主码流 + H.264 辅码流,VBR+CBR结合。

-

低延迟协议设计:WebRTC、SRT、LL-HLS 多协议组合。

-

边缘优化:缓存、断网录像、事件触发上传、边缘 AI 协同。

-

架构协同:硬件端采集与编码、云端分发与分析、应用端跨平台访问。

-

工程可扩展性:支持多设备并发、大规模部署和跨终端优化。

通过这些优化策略,智能摄像头系统可以在 高分辨率、低延迟、低带宽消耗、跨终端兼容性和可扩展性之间达到平衡,满足家庭安防、工业监控和智能门铃等多种场景的实际需求。

扩展阅读:

| 掌握 WebRTC:实时音视频与数据传输核心技术全解 | 掌握 WebRTC:实时音视频与数据传输核心技术全解 |

| WebRTC 架构全景图与信令时序详解 | WebRTC 架构全景图与信令时序详解 |

| 深度剖析:摄像头系统中云、边、端的三大关键技术 | 深度剖析:摄像头系统中云、边、端的三大关键技术 |

| 摄像头三端开发常见问题及解决方案 | 摄像头三端开发常见问题及解决方案 |

| 提升智能摄像头性能:视频编码与低延迟传输的深度优化 | 提升智能摄像头性能:视频编码与低延迟传输的深度优化 |

| 边缘-云协同:智能摄像头分布式 AI 架构 | 边缘-云协同:智能摄像头分布式 AI 架构 |

| 保障实时监控:摄像头网络稳定性优化指南 | 保障实时监控:摄像头网络稳定性优化指南 |

| 摄像头视频云存储与回放系统架构 | 摄像头视频云存储与回放系统架构 |

| 智能摄像头安全架构:数据加密与隐私保护 | 智能摄像头安全架构:数据加密与隐私保护 |

| 直播、监控、视频会议:不同场景下的视频流协议选型 | 直播、监控、视频会议:不同场景下的视频流协议选型 |

1282

1282

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?