最近为了适配客户版本,搭建了CDH5.16版本的数据数据环境。而默认的Spark是1.6版本的,为配合客户需要升级成Spark2,由于机器资源有限制,先把Spark1.6删除了,下载SPARK2-2.1.0.cloudera3-1.cdh5.13.3.p0.569822-el7.parcel包,进行了安装。安装完成之后,运行Spark的相关命令就报java.lang.NoClassDefFoundError: org/apache/hadoop/fs/FSDataInputStream异常,我使用的命令是spark2-submit时报错,其实所有Spark相关命令都是一样的错误。

特别需要注意是:

spark2的提交命令是Spark2-submit,系统可能会有spark1.6的命令spark-submit干扰。

使用Spark的命令的机器需要安装Gateway组件,然后需要deploy client configuration(部署客户端配置)。个人认为既然使用CDH Manager,如果还去机器上直接改配置的,那还要CDH Manager干啥?网上有很多答案,都说教人要改这改那的,这命令那么命令的,可能别人也没搞明白为啥会出那样的问题。

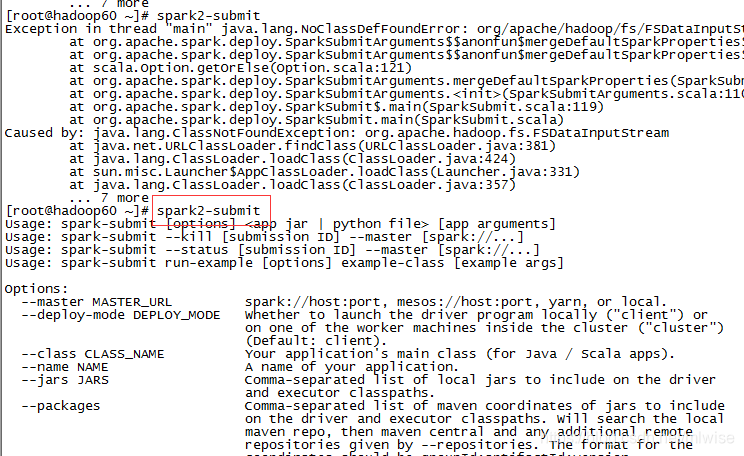

错误信息如下:

[root@hadoop60 ~]# spark2-submit

Exception in thread "main" java.lang.NoClassDefFoundError: org/apache/hadoop/fs/FSDataInputStream

at org.apache.spark.deploy.SparkSubmitArguments$$anonfun$mergeDefaultSparkProperties$1.apply(SparkSubmitArguments.scala:124)

at org.apache.spark.deploy.SparkSubmitArguments$$anonfun$mergeDefaultSparkProperties$1.apply(SparkSubmitArguments.scala:124)

at scala.Option.getOrElse(Option.scala:121)

at org.apache.spark.deploy.SparkSubmitArguments.mergeDefaultSparkProperties(SparkSubmitArguments.scala:124)

at org.apache.spark.deploy.SparkSubmitArguments.<init>(SparkSubmitArguments.scala:110)

at org.apache.spark.deploy.SparkSubmit$.main(SparkSubmit.scala:119)

at org.apache.spark.deploy.SparkSubmit.main(SparkSubmit.scala)

Caused by: java.lang.ClassNotFoundException: org.apache.hadoop.fs.FSDataInputStream

at java.net.URLClassLoader.findClass(URLClassLoader.java:381)

at java.lang.ClassLoader.loadClass(ClassLoader.java:424)

at sun.misc.Launcher$AppClassLoader.loadClass(Launcher.java:331)

at java.lang.ClassLoader.loadClass(ClassLoader.java:357)

... 7 more

[root@hadoop60 ~]#

解决步骤:

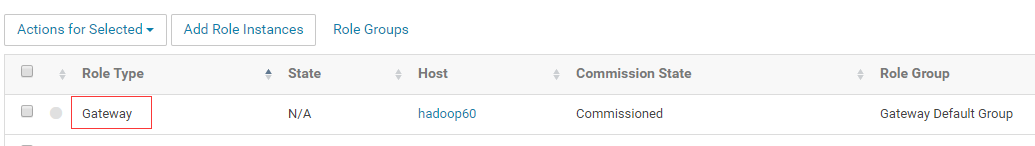

1. 选择需要使用Spark命令的机器上安装Gateway组件

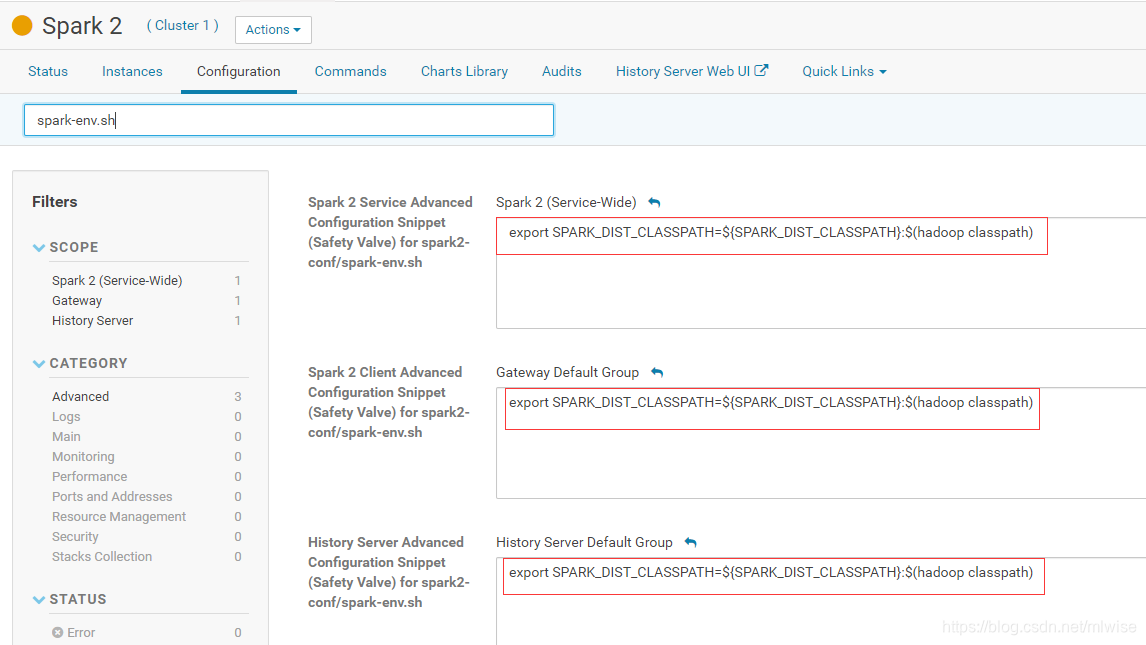

2. 增加Spark-env.sh的配置export SPARK_DIST_CLASSPATH=${SPARK_DIST_CLASSPATH}:$(hadoop classpath)

输入之后,最好行的末尾回车一下

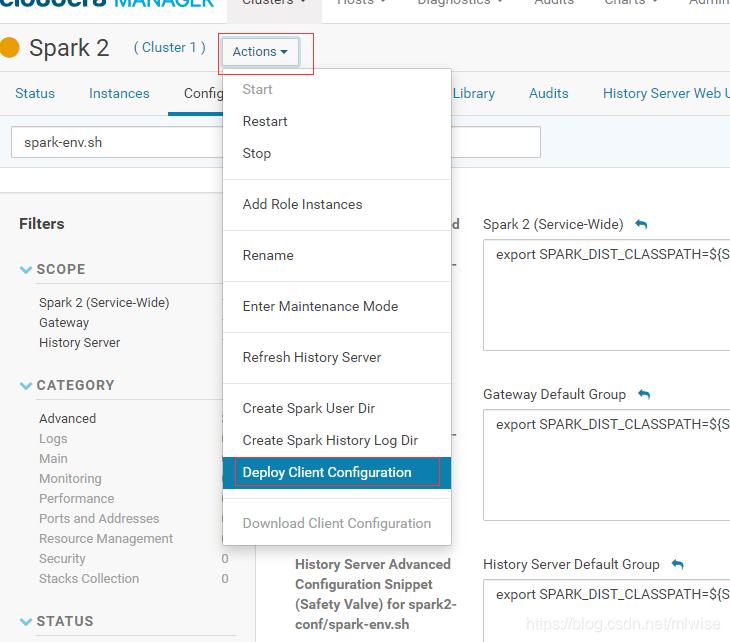

3. 部署Spark客户端配置

4. 如果还不行,可以尝试重启Spark或者集群(我忘记了有没有做这一步)

做了这些步骤之后,就好了。开始网上找来找去,都不合适,网上有很多这个错误的,就是没有一个真正解决的,当今的网络太纷繁复杂了,啥信息都有,很难分辨。抽空写出来,希望对大家有用。

本文记录了在CDH5.16环境下将Spark从1.6版本升级到2.x版本的过程及遇到的问题。在升级过程中,因删除Spark1.6并安装Spark2后,运行Spark命令时出现java.lang.NoClassDefFoundError异常。通过安装Gateway组件、配置Spark-env.sh、部署客户端配置等步骤成功解决问题。

本文记录了在CDH5.16环境下将Spark从1.6版本升级到2.x版本的过程及遇到的问题。在升级过程中,因删除Spark1.6并安装Spark2后,运行Spark命令时出现java.lang.NoClassDefFoundError异常。通过安装Gateway组件、配置Spark-env.sh、部署客户端配置等步骤成功解决问题。

1297

1297

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?