hadoop(mapreduce)问题:向集群上传dfs文件,内容显示为空

做Windows搭建hadoop环境作业时碰到了这个问题:此处一直为0b,因为技术欠佳,做坐了很久才找到解决方式

上传dfs文件,但上传后没有任何数据!通过参照参考后,完美解决!

问题原因:

hadoop namenode -format格式化时格式化了多次(虽然我刚开始就不可以)造成那么spaceID不一致

解决方式:

其实虚拟机集群和Windows搭建hadoop环境相似,我这次做的的是Windows搭建

- 首先关闭集群!

stop-all.cmd在自动生成的Omysoftware里这两个文件夹下自动生成了data,tmp内容。把data,tmp删掉,自己再建空的data,tmp文件夹

- 然后在D:\hadoop-2.6.0\sbin(我的)重新格式化namenode

hadoop namenode -format,我看了有一篇文章,选了’N’,选’Y’应该也可以? - D:\hadoop-2.6.0\sbin(我的)

start-all.cmd启动集群 - 重新refresh,或者上传dfs文件!成功!

如何知道自己是否是因为hadoop namenode -format格式化时格式化了多次造成那么spaceID不一致而造成的问题呢?

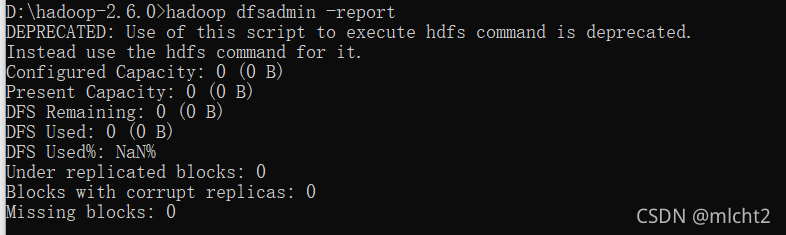

hadoop dfsadmin -report

Configured Capacity: 0 (0 B)

Present Capacity: 0 (0 B)

DFS Remaining: 0 (0 B)

DFS Used: 0 (0 B)

DFS Used%: NaN%

Under replicated blocks: 0

Blocks with corrupt replicas: 0

Missing blocks: 0

这个问题的原因是使用hadoop namenode -format格式化时格式化了多次造成那么spaceID不一致

如果没有问题的话,应该为:

Hostname: master

Decommission Status : Normal

Configured Capacity: 16775028736 (15.62 GB)

DFS Used: 24576 (24 KB)

Non DFS Used: 8850161664 (8.24 GB)

DFS Remaining: 7924842496 (7.38 GB)

DFS Used%: 0.00%

DFS Remaining%: 47.24%

Configured Cache Capacity: 0 (0 B)

Cache Used: 0 (0 B)

Cache Remaining: 0 (0 B)

Cache Used%: 100.00%

Cache Remaining%: 0.00%

Xceivers: 1

Last contact: Wed Jan 24 23:29:54 PST 2018

通过参照参考后,完美解决!感谢!!!

不管是虚拟机,还是windows配,真的是很像!不禁想起去年用虚拟机也遇到了此类问题。哈哈哈

在Windows上搭建Hadoop环境时遇到向DFS上传文件内容为空的问题,原因是多次执行hadoop namenode -format导致spaceID不一致。解决方法包括删除data和tmp文件夹,重新格式化namenode并启动集群。

在Windows上搭建Hadoop环境时遇到向DFS上传文件内容为空的问题,原因是多次执行hadoop namenode -format导致spaceID不一致。解决方法包括删除data和tmp文件夹,重新格式化namenode并启动集群。

480

480

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?