一、CPU层面

基础知识

CPU内部:L0寄存器、L1高速缓存、L2高速缓存 (速度快,成本高)

CPU共享:L3高速缓存、L4主存、L5磁盘、L6远程文件存储 (速度慢,成本低)。

如果有多块CPU,他们会共享CPU共享部分,而L5、L6不会直接和CPU打交道。

读取内存数据的步骤:这里暂时把L3高速缓存、L4主存看成是一个内存,当从内存读取数据时,会把数据读取到L2的高速缓存,再读到L1高速缓存,再读到L0寄存器,然后CPU才会对寄存器的数据进行计算。

CPU找数据的步骤:首先再高速缓存里找,如果找不到就会去主存里面去找,找到后就进行读取内存数据的步骤,数据放在高速缓存后,下次CPU再找同样的数据就会从高速缓存里直接获取。

缓存行的概念

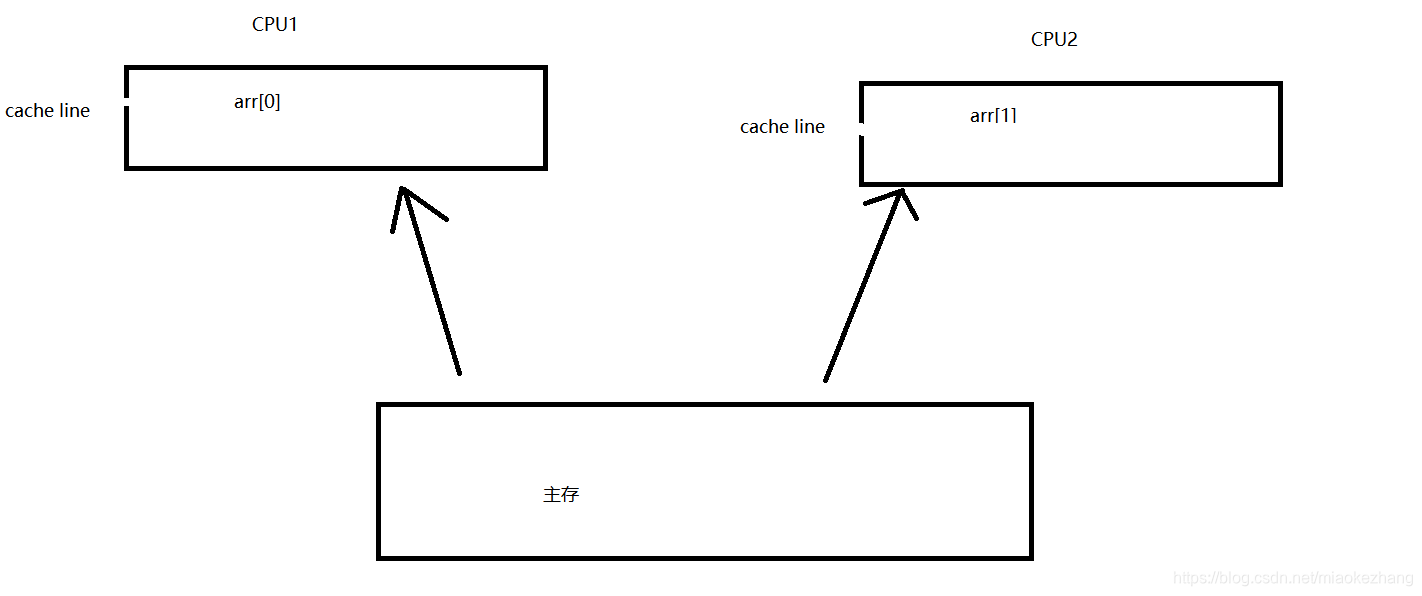

从图中可以暂且认定

CPU从寄存器读取数据:CPU从主存读取数据 约= 1:100

而缓存行cache line就是为了解决这种速度上的差异

缓存行为CPU缓存的最小单位,多数CPU缓存行大小为64个字节

图中展示了CPU对x、y从内存到寄存器的读取步骤,多CPU在读取数据到L2时就会独自占有相应的缓存资源。

缓存行对于内存中比较小的数据会进行缓存行对齐,就是缓存行里尽量放多一点达到64个字节数据进行读取(与局部性原理有点像)

代码证明

public class T01_CacheLinePadding {

private static class T extends Padding {

public volatile long x = 0L;

}

public static T[] arr = new T[2];

static {

arr[0] = new T();

arr[1] = new T();

}

public static void main(String[] args) throws Exception {

Thread t1 = new Thread(()->{

for (long i = 0; i < 1000_0000L; i++) {

arr[0].x = i;

}

});

Thread t2 = new Thread(()->{

for (long i = 0; i < 1000_0000L; i++) {

arr[1].x = i;

}

});

final long start = System.nanoTime();

t1.start();

t2.start();

t1.join();

t2.join();

System.out.println((System.nanoTime() - start)/100_0000);

}

}

代码中有声明了一个内部类T,内容只有一个等于0且是volatile的long型x,以及一个内容为T且长度为2的数组arr,主方法创建两个线程分别来循环一千万次对arr数组下标0、1进行赋值。

运行这段代码后,花的时间大概在230ms左右。

下面我们再来看一段代码

public class T02_CacheLinePadding {

private static class Padding {

public volatile long p1, p2, p3, p4, p5, p6, p7; //

}

private static class T extends Padding {

public volatile long x = 0L;

}

public static T[] arr = new T[2];

static {

arr[0] = new T();

arr[1] = new T();

}

public static void main(String[] args) throws Exception {

Thread t1 = new Thread(()->{

for (long i = 0; i < 1000_0000L; i++) {

arr[0].x = i;

}

});

Thread t2 = new Thread(()->{

for (long i = 0; i < 1000_0000L; i++) {

arr[1].x = i;

}

});

final long start = System.nanoTime();

t1.start();

t2.start();

t1.join();

t2.join();

System.out.println((System.nanoTime() - start)/100_0000);

}

}

这一段代码与第一段区别在与定义了类T的一个父类Padding,而这个父类Padding定义了p1,p2,p3,p4,p5,p6,p7这个7个long型变量,这代表什么呢?这代表类T的对象在new出来的时候,首先会有自己的成员变量x,还会有继承父类Padding的p1到p7者7个long型变量,想想看,这个对象的大小正好是64个字节,即正好是一个缓存行cache line的大小。

运行代码后,花的时间大概是100多ms,兄弟,快了一倍呀!

具体分析

第一段代码中,CPU在执行时,可能会将arr[0].x、arr[1].x放进同一个缓存行里,以为long型占8个字节,而缓存行为64个字节,由于arr数据元素为T,而T类的x变量是volatile修饰的,当CPU1对arr[0].x进行修改并将数据放回主存的时候需要通知正在修改arr[1].x数据的CPU2,告诉CPU2,你的缓存行cache line里的arr[0]已经失效啦,你要从主存里重新获取缓存行里的数据,这样CPU2就需要频繁的从主存中更新arr[0]的值。

而在第二段代码中,类T继承了Padding类,T对象new处理就占了64个字节,正好对应一个缓存行,arr[0].x在写回主存的时候,不需要通知CPU2,就不会频繁的再去从主存中更新数据。

书籍原话:

instance = new Singleton(); // instance是volatile变量

转变成汇编代码,如下

0x01a3de1d: movb $0×0,0×1104800(%esi);

0x01a3de24: lock addl $0×0,(%esp);

有volatile变量修饰的共享变量进行写操作的时候会多出第二行汇编代码,通过查IA-32架 构软件开发者手册可知,Lock前缀的指令在多核处理器下会引发了两件事情

//

1)将当前处理器缓存行的数据写回到系统内存。

2)这个写回内存的操作会使在其他CPU里缓存了该内存地址的数据无效。

//

为了提高处理速度,处理器不直接和内存进行通信,而是先将系统内存的数据读到内部缓存(L1,L2或其他)后再进行操作,但操作完不知道何时会写到内存。如果对声明了volatile的 变量进行写操作,JVM就会向处理器发送一条Lock前缀的指令,将这个变量所在缓存行的数据写回到系统内存。但是,就算写回到内存,如果其他处理器缓存的值还是旧的,再执行计算操作就会有问题。所以,在多处理器下,为了保证各个处理器的缓存是一致的,就会实现缓存一致性协议,每个处理器通过嗅探在总线上传播的数据来检查自己缓存的值是不是过期了,当处理器发现自己缓存行对应的内存地址被修改,就会将当前处理器的缓存行设置成无效状态,当处理器对这个数据进行修改操作的时候,会重新从系统内存中把数据读到处理器缓存里。

下面来具体讲解volatile的两条实现原则。

1)Lock前缀指令会引起处理器缓存回写到内存。

Lock前缀指令导致在执行指令期间,声 言处理器的LOCK#信号。在多处理器环境中,LOCK#信号确保在声言该信号期间,处理器可以 独占任何共享内存[2]。但是,在最近的处理器里,LOCK#信号一般不锁总线,而是锁缓存,毕 竟锁总线开销的比较大。在8.1.4节有详细说明锁定操作对处理器缓存的影响,对于Intel486和 Pentium处理器,在锁操作时,总是在总线上声言LOCK#信号。但在P6和目前的处理器中,如果 访问的内存区域已经缓存在处理器内部,则不会声言LOCK#信号。相反,它会锁定这块内存区 域的缓存并回写到内存,并使用缓存一致性机制来确保修改的原子性,此操作被称为“缓存锁 定”,缓存一致性机制会阻止同时修改由两个以上处理器缓存的内存区域数据。

2)一个处理器的缓存回写到内存会导致其他处理器的缓存无效。

IA-32处理器和Intel 64处 理器使用MESI(修改、独占、共享、无效)控制协议去维护内部缓存和其他处理器缓存的一致 性。在多核处理器系统中进行操作的时候,IA-32和Intel 64处理器能嗅探其他处理器访问系统内存和它们的内部缓存。处理器使用嗅探技术保证它的内部缓存、系统内存和其他处理器的 缓存的数据在总线上保持一致。例如,在Pentium和P6 family处理器中,如果通过嗅探一个处理器来检测其他处理器打算写内存地址,而这个地址当前处于共享状态,那么正在嗅探的处理器将使它的缓存行无效,在下次访问相同内存地址时,强制执行缓存行填充。

追加字节能优化性能?这种方式看起来很神奇,但如果深入理解处理器架构就能理解其 中的奥秘。让我们先来看看LinkedTransferQueue这个类,它使用一个内部类类型来定义队列的 头节点(head)和尾节点(tail),而这个内部类PaddedAtomicReference相对于父类 AtomicReference只做了一件事情,就是将共享变量追加到64字节。我们可以来计算下,一个对 象的引用占4个字节,它追加了15个变量(共占60个字节),再加上父类的value变量,一共64个

字节。

追加字节能优化性能?这种方式看起来很神奇,但如果深入理解处理器架构就能理解其 中的奥秘。让我们先来看看LinkedTransferQueue这个类,它使用一个内部类类型来定义队列的 头节点(head)和尾节点(tail),而这个内部类PaddedAtomicReference相对于父类 AtomicReference只做了一件事情,就是将共享变量追加到64字节。我们可以来计算下,一个对 象的引用占4个字节,它追加了15个变量(共占60个字节),再加上父类的value变量,一共64个字节。

为什么追加64字节能够提高并发编程的效率呢?因为对于英特尔酷睿i7、酷睿、Atom和 NetBurst,以及Core Solo和Pentium M处理器的L1、L2或L3缓存的高速缓存行是64个字节宽,不 支持部分填充缓存行,这意味着,如果队列的头节点和尾节点都不足64字节的话,处理器会将它们都读到同一个高速缓存行中,在多处理器下每个处理器都会缓存同样的头、尾节点,当一个处理器试图修改头节点时,会将整个缓存行锁定,那么在缓存一致性机制的作用下,会导致其他处理器不能访问自己高速缓存中的尾节点,而队列的入队和出队操作则需要不停修改头

节点和尾节点,所以在多处理器的情况下将会严重影响到队列的入队和出队效率。Doug lea使 用追加到64字节的方式来填满高速缓冲区的缓存行,避免头节点和尾节点加载到同一个缓存行,使头、尾节点在修改时不会互相锁定。

本文探讨了CPU缓存层级,缓存行的概念及其对并发编程的影响。通过实例对比,展示了如何利用缓存行对齐优化多线程性能,避免缓存行争用,提升程序执行效率。

本文探讨了CPU缓存层级,缓存行的概念及其对并发编程的影响。通过实例对比,展示了如何利用缓存行对齐优化多线程性能,避免缓存行争用,提升程序执行效率。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?