使用Anaconda下载pyspark

在anaconda内创建虚拟环境pyspark(名字随便起)

conda create -n 名字 python=3.8

查看虚拟环境

conda env list

激活虚拟环境

conda activate 名字

pip用清华源下载pyspark

pip install pyspark -i https://pypi.tuna.tsinghua.edu.cn/simple

版本问题需要注意:

在pycharm输入代码查看pyspark版本

import pyspark

print(pyspark.__version__)

根据相应的java版本下载pyspark,我用的是java-21,pyspark3.5.4。具体根据java版本选择pyspark升版本还是降版本,版本不匹配也会报错。

pycharm配置conda环境的解释器

添加conda环境解释器

- 点击pycharm右下角解释器

- 点击添加解释器

- 在添加解释器界面点击conda环境

- 点击conda环境→现有环境→右侧 ... 图标

找到anaconda内python安装位置

- 按路径找到python.exe

- anaconda\envs\pyspark(anaconda虚拟环境名字)\python.exe

- 勾选可用于所有项目

- 点击确定

在pycharm中使用pyspark时报错

问题:

执行测试代码pyspark的map方法

from pyspark import SparkConf, SparkContext if __name__ == '__main__': conf = SparkConf().setMaster('local[*]').setAppName('spark_test') sc = SparkContext(conf=conf) rdd = sc.parallelize([1, 2, 3, 4, 5]) print(rdd.map(lambda data: data*10).collect()) sc.stop()

pycharm报错

解决方案:

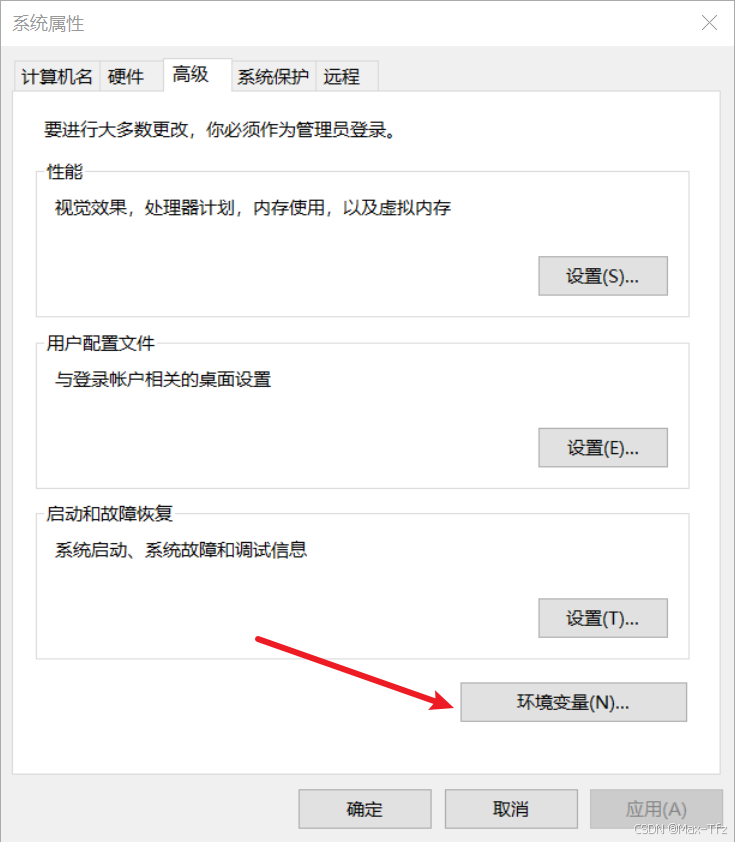

配置windows的java的环境变量

- 在Windows桌面右键点击此电脑

-

点击属性

- 点击高级系统设置

- 点击环境变量

- 在系统变量内找到Path变量

- 添加自己的java所在文件夹路径

最后把打开的对话框全部点确定,保存设置

查看是否配置成功

- win+R输入cmd打开黑框

- 在黑框内输入java -version查看java版本,弹出版本号路径添加成功

在pycharm内配置环境变量

在pycharm找到编辑配置

找到环境配置点击右侧进行编辑

点击+添加JAVA_HOME与PYSPARK_PYTHON变量

- JAVA_HOME指向java所在文件夹

- PYSPARK_PYTHON指向python所在文件夹

点击确定保存退出

配置完成后运行代码

1758

1758

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?