首先,我将简要概述相关的数学原理及其原因,接下来,我们将深入探讨论文的细节,以及它们如何应用于 GPT-2 和 GPT-3 等 transformers 模型。

最重要的一点是:LoRA 减少了可训练参数(trainable parameters)的数量,从而减少了训练时间和 GPU 内存的使用量,同时保持了输出的质量。

LLM(顾名思义)的规模非常大。用于微调的数据集(fine-tuning datasets)通常比模型的预训练数据集小得多。当数据集比较小的时候,LoRA 只需更新较少的权重,这即是 LoRA 的优势所在。

二、LoRA 的工作原理

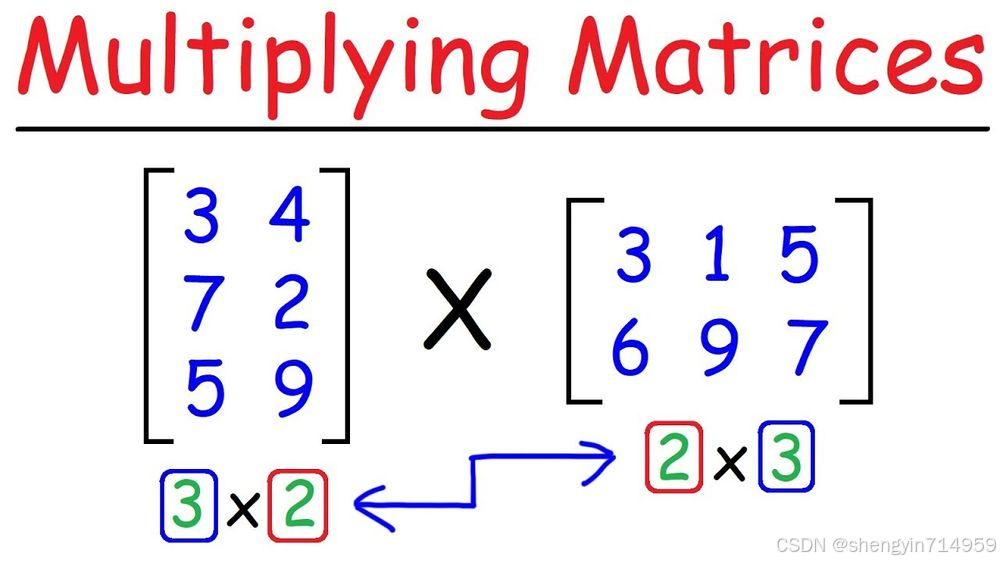

如果你熟悉矩阵乘法,那么应该知道 AxM 矩阵和 MxB 矩阵相乘得到的结果是一个 AxB 矩阵。

假设在神经网络中有一个 MxM 的预训练密集层(pre-trained dense layer)(权重矩阵)W。

例如,这个 Keras 模型有 3 个 size 为 512x512 的密集层(dense layers):

订阅专栏 解锁全文

订阅专栏 解锁全文

590

590

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?