ChatGML微调训练医疗问答任务

目录

一. ChatGLM2-6B

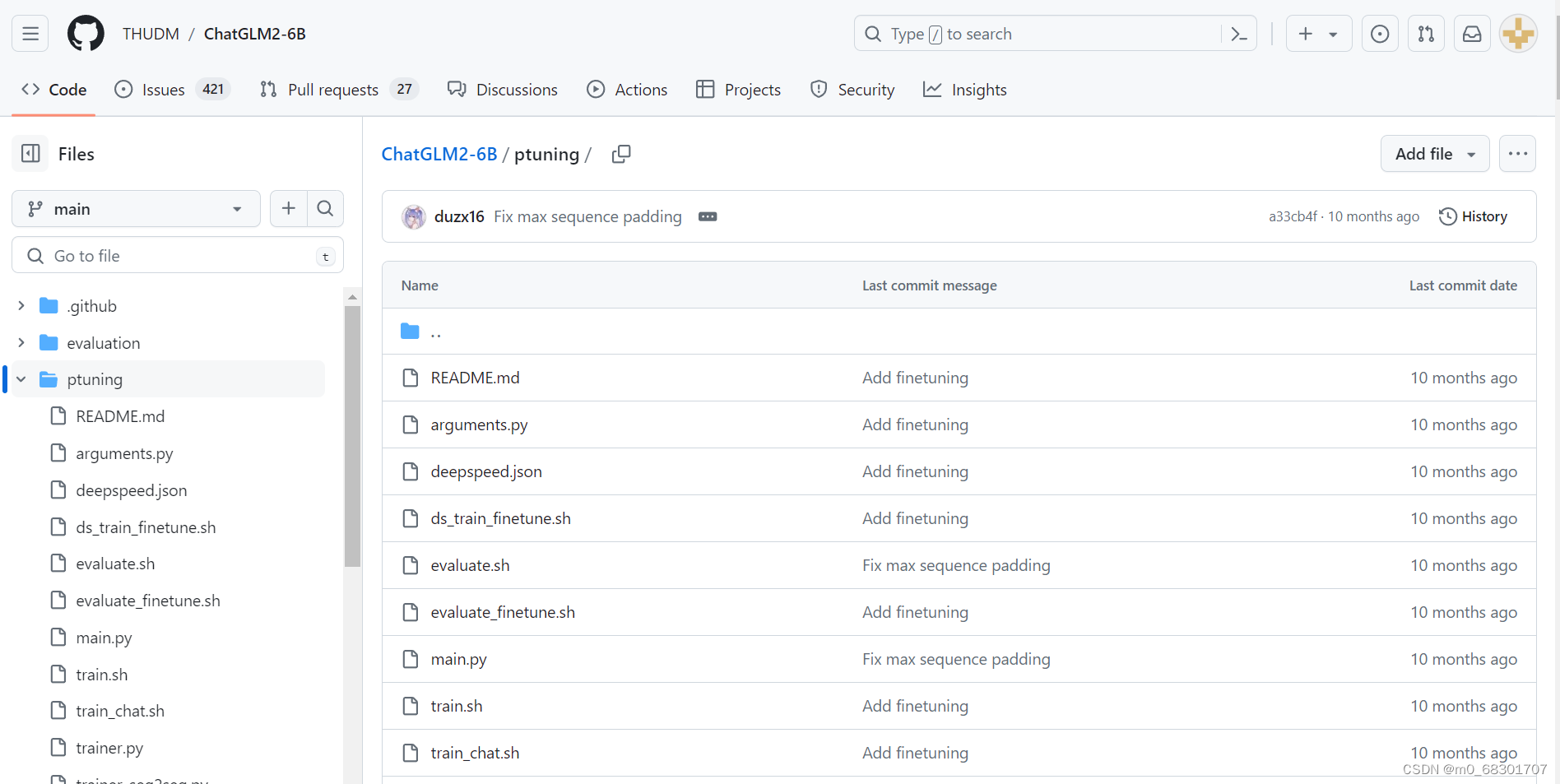

官方github地址:https://github.com/THUDM/ChatGLM2-6B

ChatGLM2-6B 是 ChatGLM-6B 的第二代版本,在保留了初代模型对话流畅、部署门槛较低等众多优秀特性的基础之上,同时引入了许多新特性,如:更强大的性能、更长的上下文、更高效的推理、更开放的协议 等。

(1)cli_demo

cli界面是通过在命令行之内直接交互来进行问答的,如下图所示:

(2)web_demo

web_demo界面是通过在Web网页中进行交互问答的,如下图所示:

(3)web_demo2

web_demo2界面也是通过在Web网页中进行交互问答的,如下图所示:

二. P-tuning-v2

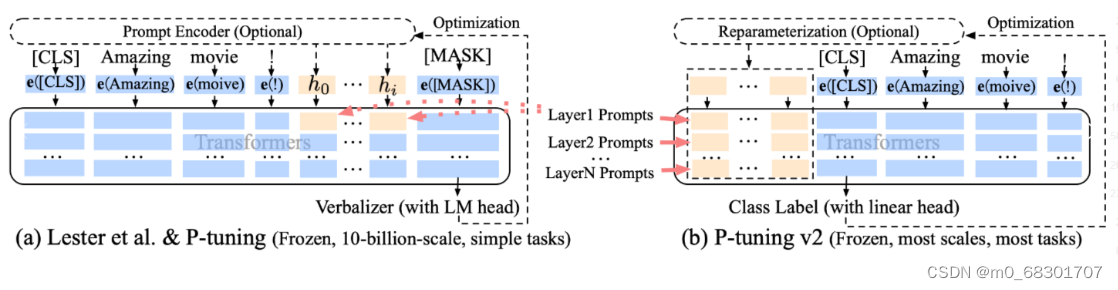

参考论文:P-Tuning v2: Prompt Tuning Can Be Comparable to Fine-tuning Universally Across Scales and Tasks

微调技术:使用ChatGLM 官方推出的 P-tuning-v2

P-tuning v2 微调技术利用 deep prompt tuning,即对预训练 Transformer 的每一层输入应用 continuous prompts 。deep prompt tuning 增加了 continuo us prompts 的能力,并缩小了跨各种设置进行微调的差距,特别是对于小型模型和困难任务。

左图为P-tuning,右图为P-tuning v2

三. 模型下载

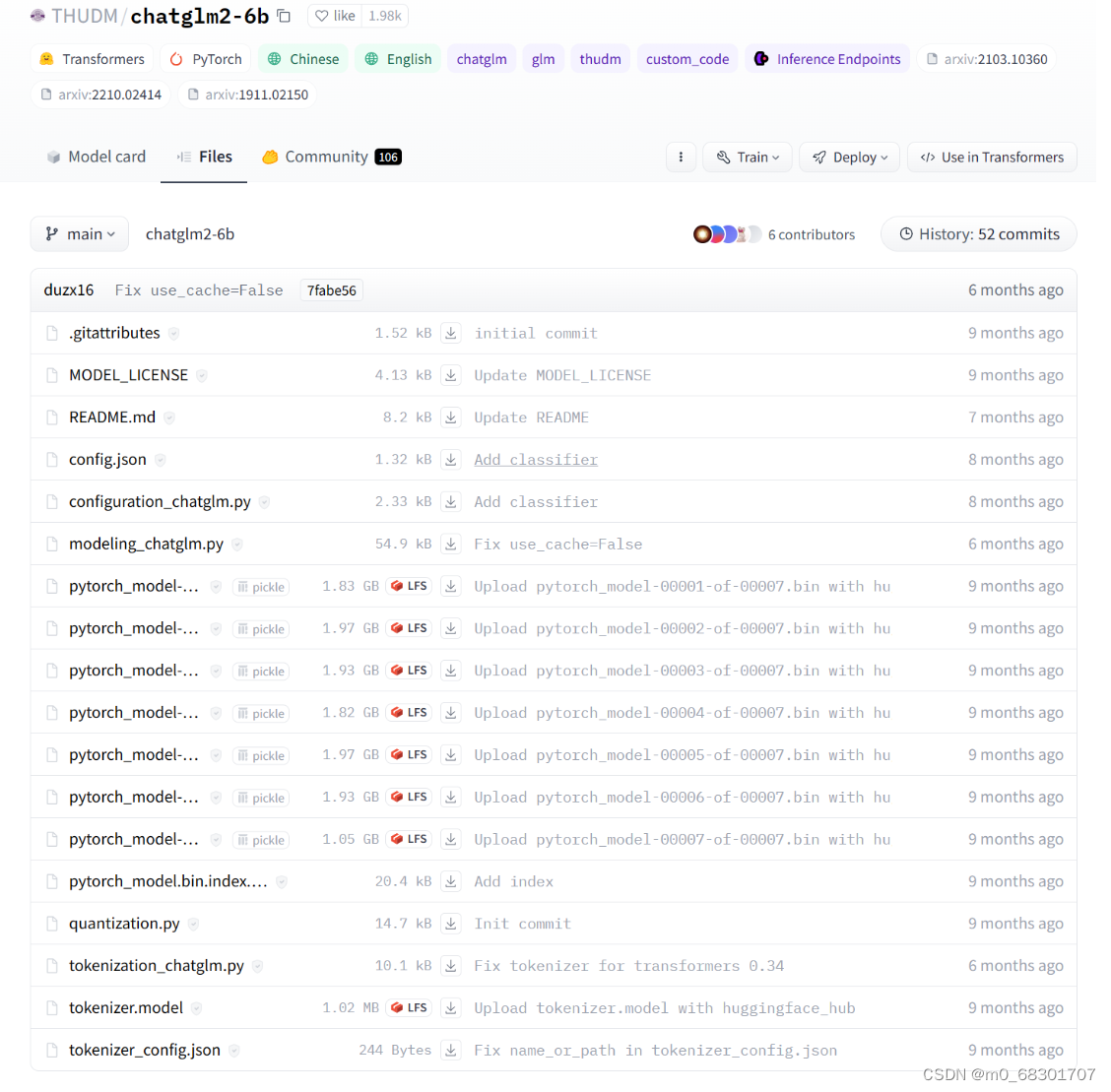

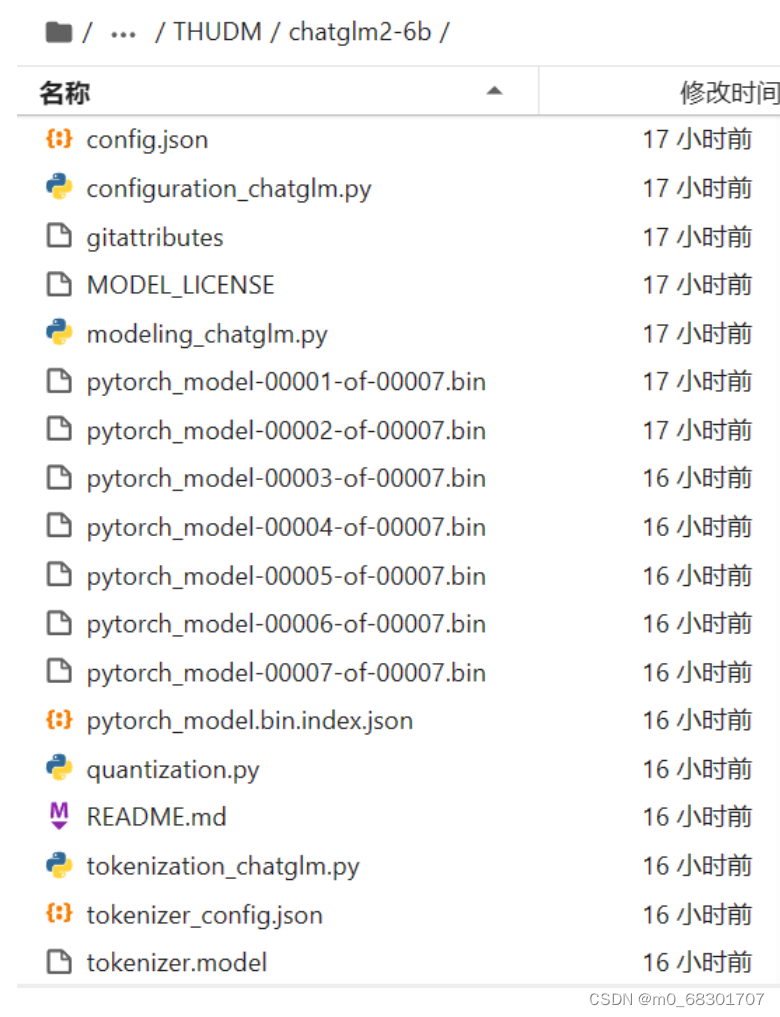

huggingface 地址:https://huggingface.co/THUDM/chatglm2-6b/tree/main

注意:这里将模型文件下载到了ChatGLM2-6B/THUDM/chatglm2-6b目录下

四. 数据集处理

使用 GitHub 上的 Chinese-medical-dialogue-data 中文医疗问答数据集

下载地址:https://github.com/Toyhom/Chinese-medical-dialogue-data

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?