先了解一下这几个概念

TP(True Positive):对groundtruth 正确检测或者是预测框体与GT框体的阈值大于预设的阈值

FP(False Positive) :对不存在的东西做了错的检测或是预测的IoU小于预设的阈值

FN(False Negative):没有检测到的GT的数量

查准率和查全率:

Precision 查准率:TP/(TP+FP) 模型预测的所有目标中,预测正确的比例

Recall 查全率:TP/(TP+FN) 所有真实目标中,模型预测正确的目标比例

AP:P-R曲线下的面积

P-R曲线:Precision-Recall 曲线

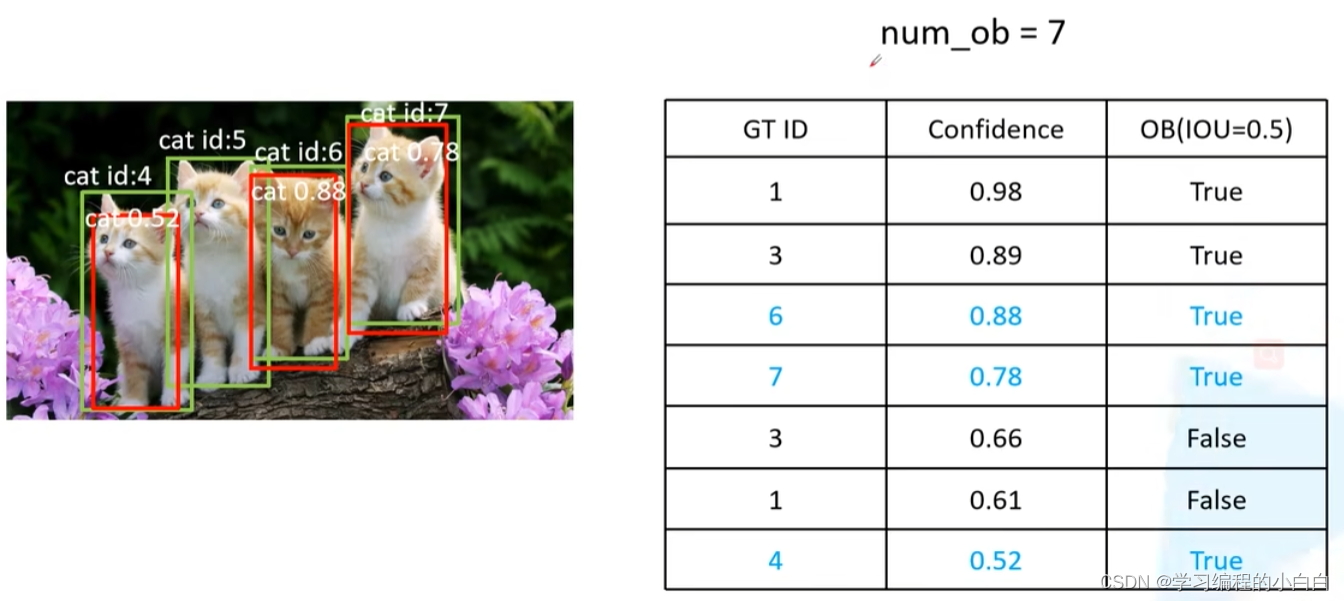

我们以猫类别为例,假设模型已经训练好了,验证集就是这三张图片

对于第一张图片,我们将它的检测结果给记录成一个表格,表格中记录每个GT ID,每个检测框的置信度,还有预测框与GT的交并比是否大于设定的阈值,同时记录一下GT的数量num_ob,表格中的置信度按降序排列

对于第二张图片,执行相同的操作,结果如下:

第三张图片,执行与第一张图片相同的操作结果如下:

这样我们就将模型的检测结果记录下来,得到一个表格,有了这个表格之后,我们就来计算一下针对confidience取不同的阈值所得到的Precision 和Recall的信息

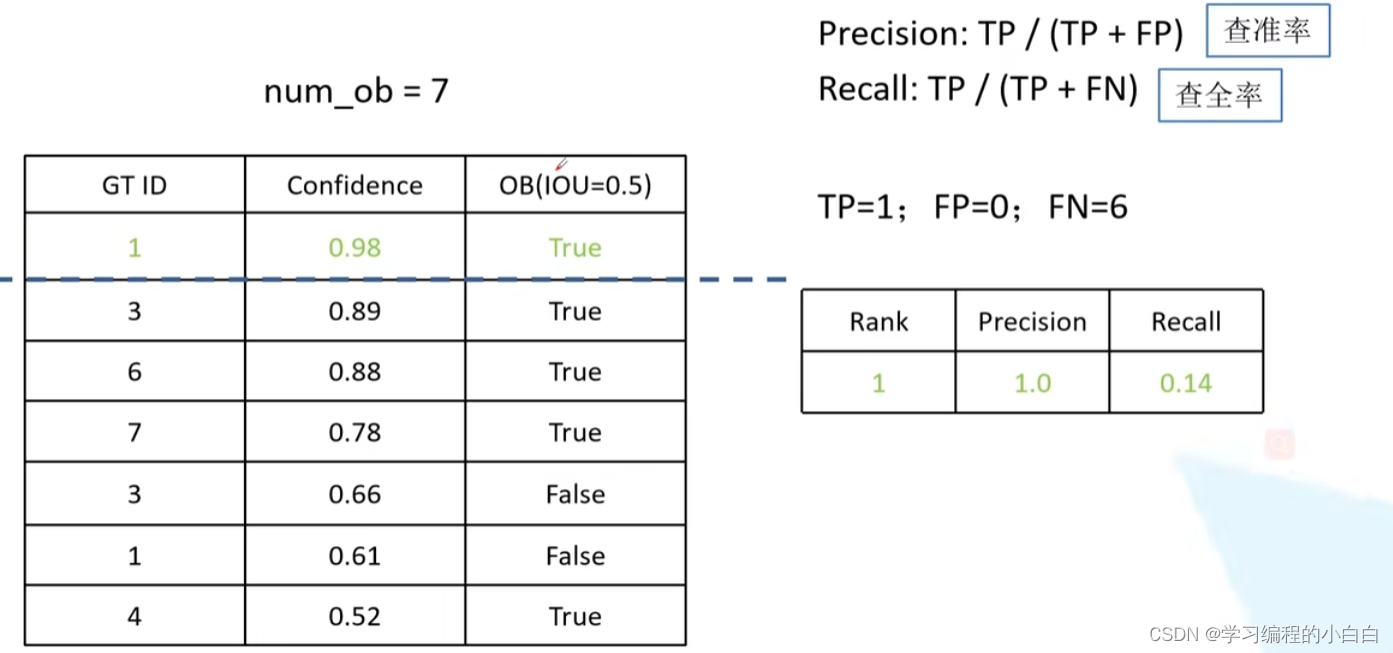

首先取confidence取大于等于0.98,计算Precision和Recall,下图是计算结果

我们将confidence取大于等于0.89,计算Precision和Recall

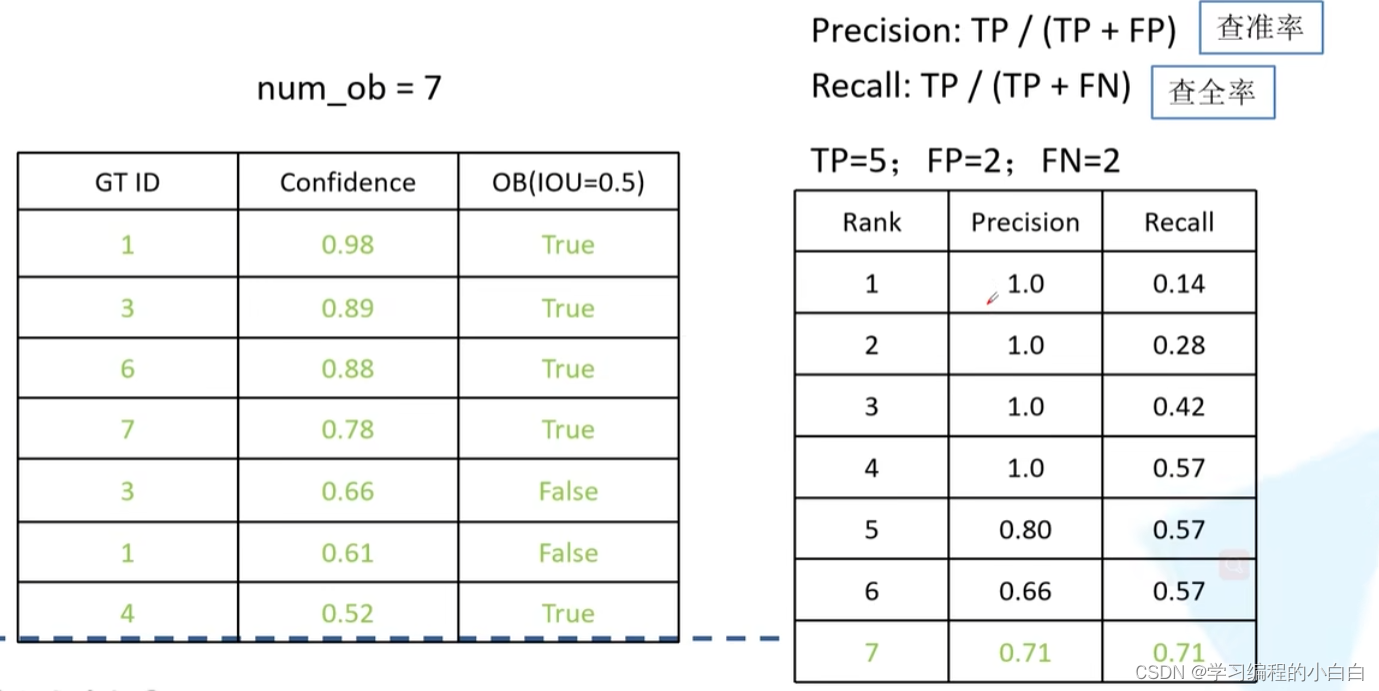

接下来取confidence大于等于0.88,再取confidence大于等于0.78,以此类推,直到计算完整个表格

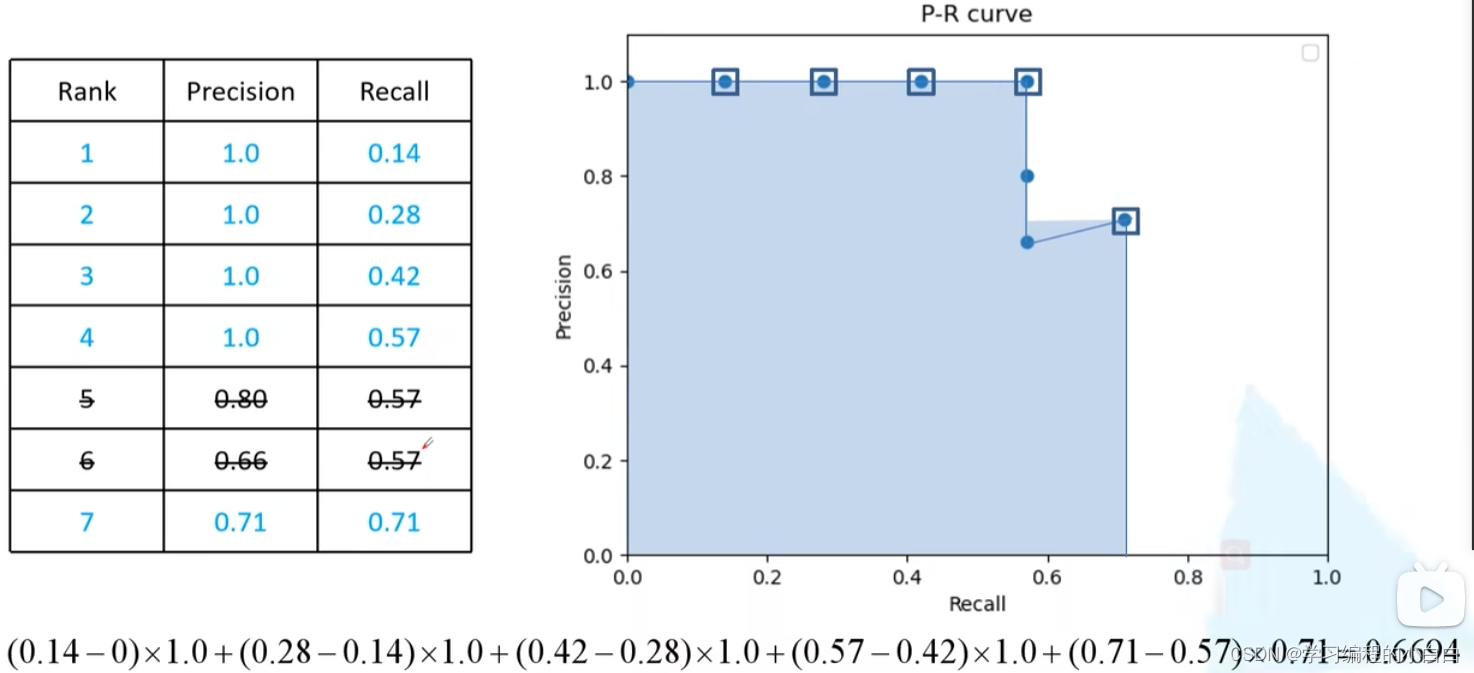

全部计算之后,我们就能得到一系列的Precision和Recall,我们就以Recall 为横坐标,Precision为纵坐标就能得到一个P-R曲线,需要注意的是,对于横坐标Recall,需要滤除一些重复的信息,比如说,对于Recall等于0.57 的情况,我们这个表格里面有三个值,我们只需要保留Precision 值最大的情况

我们就可以计算P-R曲线下的面积了,用阴影部分框住的面积呢就是AP了,也就是对于猫这个类别的AP结果。

我们常说的mAP 就是各类别AP的平均值。

本文介绍了目标检测中的关键术语如TruePositive、FalsePositive和FalseNegative,以及查准率、查全率、Precision、Recall和AP的概念。通过实例分析,详细解释了如何通过设置不同confidence阈值计算P-R曲线和mAP(均值平均精度)。

本文介绍了目标检测中的关键术语如TruePositive、FalsePositive和FalseNegative,以及查准率、查全率、Precision、Recall和AP的概念。通过实例分析,详细解释了如何通过设置不同confidence阈值计算P-R曲线和mAP(均值平均精度)。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?