实现 master/master 的 Keepalived 双主架构

master/slave

的单主架构,同一时间只有一个

Keepalived

对外提供服务,此主机繁忙,而另一台主机却很空闲,利用率低下,可以使用master/master

的双主架构,解决此问题。

master/master

的双主架构:

即将两个或以上

VIP

分别运行在不同的

keepalived

服务器,以实现服务器并行提供

web

访问的目的,提高服务器资源利用率

KA1

#ha1主机配置

[root@rhel7-ka1 ~]# vim /etc/keepalived/keepalived.conf

@@@@ 内容省略 @@@@

vrrp_instance VI_1 {

state MASTER #主

interface ens33

virtual_router_id 50

priority 100

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

172.25.254.50 dev ens33 label ens33:0

}

}

vrrp_instance VI_60 {

state BACKUP #备

interface ens33

virtual_router_id 60

priority 80

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

172.25.254.60 dev ens33 label ens33:1

}

}

KA2

[root@rhel7-ka2 ~]# vim /etc/keepalived/keepalived.conf

@@@@ 内容省略 @@@@

vrrp_instance VI_1 {

state BACKUP #备

interface ens33

virtual_router_id 50

priority 80

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

172.25.254.50 dev ens33 label ens33:0

}

}

vrrp_instance VI_60 {

state MASTER #主

interface ens33

virtual_router_id 60

priority 100

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

172.25.254.60 dev eth0 label eth0:1

}

}

ps:如果想要三个节点的三主架构实现:

# 第一个节点 ka1 配置:Vrrp instance 1 : MASTER ,优先级 100Vrrp instance 2 : BACKUP ,优先级 80Vrrp instance 3 : BACKUP ,优先级 60# 第二个节点 ka2 配置:Vrrp instance 1 : BACKUP ,优先级 60Vrrp instance 2 : MASTER ,优先级 100Vrrp instance 3 : BACKUP ,优先级 80# 第三个节点 ka3 配置:Vrrp instance 1 : BACKUP ,优先级 80Vrrp instance 2 : BACKUP ,优先级 60Vrrp instance 3 : MASTER ,优先级 100

实现ipvs的高可用性

1 虚拟服务器配置结构

virtual_server IP port {

...

real_server {

...

}

real_server {

...

}

…

}2 virtual server (虚拟服务器)的定义格式

virtual_server IP port #定义虚拟主机IP地址及其端口

virtual_server fwmark int #ipvs的防火墙打标,实现基于防火墙的负载均衡集群

virtual_server group string #使用虚拟服务器组

3 虚拟服务器配置

virtual_server IP port { #VIP和PORT

delay_loop <INT> #检查后端服务器的时间间隔

lb_algo rr|wrr|lc|wlc|lblc|sh|dh #定义调度方法

lb_kind NAT|DR|TUN #集群的类型,注意要大写

persistence_timeout <INT> #持久连接时长

protocol TCP|UDP|SCTP #指定服务协议,一般为TCP

sorry_server <IPADDR> <PORT> #所有RS故障时,备用服务器地址

real_server <IPADDR> <PORT> { #RS的IP和PORT

weight <INT> #RS权重

notify_up <STRING>|<QUOTED-STRING> #RS上线通知脚本

notify_down <STRING>|<QUOTED-STRING> #RS下线通知脚本

HTTP_GET|SSL_GET|TCP_CHECK|SMTP_CHECK|MISC_CHECK { ... } #定义当前主机健康状

态检测方法

}

}

#注意:括号必须分行写,两个括号写在同一行,如: }} 会出错

4 应用层监测

HTTP_GET|SSL_GET {

url {

path <URL_PATH> #定义要监控的URL

status_code <INT> #判断上述检测机制为健康状态的响应码,一般为 200

}

connect_timeout <INTEGER> #客户端请求的超时时长, 相当于haproxy的timeout server

nb_get_retry <INT> #重试次数

delay_before_retry <INT> #重试之前的延迟时长

connect_ip <IP ADDRESS> #向当前RS哪个IP地址发起健康状态检测请求

connect_port <PORT> #向当前RS的哪个PORT发起健康状态检测请求

bindto <IP ADDRESS> #向当前RS发出健康状态检测请求时使用的源地址

bind_port <PORT> #向当前RS发出健康状态检测请求时使用的源端口

}

5 TCP监测

TCP_CHECK {

connect_ip <IP ADDRESS> #向当前RS的哪个IP地址发起健康状态检测请求

connect_port <PORT> #向当前RS的哪个PORT发起健康状态检测请求

bindto <IP ADDRESS> #发出健康状态检测请求时使用的源地址

bind_port <PORT> #发出健康状态检测请求时使用的源端口

connect_timeout <INTEGER> #客户端请求的超时时长

#等于haproxy的timeout server

}实验:

实战案例

1

:实现单主的

LVS-DR

模式

准备

web

服务器并使用脚本绑定

VIP

至

web

服务器

lo

网卡

#准备两台后端RS主机

[root@rs1 ~]# yum install httpd -y

[root@rs1 ~]# echo RS1 - 172.25.254.101 > /var/www/html/index.html

[root@rs1 ~]# ip addr add 172.25.254.100/32 dev lo

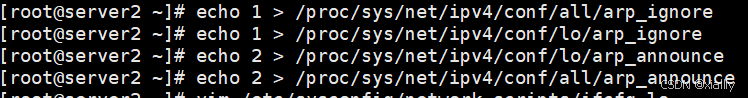

[root@rs1 ~]# echo 1 > /proc/sys/net/ipv4/conf/all/arp_ignore

[root@rs1 ~]# echo 1 > /proc/sys/net/ipv4/conf/lo/arp_ignore

[root@rs1 ~]# echo 2 > /proc/sys/net/ipv4/conf/lo/arp_announce

[root@rs2 ~]# yum install httpd -y

[root@rs1 ~]# echo RS1 - 172.25.254.101 > /var/www/html/index.html

[root@rs2 ~]# ip addr add 172.25.254.100/32 dev lo

[root@rs2 ~]# echo 1 > /proc/sys/net/ipv4/conf/all/arp_ignore

[root@rs2 ~]# echo 1 > /proc/sys/net/ipv4/conf/lo/arp_ignore

[root@rs2 ~]# echo 2 > /proc/sys/net/ipv4/conf/lo/arp_announce

[root@node30 ~]# yum install httpd -y

[root@node30 ~]# echo RS1 - 172.25.254.101 > /var/www/html/index.html

[root@node30 ~]# ip addr add 172.25.254.100/32 dev lo

[root@node30 ~]# echo 1 > /proc/sys/net/ipv4/conf/all/arp_ignore

[root@node30 ~]# echo 1 > /proc/sys/net/ipv4/conf/lo/arp_ignore

[root@node30

~]# echo 2 > /proc/sys/net/ipv4/conf/lo/arp_announce172.25.254.110

设置lo

172.25.254.120

配置keepalived

#ka1节点的配置

[root@rhel7-ka1 ~]# vim /etc/keepalived/keepalived.conf

@@@@ 省略内容 @@@@

virtual_server 172.25.254.100 80 {

delay_loop 6

lb_algo wrr

lb_kind DR

protocol TCP

sorry_server 172.25.254.30

real_server 172.25.254.101 80 {

weight 1

TCP_CHECK {

connect_timeout 5

nb_get_retry 3

delay_before_retry 3

connect_port 80

}

}

real_server 172.25.254.102 80 {

weight 1

HTTP_GET {

url {

path /

status_code 200

}

connect_timeout 1

nb_get_retry 3

delay_before_retry 1

}

}

}

#ka2节点的配置,配置和ka1基本相同,只需修改三行

[root@rhel7-ka2 ~]# vim /etc/keepalived/keepalived.conf

@@@@ 省略内容 @@@@

virtual_server 172.25.254.100 80 {

delay_loop 6

lb_algo wrr

lb_kind DR

protocol TCP

sorry_server 172.25.254.30

real_server 172.25.254.101 80 {

weight 1

TCP_CHECK {

connect_timeout 5

nb_get_retry 3

delay_before_retry 3

connect_port 80

}

}

real_server 172.25.254.102 80 {

weight 1

HTTP_GET {

url {

path /

status_code 200

}

connect_timeout 1

nb_get_retry 3

delay_before_retry 1

}

}

}KA1和KA2

测试结果:

模拟故障

#第一台RS1故障,自动切换至RS2

[root@rs1 ~]# systemctl stop httpd #当RS1故障

[Administrator.WIN-20240602BIS] ➤ for i in {1..6}; do curl 172.25.254.100; done

#全部流浪被定向到RS2中

RS2 - 172.25.254.102

RS2 - 172.25.254.102

RS2 - 172.25.254.102

RS2 - 172.25.254.102

RS2 - 172.25.254.102

RS2 - 172.25.254.102

[root@rhel7-ka1 ~]# ipvsadm -Ln

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 172.25.254.100:80 wrr

-> 172.25.254.102:80 Route 1 0 12 #RS1被踢出保留

RS2

#后端RS服务器都故障,启动Sorry Server

[root@rs2 ~]#systemctl stop httpd

[Administrator.WIN-20240602BIS] ➤ for i in {1..6}; do curl 172.25.254.100; done

sorry server

sorry server

sorry server

sorry server

sorry server

sorry server

[root@rhel7-ka1 ~]# ipvsadm -Ln

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 172.25.254.100:80 wrr

-> 172.25.254.30:80 Route 1 0 3

#陆续启动RS1 RS2

[root@rhel7-ka1 ~]# ipvsadm -Ln

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 172.25.254.100:80 wrr

-> 172.25.254.101:80 Route 1 0 3

-> 172.25.254.102:80 Route 1 0 9

#ka1故障,自动切换至ka2

[root@rhel7-ka1 ~]# systemctl stop keepalived.service

[root@rhel7-ka2 ~]# ipvsadm -Ln

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 172.25.254.100:80 wrr

-> 172.25.254.101:80 Route 1 0 0

-> 172.25.254.102:80 Route 1 0 0实现其它应用的高可用性 VRRP Script

keepalived

利用

VRRP Script

技术,可以调用外部的辅助脚本进行资源监控,并根据监控的结果实现优先动态调整,从而实现其它应用的高可用性功能

VRRP Script 配置

定义脚本

vrrp_script

:自定义资源监控脚本,

vrrp

实例根据脚本返回值,公共定义,可被多个实例调用,定

义在

vrrp

实例之外的独立配置块,一般放在

global_defs

设置块之后。

通常此脚本用于监控指定应用的状态。一旦发现应用的状态异常,则触发对

MASTER

节点的权重减至低于SLAVE

节点,从而实现

VIP

切换到

SLAVE

节点

vrrp_script <SCRIPT_NAME> {

script <STRING>|<QUOTED-STRING> #此脚本返回值为非0时,会触发下面OPTIONS执行

OPTIONS

}

调用脚本

track_script

:调用

vrrp_script

定义的脚本去监控资源,定义在

VRRP

实例之内,调用事先定义的

vrrp_script

track_script {

SCRIPT_NAME_1

SCRIPT_NAME_2

}

定义

VRRP script

vrrp_script <SCRIPT_NAME> { #定义一个检测脚本,在global_defs 之外配置

script <STRING>|<QUOTED-STRING> #shell命令或脚本路径

interval <INTEGER> #间隔时间,单位为秒,默认1秒

timeout <INTEGER> #超时时间

weight <INTEGER:-254..254> #默认为0,如果设置此值为负数,

#当上面脚本返回值为非0时

#会将此值与本节点权重相加可以降低本节点权重,

#即表示fall.

#如果是正数,当脚本返回值为0,

#会将此值与本节点权重相加可以提高本节点权重

#即表示 rise.通常使用负值

fall <INTEGER> #执行脚本连续几次都失败,则转换为失败,建议设为2以上

rise <INTEGER> #执行脚本连续几次都成功,把服务器从失败标记为成功

user USERNAME [GROUPNAME] #执行监测脚本的用户或组

init_fail #设置默认标记为失败状态,监测成功之后再转换为成功状态

}

调用

VRRP script

vrrp_instance test {

... ...

track_script {

check_down

}

}

实战案例:利用脚本实现主从角色切换和实现HAProxy高可用性

[root@rhel7-ka1 ~]# vim /mnt/check_lee.sh

#!/bin/bash

[ ! -f "/mnt/lee" ]

[root@rhel7-ka1 ~]# chmod +x /mnt/check_lee.sh

[root@rhel7-ka1 ~]# vim /etc/keepalived/keepalived.conf

@@@@ 省略内容 @@@@

vrrp_script check_lee {

script "/mnt/check_lee.sh"

interval 1

weight -30

fall 2

rise 2

timeout 2

}

vrrp_instance web {

state MASTER

interface ens33

virtual_router_id 50

priority 100

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

172.25.254.100 dev ens33 label ens33:0

}

track_script {

check_lee

}

}

[root@rhel7-ka1 ~]# touch /mnt/lee

[root@rhel7-ka1 ~]# tail -f /var/log/messages

设置脚本并设置权限

在KA1和KA2上进行配置haproxy的实现高可用

并在两个节点上启动内核参数

测试结果:

#在两个ka1和ka2先实现haproxy的配置

[root@rhel7-ka1 & ka2 ~]# vim /etc/haproxy/haproxy.cfg

listen webserver

bind 172.25.254.100:80

server web1 172.25.254.101:80 check

server web2 172.25.254.102:80 check

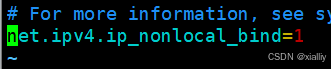

#在两个ka1和ka2两个节点启用内核参数

[root@rhel7-ka1 & ka2 ~]# vim /etc/sysctl.conf

net.ipv4.ip_nonlocal_bind = 1

[root@rhel7-ka1 & ka2 ~]# sysctl -p

#在ka1中编写检测脚本

[root@rhel7-ka1 ~]# vim /etc/keepalived/scripts/haproxy.sh

#!/bin/bash

/usr/bin/killall -0 haproxy

[root@rhel7-ka1 ~]# chmod +X /etc/keepalived/scripts/haproxy.sh

#在ka1中配置keepalived

[root@ka1-centos8 ~]#cat /etc/keepalived/keepalived.conf

vrrp_script check_haproxy {

script "/etc/keepalived/scripts/haproxy.sh"

interval 1

weight -30

fall 2

rise 2

timeout 2

}

vrrp_instance web {

state MASTER

interface ens33

virtual_router_id 50

priority 100

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

172.25.254.100 dev ens33 label ens33:0

}

track_script {

check_haproxy

}

}

#测试

root@rhel7-ka1 ~]# systemctl stop haproxy.service

2783

2783

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?