Ollama+Docker+Open WebUI

1、安装Ollama,专门用于在本地机器上便捷部署和运行大型语言模型(LLM)的开源框架

打开Ollama官网,点击Download下载

下载自己所需系统版本,这里我下载的是Windows版本

下载完成双击安装

等待安装完成

按Win+R呼出运行输入cmd回车打开命令提示符

根据自己所需输入对应指令,第一次输入指令会下载模型,没有科学环境比较慢

ollama run deepseek-r1:1.5b ##1.5b

ollama run deepseek-r1:7b ##7b

ollama run deepseek-r1:8b ##8b

ollama run deepseek-r1:14b ##14b

ollama run deepseek-r1:32b ##32b

ollama run deepseek-r1:70b ##70b

ollama run deepseek-r1:671b ##671b等待下载模型

模型下载完成即可使用,后续在命令提示符输入相应指令即可使用

到这里即可正常使用,但在命令提示符问答不太美观,可以使用Docker+Open WebUI搭建一个漂亮的UI

2、安装Docker,容器平台,用于部署Open WebUI

打开Docker官网,点击Download Docker Desktop下载自己所需系统版本,我这里下载的是windows-amd64

下载完成双击安装

等待安装

安装完成关闭重启系统

系统重启后docker自动运行

登录docker账号,没有账号自行注册

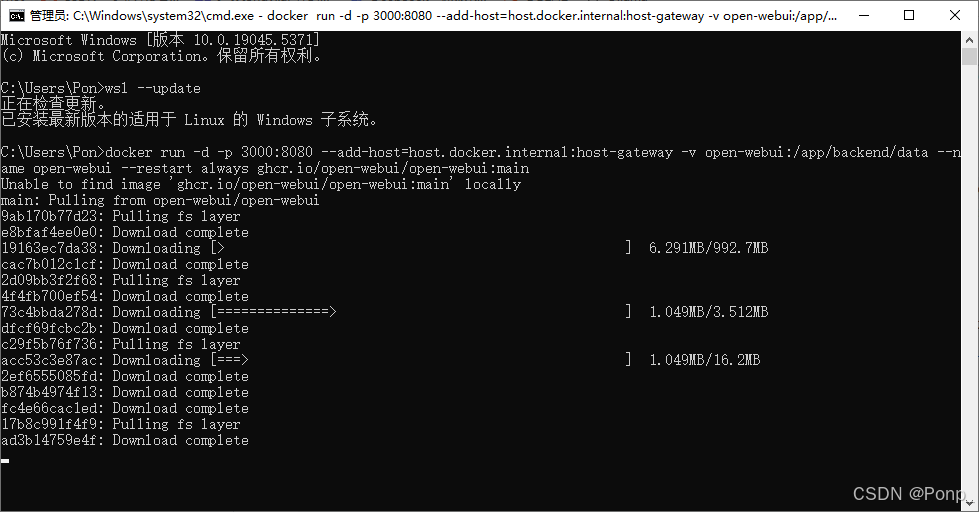

如果报错Docker Engine Stopped,检查并更新wsl,

这里我已更新,输入wsl --update等待更新完成

打开命令提示符,输入下面指令运行Open WebUI 容器:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

查看Docker容器,启动,启动前一定要run你的模型!!!

第一次进入需要创建管理员账号,账密就是你的Docker账密

愉快使用

大功告成!!!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?