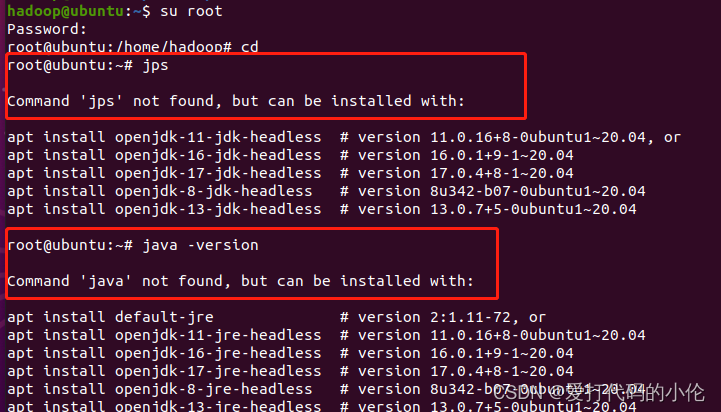

问题出现:

linux切换成root用户,命令jps找不到(无法使用Java命令),但是在普通用户可以使用。

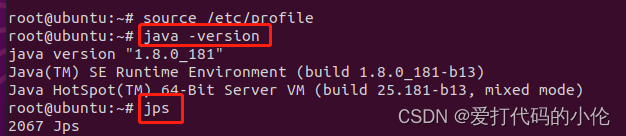

解决方法:

1.在root用户上使用source /etc/profile

source /etc/profile

2.使用java -version和jps(成功)

java -version

jps

博客主要讲述在Linux系统中,切换到root用户后,出现jps等Java命令找不到的问题,而普通用户可正常使用。解决方法是在root用户上执行source /etc/profile,之后使用java -version和jps命令可成功运行。

博客主要讲述在Linux系统中,切换到root用户后,出现jps等Java命令找不到的问题,而普通用户可正常使用。解决方法是在root用户上执行source /etc/profile,之后使用java -version和jps命令可成功运行。

linux切换成root用户,命令jps找不到(无法使用Java命令),但是在普通用户可以使用。

1.在root用户上使用source /etc/profile

source /etc/profile

2.使用java -version和jps(成功)

java -version

jps

1260

1260

1862

1862