Progressive Feature Alignment for Unsupervised Domain Adaptation

用于无监督领域自适应的渐进式特征对齐

Published in: 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR)

论文链接

概览

UDA: 标签丰富的源域到一个完全未标记的目标域。

Recent Approaches: 伪标签进行判别性域迁移,以强制跨源域和目标域的类级(class-level)分布对齐。

Existing Problem: 因为伪标签的准确性没有得到明确的保证,这些方法容易受到误差积累的影响,因此无法保持跨域类别的一致性。

Proposed Method: Progressive Feature Alignment Network (PFAN) 渐进式特征对齐网络(PFAN),通过利用目标域的类内变化,逐步有效地对齐跨域的判别性的特征。具体来说,首先,开发了一个由易到难的迁移策略(EHTS)和一个自适应原型对齐(APA)步骤来迭代和交替地训练模型。此外,在观察到一个良好的域自适应通常需要一个非饱和的源分类器后,考虑了一种简单而有效的方法,通过进一步将==温度变化(temperature variate)==纳入soft-max函数来延迟源分类损失的收敛速度。

动机

分类边界首先由完全标记的源域绘制,在目标域中存在类内的变异。

PFAN结构图

将网络分为三个模块:特征提取器 G G G、标签预测器 F F F、域鉴别器 D D D和相关参数 θ g 、 θ f 、 θ d θ_g、θ_f、θ_d θg、θf、θd。==左图:==由易到难的策略(ETHS)。==右图:==网络结构:PFAN中的虚线表示权重共享。

complement:补充 alleviate:减轻

理论分析插图

(a)假设在没有实现类别对齐的情况下,即在类别对齐之前:源域标记函数 f S f_S fS和伪标签函数 f T ^ f_{\hat \mathcal{T} } fT^存在一个最优性差距。(b)类别对齐后:最优性差距不再存在。

实验结果

A.

B.

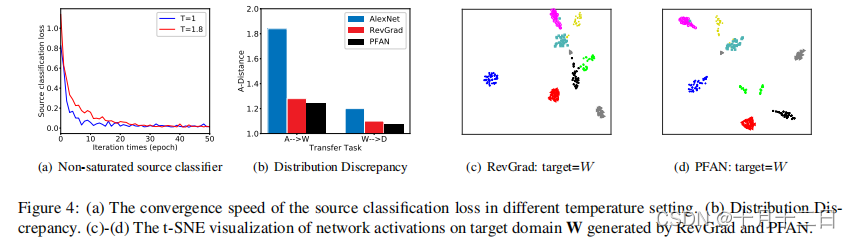

(a)不同温度设置下源分类损失的收敛速度。(b)分布的差异。©-(d)由RevGrad和PFAN生成的目标域 W 上的网络激活的t-SNE可视化。(之前很多方法会画出具有源域和目标域的t-SNE)

C.

迁移任务A→W的伪标记精度和测试精度的比较。伪标记精度使用(正确标记样本的数量)/(标记样本的数量)计算。

1. Introduction

拥有大规模标记数据集是深度卷积神经网络(CNNs)最近取得成功的原因之一。然而,在不同的领域中收集和注释大量的样本是一个极其昂贵和耗时的过程。同时,在一个大数据集上训练的传统CNNs也显示出由于数据偏差或漂移产生的较低的水平泛化能力。无监督域自适应(UDA) 方法通过将知识从一个标签丰富的源域迁移到一个完全未标记的目标域来解决上述问题。深度UDA方法,通常寻求共同实现小的源泛化误差和跨域分布差异,取得了显著的性能。

之前的大多数工作都集中在匹配全局源数据分布和目标数据分布,以学习领域不变的表示。然而,学习到的表示不仅使源和目标域更接近,而且将不同类标签的样本混合在一起。在最近的研究中,开始考虑学习目标领域的区别性表征。具体来说,其中一些提出使用伪标签来学习目标判别表示,这鼓励了目标域中类之间的低密度分离。

这些方法面临着两个关键的限制。

- 首先,他们需要一个很强的预先假设,即正确的伪标记样本可以减少错误伪标记样本引起的偏差。然而,满足这个假设是非常具有挑战的,特别是当域差异很大时。学习到的分类器可能无法自信地区分目标样本,或者无法用预期的精度要求对其精确地伪标记它们。

- 其次,他们基于伪标记样本对目标样本的类别损失进行反向传播,使目标性能容易受到误差积累的影响。

在探索过程中,本文通过经验观察了目标领域的不同数据模式。其动机如图1所示。 类内分布变化(variance)存在于目标域中。一些目标样本,称之为简单样本(easy samples),由于它们与源域足够接近,所以很有可能被正确分类,可以直接给它们分配伪标签,而不需要任何适应。一些目标样本,称之为困难样本(hard samples),离源域很远,它们的分类边界是模糊的。此外,一些容易的样本,称之为假容易的样本(false-easy samples),位于非对应的源类别的支持范围内,很容易被高置信度的伪标签所误导。这些虚假标记的样本在类别排列中引入了错误的信息,并有可能导致错误的累积。因此,在UDA的背景下,减轻它们的负面影响是先决条件。

本文工作

在本文中,提出了一个渐进的特征对齐网络(PFAN),它通过显式地强制执行类别对齐,在很大程度上扩展了先验的基于判别性表示的方法的能力。首先,采用==由易到难的迁移策略(EHTS)根据跨域相似度量逐步选择可靠的伪标记目标样本。但是,所选的样本可能包含一些分类错误的目标样本。然后,为了抑制错误标记样本的负面影响,提出了一种自适应原型对齐(APA)==来对齐每个类别的源原型和目标原型。本文的工作不是基于伪标记样本反向传播目标样本的类别损失,而是基于源样本和所选择的伪标记目标样本的跨域类别分布。EHTS和APA不断迭代更新,其中EHTS通过提供可靠的伪标记样本,提高了APA的鲁棒性,而APA学习到的跨域类别对齐可以有效缓解EHTS引入的错误标记样本 。此外,在观察到一个良好的自适应模型通常需要一个非饱和的源分类器后,考虑了一种简单而有效的方法,通过进一步将温度变化纳入软最大函数来延迟源分类损失的收敛速度。实验结果表明,所提出的PFAN在三个UDA数据集上超过了最先进的性能。

2. Related Work

受生成对抗网络(GAN)最近成功的启发,深度对抗域适应在学习域不变表示方面受到越来越多的关注,以减少域差异并提供了显著的结果。这些方法试图找到一个特征空间,使该空间中源分布和目标分布之间的混淆最大。例如,提出了一个梯度反转层来训练一个特征提取器,该特征提取器产生最大限度的域二值分类器损失,同时最小化标签预测器损失。

许多方法利用距离度量来度量源域和目标域之间的域差异,如最大平均差异(MMD)、KL散度或瓦瑟斯坦距离。大多数之前的努力都是为了通过匹配 P ( X s ) P(X_s) P(Xs)和 P ( X t ) P(X_t) P(Xt)来实现域对齐。然而,精确的域级对齐并不意味着细粒度的类间重叠。因此,在没有目标真实标签的情况下,追求类别级(category-level)对齐是很重要的。

利用伪标签来弥补目标域中分类信息的缺失。使用修正后的MMD联合匹配了边际分布和条件分布。利用非对称 tri-training策略来学习目标域的判别表示。基于前一个训练时期的分类器,迭代选择伪标记的目标样本,并利用扩大的训练集对模型进行重新训练。提出了为所有目标样本分配伪标签,并利用它们来实现跨域的语义对齐。然而,这些方法高度依赖于正确的伪标记样本可以减少错误的伪标记样本所引起的偏差的假设。它们并没有明确地减轻那些错误的伪标记样本。当错误的伪标记样本处于突出的位置时,其性能将受到限制。

3. Progressive Feature Alignment Network

本节中,首先提供所提出的PFAN的细节,然后从理论上研究方法的有效性。

PFAN的整体架构如图2所示,它由EHTS、APA和随温度变化的soft-max函数三个组件组成。EHTS为从容易到困难的迭代提供了可靠的伪标签样本和APA明确地强制执行跨域类别对齐。

3.1. Task Formulation

3.2.Easy-to-Hard Transfer Strategy

EHTS偏向于更容易的样本,这种偏差有助于避免包括更有可能被给予错误的伪标签的困难样本(hard samples)。在本文的方法中,简单的样本正在逐渐增加。因此,“硬”样本可能会在进一步的步骤中被选择。EHTS所选择的伪标记样本可以与相应的源类别对齐,如第3.3节所述。

EHTS首先计算源域中每个类的 D D D维原型 c k S {c_k}^S ckS ∈ R D ∈R^D ∈RD。源原型是嵌入每类源样本的平均向量,通过嵌入函数G(即图2中的特征提取器)的平均向量,源原型是通过具有可训练参数 θ g θ_g θg的嵌入函数 G G G(即图2中的特征提取器)在每个源样本类别中嵌入的平均向量,

其中, D s k {D_s}^k Dsk为源域中标记为 k k k类的样本集, N s k {N_s}^k Nsk为对应的样本数。然后,得到一组原型集合 { c k S } C k = 1 {\{

{c_k}^S\}^C}_{k=1} {

ckS}C

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2395

2395

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?