深度学习基础知识第二天

传统的机器学习算法不能达到实用的标准:像SVM和AdaBoost

人工特征的局限性:

通用性差

建模能力差

维数灾难

HOG特征(梯度方向直方图)+SVM(线性的支持向量机)来解决行人检测问题, 只计算了图像边缘,但是图像的纹理和颜色信息等等并没有检测出来。

CV方向

颜色直方图

Haar特征

HOG特征

Garbor特征

再比如:

1、Sift特征

2、Spin Image旋转图像 旋转直方图

3、ICF特征

4、ACF特征

5、既融合了边缘又融合了纹理等等

但是精度不太好

注意:机器学习较深度学习的不足在于:机器学习的人工特征提取阶段,在通过人工特征提建模的过程中,必然会简化特征便于计算,这样的话会丢掉原始图像的重要信息,会对图像分类识别的效果不大好

维数灾难

是因为特征越多,维数越大,分类准确率成上升趋势,但当特征维数达到一定规模后,在增加特征,分类精度反而下降,因为特征空间维数增加,样本在特征空间中分布就很稀,比如在一千万维度的空间中,样本1万个样本,样本在特征空间中就会分布的很稀,那么这些样本在特征空间中就像噪声一般,导致算法无法正确拟合出一个模型出来,因为怎么看多像一个噪声。

机器学习算法的局限性

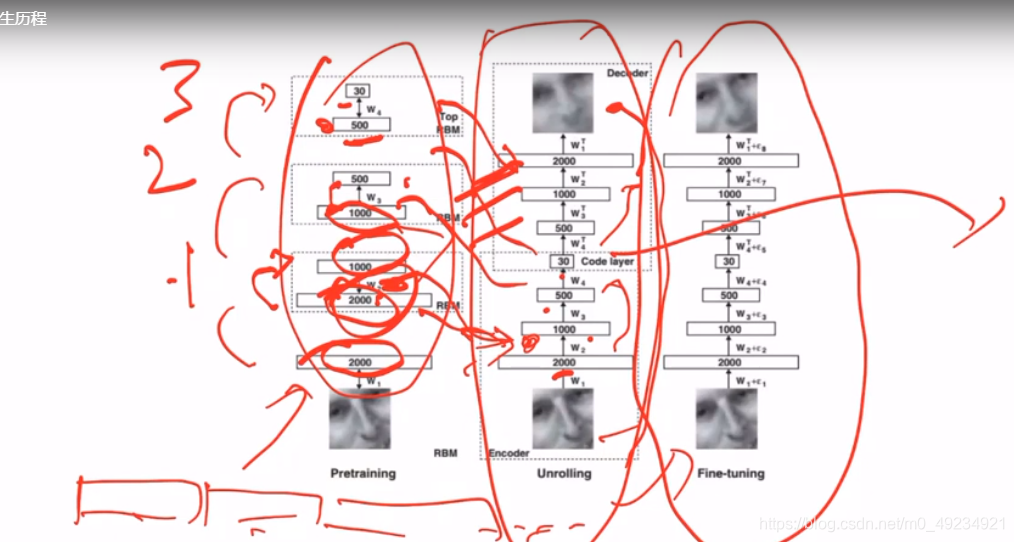

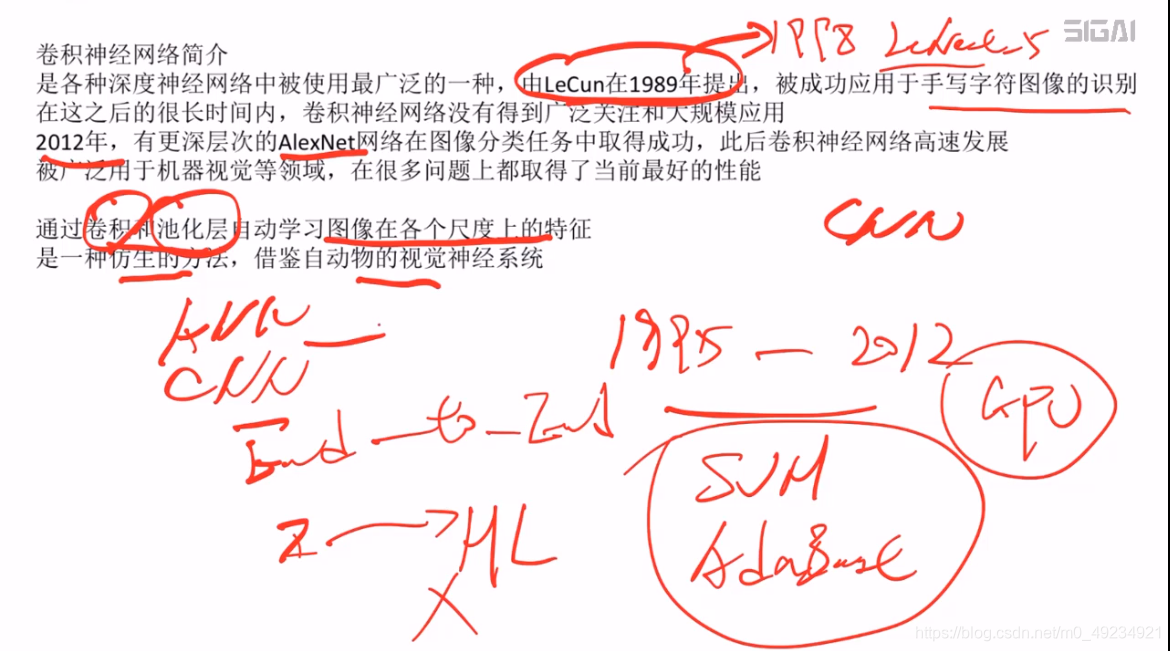

AlexNet在图像分类取得一个很好的效果。

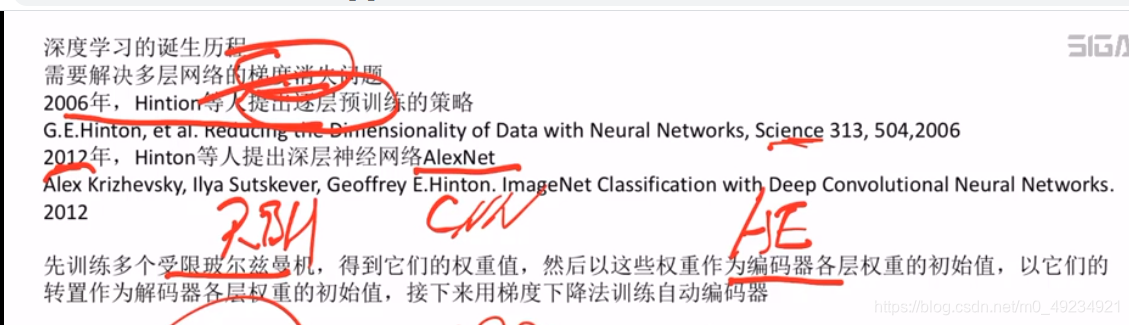

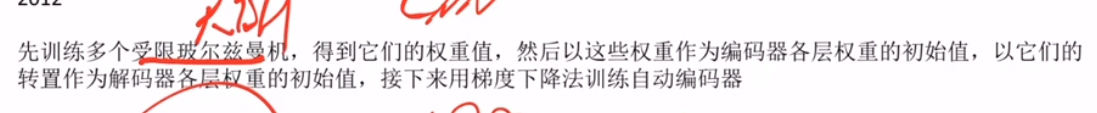

上图种2006年的文章中,怎么来做与训练的呢?

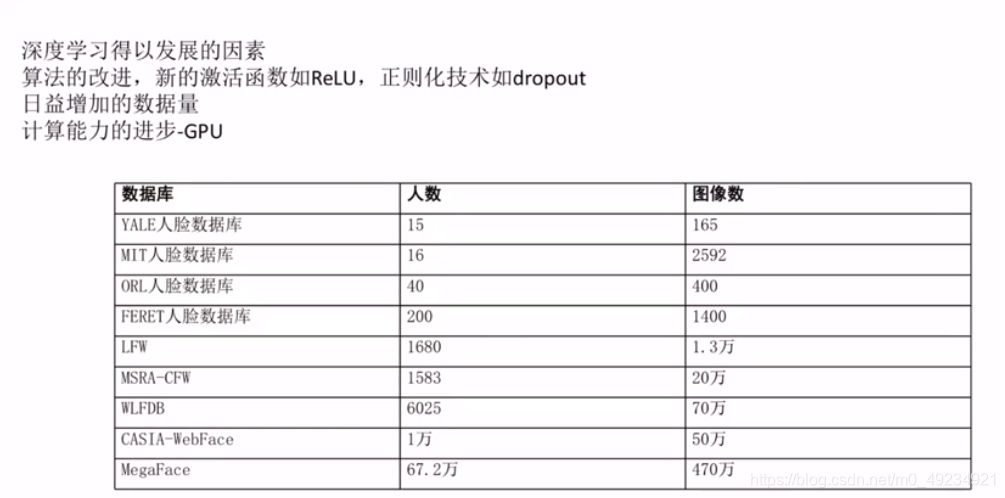

Alexnet之所以在图像分类上取得很好的效果的原因在于:

1、激活函数ReLU,在很大程度上能够缓解梯度消失的问题。

2、droptout的机制(可以看成正则化)

在神经网络中,怎么样用一个多层的神经网络完成自动特征的提取呢?

神经网络在机器视觉上的应用:

1、通用目标检测-----------> R-CNN 以及它的改进

2、人脸识别/检测、行人检测----------------->卷积神经网络 以及它的改进

3、图像分割(图像语义分割)---------> FCN(全卷积网络)占据统计地位 以及它的改进

神经网络在语音识别(ASR)上的应用

循环神经网络—RNN

在数据挖掘上的应用

CNN、RNN解决分类和回归问题

GAN解决数据生成的问题

DRL(深度强化学习)解决控制和策略类的问题

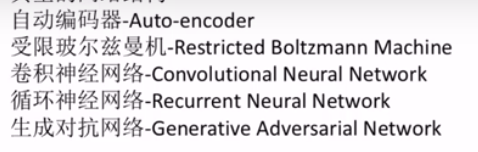

自动编码器

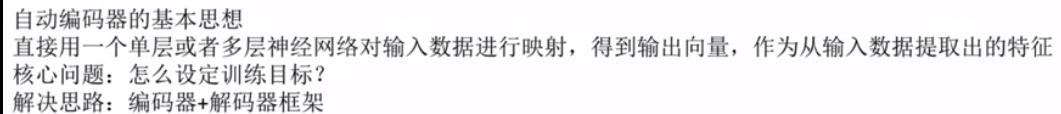

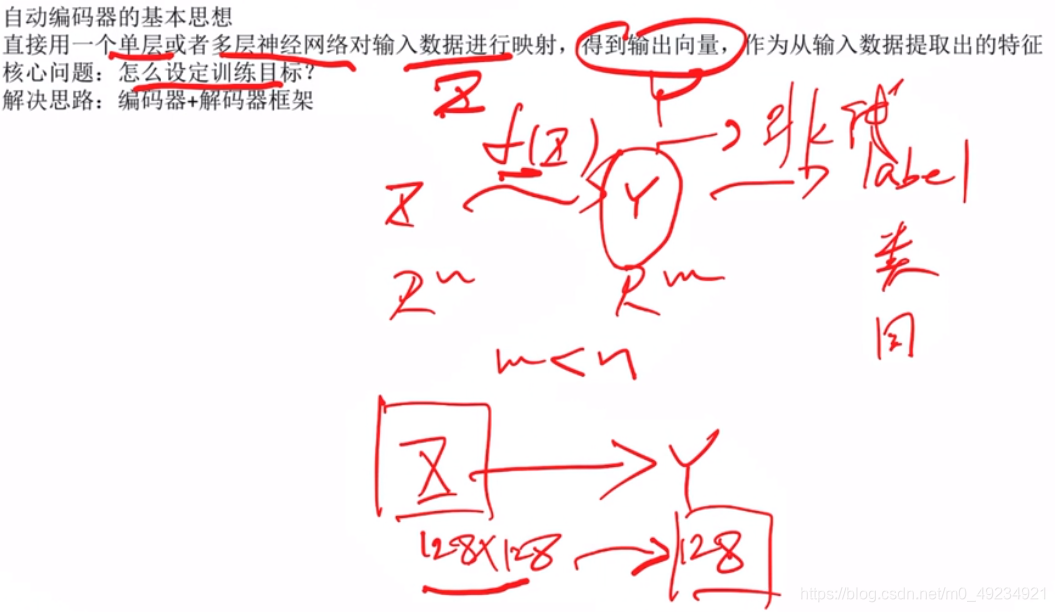

1、自动编码器的基本思想

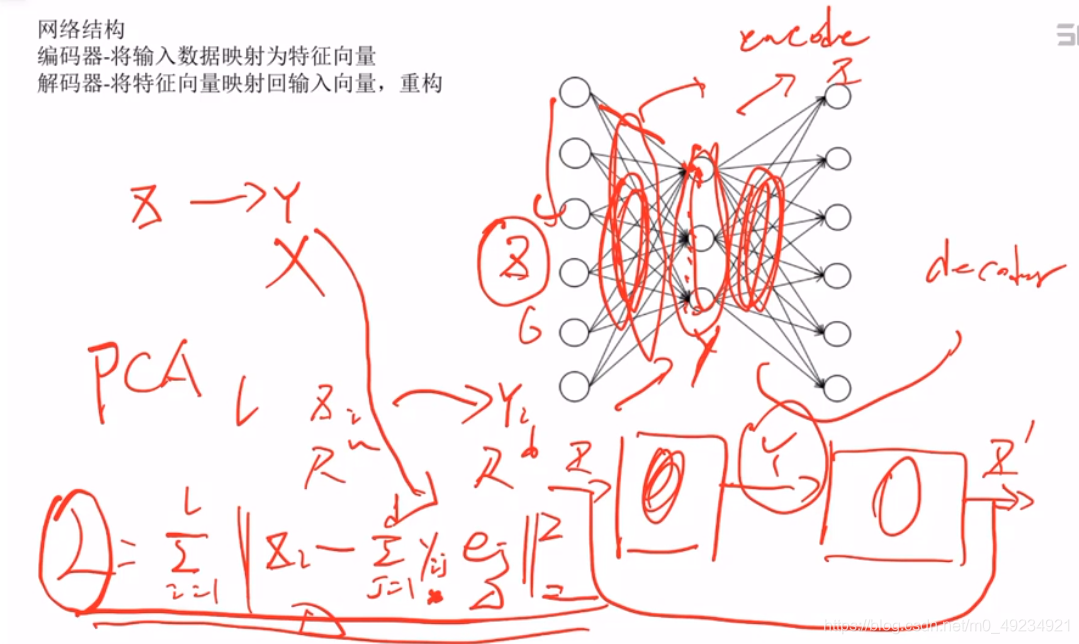

2、网络结构

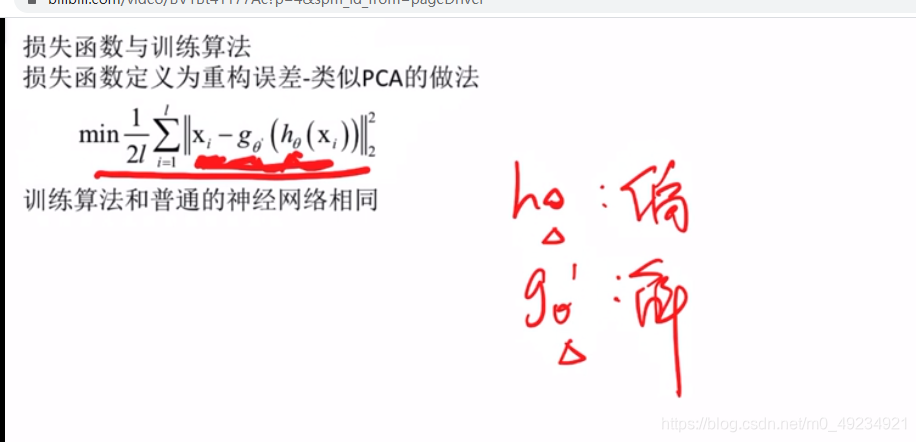

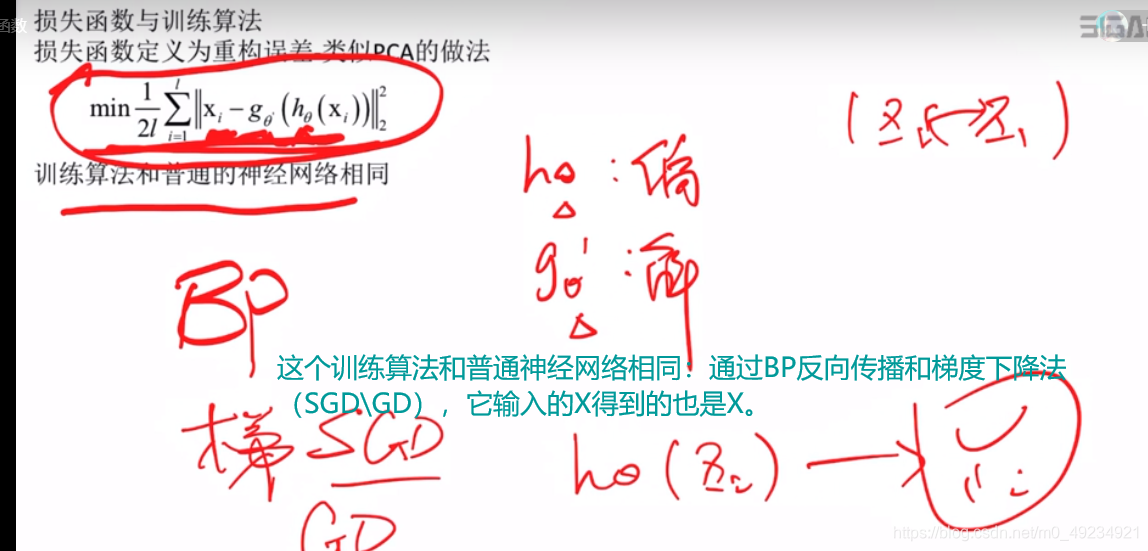

3、损失函数和训练算法

h0:编码器的映射函数

g0:解码器的映射函数

通过编码器的编码后,再到解码器的解码得到的重构X与实际向量X之间的差尽可能最小

下图中的公式为均方误差损失函数。

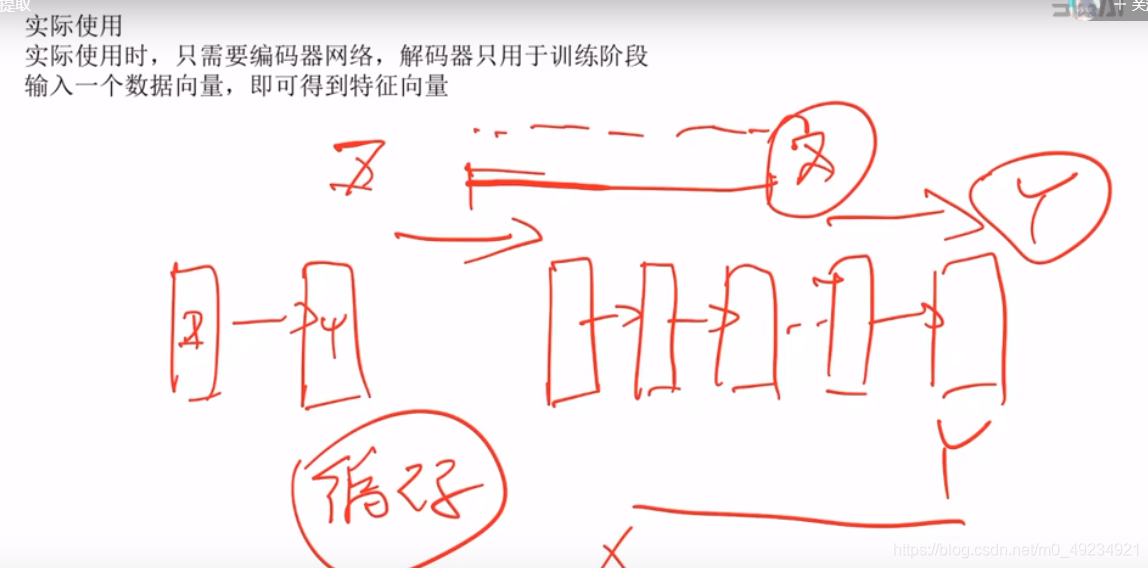

4、实际使用

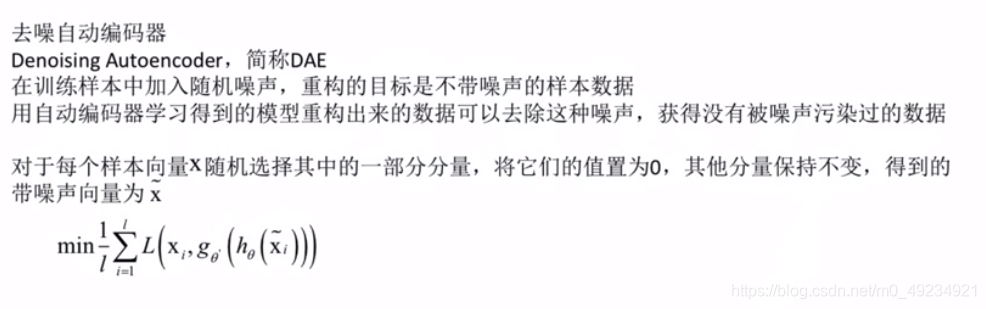

5、去噪自动编码器(DAE)

和上面讲的编码器一样,唯一不同的在于输入的是带有噪声的X(在X上加有随机噪声)—>输出的是没被加有噪声的X。

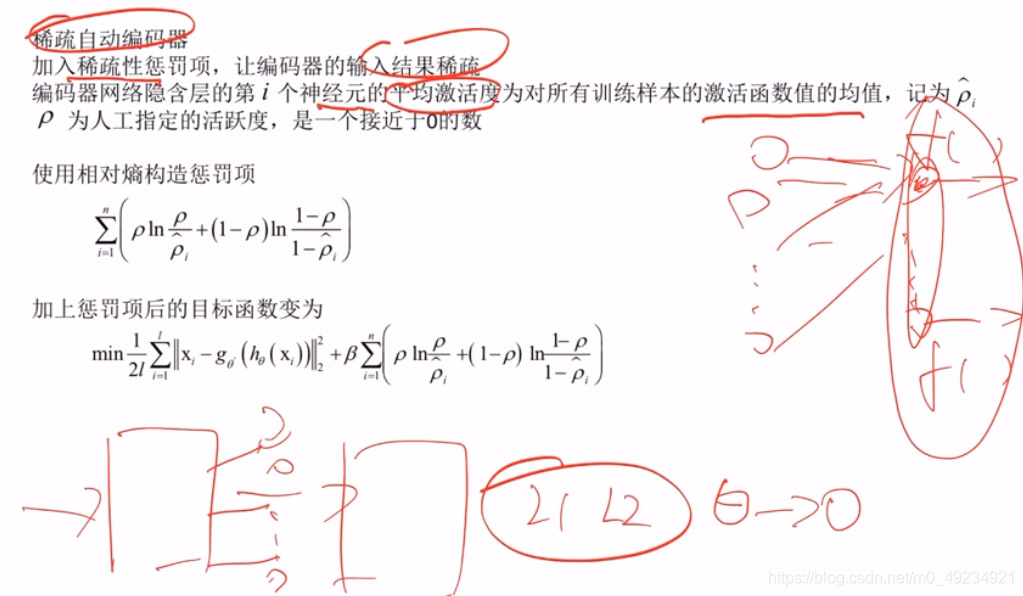

6、稀疏编码

结果系数:就是让经过编码器的输出结构尽量接近于0.

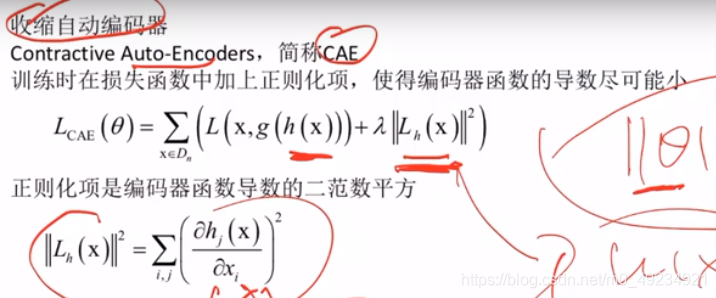

7、收缩自动编码

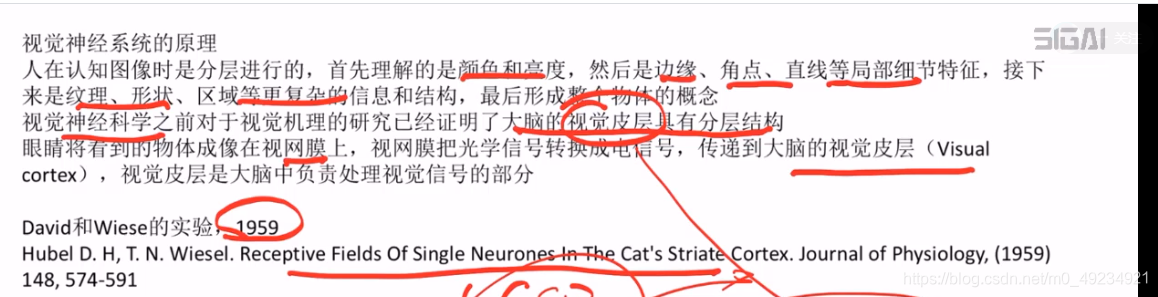

卷积神经网络

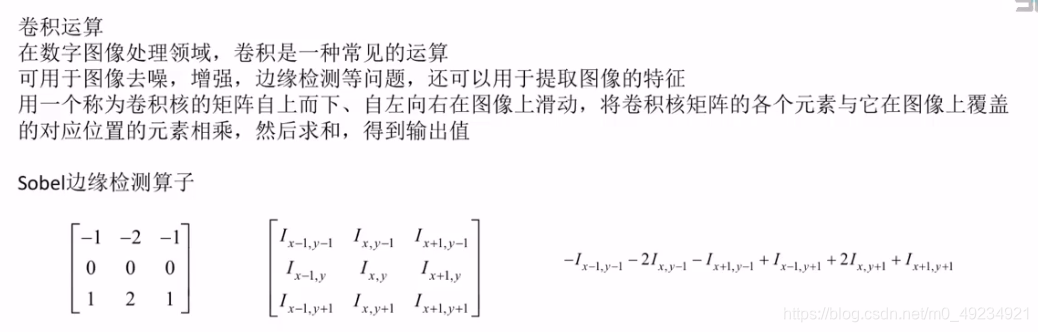

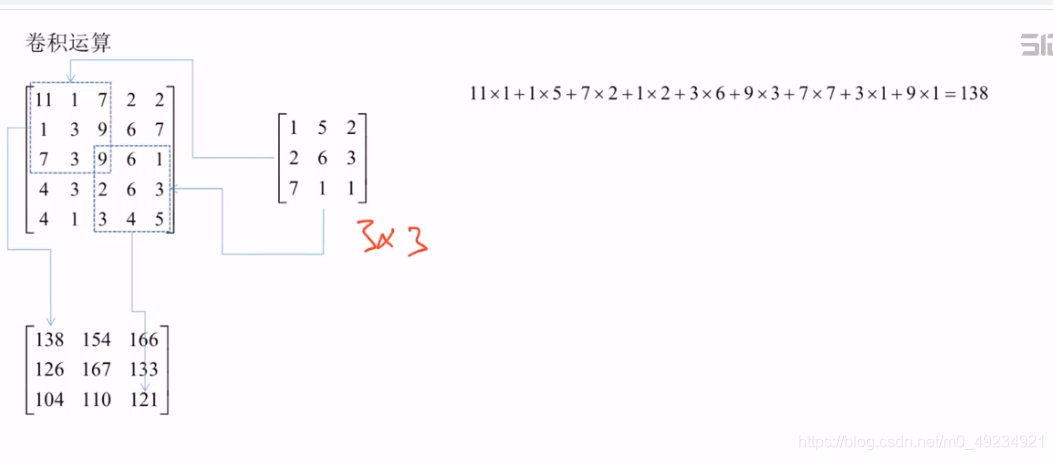

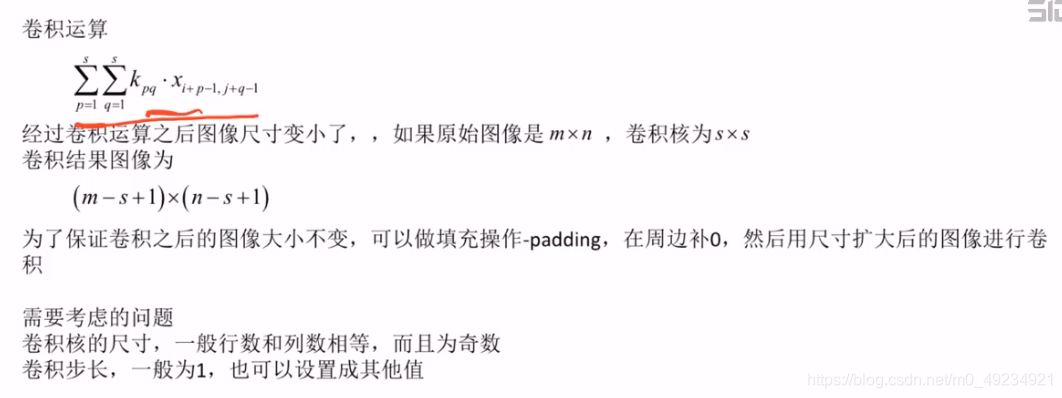

卷积运算

本文探讨了人工特征在机器学习中的局限性,如通用性差和维数灾难,并介绍了神经网络如何通过多层结构自动提取特征。重点讨论了神经网络在机器视觉、语音识别和数据挖掘中的应用,包括自动编码器、卷积神经网络及其各种变体。深度学习的自动特征提取能力显著优于传统机器学习算法,尤其是在图像和语音领域。

本文探讨了人工特征在机器学习中的局限性,如通用性差和维数灾难,并介绍了神经网络如何通过多层结构自动提取特征。重点讨论了神经网络在机器视觉、语音识别和数据挖掘中的应用,包括自动编码器、卷积神经网络及其各种变体。深度学习的自动特征提取能力显著优于传统机器学习算法,尤其是在图像和语音领域。

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?