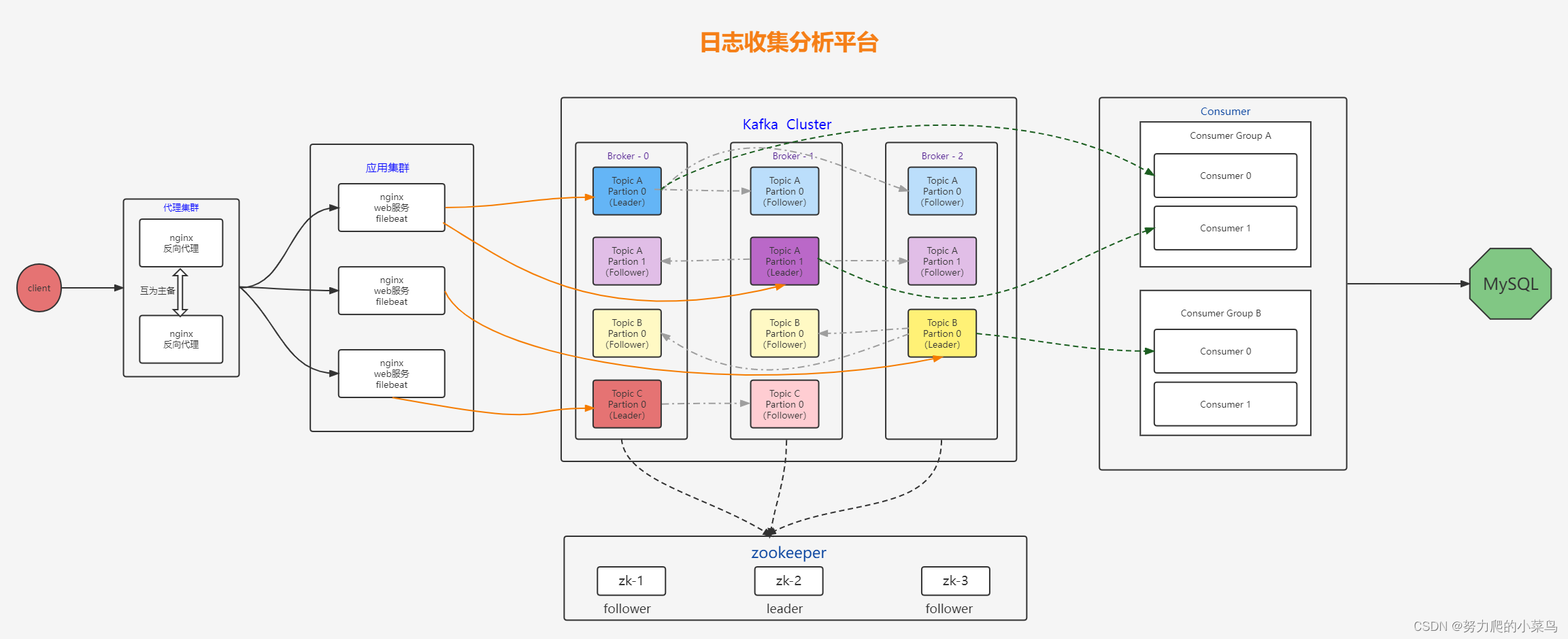

此平台是一个基于kafka集群的日志收集平台,可以分为三个部分

第一部分

5台centos7的机器搭建一个web集群,前面使用了两台机器做nginx负载均衡,两台nginx反向代理机器之间采用了keepalive双VIP做高可用,后面使用3台机器搭建web静态页面用于测试。

第二部分

3台centos7机器搭建kafka集群,上面部署了zookeeper,因为现在使用的是kafka2.12版本,还没有到kafka3。

第三部分

通过部署在nginx web服务器上的filebeat去收集日志,收集到日志后利用pykafka模块写脚本去消费日志,并进行数据清洗,将清洗后的数据写入MySQL。

第一部分知识点

1、DNS通过域名解析到三个ip

1、www.sc.com可以解析成多个ip地址,一般来说会轮询方式去解析成各个ip;但是如果其中一个服务器挂了,DNS不会立即将这个ip地址去掉,还是会解析成挂掉的ip,可能会造成访问失败,虽然客户端有重试,但还是会影响用户体验

2、测试的时候,可以直接访问nginx web,也可以绑定域名访问

3、DNS做负载均衡会有很多局限,扩容和缩容都不方便

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2042

2042

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?