一、网络爬虫是什么?

百度百科给出的定义:网络爬虫(又称为网页蜘蛛,网络机器人,在FOAF社区中间,更经常的称为网页追逐者),是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本。另外一些不常使用的名字还有蚂蚁、自动索引、模拟程序或者蠕虫。

本文以爬取诗词名句网的<<水浒传>>为例

二、使用步骤

1.引入库

requests是python中一款基于网络请求的模块,功能非常强大,简单便捷,,效率极高,作用是模拟浏览器请求。

requests爬虫过程:

1.指定url

2.发起请求

3.获得响应数据

4.数据解析

5.持久化存储

Beautiful Soup提供一些简单的、python式的函数用来处理导航、搜索、修改分析树等功能,作用是解析数据。

库的安装:

pip install requests

pip install bs4

代码如下(示例):

import requests

from bs4 import BeautifulSoup

2.数据请求

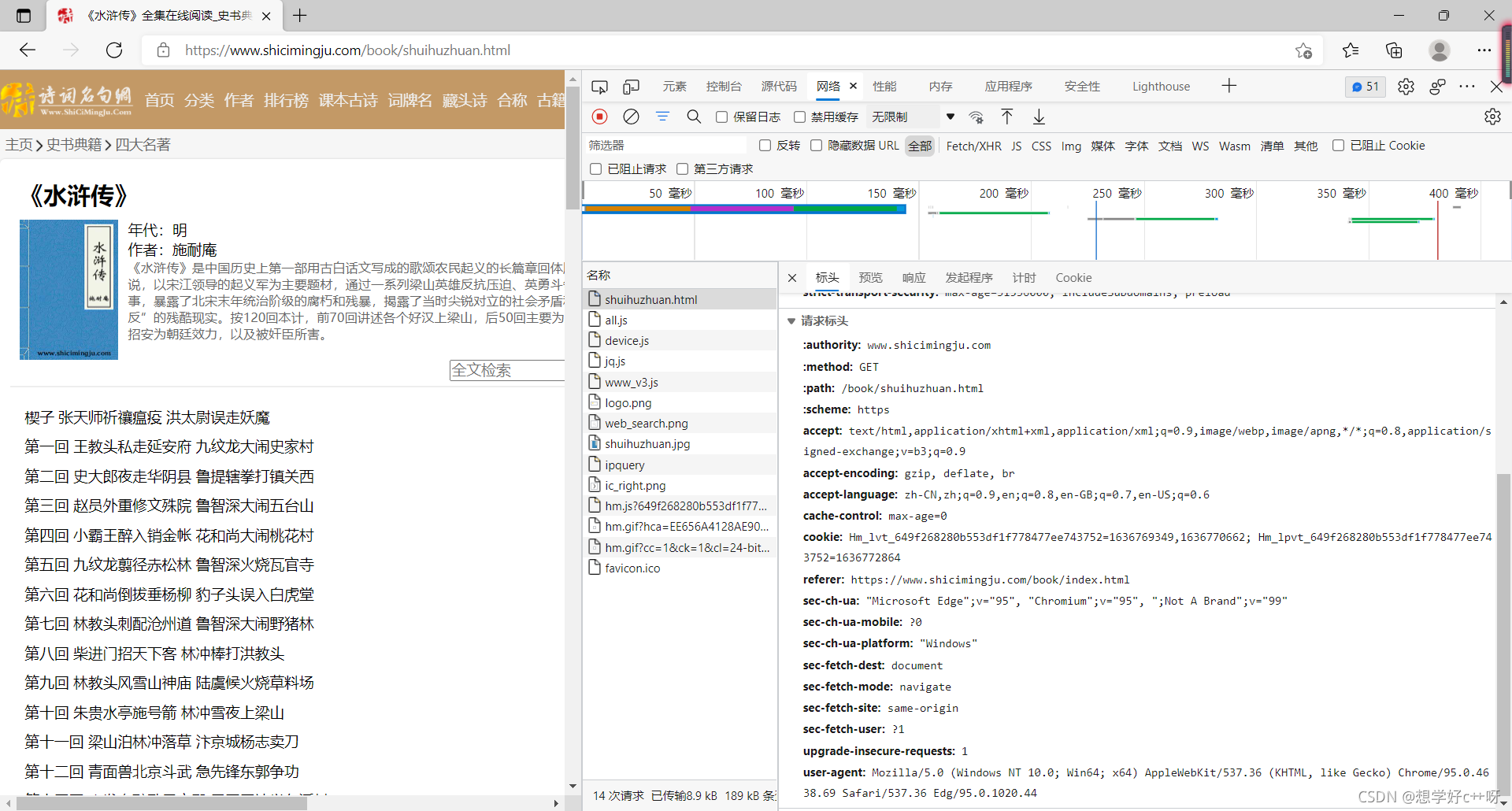

首先在浏览器进入此网址,右键检查或者快捷键F12,找到网络,即network,博主的谷歌浏览器都汉化了,F5,即出现此页面。

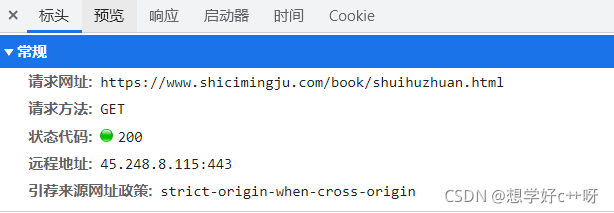

请求网址即需要爬取的网址,请求方法是get,所有之后用的是requests.get请求,状态码是200说明网页正常,滚到底可以看到user-agent,不同电脑不同,所有不能盲目复制。

代码如下(示例):

#诗词名句网

url = 'https://www.shicimingju.com/book/shuihuzhuan.html'

#U-A伪装

headers ={

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/95.0.4638.69 Safari/537.36'

}

#请求响应

response = requests.get(url=url,headers

本文介绍了如何使用Python的requests和BeautifulSoup库爬取诗词名句网上的《水浒传》内容,并将其存储为TXT文件。详细步骤包括引入库、数据请求、数据解析和数据存储。通过示例代码展示了爬虫的实现过程。

本文介绍了如何使用Python的requests和BeautifulSoup库爬取诗词名句网上的《水浒传》内容,并将其存储为TXT文件。详细步骤包括引入库、数据请求、数据解析和数据存储。通过示例代码展示了爬虫的实现过程。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2086

2086

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?