特征匹配

目标

• 我们将要学习在图像间进行特征匹配

• 使用 OpenCV 中的蛮力(Brute-Force)匹配和 FLANN 匹配

drawmatches函数的参数详解

img1 – 源图像1

keypoints1 – 源图像1的特征点.

img2 – 源图像2.

keypoints2 – 源图像2的特征点

matches1to2 – 源图像1的特征点匹配源图像2的特征点[matches[i]] .

outImg – 输出图像具体由flags决定.

matchColor – 匹配的颜色(特征点和连线),若matchColor==Scalar::all(-1),颜色随机.

singlePointColor – 单个点的颜色,即未配对的特征点,若matchColor==Scalar::all(-1),颜色随机.

matchesMask – Mask决定哪些点将被画出,若为空,则画出所有匹配点.

flags – Fdefined by DrawMatchesFlags.

Brute-Force 匹配的基础

蛮力匹配器是很简单的。首先在第一幅图像中选取一个关键点然后依次与第二幅图像的每个关键点进行(描述符)距离测试,最后返回距离最近的关键点。

对于 BF 匹配器,我们首先要使用 cv2.BFMatcher() 创建一个 BFMatcher 对象。它有两个可选参数。第一个是 normType。它是用来指定要使用的距离测试类型。默认值为 cv2.Norm_L2。这很适合 SIFT 和 SURF 等(c2.NORM_L1 也可以)。对于使用二进制描述符的 ORB,BRIEF,BRISK算法等,要使用 cv2.NORM_HAMMING,这样就会返回两个测试对象之间的汉明距离。如果 ORB 算法的参数设置为 V TA_K==3 或 4,normType就应该设置成 cv2.NORM_HAMMING2。

第二个参数是布尔变量 crossCheck,默认值为 False。如果设置为True,匹配条件就会更加严格,只有到 A 中的第 i 个特征点与 B 中的第 j 个特征点距离最近,并且 B 中的第 j 个特征点到 A 中的第 i 个特征点也是最近(A 中没有其他点到 j 的距离更近)时才会返回最佳匹配(i,j)。也就是这两个特征点要互相匹配才行。这样就能提供统一的结果,这可以用来替代 D.Lowe在 SIFT 文章中提出的比值测试方法。

BFMatcher 对象具有两个方法,BFMatcher.match() 和 BFMatcher.knnMatch()。

第一个方法会返回最佳匹配。第二个方法为每个关键点返回 k 个最佳匹配(降序排列之后取前 k 个),其中 k 是由用户设定的。如果除了匹配之外还要做其他事情的话可能会用上(比如进行比值测试)。

就像使用 cv2.drawKeypoints() 绘制关键点一样,我们可以使用cv2.drawMatches() 来绘制匹配的点。它会将这两幅图像先水平排列,然后在最佳匹配的点之间绘制直线(从原图像到目标图像)。如果前面使用的是 BFMatcher.knnMatch(),现在我们可以使用函数 cv2.drawMatchsKnn为每个关键点和它的 k 个最佳匹配点绘制匹配线。如果 k 等于 2,就会为每个关键点绘制两条最佳匹配直线。如果我们要选择性绘制话就要给函数传入一个掩模。

让我们分别看一个 ORB 和一个 SURF 的例子吧。(使用不同距离计算方法)。

对 ORB 描述符进行蛮力匹配

现在我们看一个在两幅图像之间进行特征匹配的简单例子。在本例中我们有一个查询图像和一个目标图像。我们要使用特征匹配的方法在目标图像中寻找查询图像的位置。(这两幅图像分别是/sample/c/box.png,和/sample/c/box_in_scene.png)

我们使用 ORB 描述符来进行特征匹配。首先我们需要加载图像计算描述符。然后创建一个 BFMatcher 对象,并将距离计算设置为cv2.NORM_HAMMING(因为我们使用的是 ORB),并将 crossCheck 设置为 True。然后使用 Matcher.match()方法获得两幅图像的最佳匹配。然后将匹配结果按特征点之间的距离进行降序排列,这样最佳匹配就会排在前面了。最后我们只将前 30 个匹配绘制出来(太多了看不清,如果愿意的话你可以多画几条)。

import numpy as np

import cv2

from matplotlib import pyplot as plt

img1 = cv2.imread('D:/xinban.png',0) # queryImage

img2 = cv2.imread('D:/xinbiao.png',0) # trainImage

# Initiate SIFT detector

orb=cv2.ORB_create()#建立orb特征检测器

# find the keypoints and descriptors with SIFT

kp1, des1 = orb.detectAndCompute(img1,None)

kp2, des2 = orb.detectAndCompute(img2,None)

# create BFMatcher object

bf = cv2.BFMatcher(cv2.NORM_HAMMING, crossCheck=True)

# Match descriptors.

matches = bf.match(des1,des2)

# Sort them in the order of their distance.

matches = sorted(matches, key = lambda x:x.distance)

# Draw first 10 matches.

img3=cv2.drawMatches(img1,kp1,img2,kp2,matches[:30],(0,0,255),(255,0,0),flags=2)

plt.imshow(img3),plt.show()

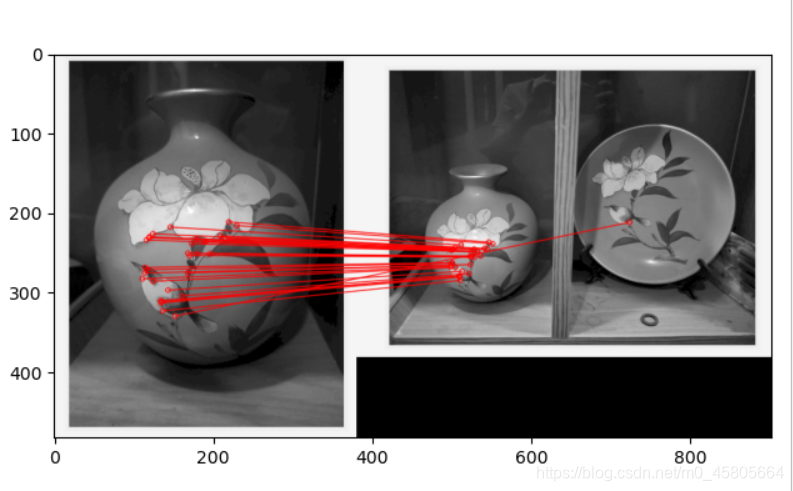

结果

使用特征匹配和单应性查找对象

目标

• 联合使用特征提取和 calib3d 模块中的 findHomography 在复杂图像中查找已知对象。

基础

还记得上一节我们做了什么吗?我们使用一个查询图像,在其中找到一些特征点(关键点),我们又在另一幅图像中也找到了一些特征点,最后对这两幅图像之间的特征点进行匹配。简单来说就是:我们在一张杂乱的图像中找到了一个对象(的某些部分)的位置。这些信息足以帮助我们在目标图像中准确的找到(查询图像)对象。

为了达到这个目的我们可以使用 calib3d 模块中的 cv2.findHomography()函数。如果将这两幅图像中的特征点集传给这个函数,他就会找到这个对象的透视图变换。然后我们就可以使用函数 cv2.perspectiveTransform() 找到这个对象了。至少要 4 个正确的点才能找到这种变换。

我们已经知道在匹配过程可能会有一些错误,而这些错误会影响最终结果。为了解决这个问题,算法使用 RANSAC 和 LEAST_MEDIAN(可以通过参数来设定)。所以好的匹配提供的正确的估计被称为 inliers,剩下的被称为outliers。cv2.findHomography() 返回一个掩模,这个掩模确定了 inlier 和outlier 点。

让我们来搞定它吧!!!

代码

和通常一样我们先在图像中来找到 SIFT 特征点,然后再使用比值测试找到最佳匹配。

# 基于FLANN的匹配器(FLANN based Matcher)定位图片

import numpy as np

import cv2

from matplotlib import pyplot as plt

MIN_MATCH_COUNT = 10 # 设置最低特征点匹配数量为10

template = cv2.imread('D:/pipeimoban.jpg', 0) # queryImage

target = cv2.imread('D:/pipeimu.jpg', 0) # trainImage

# Initiate SIFT detector创建sift检测器

sift = cv2.xfeatures2d.SIFT_create()

# find the keypoints and descriptors with SIFT

kp1, des1 = sift.detectAndCompute(template, None)

kp2, des2 = sift.detectAndCompute(target, None)

# 创建设置FLANN匹配

FLANN_INDEX_KDTREE = 0

index_params = dict(algorithm=FLANN_INDEX_KDTREE, trees=5)

search_params = dict(checks=50)

flann = cv2.FlannBasedMatcher(index_params, search_params)

matches = flann.knnMatch(des1, des2, k=2)

# store all the good matches as per Lowe's ratio test.

good = []

# 舍弃大于0.7的匹配

for m, n in matches:

if m.distance < 0.7 * n.distance:

good.append(m)

if len(good) > MIN_MATCH_COUNT:

# 获取关键点的坐标

src_pts = np.float32([kp1[m.queryIdx].pt for m in good]).reshape(-1, 1, 2)

dst_pts = np.float32([kp2[m.trainIdx].pt for m in good]).reshape(-1, 1, 2)

# 计算变换矩阵和MASK

M, mask = cv2.findHomography(src_pts, dst_pts, cv2.RANSAC, 5.0)

matchesMask = mask.ravel().tolist()

h, w = template.shape

# 使用得到的变换矩阵对原图像的四个角进行变换,获得在目标图像上对应的坐标

pts = np.float32([[0, 0], [0, h - 1], [w - 1, h - 1], [w - 1, 0]]).reshape(-1, 1, 2)

dst = cv2.perspectiveTransform(pts, M)

cv2.polylines(target, [np.int32(dst)], True, 0, 2, cv2.LINE_AA)

else:

print("Not enough matches are found - %d/%d" % (len(good), MIN_MATCH_COUNT))

matchesMask = None

draw_params = dict(matchColor=(0, 255, 0),

singlePointColor=None,

matchesMask=matchesMask,

flags=2)

result = cv2.drawMatches(template, kp1, target, kp2, good, None, **draw_params)

plt.imshow(result)

plt.show()

结果如下

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?