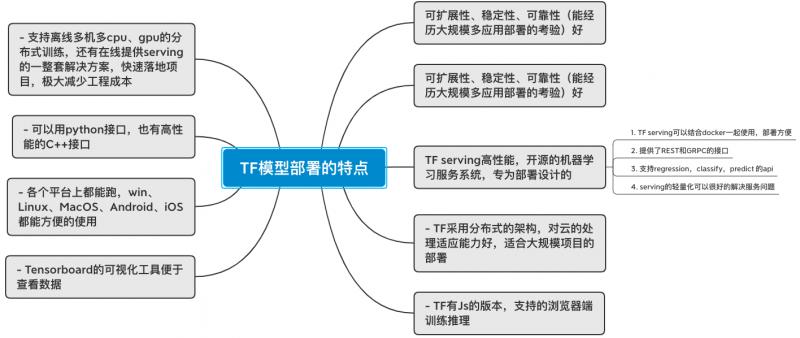

TF模型部署的特点

- 可扩展性、稳定性、可靠性(能经历大规模多应用部署的考验)好

- 支持将模型部署到不同的设备,可在移动端进行产品的部署,不需要单独的模型解码器

- TF serving高性能,开源的机器学习服务系统,专为部署设计的

- TF serving可以结合docker一起使用,部署方便

- 提供了REST和GRPC的接口

- 支持regression,classify,predict 的api

- serving的轻量化可以很好的解决服务问题

- TF采用分布式的架构,对云的处理适应能力好,适合大规模项目的部署

- TF有Js的版本,支持的浏览器端训练推理

- Tensorboard的可视化工具便于查看数据

- 各个平台上都能跑,win、Linux、MacOS、Android、iOS都能方便的使用

- 可以用python接口,也有高性能的C++接口

- 支持离线多机多cpu、gpu的分布式训练,还有在线提供serving的一整套解决方案,快速落地项目,极大减少工程成本

1475

1475

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?