一、LR

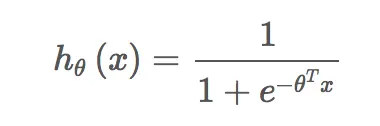

LR模型的表达式为:

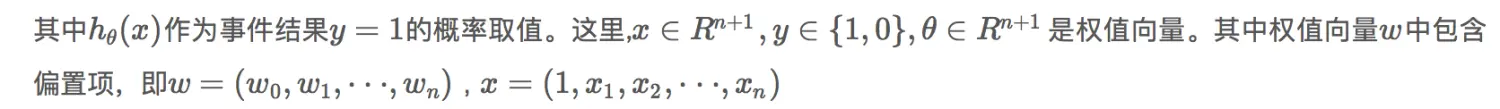

一个事件发生的几率(odds)是指该事件发生的概率与该事件不发生的概率的比值。如果事件发生的概率是p,那么该事件的几率为p/(1-p) ,该事件的对数几率(log odds)或logit函数是:

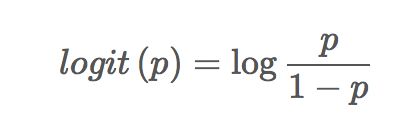

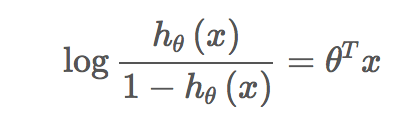

对LR而言,根据模型表达式可以得到:

二、softmax

Softmax Regression是Logistic回归的推广,Logistic回归是处理二分类问题的,而Softmax Regression是处理多分类问题的。Logistic回归是处理二分类问题的比较好的算法,具有很多的应用场合,如广告计算等。Logistic回归利用的是后验概率最大化的方式去计算权重。

使用Python实现Softmax:

import bumpy as np

def softmax(x):

return np.exp(x)/np.sum(np.exp(x),axis=0)

三、神经网络:

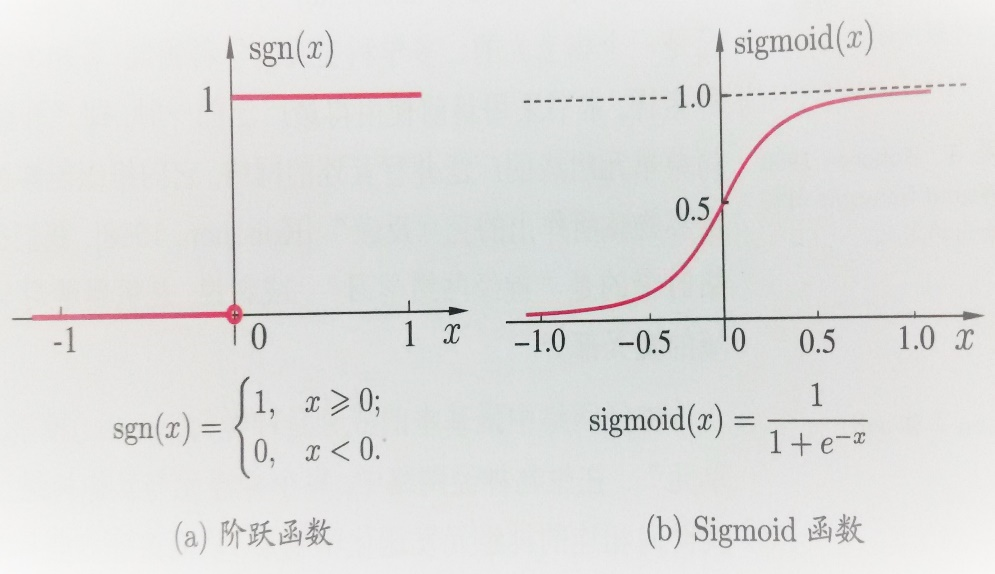

理想中的激活函数是下图所示的阶跃函数,它将输入值映射为输出值“0”或“1”, “1”对应神经元兴奋,“0”对应神经元抑制。但是,阶跃函数具有不连续,不光滑(不连续可导)等不太好的性质,因此实际中常用Logistic回归中应用到的sigmoid函数作为激活函数。典型的sigmoid函数如图4-5(b)所示,它把可能在较大范围内变化的输入值挤压到(0, 1)输出值范围内,因此有时又称之为“挤压函数”(squashing function).

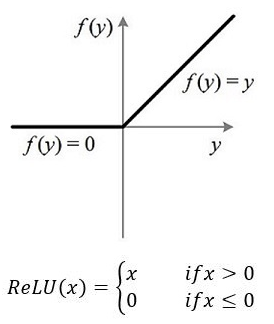

多层神经网络:Relu激活函数:

深度学习模型:keras(方便),pytorch,tensorflow

四、

dropout训练过程随机会丢掉一些点,预测不丢都用到

多人预测防止过拟合

滤波后的图像大小不变,卷积后的图片大小变小厚度变大

滤波步骤:1、对原始图像的边缘进行某种方式的填充(一般为0填充)。

2、将掩膜划过整幅图像,计算图像中每个像素点的滤波结果。

卷积步骤:1、180度翻转卷积核。2、不做边界填充,直接对图像进行相应位置乘积和。

卷积根据步长定距离。

polling:比如矩阵A是20*20的矩阵要进行大小为10*10的池化,那么用10*10的大小,对应到后来2*2的矩阵,后来每个元素的值,是10*10矩阵每个元素的值的和再处于该矩阵的元素个数,也就是平均值形式的池化。

将最显著特征保留(自然数矩阵)。

本文介绍了机器学习中的几种基础模型,包括逻辑回归(LR)、Softmax Regression以及神经网络的基本概念。LR通过logit函数计算事件发生的对数几率,Softmax Regression则是Logistic回归在多分类问题上的推广。此外,文中还探讨了激活函数的选择及其作用,并简单介绍了深度学习模型的实现框架。

本文介绍了机器学习中的几种基础模型,包括逻辑回归(LR)、Softmax Regression以及神经网络的基本概念。LR通过logit函数计算事件发生的对数几率,Softmax Regression则是Logistic回归在多分类问题上的推广。此外,文中还探讨了激活函数的选择及其作用,并简单介绍了深度学习模型的实现框架。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?