一、服务器端配置

1、nfs-utils安装

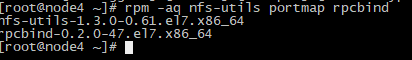

首先检查是否安装:

#rpm -aq nfs-utils rpcbind

说明已经默认安装,如果没有,可以使用如下命令安装:

#yum -y install rpcbind nfs-utils

2、启动nfs,prcbind服务

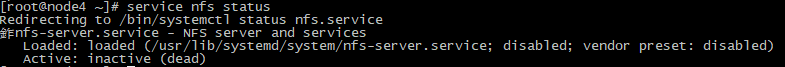

查看nfs服务启动状态:

#service nfs status

启动命令:

#service prcbind start

#service nfs start

3、服务器端关闭SElinux和防火墙

#setenforce 0 ; systemctl stop firewalld

服务器端创建共享目录,或者使用已经存在的目录,同时设置读写权限

#chmod 777 /data01/etasy_data_dir

4、服务启端配置/etc/exports

#vi /etc/exports

添加以下配置:

#/data01/etasy_data_dir * (rw,sync,no_root_squash)

加载exports文件

#exportfs –a

二、客户端配置

1、客户端关闭关闭SElinux和防火墙

2、客户端安装并启动rpcbind,如果已经安装直接启动即可。

安装:yum -y install rpcbind

启动:service rpcbind start

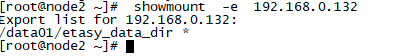

3、客户端查看服务器共享的目录

# showmount -e 192.168.0.132

说明共享目录可以访问。

4、将共享目录挂载到本地目录

创建本地目录:

#mkdir etasy_data_dir

挂载共享目录,为了保持目录统一,我使用相同的目录进行挂载,如下:

# mount -t nfs 192.168.0.132:/data01/etasy_data_dir /data01/etasy_data_dir

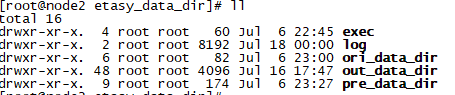

查看挂载情况:

#ll /data01/etasy_data_dir

说明目录挂载成功。

到这里基本上已经完成,我们还可以进一步设置开机自动挂载。如下:

服务器端配置开启启动nfs

修改 /etc/profile文件,添加如下信息

etc/init.d/nfs start

客户端设置自动挂载:

#vi /etc/fstab

添加:

192.168.0.132:/data01/etasy_data_dir /data01/etasy_data_dir nfs defaults 0 0

注意这里的ip和目录和挂载目录一致。

本文详细介绍NFS网络文件系统的服务器端及客户端配置步骤。包括安装nfs-utils、配置exports文件、设置共享目录权限等服务器端操作,以及安装启动rpcbind、挂载共享目录等客户端配置。

本文详细介绍NFS网络文件系统的服务器端及客户端配置步骤。包括安装nfs-utils、配置exports文件、设置共享目录权限等服务器端操作,以及安装启动rpcbind、挂载共享目录等客户端配置。

743

743

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?