kl散度意义:

在统计学意义上来说,KL散度可以用来衡量两个分布之间的差异程度。若两者差异越小,KL散度越小,反之亦反。当两分布一致时,其KL散度为0。

Kullback-Leibler Divergence,即K-L散度,是一种量化两种概率分布P和Q之间差异的方式,又叫相对熵。在概率学和统计学上,我们经常会使用一种更简单的、近似的分布来替代观察数据或太复杂的分布。K-L散度能帮助我们度量使用一个分布来近似另一个分布时所损失的信息量。

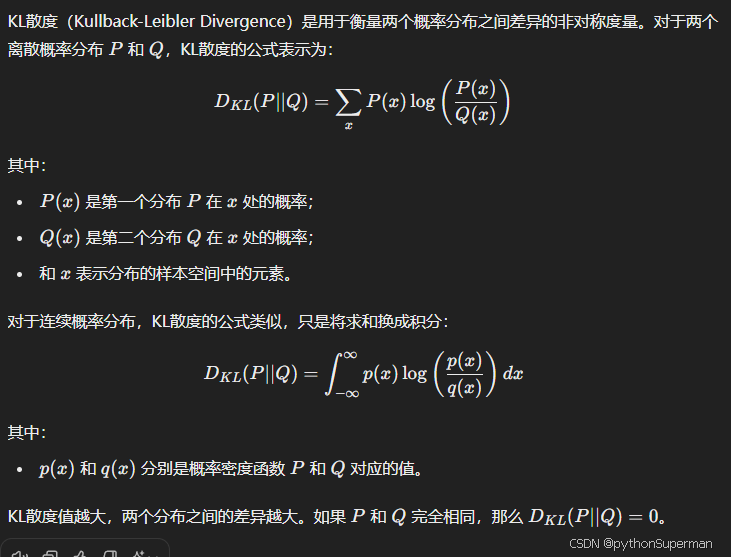

kl散度公式:

kl散度在pytorch代码中实现

import torch

import torch.nn.functional as F

# 假设 P 和 Q 是两个概率分布

P = torch.tensor([0.1, 0.4, 0.5], dtype=torch.float32) # 目标分布

Q = torch.tensor([0.2, 0.3, 0.5], dtype=torch.float32) # 预测分布

# 对 Q 进行 log 变换 (因为 F.kl_div 中要求第二个参数是 log prob)

log_Q = torch.log(Q)

# 使用 kl_div 计算 KL 散度

kl_divergence = F.kl_div(log_Q, P, reduction='batchmean') # reduction 参数控制求和方式

print(kl_divergence)

KL散度是一种量化两个概率分布间差异的方法,它衡量了从一个分布到另一个分布时的信息损失。当分布接近时,KL散度较小。在统计学和概率学中,它用于简化复杂分布的近似计算。

KL散度是一种量化两个概率分布间差异的方法,它衡量了从一个分布到另一个分布时的信息损失。当分布接近时,KL散度较小。在统计学和概率学中,它用于简化复杂分布的近似计算。

1397

1397

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?