MyBatis定义了Cache接口方便我们进行自定义扩展。

EhCache 是一个纯Java的进程内缓存框架,具有快速、精干等特点,是Hibernate中默认的CacheProvider。

1、引入依赖

<!-- Ehcache依赖 -->

<dependency>

<groupId>org.mybatis.caches</groupId>

<artifactId>mybatis-ehcache</artifactId>

<version>1.1.0</version>

</dependency>

<!-- slf4j日志 -->

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-api</artifactId>

<version>1.7.25</version>

</dependency>

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-log4j12</artifactId>

<version>1.7.25</version>

</dependency>

2、在mybatis指定自定义的cache

<cache type="org.mybatis.caches.ehcache.EhcacheCache"></cache>

3、创建ehcache.xml

<?xml version="1.0" encoding="UTF-8"?>

<ehcache xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:noNamespaceSchemaLocation="../config/ehcache.xsd">

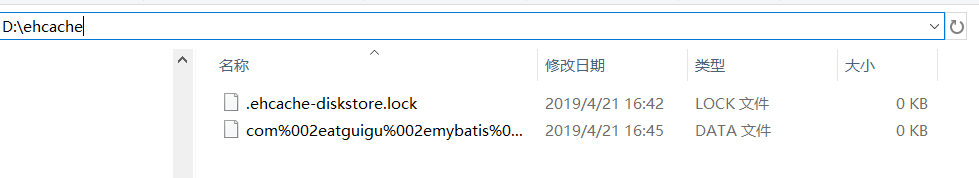

<!-- 磁盘保存路径 -->

<diskStore path="D:\ehcache" />

<!--

属性说明:

diskStore:指定数据在磁盘中的存储位置。

defaultCache:当借助CacheManager.add("demoCache")创建Cache时,EhCache便会采用<defalutCache/>指定的的管理策略。

必要属性:

maxElementsInMemory:在内存中缓存的element的最大数目。

maxElementsOnDisk:在磁盘上缓存的element的最大数目,若是0表示无穷大。

eternal:设定缓存的elements是否永远不过期。如果为true,则缓存的数据始终有效,如果为false那么还要根据timeToIdleSeconds,timeToLiveSeconds判断。

overflowToDisk:设定当内存缓存溢出的时候是否将过期的element缓存到磁盘上。

可选属性:

timeToIdleSeconds:当缓存在EhCache中的数据前后两次访问的时间超过timeToIdleSeconds的属性取值时,这些数据便会删除,默认值是0,也就是可闲置时间无穷大。

timeToLiveSeconds:缓存element的有效生命期,默认是0.,也就是element存活时间无穷大。

diskSpoolBufferSizeMB:这个参数设置DiskStore(磁盘缓存)的缓存区大小.默认是30MB.每个Cache都应该有自己的一个缓冲区。

diskPersistent:在VM重启的时候是否启用磁盘保存EhCache中的数据,默认是false。

diskExpiryThreadIntervalSeconds:磁盘缓存的清理线程运行间隔,默认是120秒。每个120s,相应的线程会进行一次EhCache中数据的清理工作。

memoryStoreEvictionPolicy:当内存缓存达到最大,有新的element加入的时候, 移除缓存中element的策略。默认是LRU(最近最少使用),可选的有LFU(最不常使用)和FIFO(先进先出)。

-->

<defaultCache

maxElementsInMemory="10000"

maxElementsOnDisk="10000000"

eternal="false"

overflowToDisk="true"

timeToIdleSeconds="120"

timeToLiveSeconds="120"

diskExpiryThreadIntervalSeconds="120"

memoryStoreEvictionPolicy="LRU">

</defaultCache>

</ehcache>

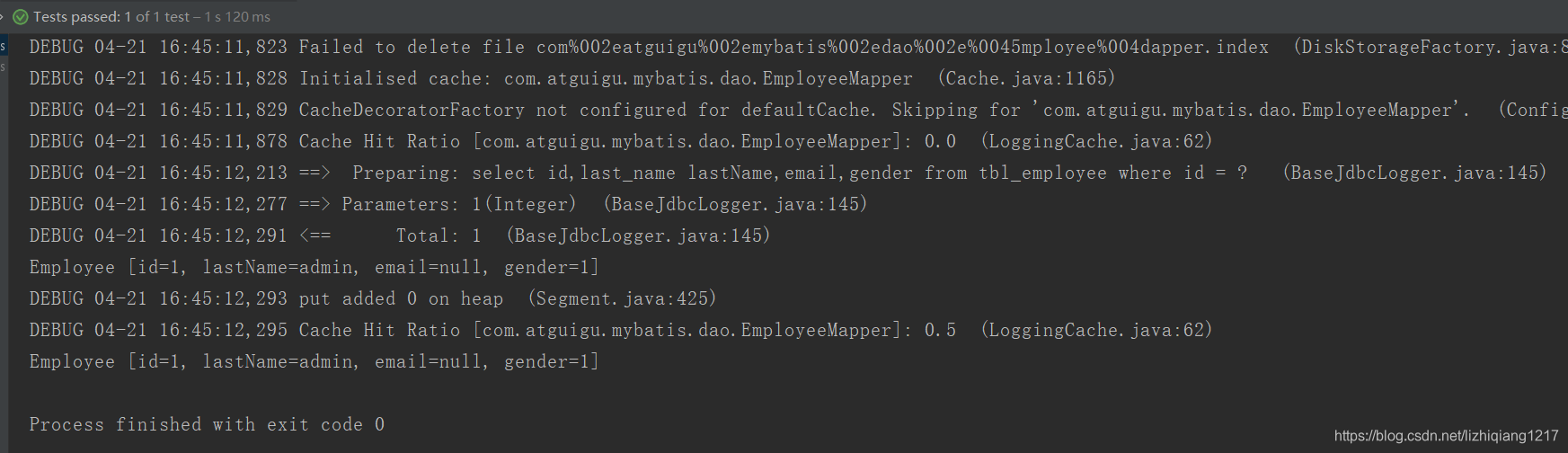

测试缓存:

@Test

public void testSecondLevelCache() throws IOException{

String resource = "mybatis-config.xml";

InputStream inputStream = Resources.getResourceAsStream(resource);

SqlSessionFactory sqlSessionFactory = new SqlSessionFactoryBuilder().build(inputStream);

SqlSession openSession = sqlSessionFactory.openSession();

SqlSession openSession2 = sqlSessionFactory.openSession();

try{

EmployeeMapper mapper = openSession.getMapper(EmployeeMapper.class);

EmployeeMapper mapper2 = openSession2.getMapper(EmployeeMapper.class);

Employee emp01 = mapper.getEmpById(1);

System.out.println(emp01);

openSession.close();

//第二次查询是从二级缓存中拿到的数据,并没有发送新的sql

Employee emp02 = mapper2.getEmpById(1);

System.out.println(emp02);

openSession2.close();

}finally{

}

}

本文介绍如何在MyBatis中集成EhCache作为二级缓存,包括配置依赖、自定义缓存策略及测试缓存效果。通过具体步骤和代码示例,展示如何利用EhCache提高数据读取效率。

本文介绍如何在MyBatis中集成EhCache作为二级缓存,包括配置依赖、自定义缓存策略及测试缓存效果。通过具体步骤和代码示例,展示如何利用EhCache提高数据读取效率。

291

291

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?