1.OpenWeb UI运行需要docker 环境下载docker Get Started | Docker

2.需要命令提示符docker -v 查询是否安装成功;

查询docker详情docker version

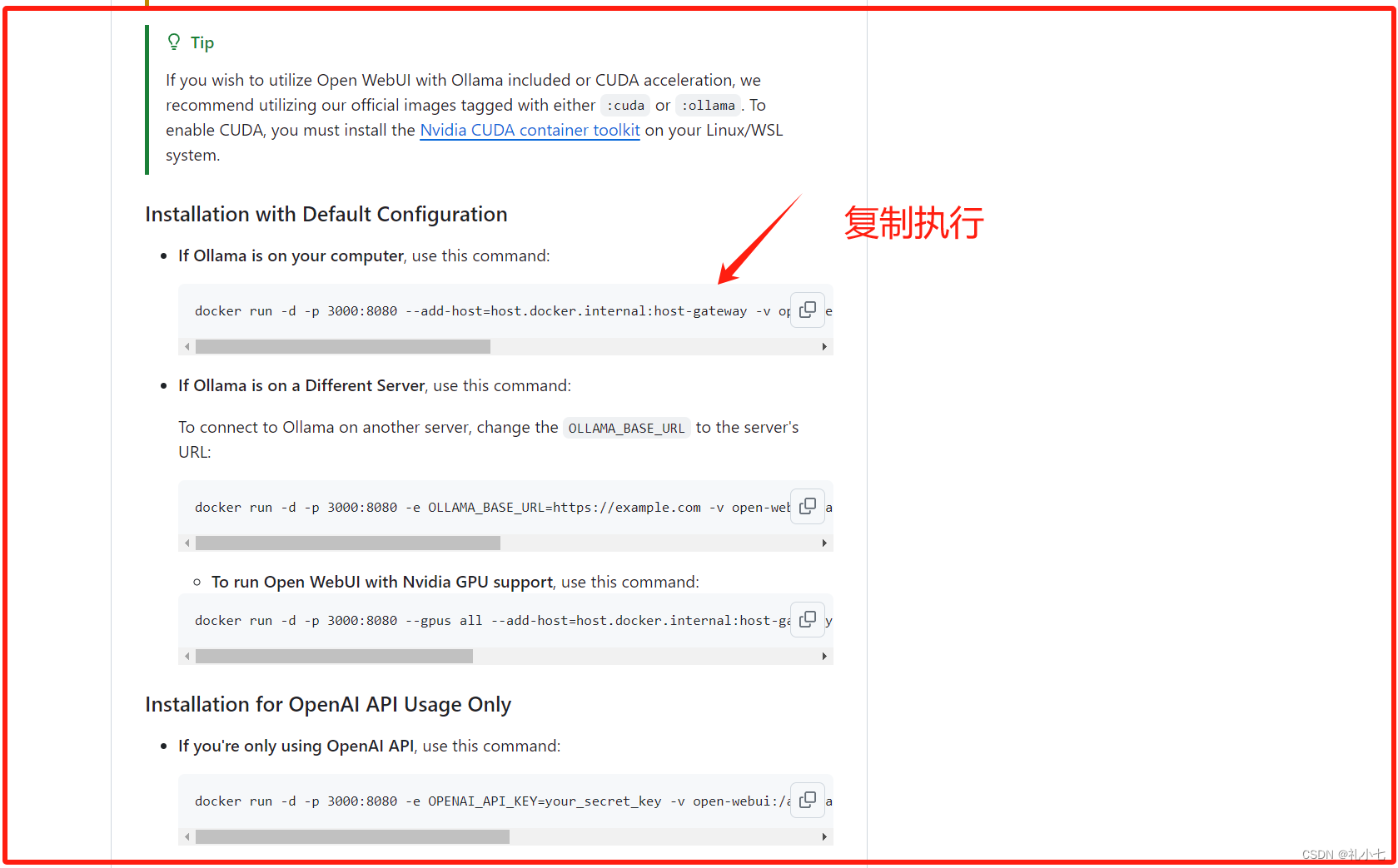

3.github拉取open-webUi镜像Package open-webui · GitHub

复制命令运行在命令提示符;

等待下载完成

4.到Github复制命令,ollama安装在本地,在命令提示符执行;

需要进入防火墙-新建站点-开通3000端口;开通流程win11 通过防火墙设置-开通本地端口-优快云博客

查看端口是否被占用 netstat -aon|findstr "11434"

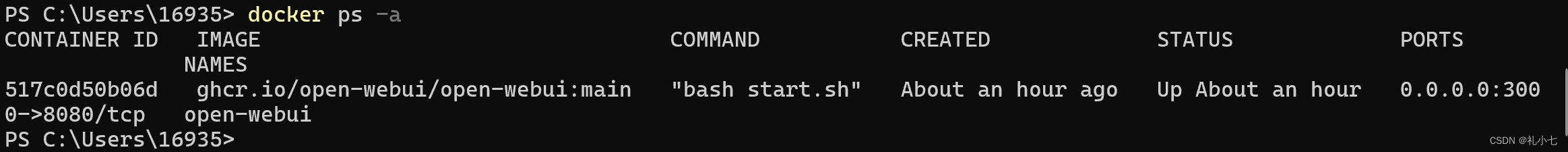

下载成功

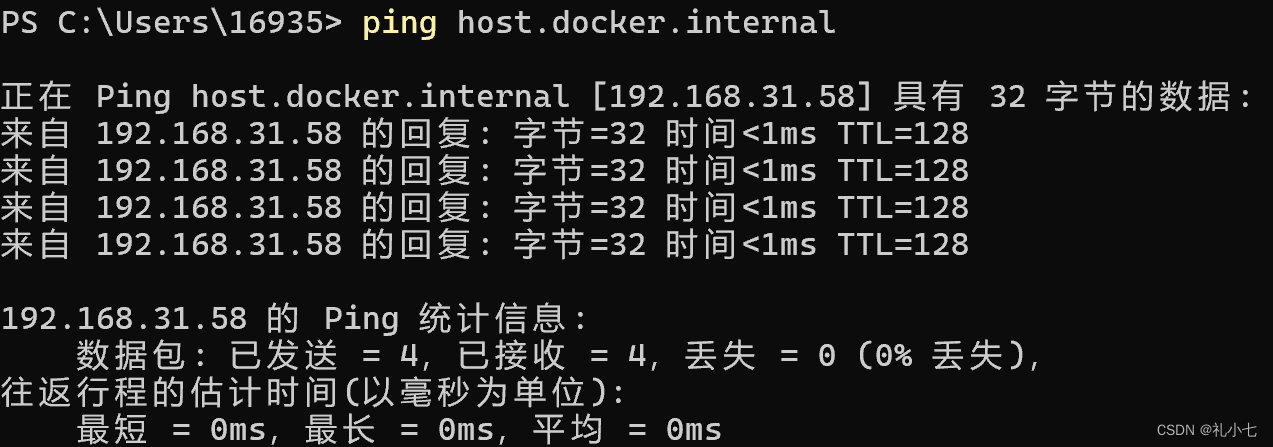

5.使用命令提示符,输入ipconfig查询本地IP,

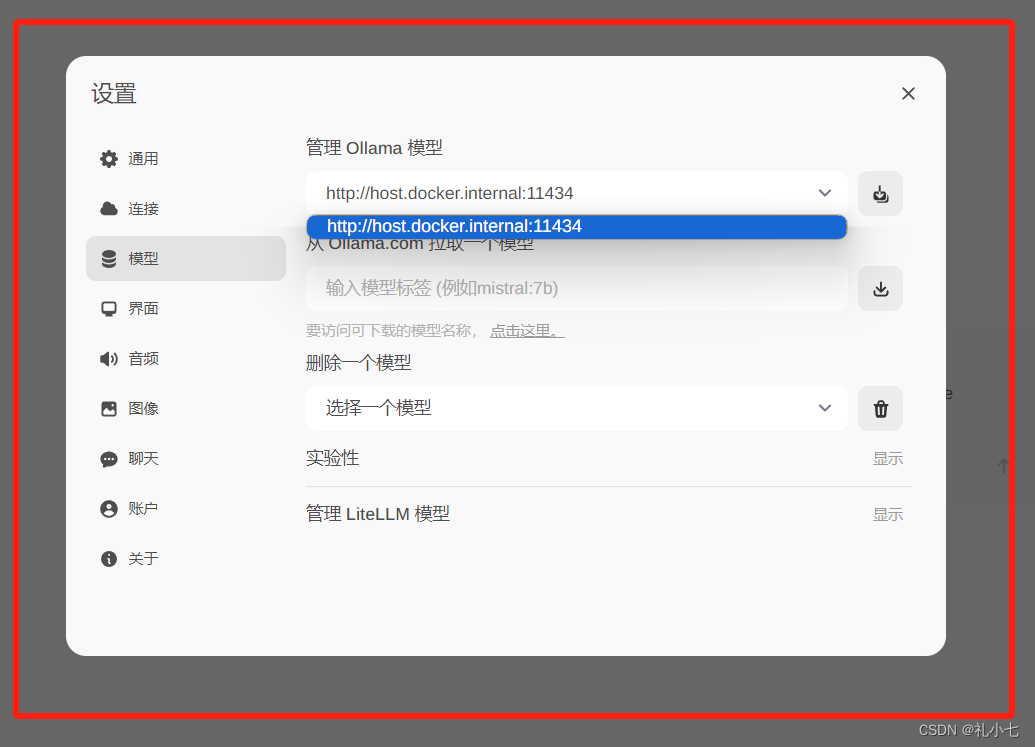

浏览器访问【本地IP:3000】右上角设置,找到language设置,找到简体中文;

设置-模型

host.docker.internal就是本地IP

查询docker进程

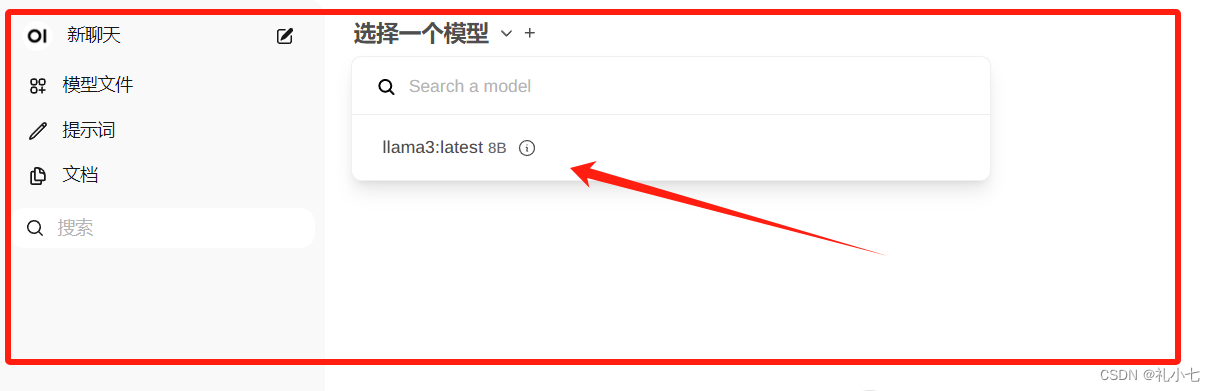

6.open-webui 选择已经安装的allama3:8B;

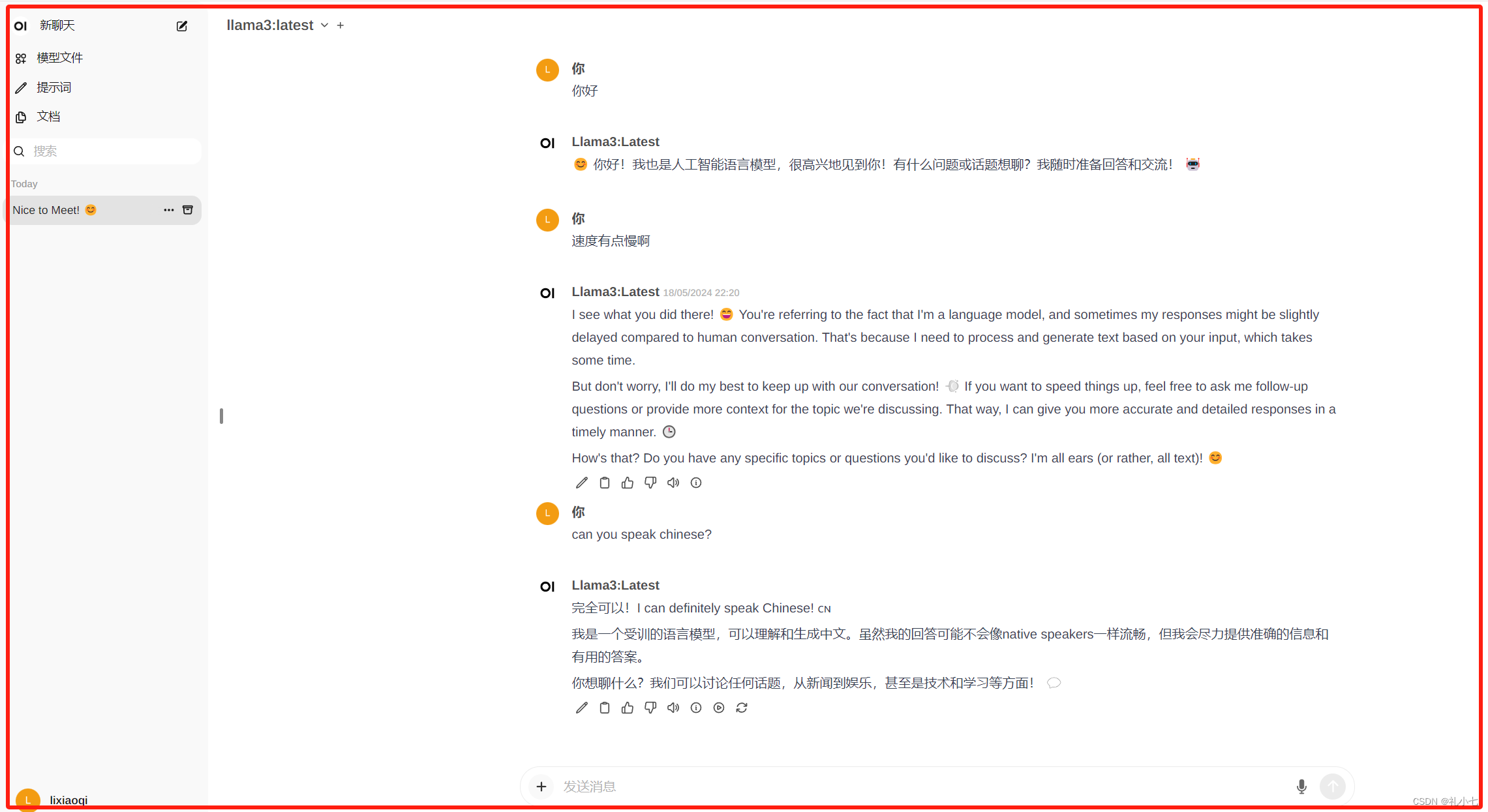

7.完成可以开始进行对话;

9481

9481

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?