然后我们再来看如何使用spark,使用scala,来从命令行中,进行

数据查询,可以看到这里,支持后面写hudi,还是因为我们配置了,hudi中的对spark支持的jar到spark中

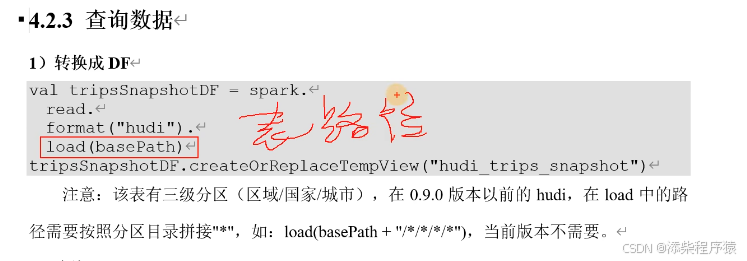

然后这里的basePath这里一定要注意,因为我们开启了,多级分区,所以,如果hudi用的是0.9.0之前的版本,那么这里的basePath需要,把

子分级,也就是子目录也拼接上.

去执行

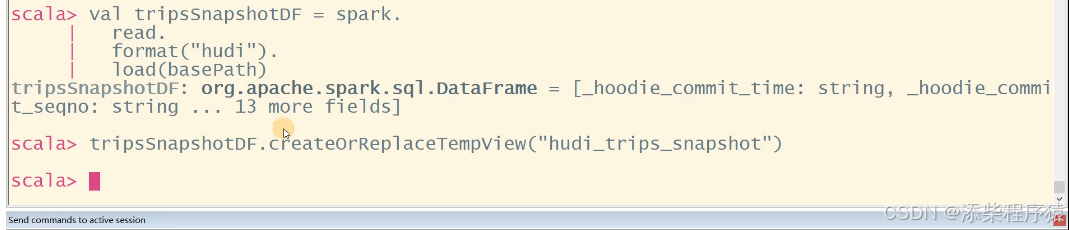

val tripsSnapshotDF = spark.

read.

format("hudi").

load(basePath)

tripsSnapshotDF.createOrReplaceTempView("hudi_trips_snapshot")可以看到这个代码的作用就是,去对应的path,去load数据,然后创建

tempview视图,根据表名: hudi_trips_snapshot

去创建视图.

订阅专栏 解锁全文

订阅专栏 解锁全文

368

368

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?