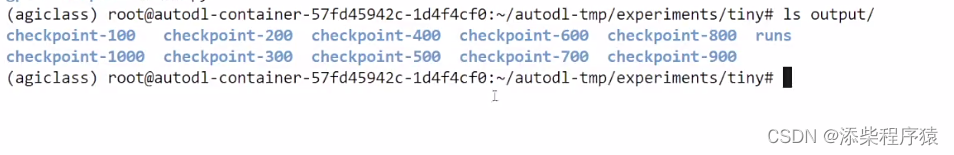

接上一节,可以看到上面目录是我们训练好的,结果文件

output文件夹中就对应了每100步生成的一个checkpoint.当然也可以定义每几轮生成一个checkpoint,但是,我们这里生成checkpoint是按的的步来算的,这个可以在前面设置.

「Checkpoint」指的是在特定时间点保存的模型的状态。这个状态包括了模型的参数权重和优化器的状态,使得训练可以从这个点重新开始而不是从头开始。

通常,我们通过观察在验证集上的评估结果,选择某个 checkpoint 作为最终用于推理的模型。

注意一般都是选择,最后还差几步快训练结束时候的模型做为最终模型使用,当然具体的,还需要

进行实际测试以后,采用.

10. 加载训练后的模型进行推理(参考)

```python

from transformers import AutoTokenizer, AutoModelForCausalLM

# 加载训练后的 checkpoint

model = AutoModelForCausalLM.from_pretrained("output/checkpoint-1000")

# 模型设为推理模式

model.eval()

# 加载 tokenizer

tokenizer = AutoTokenizer.from_pretra

本文介绍了模型微调中关于checkpoint的使用,强调选择验证集表现最佳的模型。讨论了如何加载模型进行推理和继续训练,并探讨了神经网络的基础,包括线性函数、神经元、激活函数以及模型训练中的学习率和BatchSize对模型性能的影响。还提到了张量的概念以及随机梯度下降在训练过程中的作用。

本文介绍了模型微调中关于checkpoint的使用,强调选择验证集表现最佳的模型。讨论了如何加载模型进行推理和继续训练,并探讨了神经网络的基础,包括线性函数、神经元、激活函数以及模型训练中的学习率和BatchSize对模型性能的影响。还提到了张量的概念以及随机梯度下降在训练过程中的作用。

订阅专栏 解锁全文

订阅专栏 解锁全文

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?