之前我们执行了chatglm-6b-int4的模型已经执行成功了,

然后我们再来试试,chatglm-6b-int8能不能在CPU上运行成功,在007节我们发现,在CPU上进行chatglm-6b-int4的大模型微调,老是报错,目前还没有解决.

首先:

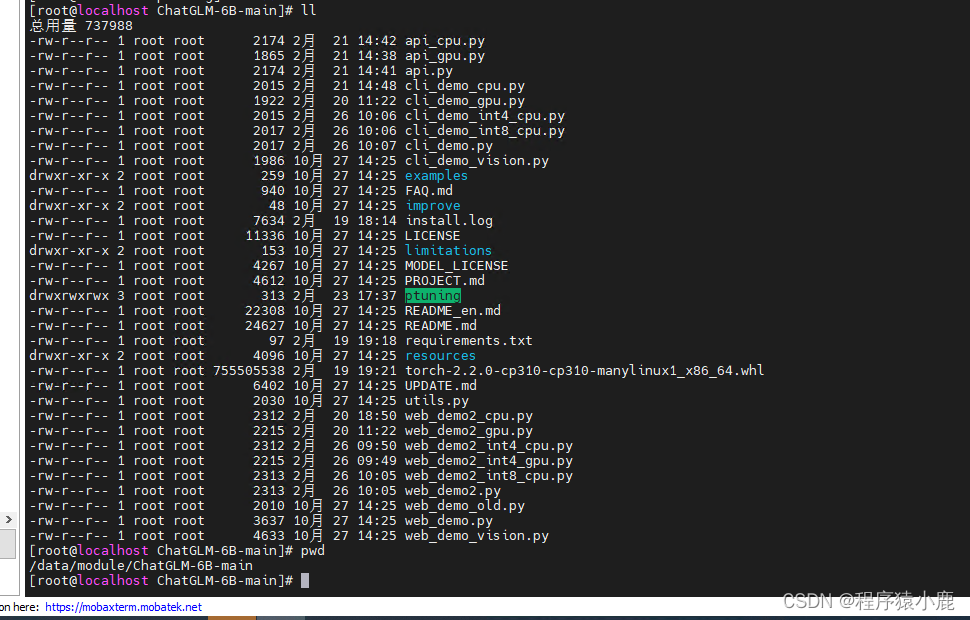

我们把之前配置好的web_demo2.py是针对chatglm-6b-int4的,我们备份一下成:

web_demo2_cpu.py 因为GPU版本的我们没用过,到时候使用gpu的时候再去修改就可以了,

然后,我们到:

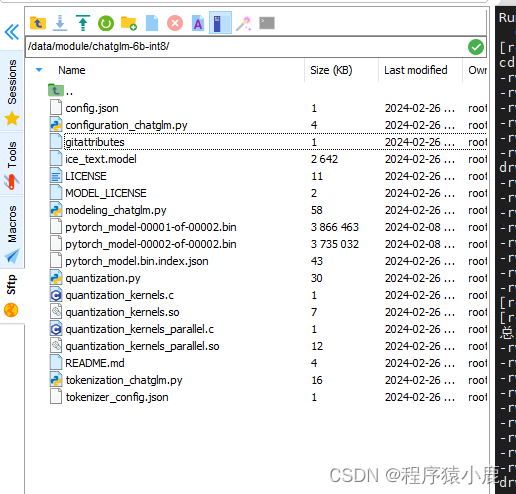

到这个/data/module/chatglm-6b-int8/里面,这些文件是之前下载好,然后放在这里的

然后需要再去编译quantization_kernels.c 和 qunantization_kernels_parallel.c 这两个文件

编译成对应的.so文件.然后,

gcc -fPIC -pthread -fopenmp -std=c99 quantization_kern

本文记录了在CentOS7.9系统中使用CPU成功运行ChatGLM-6B-int8模型的过程。首先备份并修改web_demo2.py为web_demo2_cpu.py,然后在/data/module/chatglm-6b-int8/目录下编译quantization_kernels.c和quantization_kernels_parallel.c文件为.so库。接着修改相关配置,启动模型并访问网页验证运行正常。此外,还提到运行ChatGLM-6B模型时遇到内存不足的问题,通过将虚拟机内存从10G增加到28G,分配4个逻辑核心,最终解决了问题并成功运行。

本文记录了在CentOS7.9系统中使用CPU成功运行ChatGLM-6B-int8模型的过程。首先备份并修改web_demo2.py为web_demo2_cpu.py,然后在/data/module/chatglm-6b-int8/目录下编译quantization_kernels.c和quantization_kernels_parallel.c文件为.so库。接着修改相关配置,启动模型并访问网页验证运行正常。此外,还提到运行ChatGLM-6B模型时遇到内存不足的问题,通过将虚拟机内存从10G增加到28G,分配4个逻辑核心,最终解决了问题并成功运行。

订阅专栏 解锁全文

订阅专栏 解锁全文

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?