然后我们再来看,这个ProcessFunction,为什么要用这个ProcessFunction,因为有些功能不用这个

做不到,比如说,我们要在数据处理的过程中拿到当前的waterMark,不用这个底层的api是拿不到的,

然后还有时间戳,以及注册定时事件,比如说我设置定时15秒以后执行某个动作对吧.

还有如果我要在侧输出流里面在分出一个高温流一个低温流这样呢?

对吧,这些都需要用到这个底层的ProcessFunction这个api了.

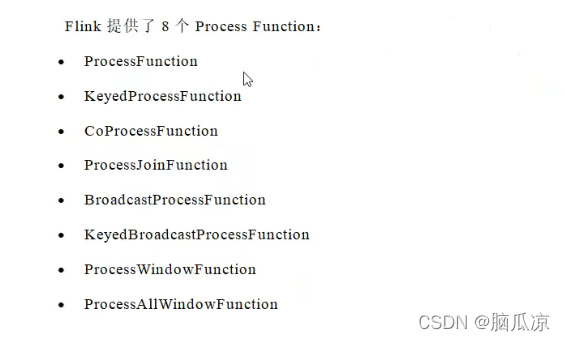

可以看到flink提供了8个ProcessFunction,这里第一个是ProcessFunction

第二个是KeyedProcessFunction,这个其实就是相当于先对流进行keyedStream对吧

先对流进行keyby,然后再调用ProcessFunction对吧.

本文介绍了Flink中的ProcessFunction,强调其在数据处理中的关键作用,如获取waterMark、时间戳、注册定时事件以及创建侧输出流等。ProcessFunction包括普通ProcessFunction、KeyedProcessFunction等8种类型,分别适用于不同场景。文章详细讲解了每个函数的用途和方法,例如processElement和process方法,以及它们在数据流处理中的应用。

本文介绍了Flink中的ProcessFunction,强调其在数据处理中的关键作用,如获取waterMark、时间戳、注册定时事件以及创建侧输出流等。ProcessFunction包括普通ProcessFunction、KeyedProcessFunction等8种类型,分别适用于不同场景。文章详细讲解了每个函数的用途和方法,例如processElement和process方法,以及它们在数据流处理中的应用。

订阅专栏 解锁全文

订阅专栏 解锁全文

390

390

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?