然后我们再来看一下,es中的分词,

要知道tokenizer就是分词器,然后他会接收一个字符流,然后把字符流分成一个个独立的tokens,词元.

然后把tokens流再输出.

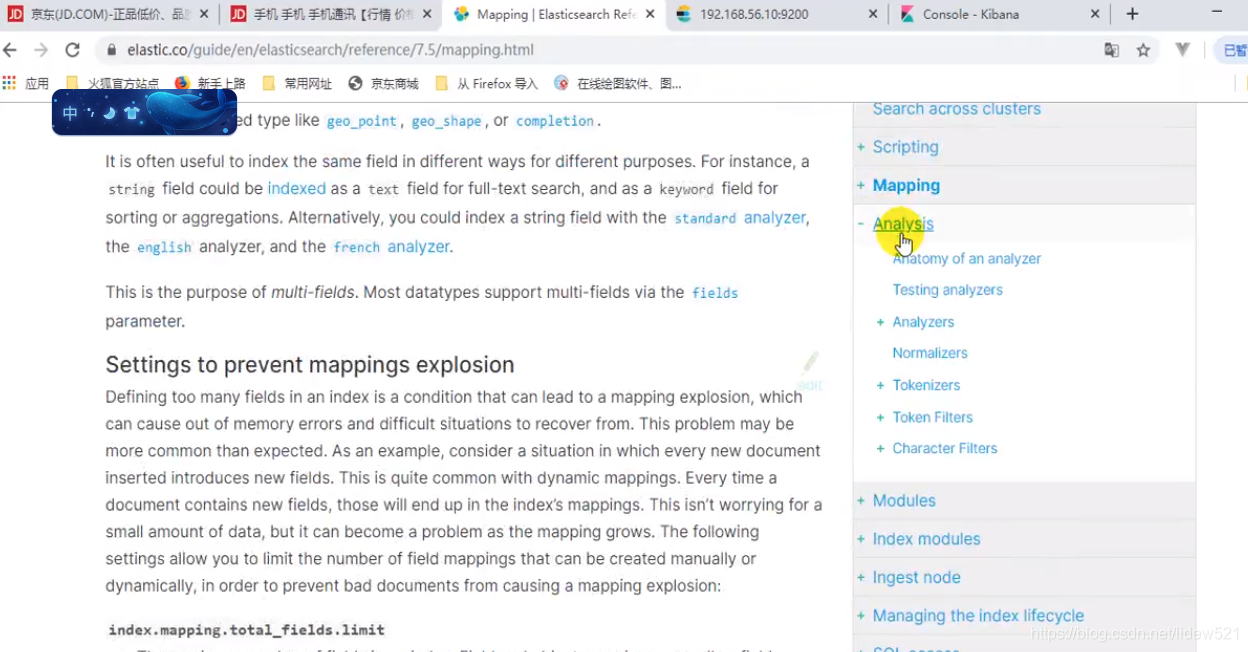

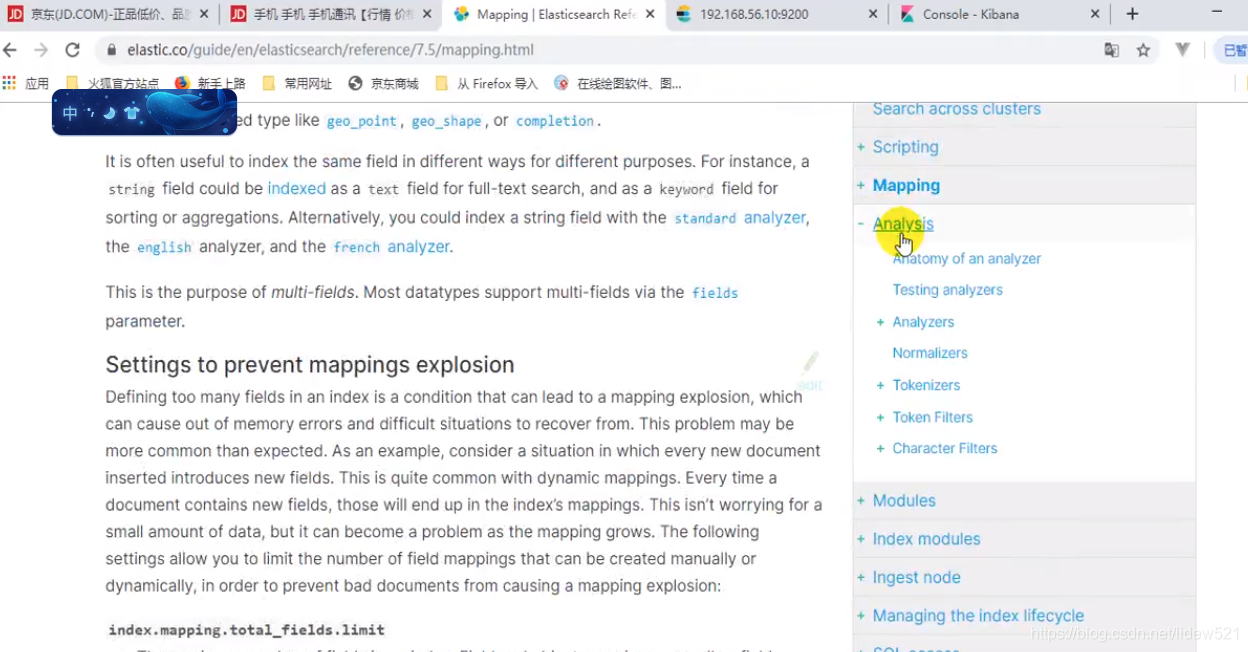

然后我们去看看,官网这个部分,在es官网上可以看到

点击analysis可以看到

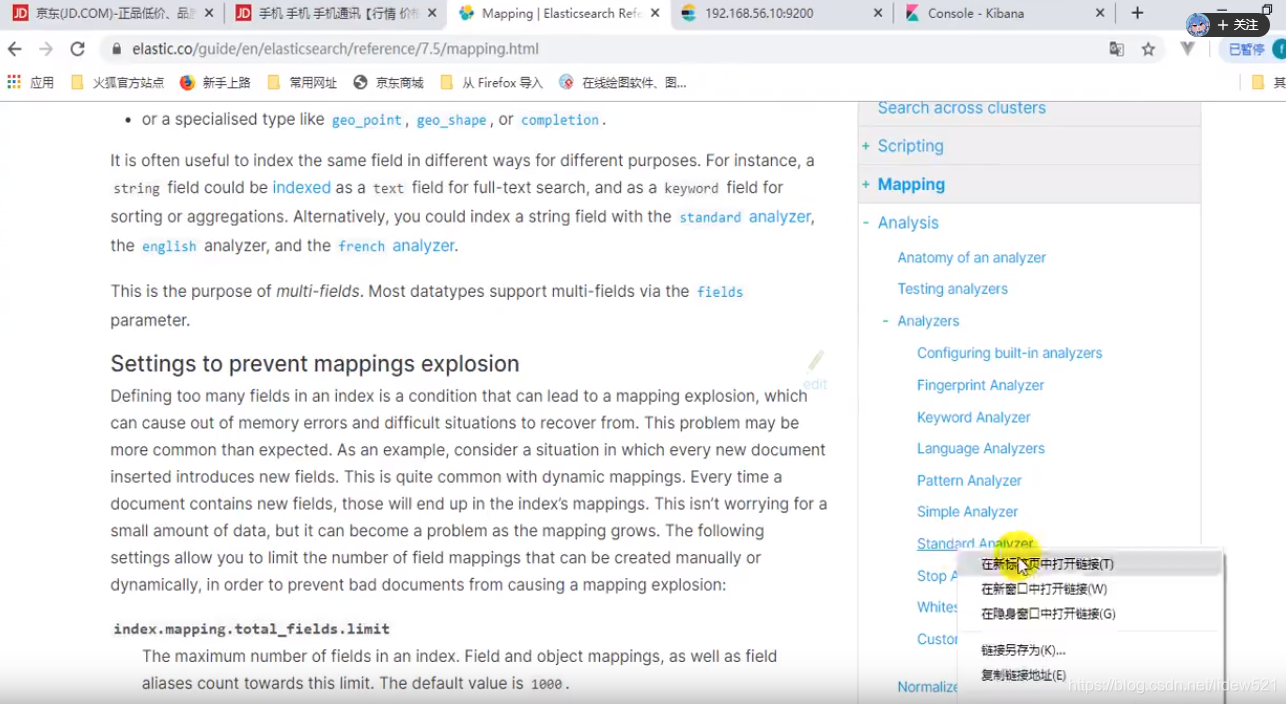

下面有个analyzers,可以看到下面提供了很多的分词器,

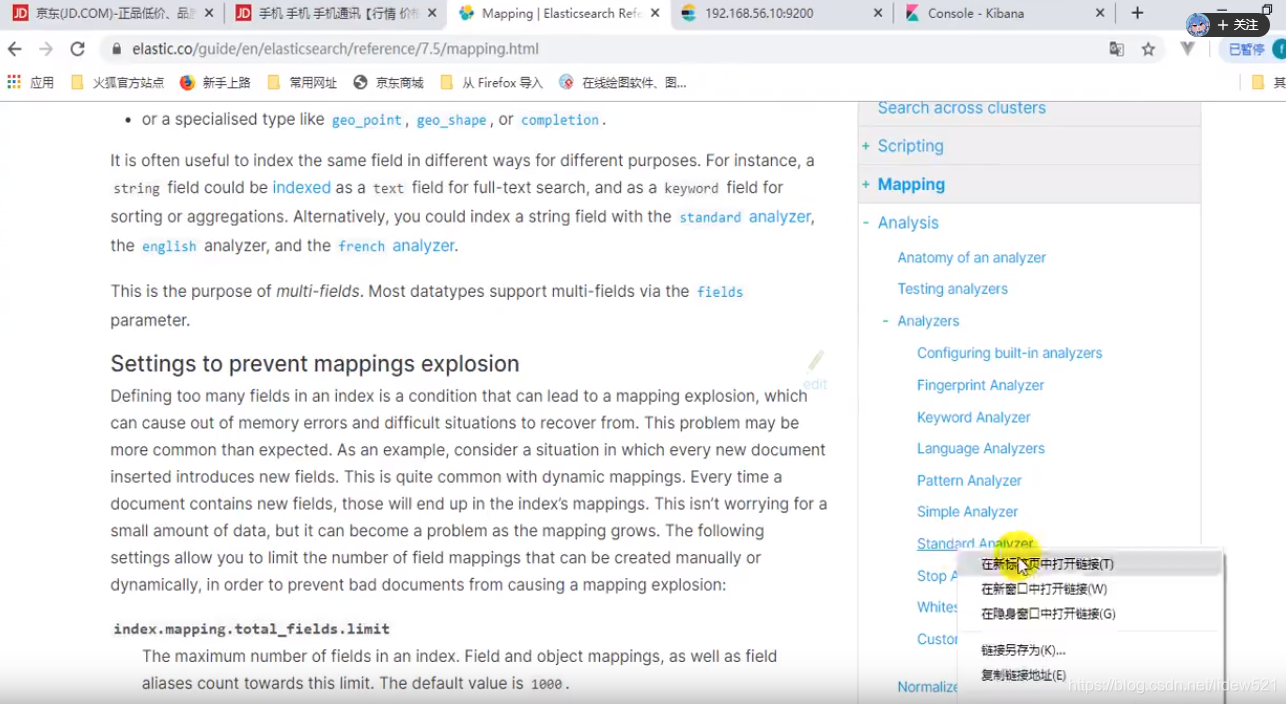

我们找到一个standard analyzer,这个是标准分词器.

.也是es提供的默认的分词器.

然后我们再来看一下,es中的分词,

要知道tokenizer就是分词器,然后他会接收一个字符流,然后把字符流分成一个个独立的tokens,词元.

然后把tokens流再输出.

然后我们去看看,官网这个部分,在es官网上可以看到

点击analysis可以看到

下面有个analyzers,可以看到下面提供了很多的分词器,

我们找到一个standard analyzer,这个是标准分词器.

.也是es提供的默认的分词器.

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?