本文出自于论文Edge Intelligence: On-Demand Deep Learning Model Co-Inference with Device-Edge Synergy ,主要介绍了一种移动设备与边缘协同作用的DNN协同推理框架。

一、简介和相关工作

- 在资源受限的移动设备上运行DNN会带来高能耗,而将DNNs卸载到云上执行时,由于无法控制长时间广域网延迟,其性能也难以预测。为了解决这些挑战,在本文中我们提出来Edgent,一个协同和按需的DNN协同推理框架,它将设备与边缘协同作用。Edgent包含两个关键点:(1)自适应地将DNN计算划分在设备和边缘之间的DNN分区,利用相邻的混合计算资源进行实时的DNN推理;(2)通过在适当的中间DNN层提前退出来加速DNN推理,从而进一步降低计算延迟。

- DNN处理的传统方式是将移动设备生成的输入数据发送到云端进行处理,推理后将结果发送回移动设备。然而以云端为中心的方案,大量数据需要借助长时间的广域网数据传输来上传到云,导致高度端到端延迟和移动设备能耗。为了减轻以云为中心方法的延迟和能量瓶颈,一个更好的方案是利用新型的边缘计算范式,边缘计算支持低延迟和高效的DNN推理。

- Edgent进一步结合了DNN分区和DNN的正确规模,通过在中间DNN层的早期退出来加速DNN推理。但是早期退出会导致部分精度损失,因此Edgent通过随需应变的方式联合优化DNN分区和正确规模。

- 我们采取一种向外扩展的方案,来释放边缘和移动设备之间的协作优势智能,从而缓解终端设备的性能和能量瓶颈。在另一方面,DNN分区不足以满足关键任务应用程序的严格及时性要求。因此,我们进一步应用了DNN的大小调整方法来加速DNN推理。

二、背景及研究动机

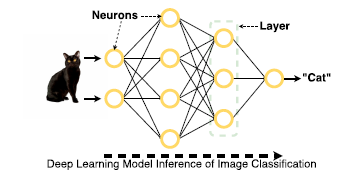

- DNN划分:将DNN划分成两部分,然后以较低的传输开销将计算密集型的一部分转移到服务器,于是减少了端到端延迟。通过在设备和边缘之间的DNN划分,我们能够协作混合计算资源在靠近低延迟的DNN推理。

- DNN正确大小:为了进一步降低延迟,我们可以将DNN正确调整大小的方法与

文章提出Edgent框架,解决了移动设备上运行DNN的高能耗和云端推理的不可预测延迟问题。Edgent通过DNN分区和正确大小调整,实现设备与边缘的协同推理,优化端到端延迟并最大化推理精度。实验表明,Edgent能有效应对带宽变化和延迟需求,提升模型性能。

文章提出Edgent框架,解决了移动设备上运行DNN的高能耗和云端推理的不可预测延迟问题。Edgent通过DNN分区和正确大小调整,实现设备与边缘的协同推理,优化端到端延迟并最大化推理精度。实验表明,Edgent能有效应对带宽变化和延迟需求,提升模型性能。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

508

508

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?