本文将教会你,如何利用多个controlnet组合以及一些最新的SD插件,来精准的控制画面,生成角色三视图、光源和颜色控制、替换背景,控制手脚完美生成等极具实用性的高级技巧,更多内容详见目录。

笔者研究了不同的controlnet组合和参数调整,踩了无数的坑,总结了本篇,只要肯学,就一定给你带来意想不到的收获!

感兴趣的小伙伴,赠送全套AIGC学习资料和安装工具,包含AI绘画、AI人工智能等前沿科技教程,模型插件,具体看下方。

需要的可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

目录

1 单个controlnet配合插件的高级用法

*1.*1 角色三视图生产

1.2 精准控制光源

*1.3* 颜色控制画面

*1.4* 一键换背景

*1.5* 更精准的图生图控制

2 多个controlnet的组合用法

**2.*1* 控制手脚完美生成

2.2 人物和背景分别控制生成

**2.3 风格融合

2.4 分块控制

3 其他相关插件的用法

3.1 生成多人画面更精准分块控制

一、 单个controlnet配合插件的高级用法

1角色三视图生产

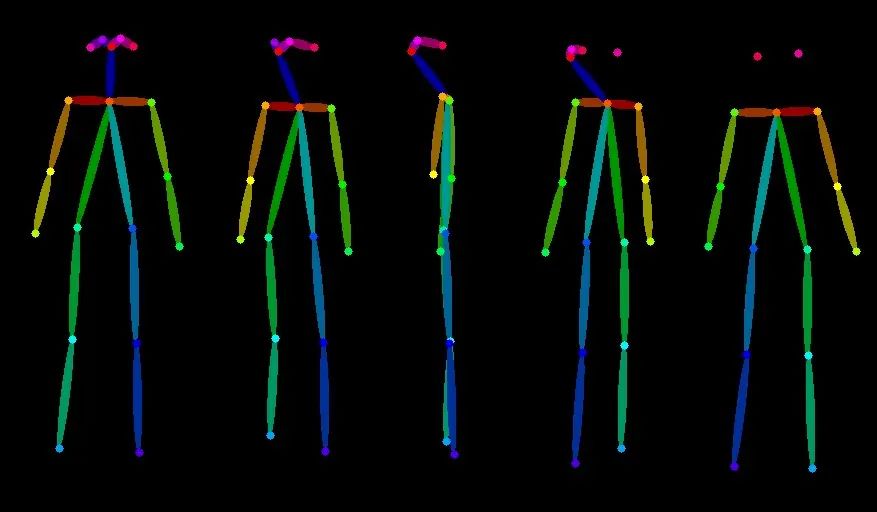

Step1 找一张openpose的三视图

下载我这张即可:

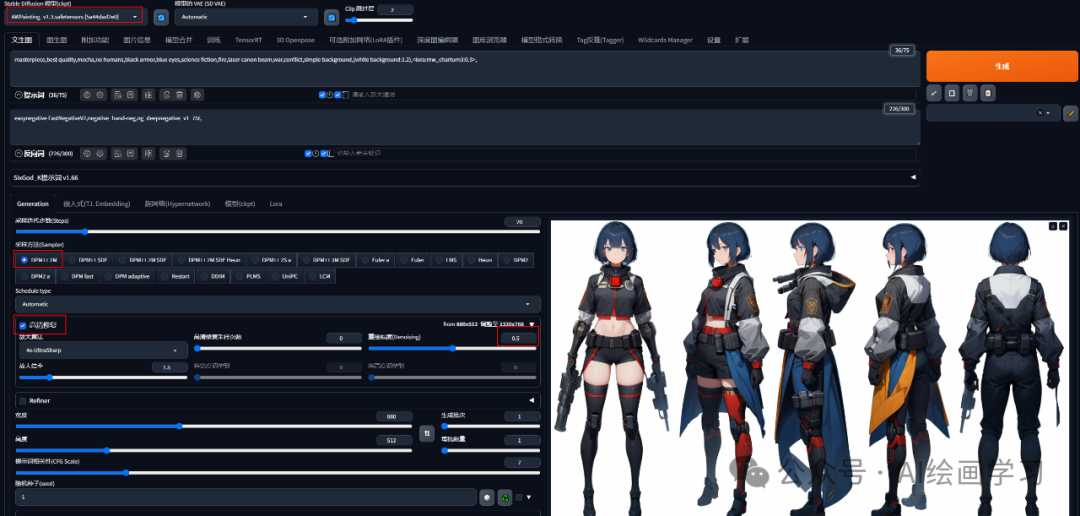

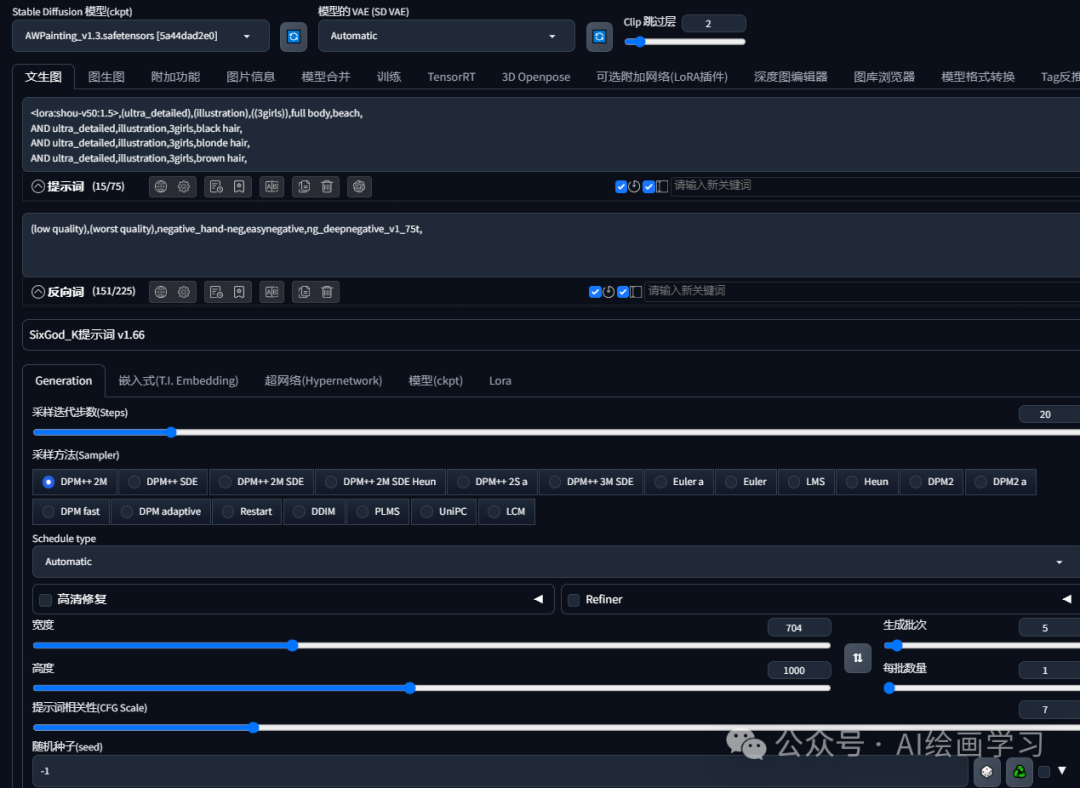

*Step2 选择controlnet模型和参数配置*

**Step3 输入咒语提示词+三视图Lora模型****

| 高质量 | 最好的质量,杰作 | best quality,masterpiece |

|---|---|---|

| 人物 | 男/女,发型,衣服 | 1 girl,Braids, dresses |

| 三视图关键词 | 单人,(简单背景,白色背景:1.3),多个视图 | solo,(simple background,white background:1.3),multiple views |

提示词1:

best quality,masterpiece,1 girl,Braids, dresses,solo,(simple background,white background:1.3),multiple views

提示词2:

masterpiece, best quality, mecha, no humans, black armor, blue eyes, science fiction, fire, laser canon beam, war, conflict, simple background, (white background:1.2)

Lora模型:

模型名称:CharTurnerBeta

下载地址:2选1

https://civitai.com/models/7252/charturnerbeta-lora-experimental

https://www.liblib.art/modelinfo/dd506630e75364658286220cce8a554d

lora权重:0.3左右,选择高清修复重绘0.5:

效果展示:

**2精准控制光源

**

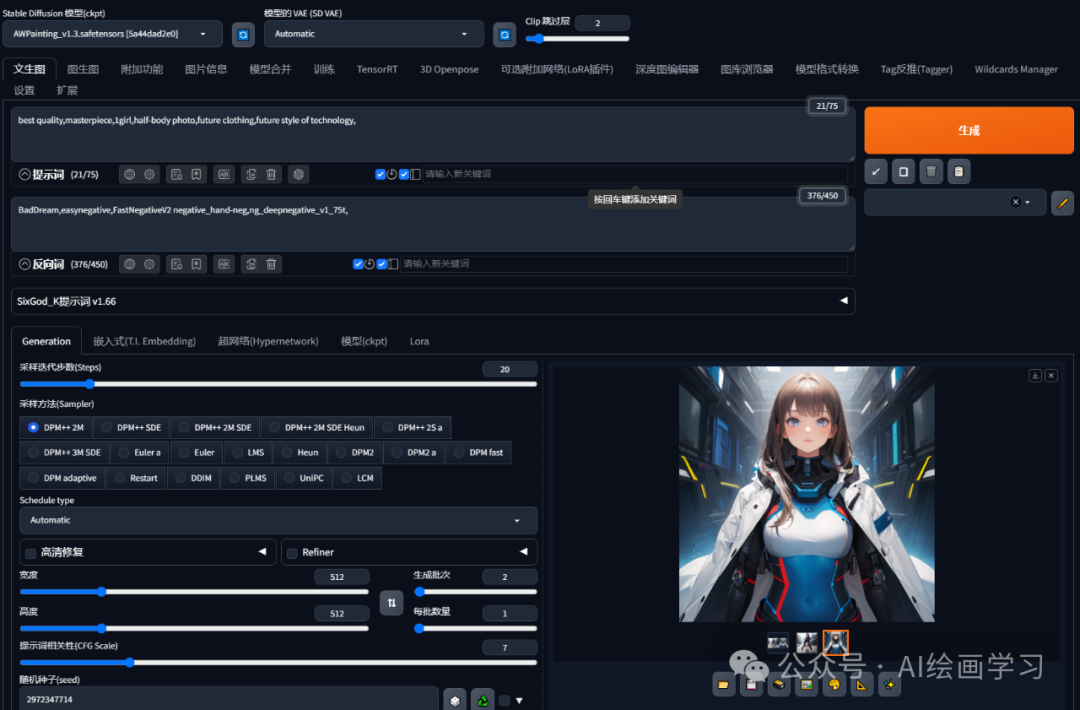

Step1 先用SD画一张图片

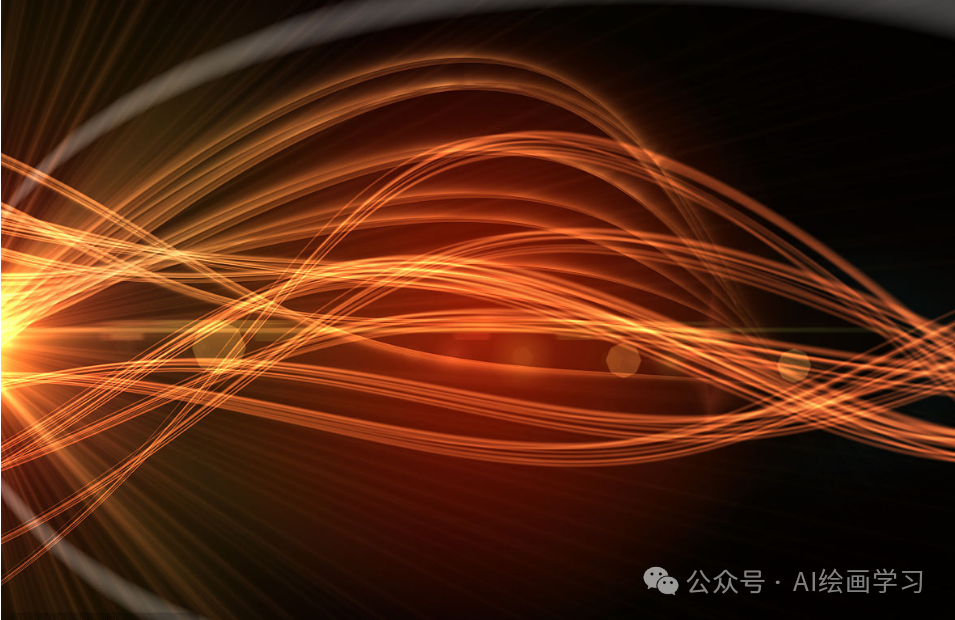

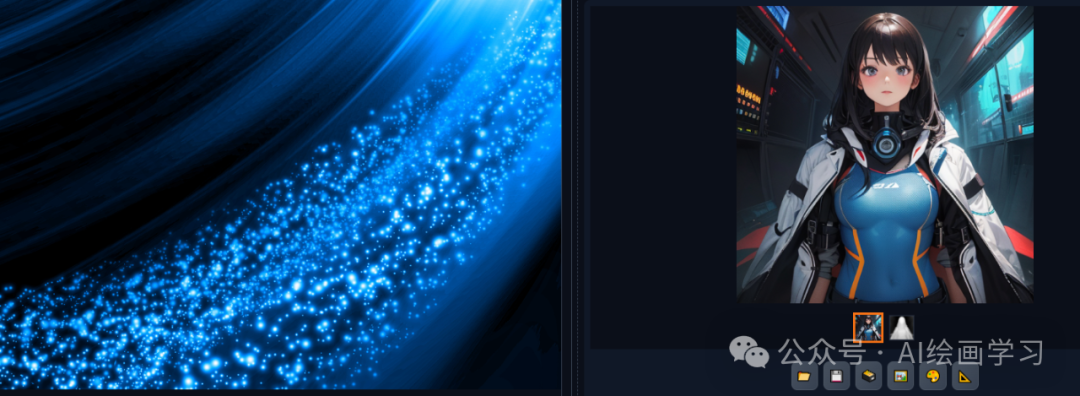

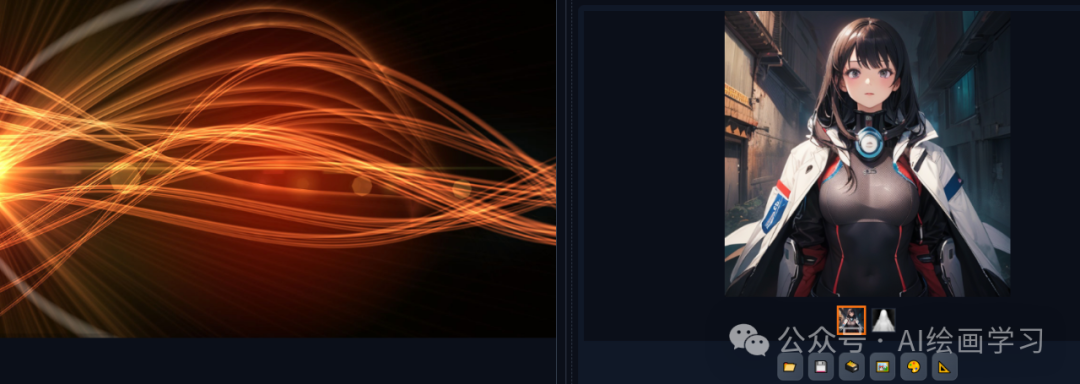

*Step2 找一些光源图素材*

*如下:

*

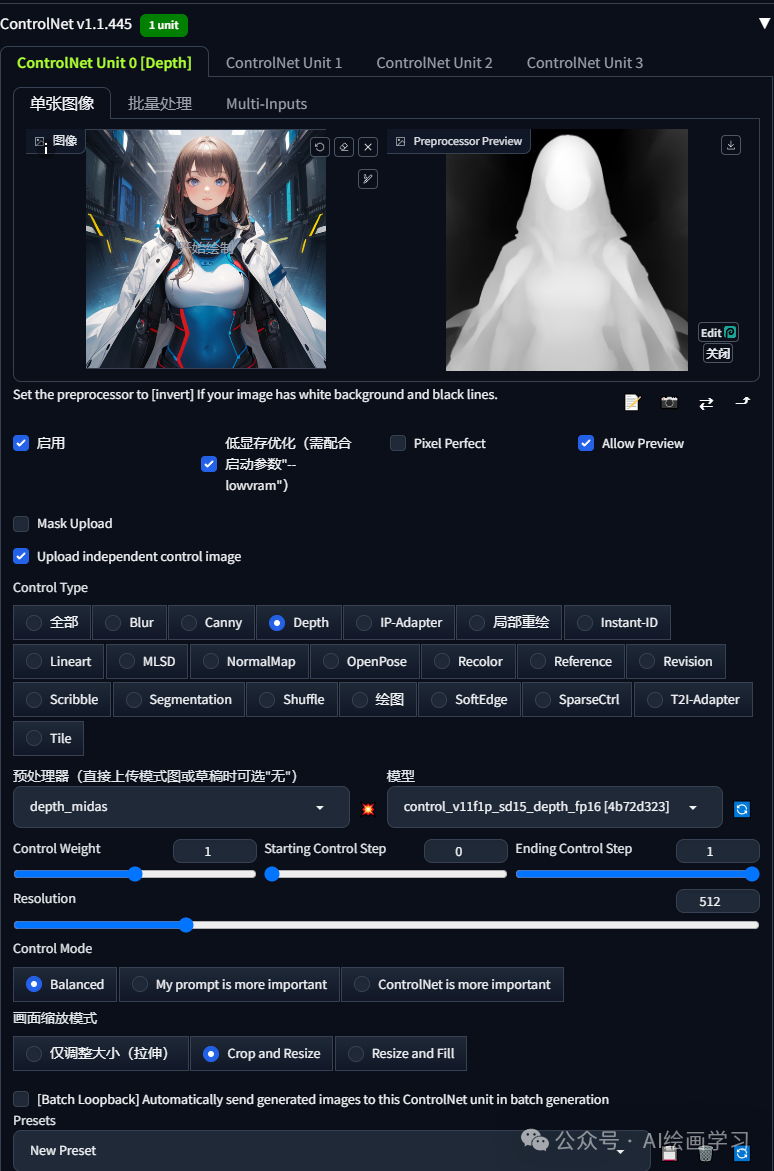

*step3 通过图生图+controlnet-depth 组合*

生成对应对应光源风格的图片:

Tips:图生图的时候,controlnet里面的图需要SD生成的,并且提示词和其他参数,包括种子数,需要和原图保持一致。

**3颜色控制画面

**

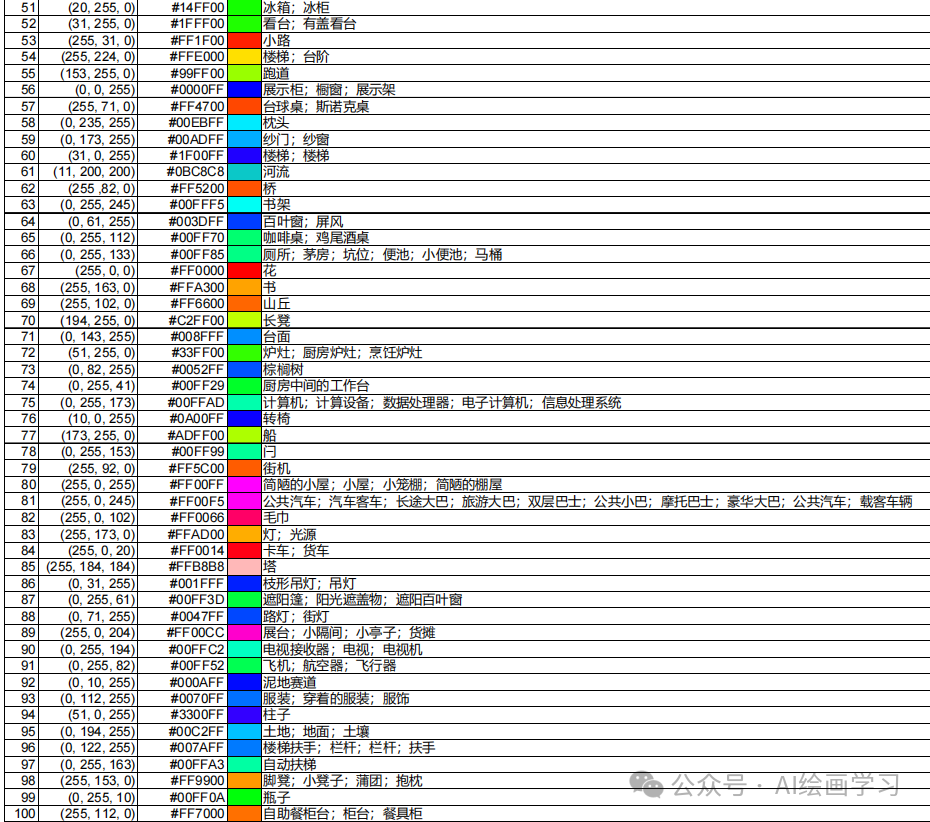

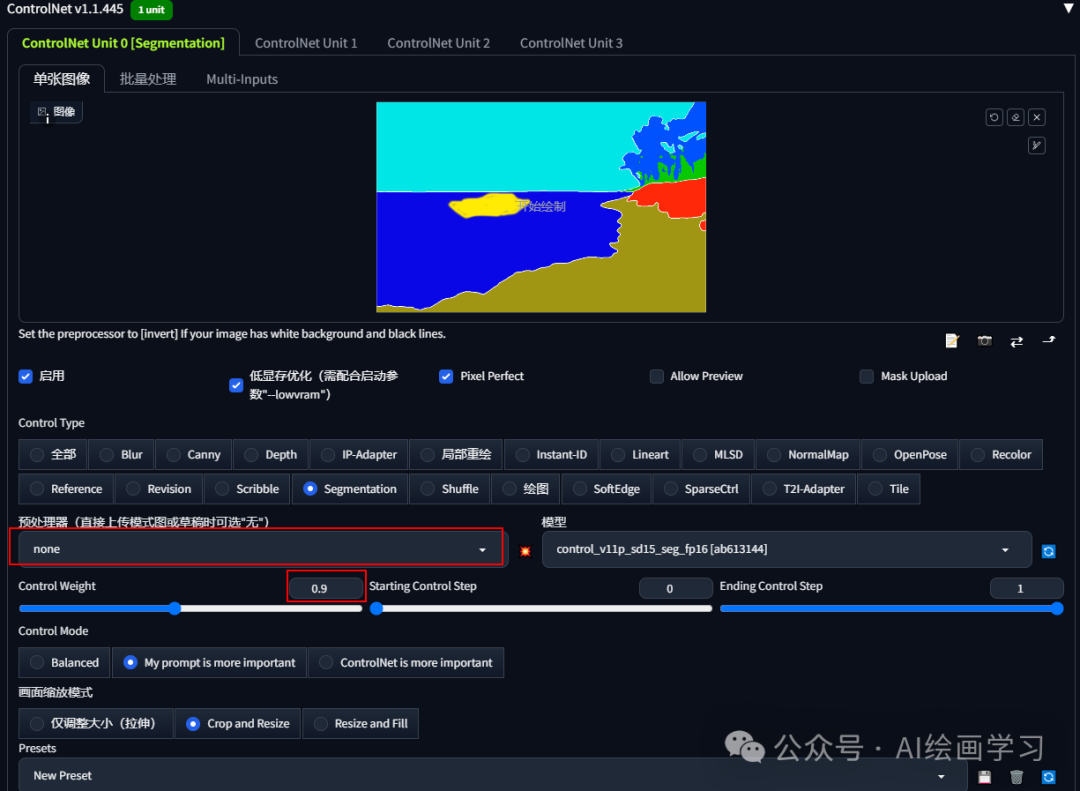

主要通过contentnet-segmentation语义分割模型来实现。

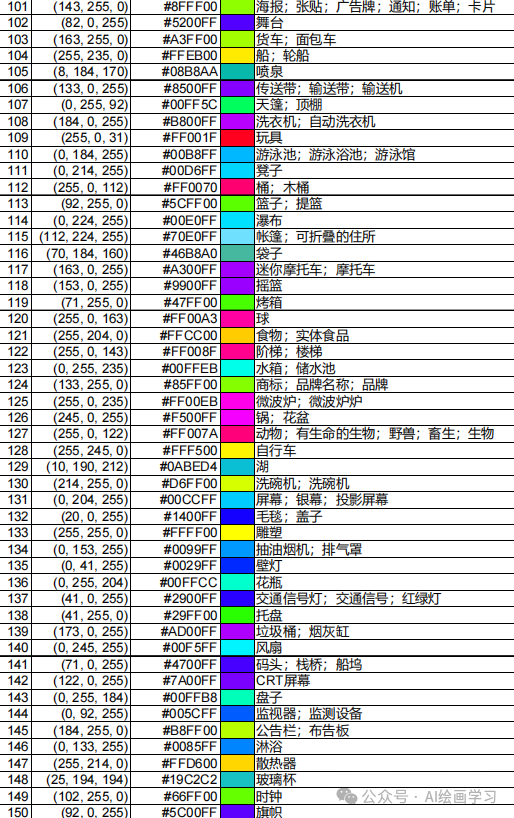

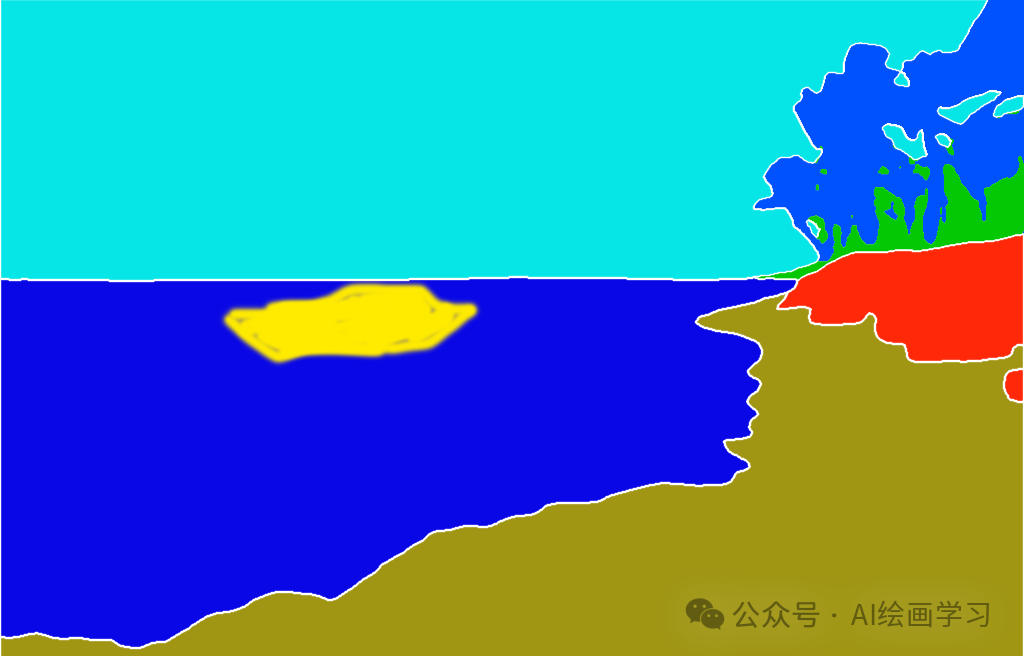

step1 不同颜色对应不同的类型

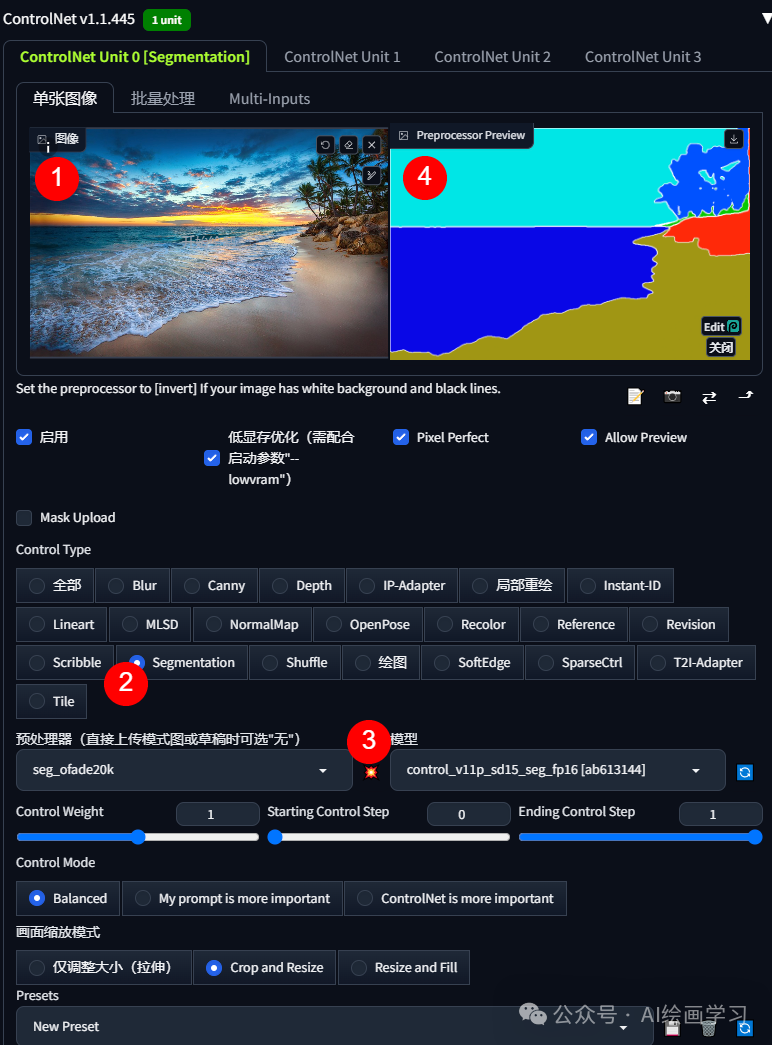

*step2 设置segmentation模型*

*1 随便找一张风景素材图上传到controlnet

*

*2* 模型选择:为了提高准确性,建议使用 seg_ofade20k 和 seg_ofcoco 而不是 seg_ufade20k。

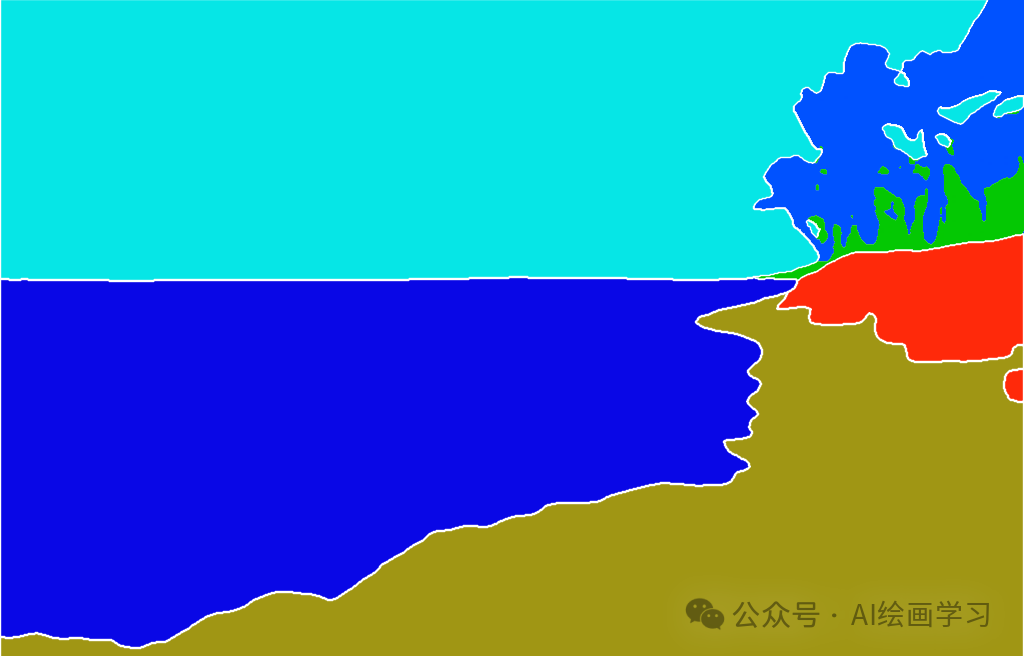

3 点击大爆炸,语义分割

4 可以看到,深蓝色区域-海水,土黄色区域-沙滩,天蓝色区域-天空,参考上文的颜色图表。(你当然也可以自己用PS用不同色块画出来,涂鸦都行)

*step3 精准生成图片或修改局部内容*

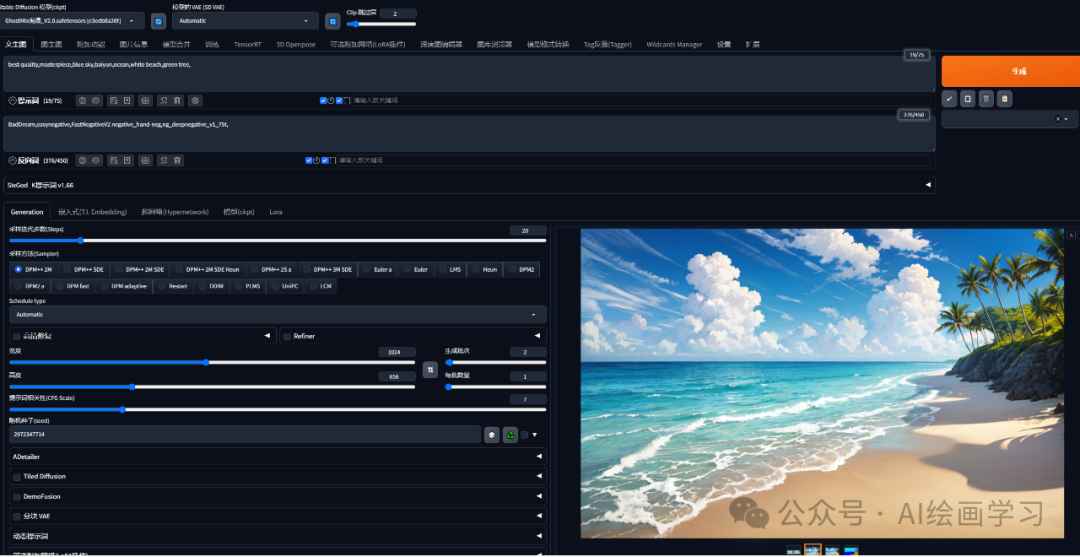

*提示词:**best quality,masterpiece,blue sky,baiyun,ocean,white beach,green tree,*

*生成图片:*

涂鸦一条船生成图片:

提示词:best quality,masterpiece,blue sky,baiyun,ocean,white beach,green tree,a boat,

无需预处理:

这样就指定的位置多了一条船,风格不变:

**4一键换背景

**

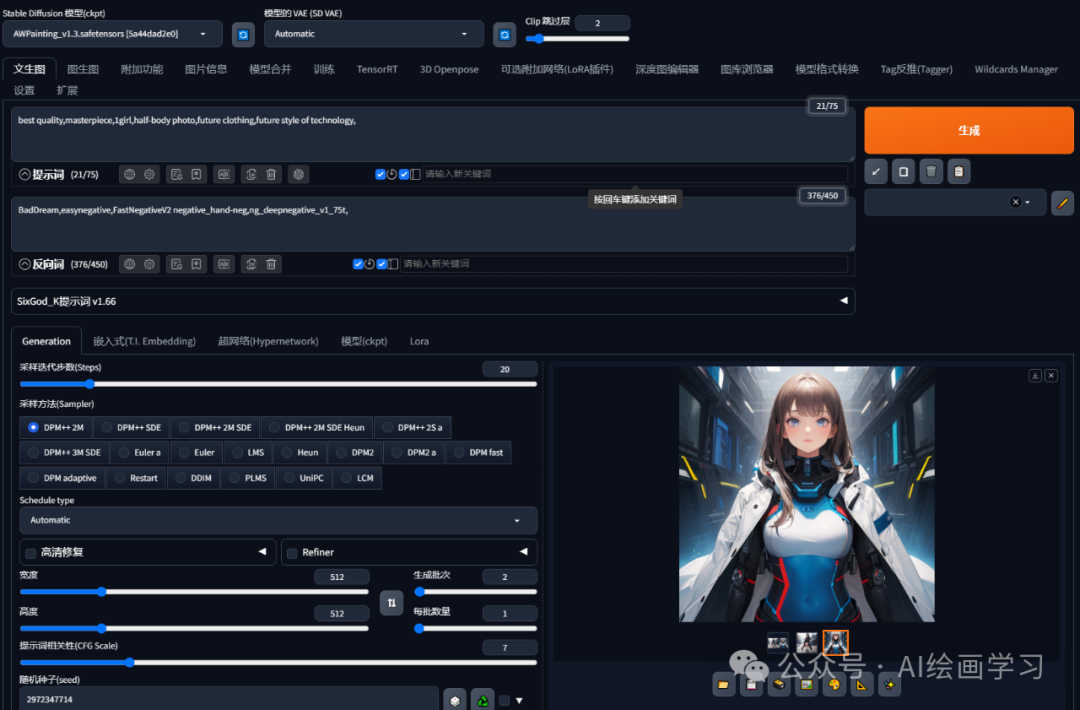

step1 图生图模型,保持原图的所有参数,只在提示词里面替换或新增目标背景的描述。

提示词:

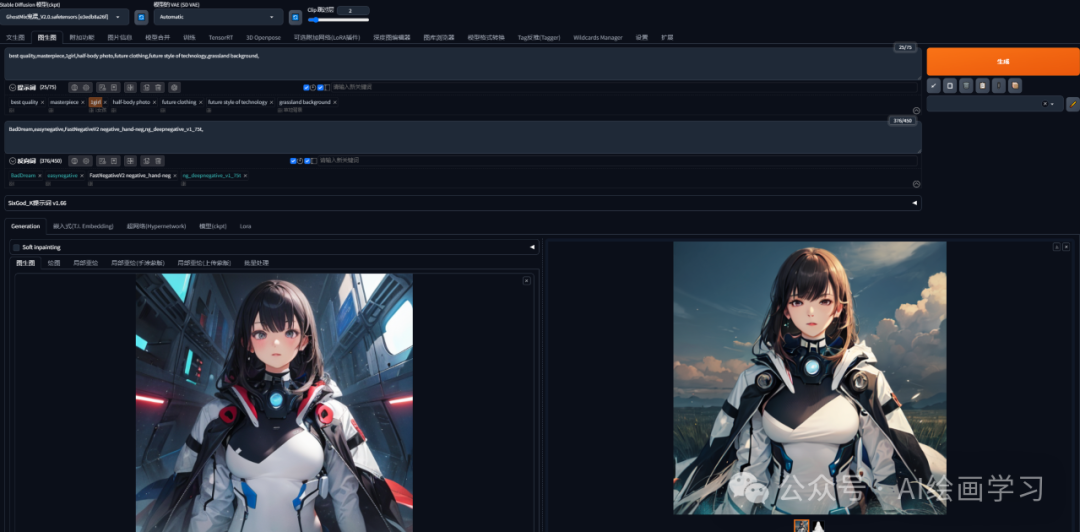

best quality,masterpiece,1girl,half-body photo,future clothing,future style of technology,grassland background,

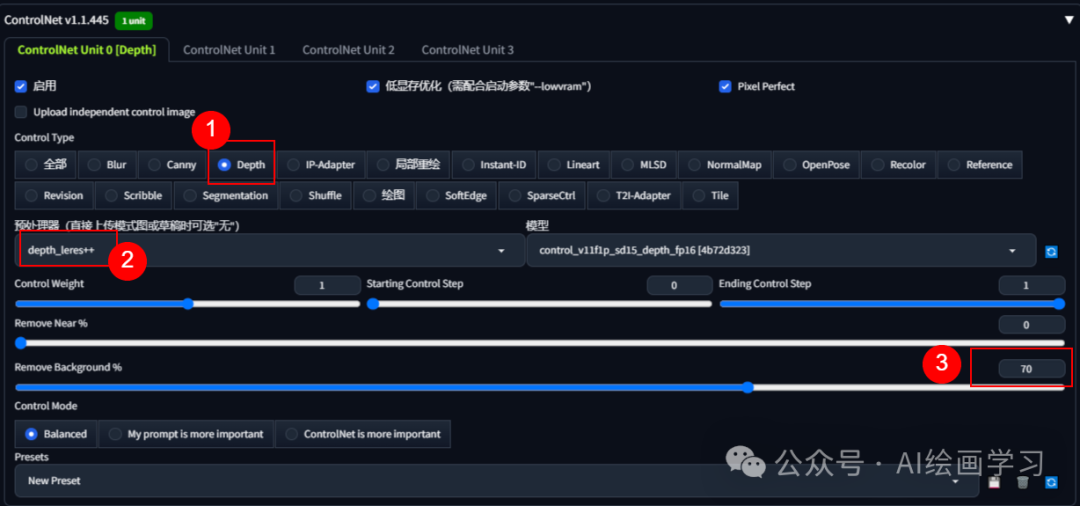

step2 启用controlnet-depth ,无需传图,选择depth_leres++预处理,参数Remove Background % =(50%~75%最佳)

*step3 生成图片,效果如下:*

由于替换了大模型风格和之前不同了,另外衣服颜色和头发也有所改变,如果只换背景,人物变化极小,那就需要 Reference。

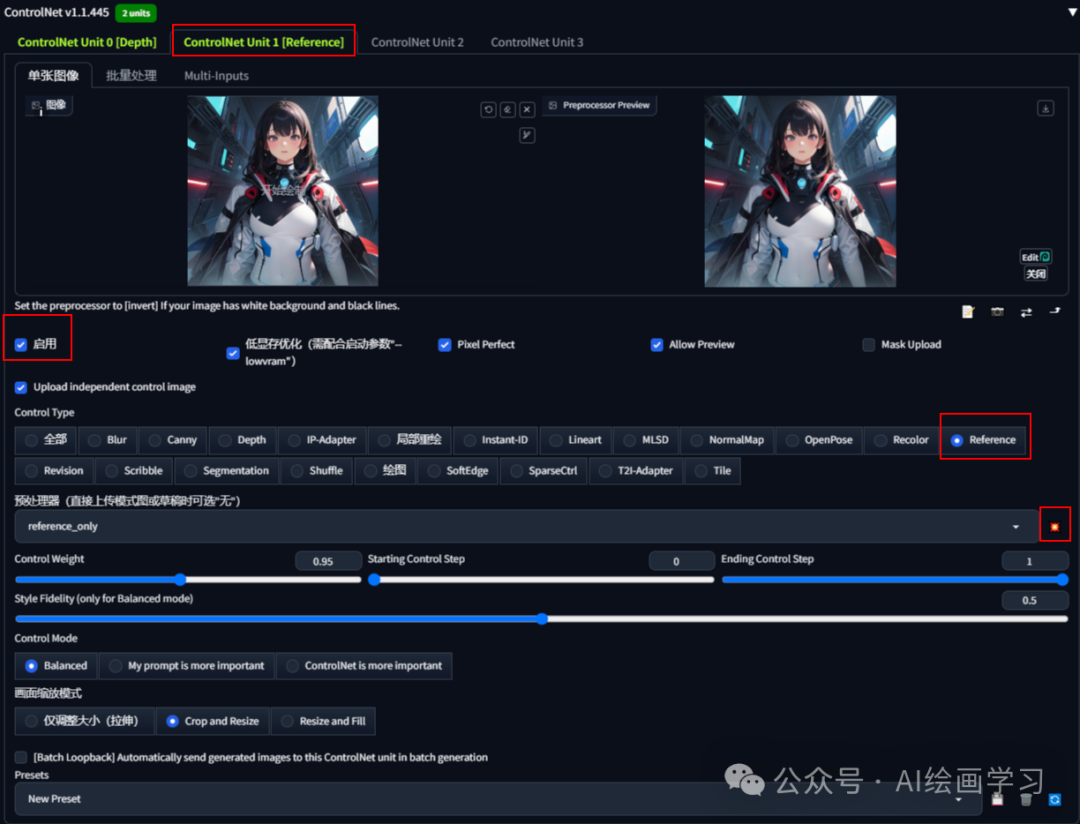

*step4 启动第二个controlnet,上传原图,并**使用Reference,配置如下图。*

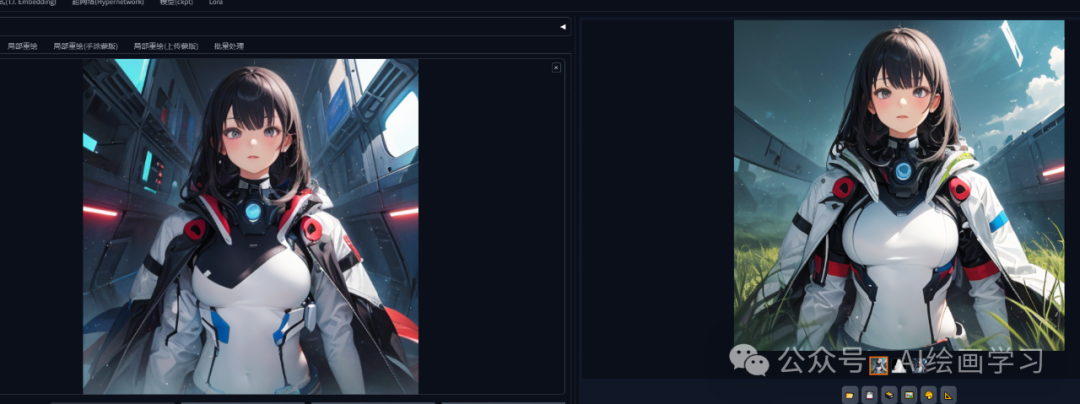

生成效果如下:

*

*

*二、**多个controlnet的组合用法*

*

*

**1更精准的图生图控制

**

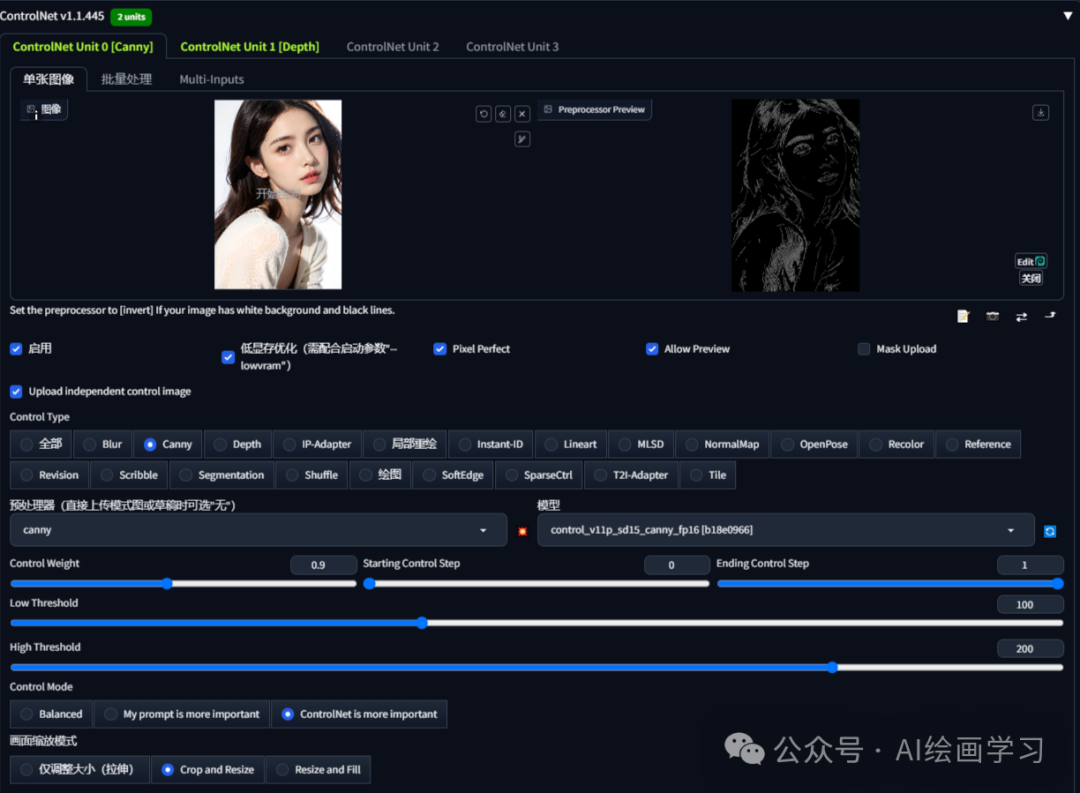

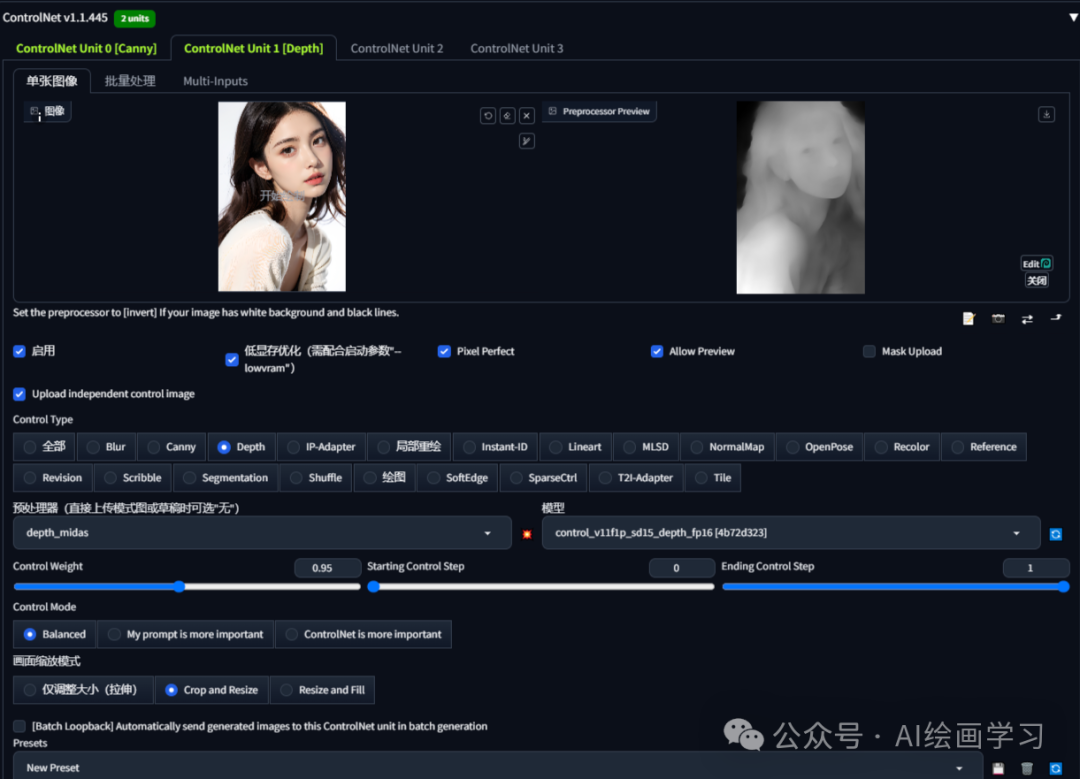

技巧是 canny+depth组合

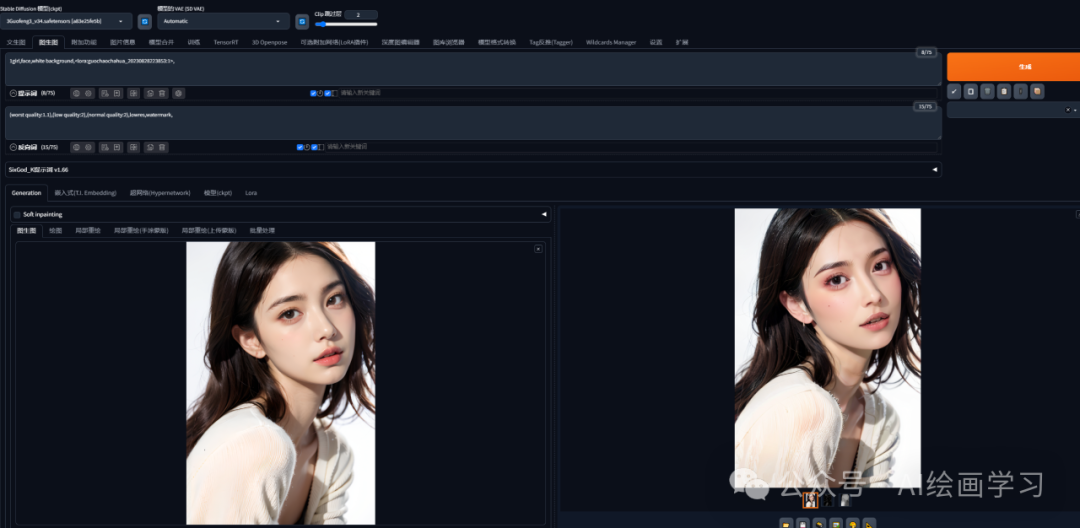

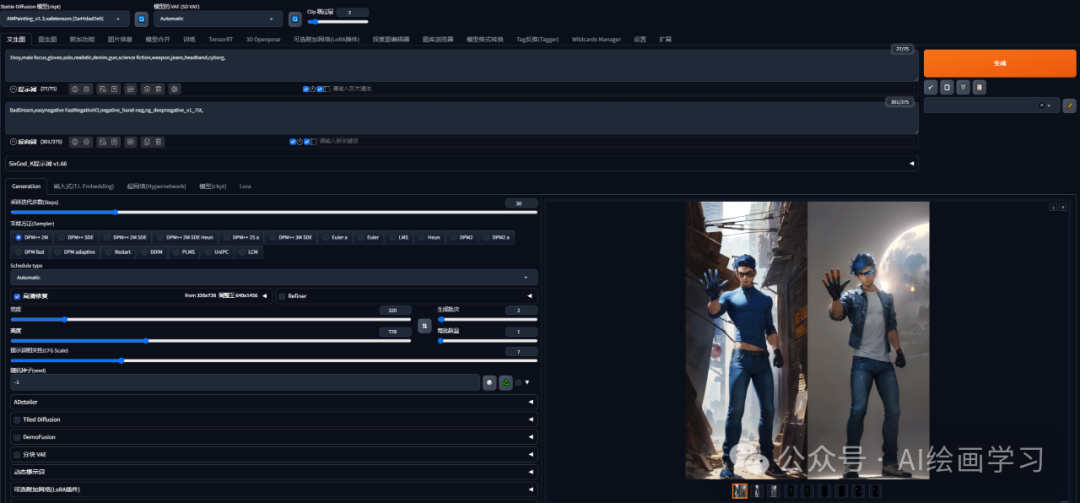

step1 图生图模式,选一个照片切换风格

切换模型或添加风格提示词或添加lora:

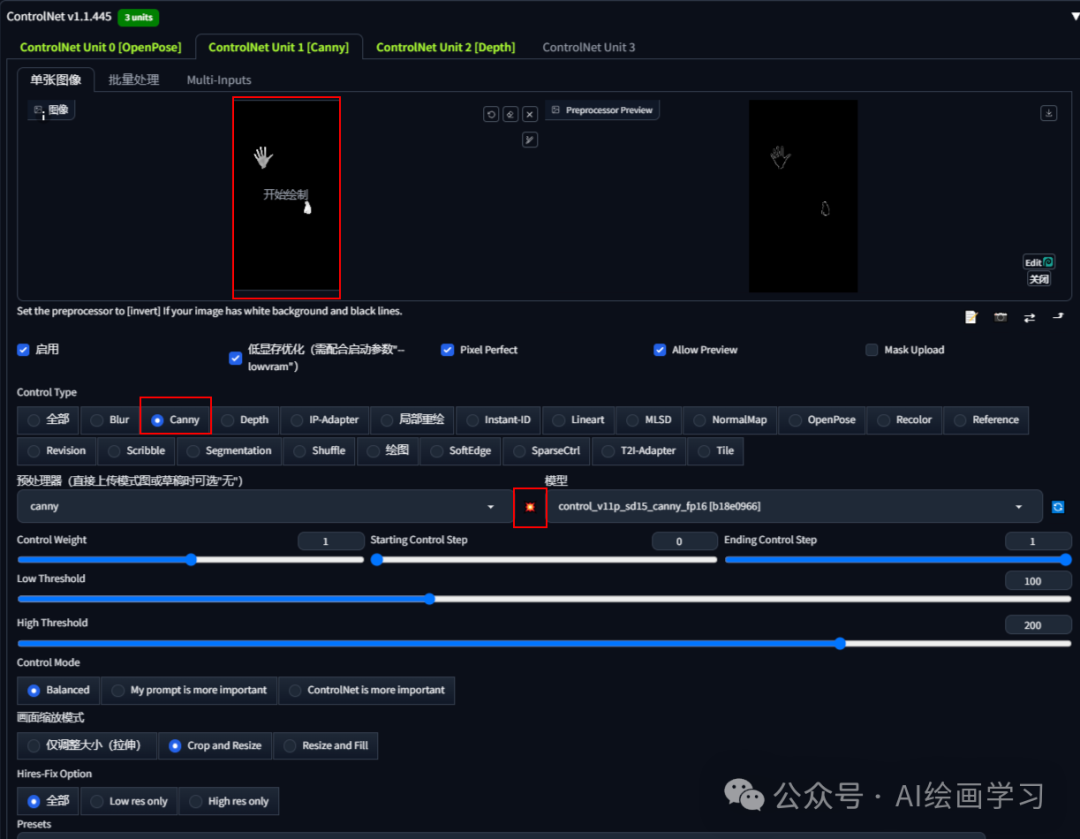

*step2* 启用1controlnet-canny

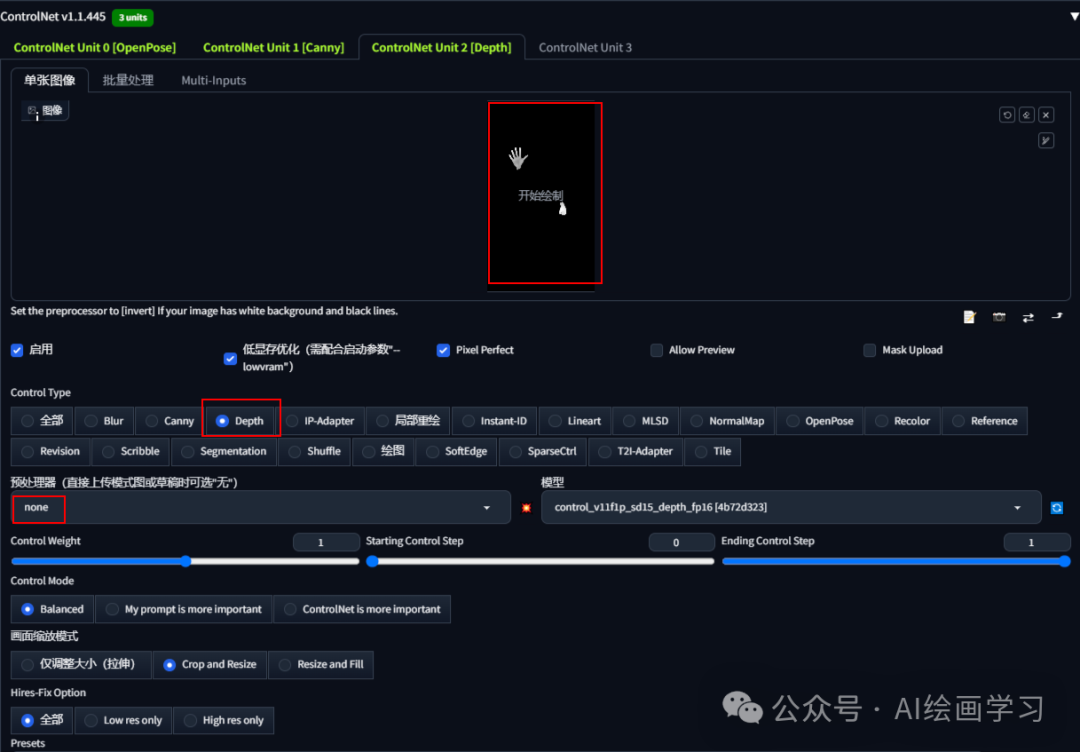

*step3 启用2controlnet-depth,生成图片*

生成不同风格,但人物造型保持了一致。

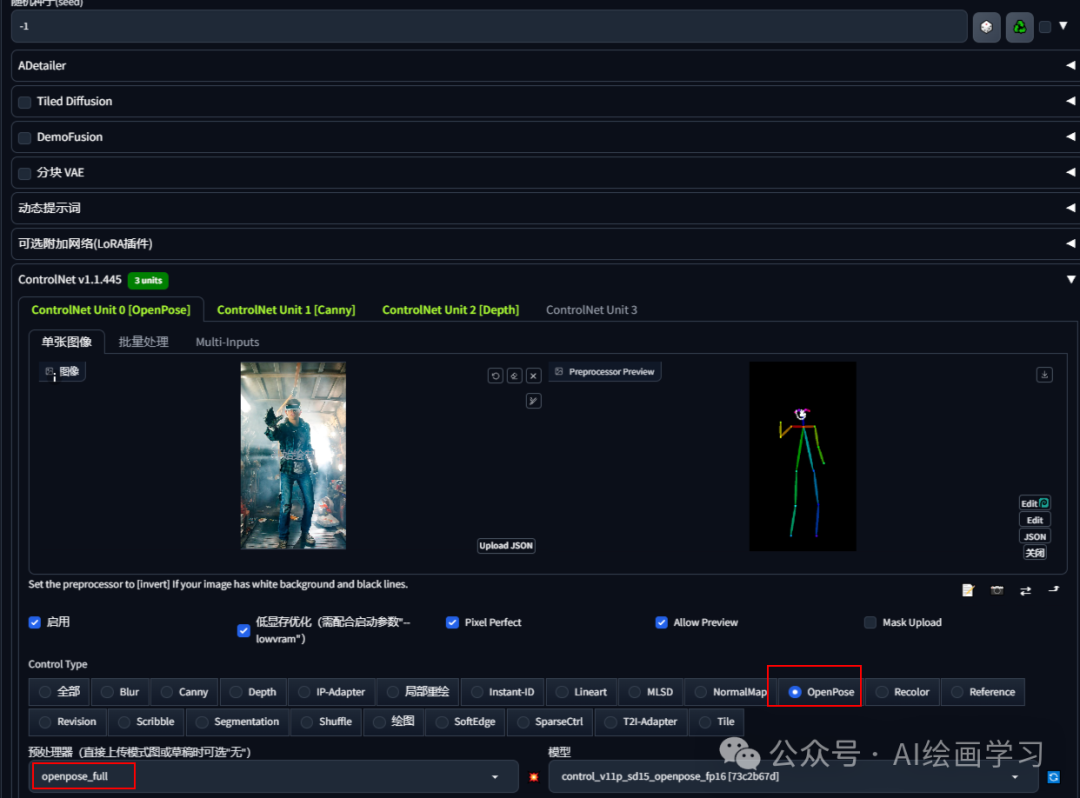

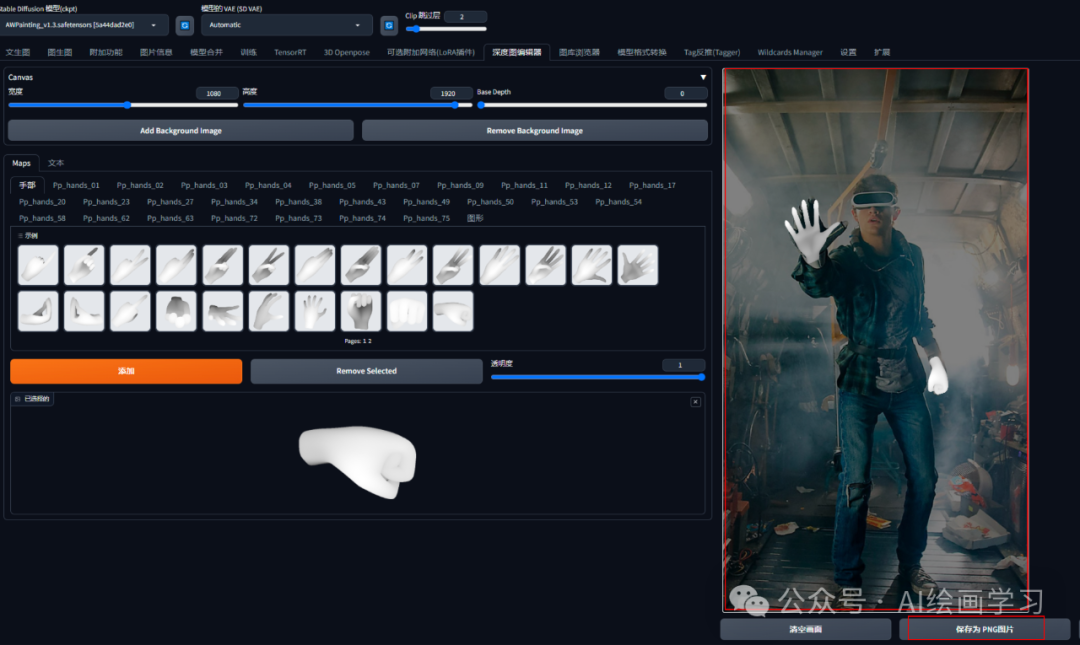

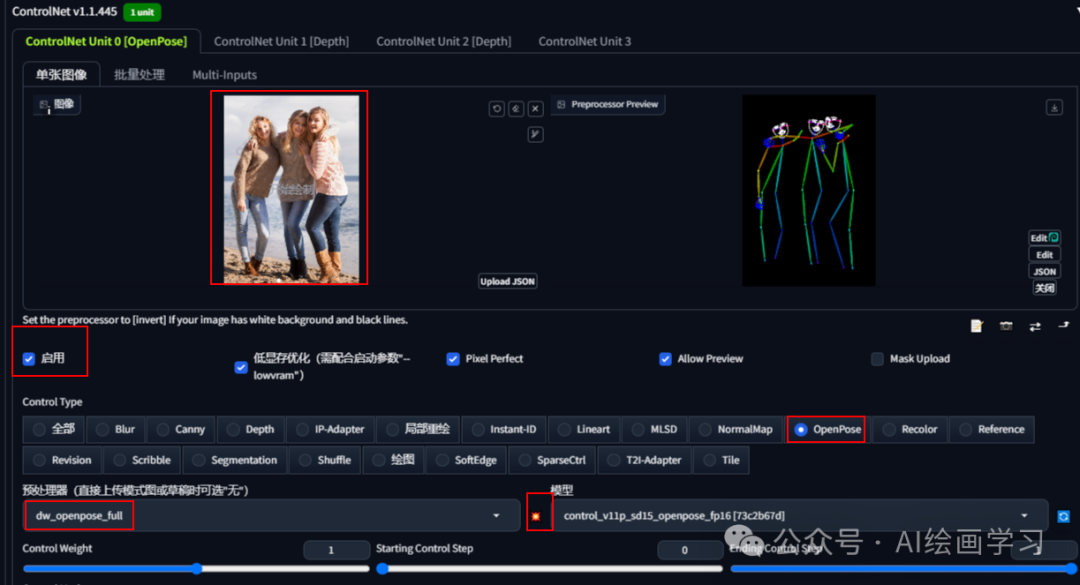

2控制手脚完美生成

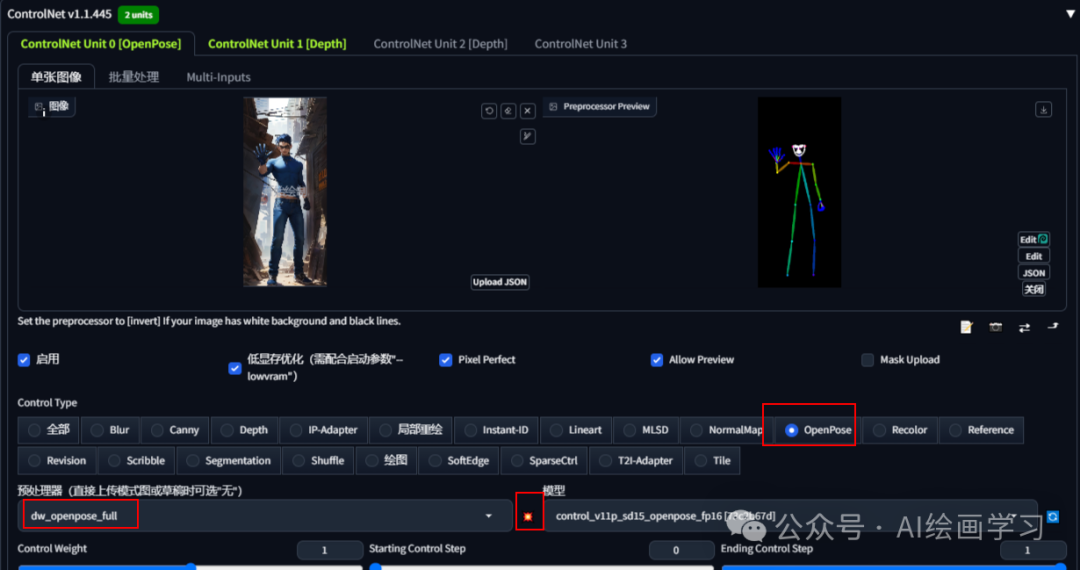

技巧是使用 openpose+canny+depth组合生成图片。

step1 启用1controlnet,选择openpose,控制人物脸部和姿态。

step2 通过插件制作手的深度图,下载图片

安装插件:深度图编辑器插件

下载地址:https://github.com/wywywywy/sd-webui-depth-lib.git

**

**

step3 启用2controlnet,选择canny,*导入手的深度图*

step4 启用2controlnet,选择depth,导入手的深度图

step5 输入关键词,生成图片

**

**

3人物和背景分别控制生成

技巧是使用。人物openpose+背景depth组合生成图片。

step1 启用1controlnet,选择openpose,控制人物脸部和姿态。

step2 启用2controlnet,选择*depth*,选择背景图片。

*step3 输入提示词,生成图片。*

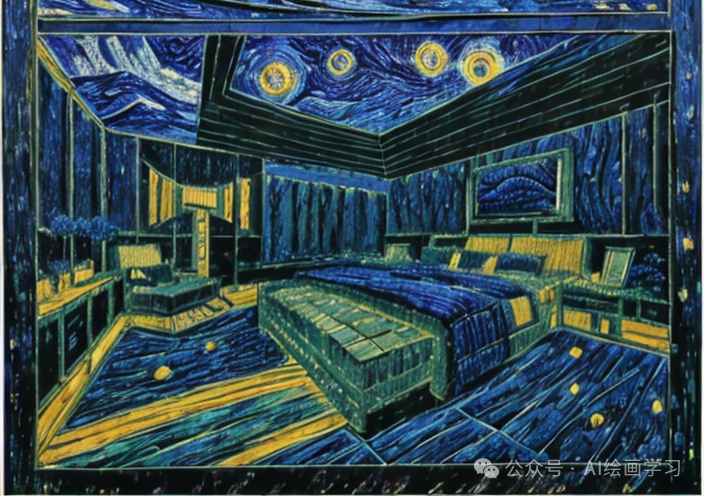

**4风格融合

**

通过风格图片+主图线稿,生成各种风格的装修风格(有点像把一张图当成lora)

*step1* 模型下载,放在*controlnet模型文件夹*:

https://huggingface.co/TencentARC/T2I-Adapter/tree/main/models

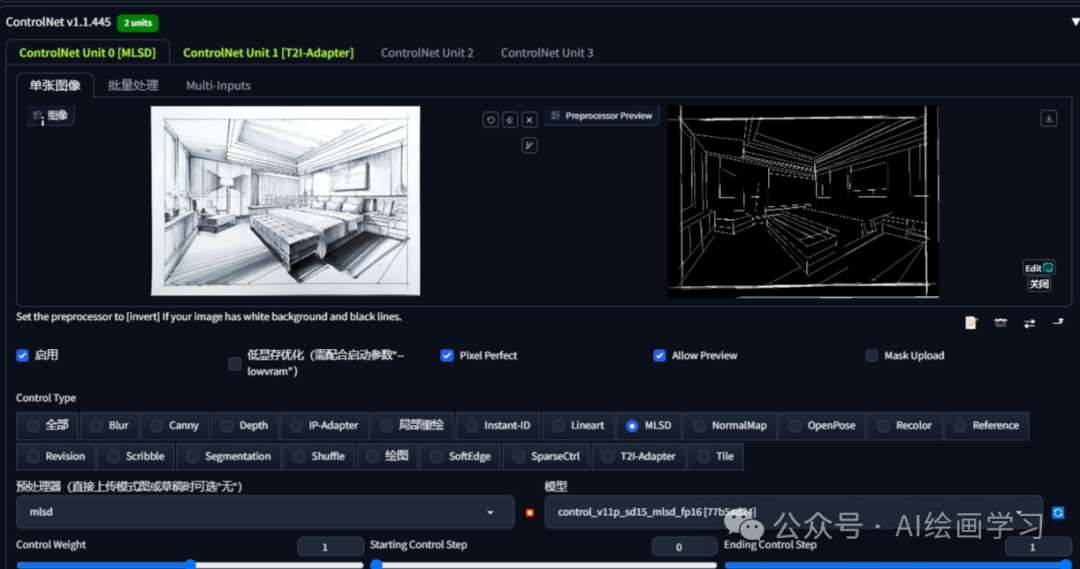

*step2* 启用1controlnet,选择canny或者MLSD,导入装修线稿**

**

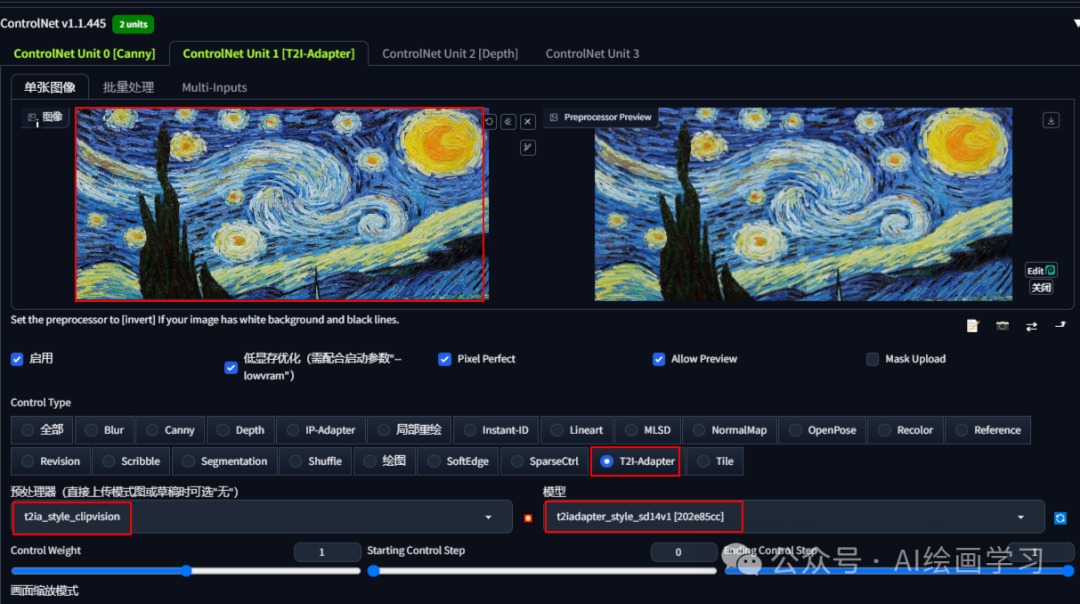

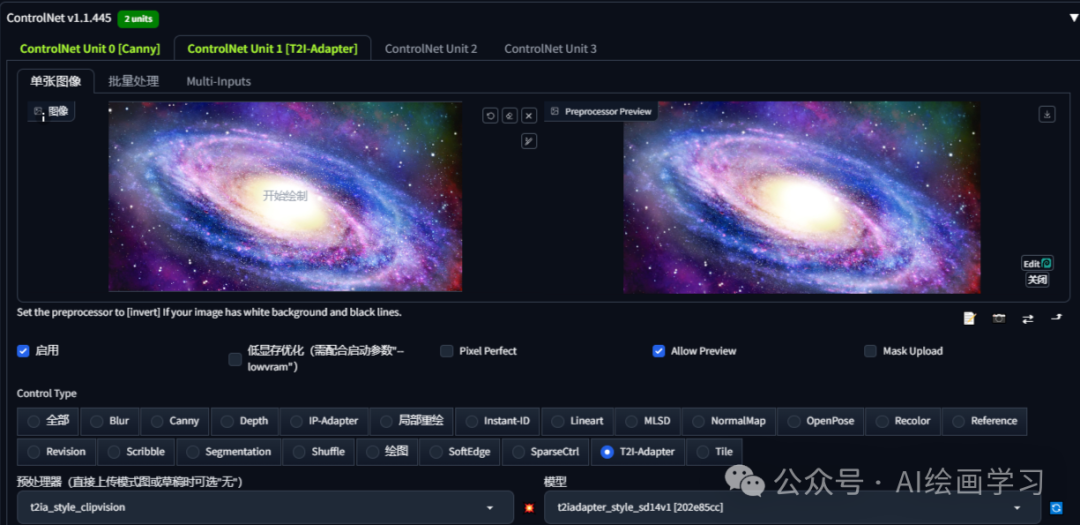

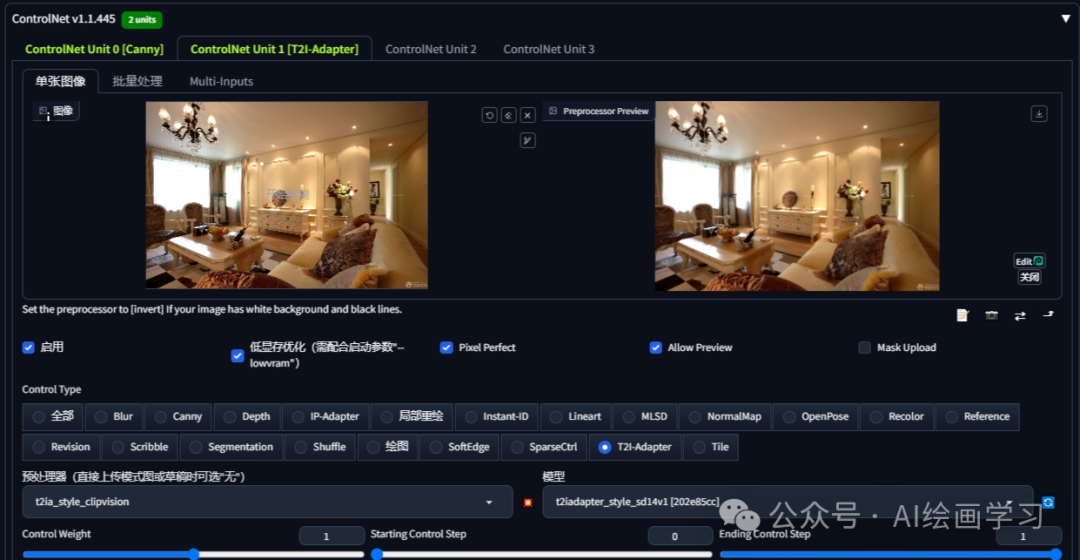

**step3*** *启用2controlnet,选******择T2I-Adapter,导******入风格图片**

**step4 不用提示词,直接生成图片****

普通线稿

无风格上色

梵高风格

宇宙风格

罗马风格

**

**

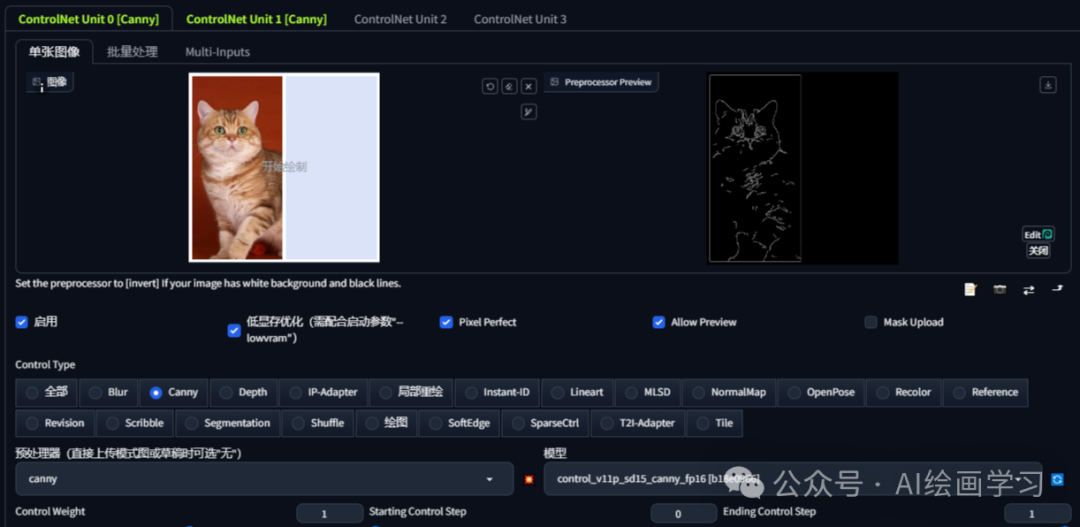

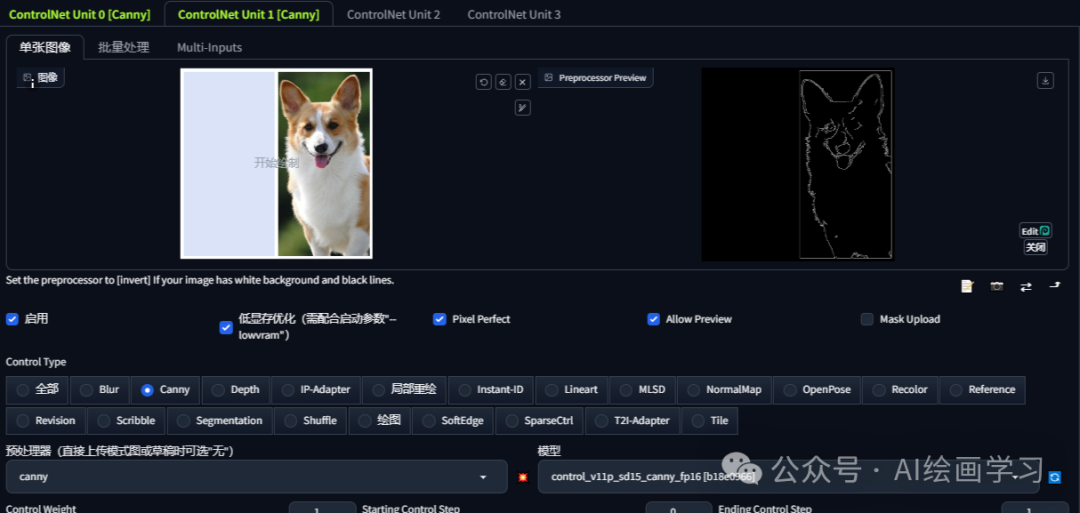

6分块控制

**同两个canny组合一张图。****

******step1**** **启用1controlnet,选择canny,导入一只猫******

******step2**** **启用2controlnet,选择canny,导入一条狗******

**

**

**三、**其他相关插件的用法

**

**

**

**

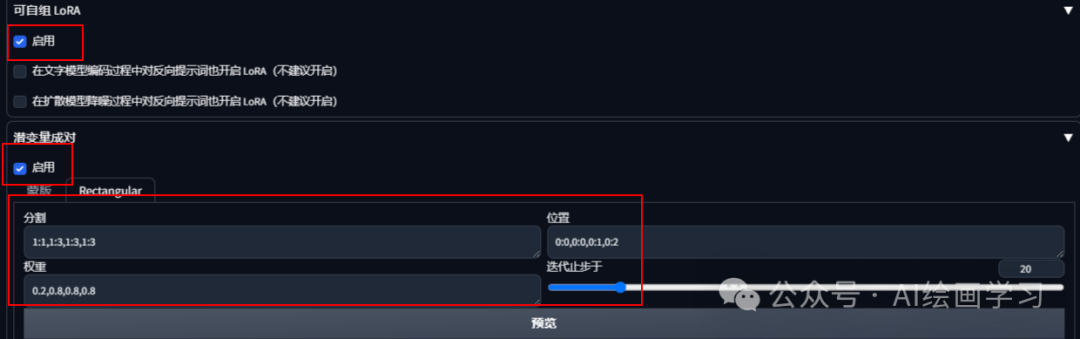

1生成多人画面更精准分块控制

技巧是通过 Latent couple、Composable LoRA、openpose插件,来控制人物数量、比例、不同人物的不同风格。

**step1 两个插件的下载地址:****

Latent couple:

https://github.com/opparco/stable-diffusion-webui-two-shot

Composable LoRA:

https://github.com/opparco/stable-diffusion-webui-composable-lora

step2 设置人物位置和比例

*step3 多人提示词写法*

*step4 设置每个人的openpose,生成图片*

* *

*

*人物都没问题了,但手指存在问题,后续详细介绍手指的修复!*

关于AI绘画技术储备

学好 AI绘画 不论是就业还是做副业赚钱都不错,但要学会 AI绘画 还是要有一个学习规划。最后大家分享一份全套的 AI绘画 学习资料,给那些想学习 AI绘画 的小伙伴们一点帮助!

感兴趣的小伙伴,赠送全套AIGC学习资料和安装工具,包含AI绘画、AI人工智能等前沿科技教程,模型插件,具体看下方。

需要的可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

一、AIGC所有方向的学习路线

AIGC所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

二、AIGC必备工具

工具都帮大家整理好了,安装就可直接上手!

三、最新AIGC学习笔记

当我学到一定基础,有自己的理解能力的时候,会去阅读一些前辈整理的书籍或者手写的笔记资料,这些笔记详细记载了他们对一些技术点的理解,这些理解是比较独到,可以学到不一样的思路。

四、AIGC视频教程合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

五、实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

这份完整版的学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

980

980

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?