今天给大家分享,利用Stable Diffusion(以下简称SD)的垫图功能,实现真人照片风格转换。

虽然SD用起来没有midjourney体验好,但是软件免费,而且可控性好,因此就选它了。

01

—

工具准备

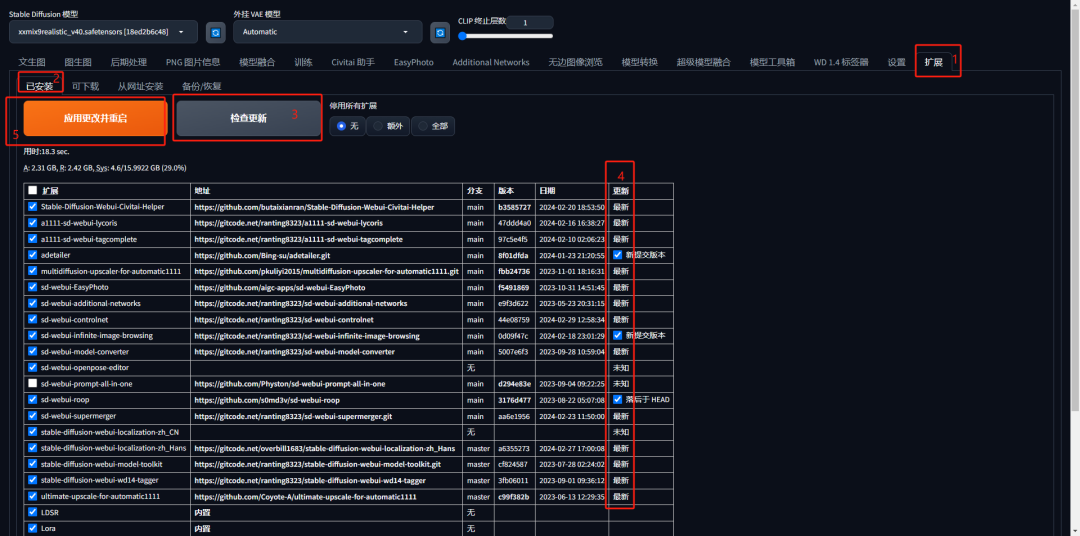

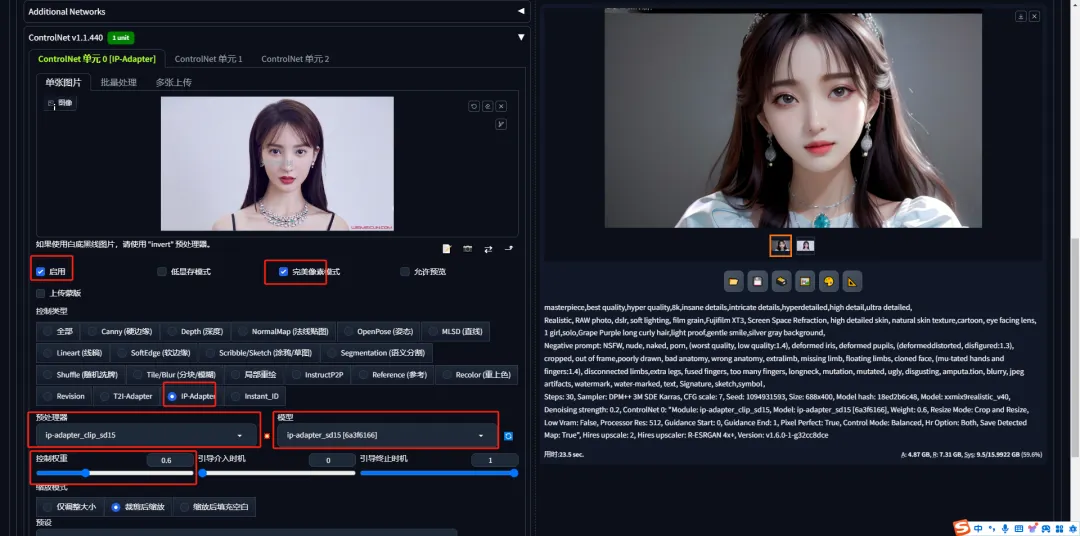

准备好SD webui工具,contronet版本要在V1.140以上,也可以直接升级到最新版本V1.440。

contronet等插件升级,依次点击SDwebui界面上的扩展,已安装,检查更新,出现升级检查进度条,然后勾选最新版本,如下图。

我们利用contronet控制类型IP-Adapter来垫图,提前下载对应模型,放入stable-diffusion-webui\models\ControlNet目录。

02

—

案例讲解

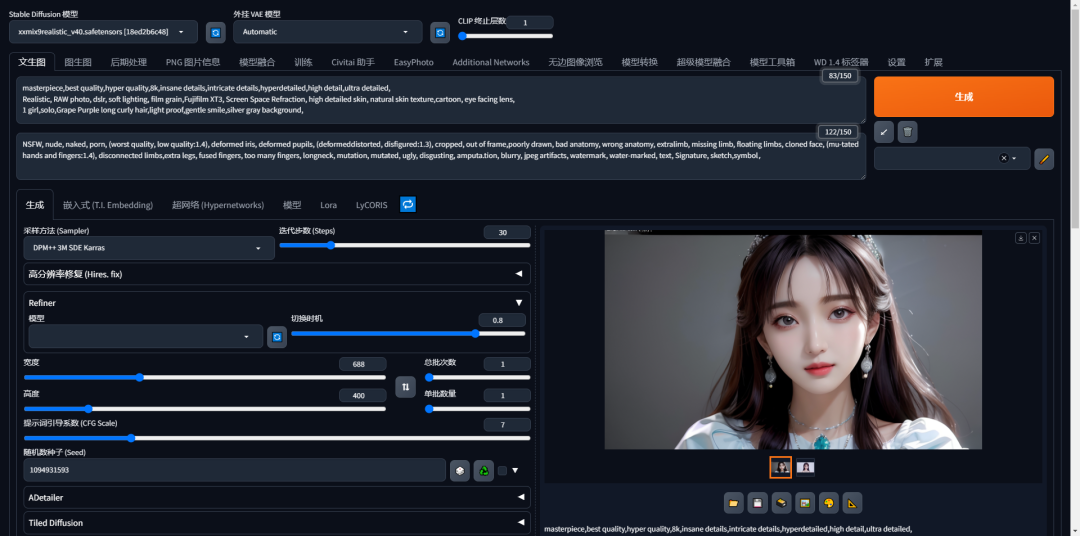

2.1 书写提示词,描述你想要的内容

模型这里选择的是大模型xxmix9realistic_v40,没有使用lora模型,

在文生图界面,第一个输入框,输入以下正向提示词,也就是你想要的内容描述:

masterpiece,best quality,hyper quality,8k,insane details,intricate details,hyperdetailed,high detail,ultra detailed,

大师级,最好画质,高品质,8K,疯狂的细节,复杂的细节,超详细的,高细节,超细节

Realistic, RAW photo, dslr, soft lighting, film grain,Fuji film XT3, Screen Space Refraction, high detailed skin, natural skin texture,cartoon,

真实感,RAW照片,dslr,柔和照明,胶片颗粒,富士胶片XT3,屏幕空间折射,高细节皮肤,自然皮肤纹理,卡通,

eye facing lens,鱼眼镜头

1 girl,solo,Grape Purple long curly hair,light proof,gentle smile,silver gray background,

1个女孩,独自,葡萄紫长卷发,耐光,温柔的微笑,银灰色背景,

第二个输入框,输入以下负向提示词,也就是你不想在AI生成图片中看到的内容,画人物一般都是通用的提示词。

NSFW, nude, naked, porn, (worst quality, low quality:1.4), deformed iris, deformed pupils, (deformed,distorted, disfigured:1.3), cropped, out of frame,poorly drawn, bad anatomy, wrong anatomy, extralimb, missing limb, floating limbs, cloned face, (mu-tated hands and fingers:1.4), disconnected limbs,extra legs, fused fingers, too many fingers, longneck, mutation, mutated, ugly, disgusting, amputa.tion, blurry, jpeg artifacts, watermark, water-marked, text, Signature, sketch,symbol,

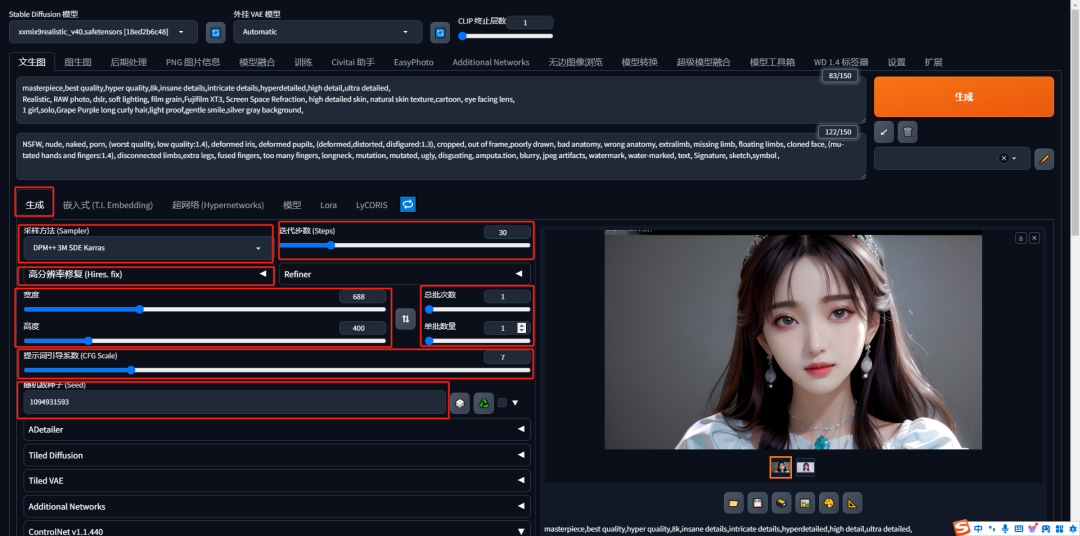

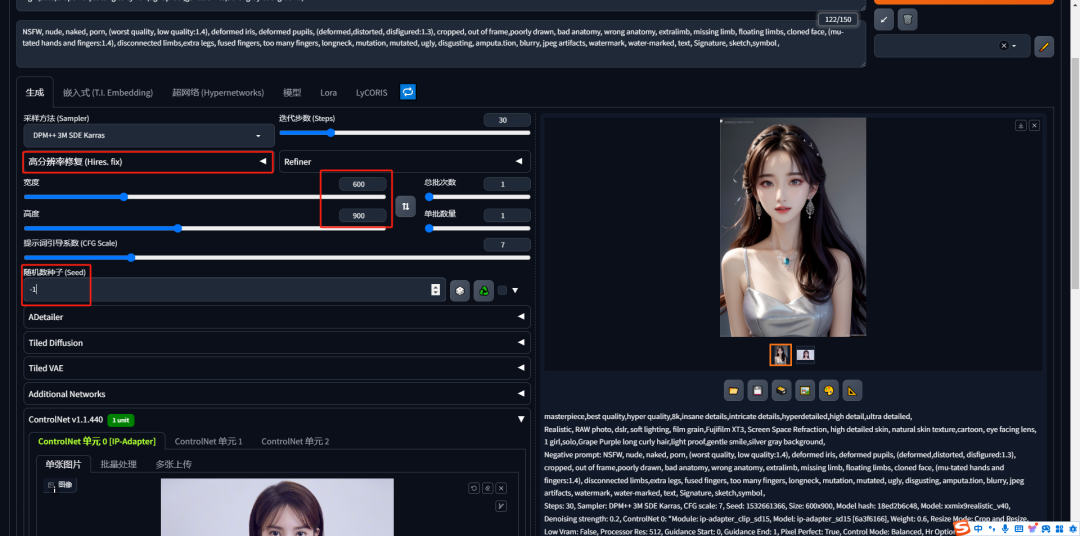

2.2 尺寸以及参数设置

采样方法sampler选择,DPM++ 3M SDE Karras,老版本可以选择DPM++ 2M SDE Karras

迭代步数steps输入30步,高分辨率修复Hires.fix先不打开(等后边生成自己满意图片再打开)

图片宽度输入688,高度输入400,后边contronet打开,拖拽图片后,也可点击向上箭头自动填充这里。

总批次数1,单批数量1,如果你想同时生成多张,也可以把总批次数改为4,单批数量1,反过来也可以

提示词引导系数CFG Scale输入7,这里值越大表示图片生成参考提示描述的权重越大,换句话就是严格按照提示词描述来生成

随机种子Seed默认是-1,这样AI会随意发挥,当你看到自己满意的图片时,把该图片的seed值复制到这里,保证图片一致性。

2.3 打开SD垫图功能

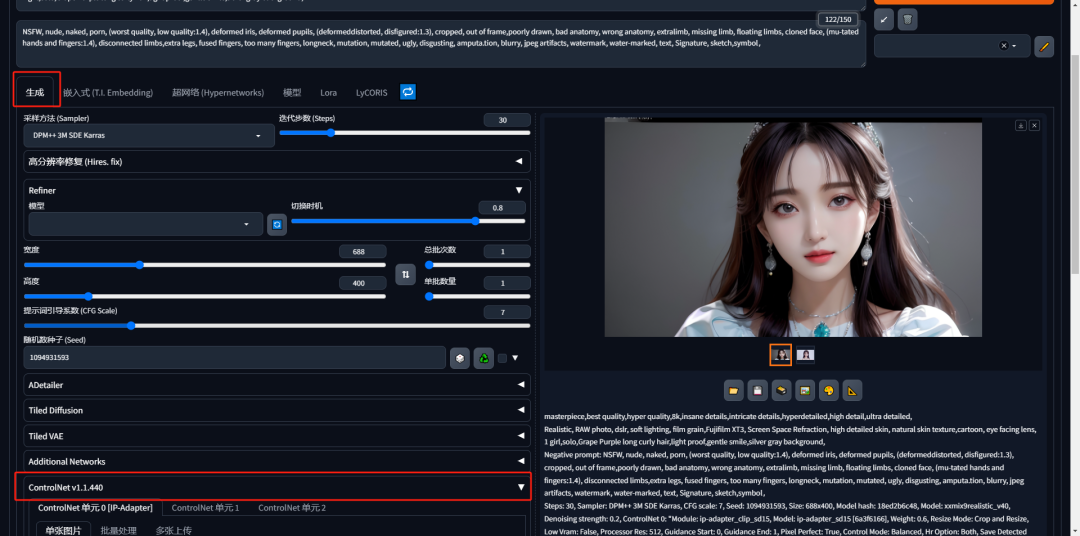

在生成界面上,向下找到contronet选项卡,点击该选项卡,选项卡自动向下打开,

可以看到有几个contronet的单元,每个单元可以利用一种控制类型,本次教程我们只选一种控制类型。

在contronet第一个单元里面,提前准备的图片(客户发给你的个人照片)拖拽进去。

可以看到会自动勾选启用,同时你要手动勾选完美像素,点击控制类型IP-Adapter。

预处理器选ip-adapter_clip_sd15,也可以选无。模型选择ip-adapter_sd15(上边提前下载好的模型)。

我这里是在网上随便找的一张金晨照片,用来模仿是客户发给你的照片,原图是这样的

利用垫图功能之后,感觉相似度还是有几分相,可调整控制权重值来影响最终成品,我的权重是0.6,生成的成品图如下

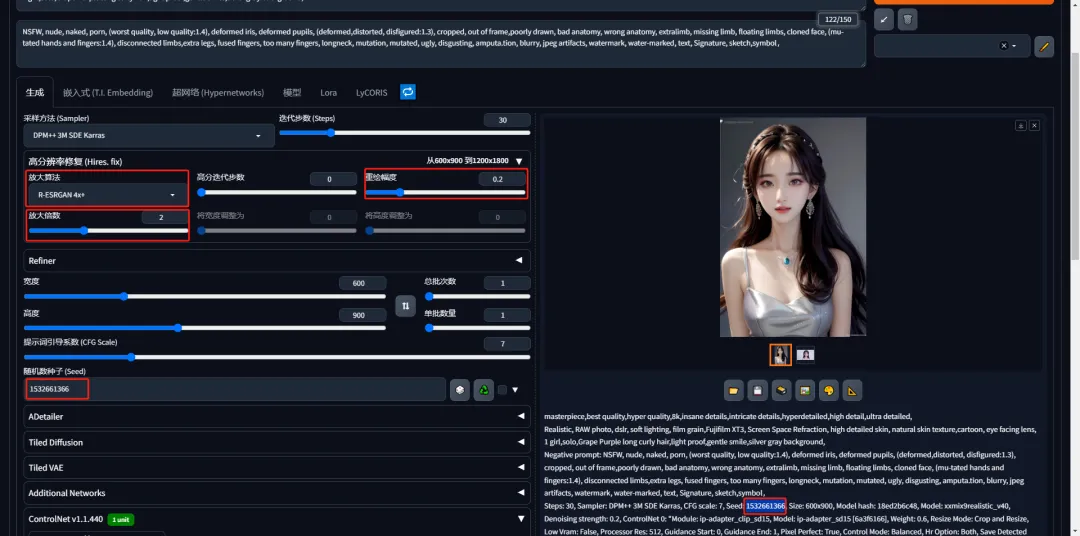

当然,你也可以把图片宽度高度调整成你想要的,比如6寸尺寸照片分辨率是12001800,开始生成时先调低分辨率除以2是600900

等你生成出自己满意的图片后,复制图片seed值,把随机中子数的-1值改为刚复制的seed值

再打开高分辨率修复Hires.fix,放大算法选R-ESRGAN 4x+,重绘幅度调到0.2,放大倍数2倍,其他参数不变

最终图片分辨率由600900放大为12001800,生成的成品效果图如下

关于AI绘画技术储备

学好 AI绘画 不论是就业还是做副业赚钱都不错,但要学会 AI绘画 还是要有一个学习规划。最后大家分享一份全套的 AI绘画 学习资料,给那些想学习 AI绘画 的小伙伴们一点帮助!

对于0基础小白入门:

如果你是零基础小白,想快速入门AI绘画是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以找到适合自己的学习方案

包括:stable diffusion安装包、stable diffusion0基础入门全套PDF,视频学习教程。带你从零基础系统性的学好AI绘画!

需要的可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

1.stable diffusion安装包 (全套教程文末领取哈)

随着技术的迭代,目前 Stable Diffusion 已经能够生成非常艺术化的图片了,完全有赶超人类的架势,已经有不少工作被这类服务替代,比如制作一个 logo 图片,画一张虚拟老婆照片,画质堪比相机。

最新 Stable Diffusion 除了有win多个版本,就算说底端的显卡也能玩了哦!此外还带来了Mac版本,仅支持macOS 12.3或更高版本。

2.stable diffusion视频合集

我们在学习的时候,往往书籍代码难以理解,阅读困难,这时候视频教程教程是就很适合了,生动形象加上案例实战,一步步带你入门stable diffusion,科学有趣才能更方便的学习下去。

3.stable diffusion模型下载

stable diffusion往往一开始使用时图片等无法达到理想的生成效果,这时则需要通过使用大量训练数据,调整模型的超参数(如学习率、训练轮数、模型大小等),可以使得模型更好地适应数据集,并生成更加真实、准确、高质量的图像。

4.stable diffusion提示词

提示词是构建由文本到图像模型解释和理解的单词的过程。可以把它理解为你告诉 AI 模型要画什么而需要说的语言,整个SD学习过程中都离不开这本提示词手册。

5.AIGC视频教程合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

这份完整版的学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

4308

4308

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?