基本卷积神经网络

AlexNet

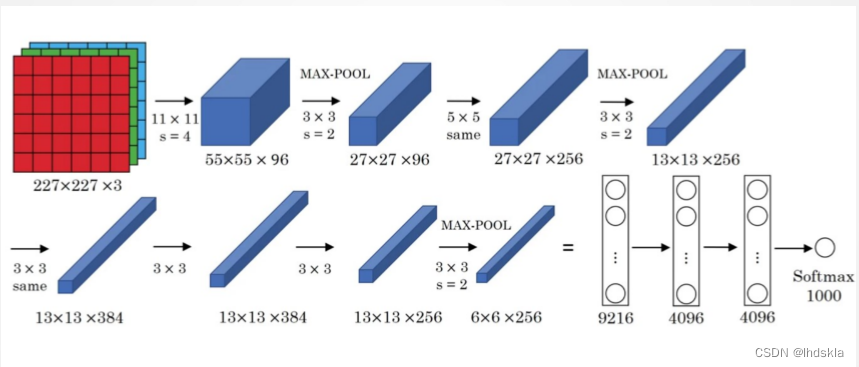

网络结构:

网络一共有8层可学习层——5层卷积层和3层全连接层。

改进:

- 池化层均采用最大池化

- 选用ReLU作为非线性环节激活函数

- 网络规模扩大,参数数量接近6000万

- 出现“多个卷积层+一个池化层”的结构

网络的普遍规律为:随网络深入,宽、高衰减,通道数增加

VGG-16

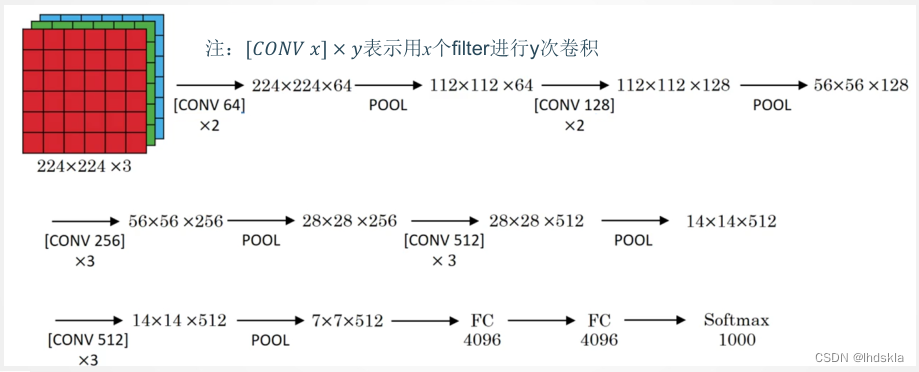

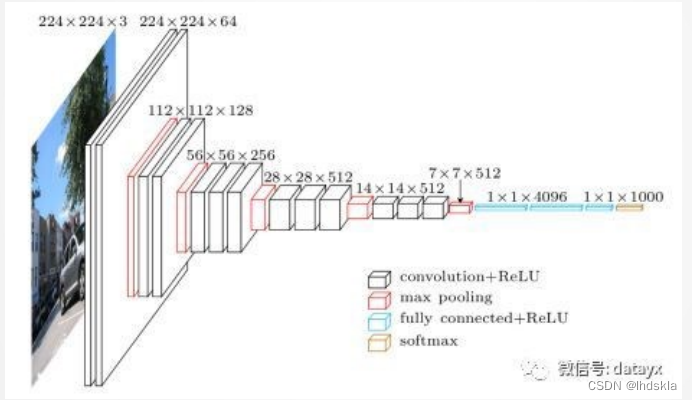

网络结构:

改进:

- 网络规模进一步增大,参数数量约为1.38亿

- 由于各卷积层、池化层的超参数基本相同,整体结构呈现出规整的特点。

普遍规律为随网络深入,高和宽衰减,通道数增多。

残差网络

残差网络(Residual Network,ResNet)是一种深度神经网络的架构,它的出现主要是为了解决深度神经网络训练过程中的梯度消失和模型退化问题。

在传统的深度神经网络中,每一层的输入都是上一层的输出,多层堆叠后,模型的表达能力会随着层数增加而增强。然而,当网络变得非常深时,会出现梯度消失和模型退化的问题。这是因为随着层数增加,梯度的反向传播会使得浅层的权重更新非常缓慢,导致浅层的特征提取能力受限,难以捕捉到复杂的特征。同时,由于深层网络中的大量参数,容易出现过拟合问题。

为了解决这些问题,残差网络采用了“跳跃连接”(skip connection)的思想,即在网络中添加了一些额外的连接,使得信息可以绕过一些层,直接传递到更深层的网络中,从而避免了梯度消失和模型退化的问题。残差网络中的跳跃连接可以通过加法或者连接的方式实现,这种连接方式能够使得模型更加深层,并且训练过程更加稳定和高效。

数据集

常用数据集

- MNIST

- Fashion-MNIST数据集

- CIFAR 10数据集

- PASCAL VOC数据集

- MS COCO数据集

- ImageNet数据集与ILSVRC

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?