pyhton 制作中文词云

偶尔看见有词云的图片,感觉挺酷炫的,今天动手研究了下。

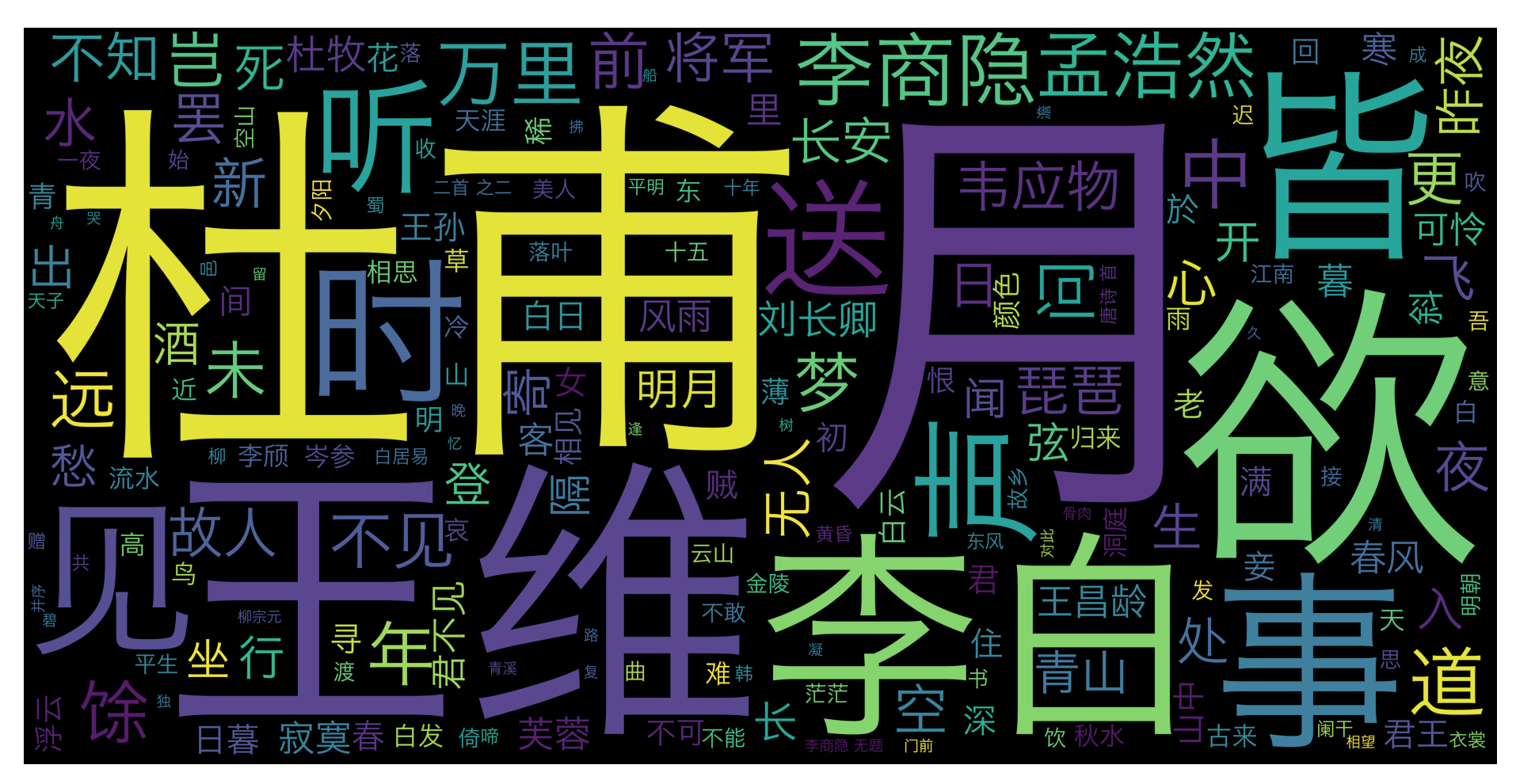

我们通过唐诗三百首的词云可以看出,诗人生活条件都比较优越,大部分都去过当时的首都长安,喜欢风花雪月,喝酒,赏月,美女和听曲,诗人这个职业非富即贵,打工人哪有闲情雅致搞吟诗做对,他们都在生活而忙碌。

主要使用了两个库,jieba, WordCloud

jieba 中文分词库,("结巴"中文分词:做最好的Python中文分词组件 “Jieba”)

为什么要用分词库,因为通常制作词云的数据都是一些文章,或者爬取的文章,都是整句的文字,我们需要把句子分词一个个词语。

WordCloud 是把分词根据算法统计出的分词出现频率,从而生成不同字体大小的词云,更多介绍可以看官网

jieba

word_cloud

http://amueller.github.io/word_cloud/index.html

一 安装jieba 和 word_cloud

- sudo pip3 install jieba

- sudo pip3 install wordcloud

二 编码代码

编码思路很简单,把想要制作词云的文章先分词,然后制作词云图片,然后保存词云图片

先看下效果吧

代码

# coding=UTF-8

import jieba

from wordcloud import WordCloud

import matplotlib.pyplot as plt

#读取唐诗

text = open("/Users/lsr/Documents/GJProject/py/ts.txt","r",encoding="gbk").read()

#去掉换行符和空格

text = text.replace('\n',"")

本文介绍了如何使用Python的jieba和WordCloud库制作中文词云。通过唐诗三百首的词云展示了诗人生活的主题,并详细说明了安装库、分词、解决编码问题以及设置背景图片的步骤。

本文介绍了如何使用Python的jieba和WordCloud库制作中文词云。通过唐诗三百首的词云展示了诗人生活的主题,并详细说明了安装库、分词、解决编码问题以及设置背景图片的步骤。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2405

2405

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?