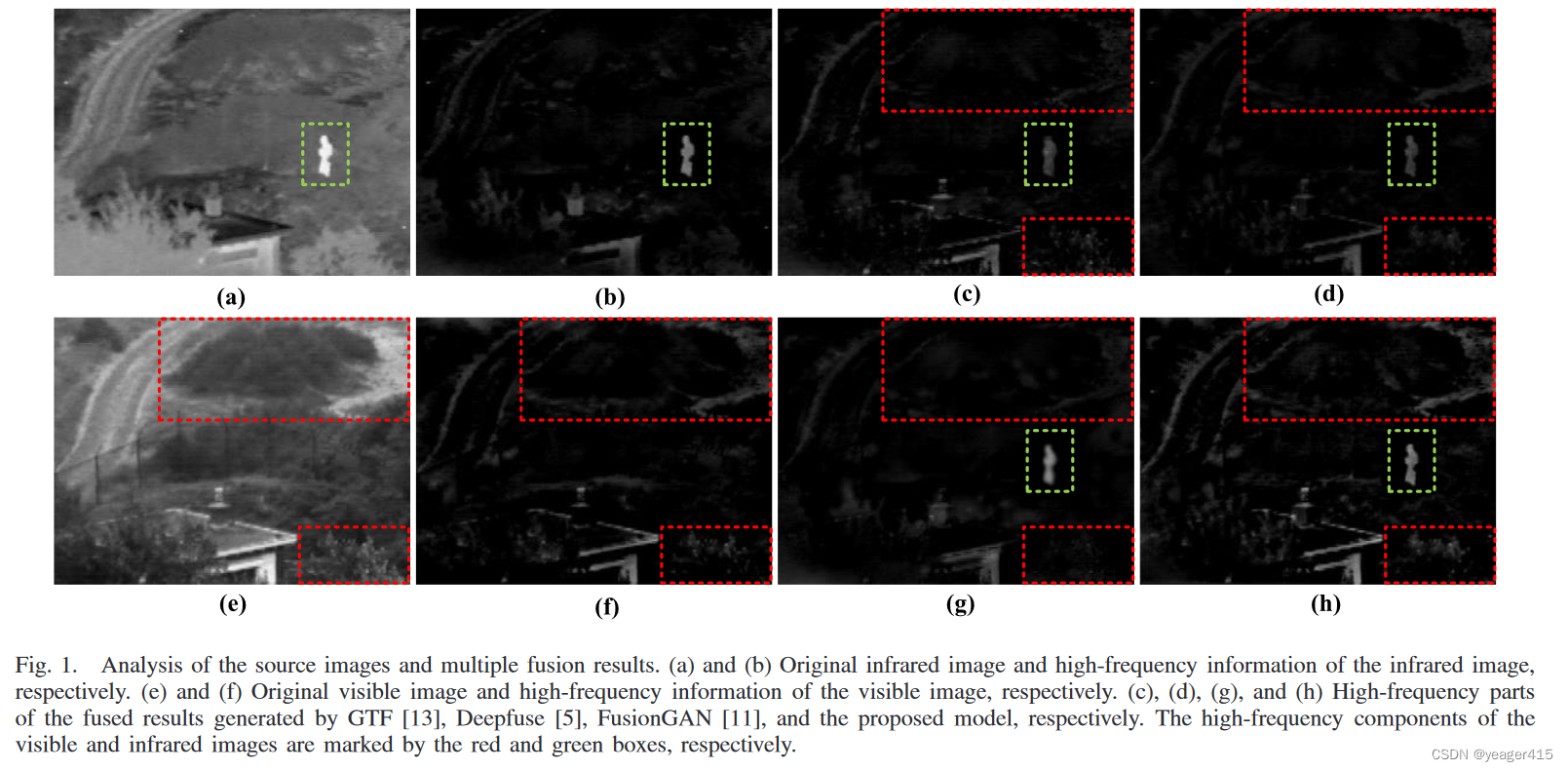

本文的特征提取和图像重建部分的网络很简单,就使用了一个U-Net+,作者分析说IVIF任务没有GT,都是通过设计损失函数来约束融合图像和源图像之间的距离,这是一种**单层一致性度量**,即最终的融合结果接近于源图像之间的折中。作者认为源图像的高频信息没有很好保留(作者在行文里先举了几个例子来说明这一点)因此作者设计了一个分支,使用傅里叶变换,即高频注意力模块获取增强的源图像,然后使用损失函数约束融合结果F和增强的源图像之间的距离,同时,设计了一个Fusion Measurement模块用于分解F得到IR和VIS,进一步和增强的源图像之间做约束,此为:Two-Level Consistency Metric

发表自TIM 2022

代码公开

Ma J.Y.组有一篇文章,输入X--->融合结果Y---->分解Xde,X和Y之间有个损失,分解的Xde和X也有一个损失。也是一个分解双约束的思想。不同的是,作者动机是保持高频部分,这里把X通过高频注意力模块增强了高频部分得到了Xen,使用Xen与Y和Xde做约束。

1、目前方法存在的问题

1)大多数方法中手动设计的融合规则过于复杂。

2)特征提取忽略了两个源图像的独特特性。因此,融合结果无法有效地保留关键信息。

3)基于表示学习的方法的性能对源图像的复杂性敏感。

作者分别展示了IR和VIS的高频部分,以及不同融合方法结果的高频部分

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3395

3395

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?