逻辑回归是一种常用于二分类问题的线性分类算法,在二分类问题中样本只有0和1两种取值,也就是说样本应该属于伯努利分布。

它的原理是将一个线性的实数范围内的数值通过sigmoid函数映射到了0-1的范围内,使得其可以得出一个样本属于正样本的概率。

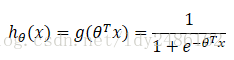

sigmoid函数的形式为:

,如下图

,如下图

我们发现sigmoid函数是一个关于(0,0.5)对称,在大于0时逐渐趋近于1,在小于0时逐渐趋近于0的函数。

若我们把 带入sigmoid函数当中,就可以把一个线性模型成功映射到0~1的范围内,而得到属于正样本的概率。(这是因为sigmoid函数是伯努利分布的指数族分布,因此可以使用其代表正样本的概率)

带入sigmoid函数当中,就可以把一个线性模型成功映射到0~1的范围内,而得到属于正样本的概率。(这是因为sigmoid函数是伯努利分布的指数族分布,因此可以使用其代表正样本的概率)

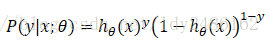

通过观测的样本,我们可以得到每个样本预测正确的概率:

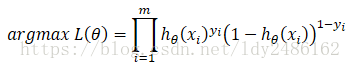

而如果我们每个样本预测正确的概率之积最大,那么我们的模型预测的效果也就越好,这就是极大似然函数:

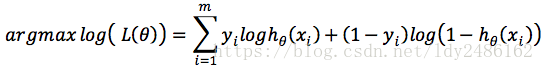

我们对这个似然函数两边取对数:

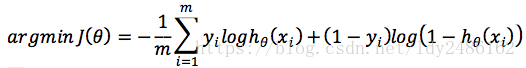

通常对于损失函数来说,我们希望损失函数的值越小,代表模型的效果越好,所以这里我们把对数似然函数进行一个变化,就可以得到我们的损失函数:

这样我们就成功把一个分类问题转化为了一个参数优化问题,在这里我们可以使用梯度下降法来求损失函数的参数θ的最优解:

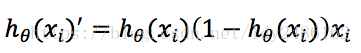

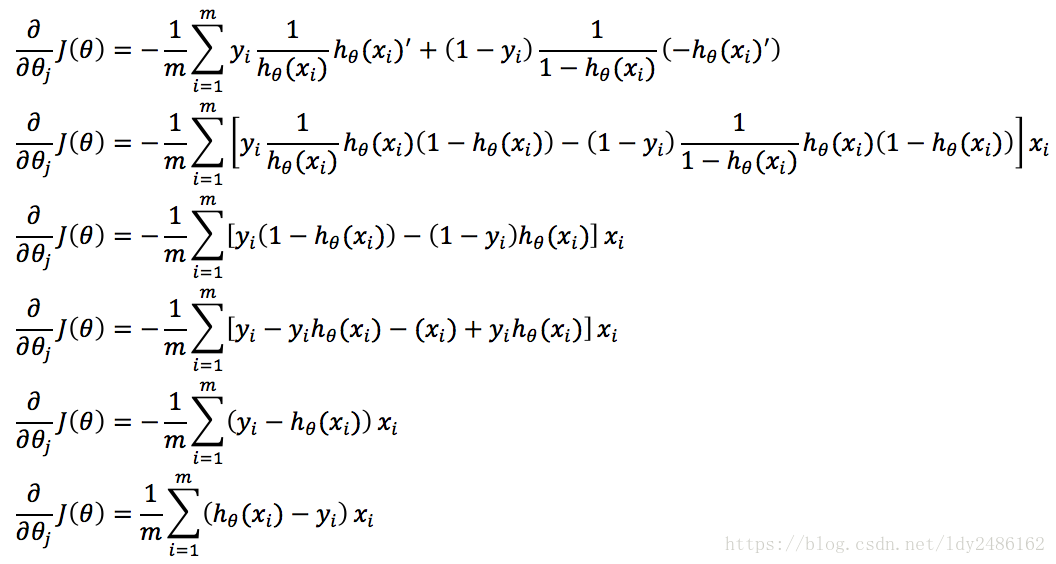

其中:

所以有:

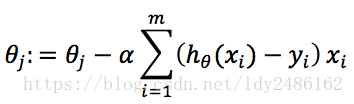

所以梯度下降的迭代公式为:

这样我们就可以通过梯度下降法得到一组参数θ,以及对应的逻辑回归模型,从而对新的样本进行分类。

逻辑回归是一种用于二分类问题的线性算法,它借助sigmoid函数将线性模型映射到0-1区间,表示样本属于正类别的概率。通过对数似然函数和梯度下降法求解最优参数,实现模型的训练与分类。

逻辑回归是一种用于二分类问题的线性算法,它借助sigmoid函数将线性模型映射到0-1区间,表示样本属于正类别的概率。通过对数似然函数和梯度下降法求解最优参数,实现模型的训练与分类。

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?