在数字化浪潮席卷全球的当下,数据已然成为驱动决策、洞察趋势的核心资产。Python 凭借其简洁的语法和丰富的第三方库,成为了网络数据采集的利器。无论是市场调研人员获取竞品信息,还是数据分析师为模型收集原始数据,Python 爬虫都能大显身手。接下来,就让我们开启从入门到精通的 Python 爬虫学习之旅。

入门篇:夯实基础,开启爬虫之门

爬虫基础概念

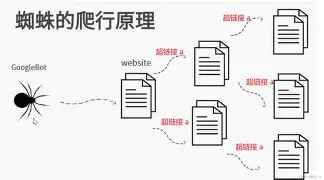

爬虫,简单来说,就是一种按照一定的规则,自动抓取万维网信息的程序或者脚本。它的作用广泛,涵盖数据采集、信息检索、市场调研等多个领域。例如,电商平台通过爬虫抓取竞品价格,以便调整自身定价策略;学术机构利用爬虫收集文献资料,辅助研究工作。

爬虫的工作流程主要分为四步:首先,向目标网站发送请求,告知服务器我们想要获取的数据;接着,接收服务器返回的响应,这通常是包含网页内容的 HTML、XML 等格式的数据;然后,对响应内容进行解析,梳理出其中的结构和信息;最后,提取我们需要的数据,完成一次数据采集。

根据功能和应用场景的不同,爬虫可分为通用爬虫、聚焦爬虫和增量式爬虫。通用爬虫就像一个 “网络搬运工”,广泛抓取互联网上的各种信息,搜索引擎的网络爬虫大多属于此类;聚焦爬虫则更有针对性,只抓取与特定主题相关的内容,常用于垂直领域的数据收集;增量式爬虫专注于抓取网站更新的内容,避免重复抓取,节省资源。

Python 基础回顾

Python 作为爬虫开发的核心语言,其基础语法是我们必须掌握的。变量用于存储数据,Python 支持多种数据类型,如整数、浮点数、字符串、列表、字典等。控制流语句,如 if - else 条件判断、for 和 while 循环,帮助我们实现程序的逻辑控制。函数则可以将重复使用的代码块封装起来,提高代码的复用性。

Python 的标准库是其强大功能的重要组成部分。os 模块提供了与操作系统交互的功能,如文件和目录的操作;sys 模块用于访问 Python 解释器的变量和函数;time 模块则可以处理时间相关的操作,例如设置爬虫的请求间隔,避免对网站造成过大压力。

网络基础与 HTTP 协议

网络通信依赖于一系列协议,其中 HTTP 协议是爬虫与网页交互的关键。HTTP 请求方法中,GET 常用于获取资源,POST 则用于向服务器提交数据。状态码用于表示请求的处理结果,常见的 200 表示请求成功,404 表示资源未找到,500 表示服务器内部错误。请求头和响应头包含了请求和响应的附加信息,如客户端信息、缓存控制等。

URL(统一资源定位符)是网页的地址,它由协议、域名、路径等部分组成。通过构造正确的 URL,我们可以向服务器请求特定的网页资源,这是爬虫获取数据的第一步。

HTML 与 CSS 基础

HTML 是网页的骨架,它通过各种标签(如 <html>、<body>、<div> 等)和属性来定义网页的结构和内容。DOM(文档对象模型)则将 HTML 文档转化为树形结构,方便我们对网页元素进行操作。

CSS 用于美化和布局网页,它通过选择器(如标签选择器、类选择器、ID 选择器)来选中 HTML 元素,并为其设置样式。掌握 CSS 选择器,对于后续使用爬虫解析网页、定位数据至关重要。

基础爬虫库的使用

Requests 库是发送 HTTP 请求的得力助手。发送 GET 请求只需一行代码:

import requests

response = requests.get('https://example.com')发送 POST 请求时,可通过 data 参数传递数据:

TypeScript取消自动换行复制

data = {'key': 'value'}

response = requests.post('https://example.com', data=data)

BeautifulSoup 库能轻松解析 HTML 或 XML 数据。例如,从响应内容中提取所有链接:

from bs4 import BeautifulSoup

soup = BeautifulSoup(response.text, 'html.parser')

links = [link.get('href') for link in soup.find_all('a')]re 库利用正则表达式从文本中提取特定模式的数据。比如,提取文本中的所有邮箱地址:

import re

text = "Contact me at example@example.com or another@example.org"

emails = re.findall(r'[\w\.-]+@[\w\.-]+\.\w+', text)进阶篇:突破瓶颈,深入爬虫核心

动态网页处理

随着前端技术的发展,动态网页越来越常见。这类网页通过 JavaScript 和 AJAX 技术实现内容的动态加载,传统的爬虫方法无法直接获取动态生成的数据。

Selenium 库可以模拟浏览器行为,解决动态网页的抓取问题。以 Chrome 浏览器为例,启动浏览器并打开网页:

from selenium import webdriver

driver = webdriver.Chrome()

driver.get('https://example.com')还可以模拟用户操作,如点击按钮、输入文本等,等待页面加载完成后,再提取数据。

爬虫框架的应用

Scrapy 框架是 Python 爬虫领域的佼佼者。它采用了模块化的架构,包含 Spider(定义爬取逻辑)、Item(定义数据结构)、Pipeline(处理数据存储等后续操作)、Middleware(处理请求和响应的中间件)等组件。

创建一个 Scrapy 项目:

scrapy startproject myproject在项目中编写 Spider 类,定义如何从网页中提取数据。除了 Scrapy,PySpider 等框架也各有特色,PySpider 具有可视化操作界面,适合快速开发小型爬虫项目,而 Scrapy 在处理大规模、复杂的爬虫任务时更具优势。

异步编程

asyncio 库是 Python 异步编程的核心,它引入了协程和事件循环的概念。协程可以理解为一种轻量级的线程,通过 async 和 await 关键字实现异步操作。

结合 aiohttp 库进行异步 HTTP 请求,能大幅提高爬虫效率:

import asyncio

import aiohttp

async def fetch(session, url):

async with session.get(url) as response:

return await response.text()

async def main():

urls = ['https://example1.com', 'https://example2.com']

async with aiohttp.ClientSession() as session:

tasks = [fetch(session, url) for url in urls]

results = await asyncio.gather(*tasks)

print(results)

asyncio.run(main())反爬虫技术与应对策略

网站为了保护自身数据和服务器资源,会采用多种反爬虫机制。IP 封锁会限制频繁访问的 IP 地址;验证码用于区分人类和机器;请求频率限制防止爬虫过度抓取;User - Agent 检测则通过识别客户端信息来判断是否为爬虫。

应对这些机制,可以使用代理服务器切换 IP,在请求之间设置随机延迟避免频率过高,伪装 User - Agent 模拟正常浏览器请求。对于验证码,可采用 OCR 技术或第三方打码平台解决。但需要强调的是,爬虫行为必须遵守法律法规和网站规则,合法合规地获取数据。

高级篇:拓展边界,攀登爬虫高峰

分布式爬虫

当需要处理大规模数据采集任务时,分布式爬虫应运而生。它将爬虫任务分散到多个节点上执行,提高采集效率。Redis 作为常用的中间件,可用于存储待抓取的 URL 队列和已抓取的状态信息。

结合 Scrapy - Redis,修改 Scrapy 的配置文件,即可搭建分布式爬虫架构。不同节点从 Redis 中获取任务,完成后将结果存储回 Redis 或其他存储系统。

APP 爬取

APP 逆向爬虫是针对移动应用的数据采集技术。对于 Android 应用,可以使用 Apktool 等工具进行反编译,分析其代码和资源文件。通过抓包工具(如 Charles、Fiddler)捕获 APP 的网络请求,了解数据传输机制和 API 接口。

在 iOS 平台上,同样可以利用反编译工具和抓包技术,分析应用的请求逻辑,进而编写专门的爬虫代码获取数据。

数据清洗与分析

爬取到的数据往往存在无效信息、缺失值和异常值,需要使用 pandas 库进行清洗和预处理。例如,删除重复数据:

import pandas as pd

data = pd.read_csv('data.csv')

data = data.drop_duplicates()处理缺失值:

data = data.fillna(0)清洗后的数据可通过数据挖掘和分析方法,如描述性统计、相关性分析等,挖掘其中的价值。使用 matplotlib、seaborn 等库进行数据可视化,能更直观地展示数据特征和规律。

性能优化与代码规范

提高爬虫性能可以从多个方面入手。优化请求策略,如减少不必要的请求;使用连接池管理 HTTP 连接,避免频繁创建和销毁连接;选择合适的数据结构,如使用集合存储不重复的 URL,提高查询效率。

同时,编写规范的代码有助于提高代码的可维护性。遵循代码缩进、命名规范,合理封装函数和划分模块,添加清晰的注释,方便自己和他人理解代码逻辑。

实战篇:学以致用,开启爬虫实战之旅

实战项目案例

以电商网站数据爬取为例,首先进行需求分析,明确需要抓取的商品信息,如名称、价格、销量等。然后设计方案,选择合适的爬虫技术,如使用 Scrapy 框架配合 Selenium 处理动态加载的页面。

在代码实现过程中,编写 Spider 类解析网页,使用 Item 定义数据结构,通过 Pipeline 将数据存储到数据库中。在这个过程中,可能会遇到反爬虫机制的阻碍,需要灵活运用应对策略解决问题。

项目部署与维护

将爬虫项目部署到服务器上,可以保证其持续稳定运行。首先搭建服务器环境,安装 Python 及相关依赖库。然后将代码部署到服务器,可使用 Git 进行版本管理。

通过定时任务工具(如 Cron、Airflow)设置爬虫的执行时间,实现定期抓取数据。同时,配置日志记录,记录爬虫的运行状态和错误信息,便于及时发现和解决问题。

为助力你进一步深入学习 Python 爬虫,这里精心整理了一系列实用学习链接,涵盖从基础入门到高阶进阶的丰富资源:

- 基础学习平台

- 菜鸟教程:Python3 教程 | 菜鸟教程 ,提供 Python 基础语法、数据类型、函数等知识,配合代码示例,助你快速入门 Python,为爬虫学习筑牢根基。

- W3School Python 教程:Python 教程 ,以简洁明了的方式讲解 Python 基础,结合在线代码编辑环境,方便即时实践,加深对知识的理解。

- 爬虫专项学习

- 《Python 爬虫入门教程》 - 慕课网:UI动效基础与实践-慕课网 ,系统介绍爬虫基础概念、工作流程,细致讲解

Requests、BeautifulSoup等库的使用,搭配实战项目,让你逐步掌握爬虫开发技巧。 - 《Python 网络爬虫从入门到实践》 - 网易云课堂:出错啦 - 网易云课堂 ,从网络基础、HTTP 协议讲起,深入剖析静态和动态网页爬取,涵盖反爬虫应对策略,通过丰富案例提升实践能力。

- 《Python 爬虫入门教程》 - 慕课网:UI动效基础与实践-慕课网 ,系统介绍爬虫基础概念、工作流程,细致讲解

- 综合学习社区

- 优快云:https://www.youkuaiyun.com/ ,搜索 “Python 爬虫”,能获取海量教程、技术文章和经验分享,社区活跃,可随时交流问题、获取帮助。

- 知乎:知乎 - 有问题,就会有答案 ,在知乎搜索 “Python 爬虫” 话题,能看到诸多优质回答,包含学习路径、项目经验、技术探讨等,拓宽学习视野。

- 官方文档

- Python 官方文档:3.13.5 Documentation ,全面介绍 Python 语言特性、标准库等,是学习 Python 最权威的资料。

- Requests 库官方文档:Requests: HTTP for Humans™ — Requests 2.32.4 documentation ,深入了解

Requests库的各种功能和使用方法。 - BeautifulSoup 库官方文档:Beautiful Soup 4.12.0 文档 — Beautiful Soup 4.12.0 documentation ,详细掌握

BeautifulSoup库解析和提取数据的技巧。 - Scrapy 框架官方文档:Scrapy 2.13 documentation — Scrapy 2.13.2 documentation ,全面学习

Scrapy框架的架构、组件使用和项目开发。

总结与展望

从爬虫基础概念到高级应用,再到实战项目,我们系统地学习了 Python 爬虫的知识和技能。每个阶段都有其核心要点,从基础库的使用到框架的应用,从应对反爬虫到性能优化,这些知识共同构成了 Python 爬虫的完整体系。

随着技术的不断发展,爬虫技术也将迎来新的变革。人工智能与爬虫的结合,将使爬虫具备更智能的信息识别和处理能力;在隐私保护和数据安全日益重要的背景下,如何在合法合规的前提下进行数据采集,也将成为爬虫技术发展的重要方向。希望读者能够保持学习热情,不断探索爬虫技术的新领域,在数据的海洋中挖掘更多有价值的信息。

以上涵盖了 Python 爬虫全流程知识。若你对某个部分想深入了解,或有修改补充需求,欢迎随时和我说。

7546

7546

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?