解决思路:

1. 首先利用结巴分词对用户的输入做名词实体挖掘处理,目的是为了挖掘出客户想要寻找的那个对象。

在试验的过程中你可能会发现jieba并不能很好的分辨出你想要的对象,这时你需要定义自己的名词实体。

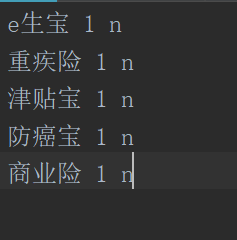

如上图所示,第一列是你想新增的实体名词,第是词频,第3列是词性,n表示名词

jieba.load_userdict("add_dict.txt")print(jieba.analyse.extract_tags(sentence1, topK=1, withWeight=True, allowPOS=('n')))import jieba

jieba.load_userdict("add_dict.txt")

sentence1 = 'e生宝的购买流程是什么样的。'

print(jieba.analyse.extract_tags(sentence1, topK=1, withWeight=True, allowPOS=('n')))通过上面的方式就可以识别出你关注的实体名词了。

但是上面的方式有个问题,如果句子出现其他名词,它的评分要高于你想要的名词,这种情况可能会出现误选。

还有种方式是,利用jieba的分词功能,将句子做分词处理,得到词数组。提前准备要自己的名词实体库,存放在字典A中。

遍历词数组中的词,若存在字典A中就是目标词。

2. 将剩余句子中的词和实体的属性做相识度匹配,匹配到的属性就是返回给用户的答案了。

<

本文探讨了jieba分词库的原理及应用,包括使用前缀树和朴素贝叶斯思想进行分词,以及TF-IDF算法进行名词实体识别。同时,对比了条件随机场(CRF)在实体识别上的优势。

本文探讨了jieba分词库的原理及应用,包括使用前缀树和朴素贝叶斯思想进行分词,以及TF-IDF算法进行名词实体识别。同时,对比了条件随机场(CRF)在实体识别上的优势。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?