1. 机器翻译所需要用到的神经网络结构是什么样的

encoder_decoder 是机器翻译所用到的神经网络结构,你也可以称它为seq2seq。encoder_decoder可以解决输入和输出不等长的问题。encoder可以输入转化为一个上下文向量c,再利用decoder可以对c进行解密得到输出序列。

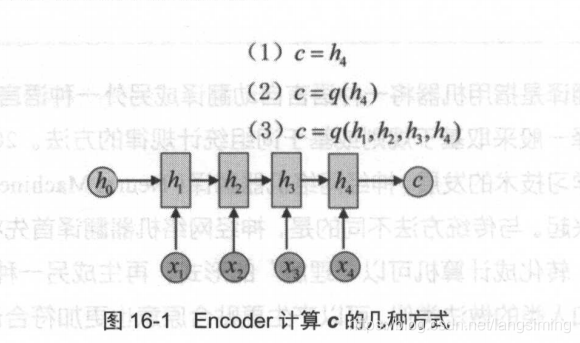

下图显示了得到隐状态c的几种方式:

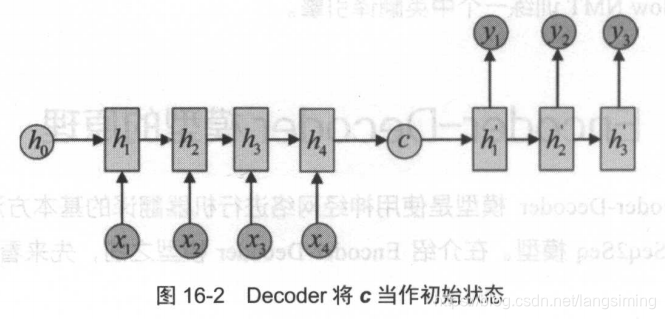

再得到隐状态c后,再利用RNN网络对c进行解码。解码过程如下图:

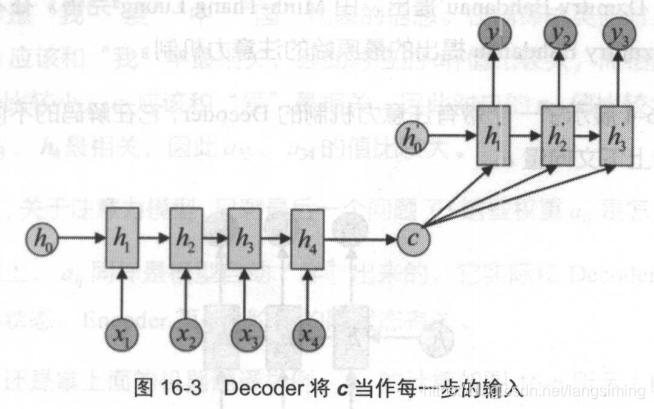

还有一种方式是将c作为每一步的输入,如下图:

注意力机制的引入

注意力机制引入的原因是当句子过长时,一个上下文c不能很好的区分一句话中每个词之间的不同含义。

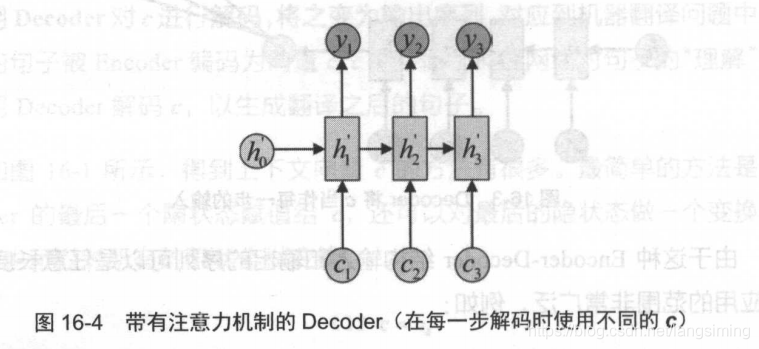

在引入decoder机制后,解码器的结构变成了下图所示的样子

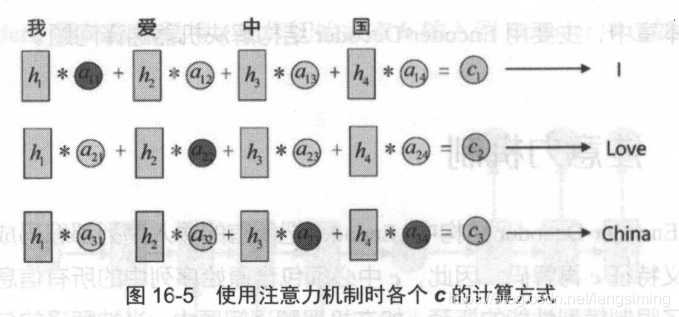

使用注意力机制后,每一个 c 会自动选取与当前所要输出的 y 最合适的上下文信息 。 具体来说,用 aij 衡量 Encoder 中第j 阶段的 hj和解码时第 i 阶段的相关性,最终 Decoder 中第 i 阶段输入的上下文信息 C来自于所高 hj 对aij 的加权之相 。以机器翻译为例(将中文翻译成英文),每一个c的具体计算方法如图。

本文深入探讨了机器翻译中使用的encoder_decoder神经网络结构,即seq2seq模型,该模型能处理输入输出长度不等的问题。文章详细解释了通过RNN进行编码和解码的过程,并介绍了注意力机制的引入,以解决长句子翻译时上下文信息不足的问题,使解码器能够关注到源句子中与当前输出最相关的部分。

本文深入探讨了机器翻译中使用的encoder_decoder神经网络结构,即seq2seq模型,该模型能处理输入输出长度不等的问题。文章详细解释了通过RNN进行编码和解码的过程,并介绍了注意力机制的引入,以解决长句子翻译时上下文信息不足的问题,使解码器能够关注到源句子中与当前输出最相关的部分。

4158

4158

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?