配置spark

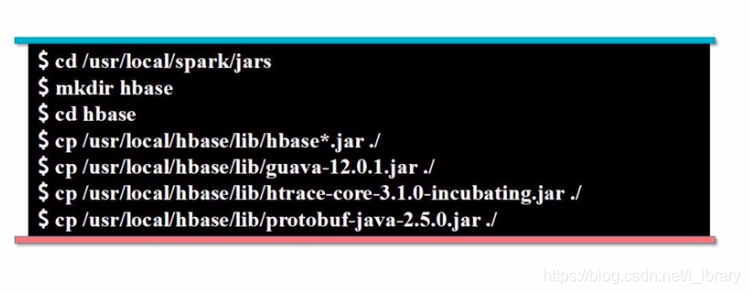

- 将hbase的lib目录下的一些jar包拷贝到spark的jar目录

cd /usr/local/spark/jars

mkdir hbase

cd hbase

cp /usr/local/hbase/lib/hbase*.jar ./

cp /usr local/hbase/lib/guava-12.0.1.jar ./

cp /usr/local/hbase/lib/client-facing-thirdparty/htrace-core4-4.2.0-incubating.jar ./

cp /usr/local/hbase/lib/protobuf-java-2.5.0.jar ./

在运行spark-submit **.py文件之前需要启动habse和hadoop.不然会报错.

启动命令:

cd /usr/local/hadoop-3.2.1

./sbin/start-all.sh

cd /usr/local/hbase

./bin/start-hbase.sh

最后可以运行spark-submit .py

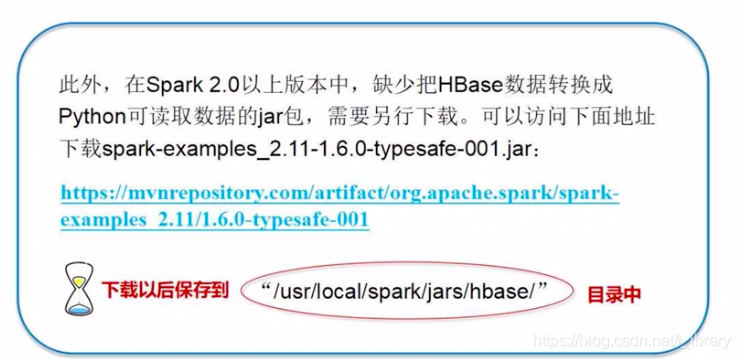

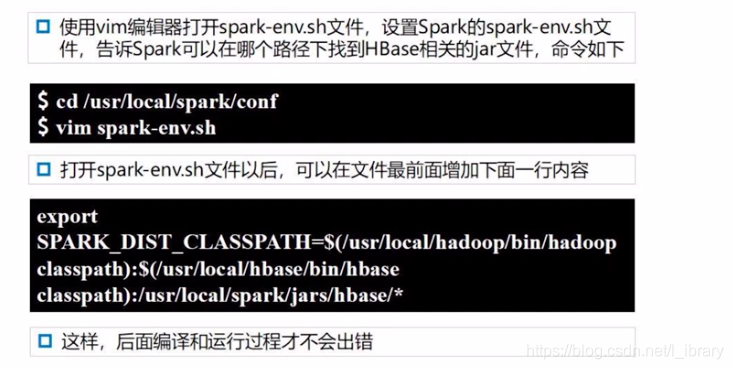

本文详细介绍如何在Spark环境中配置HBase,包括将HBase的jar包复制到Spark的jars目录,以及启动HBase和Hadoop的必要步骤。确保在运行spark-submit脚本前,正确设置环境,避免运行时出现错误。

本文详细介绍如何在Spark环境中配置HBase,包括将HBase的jar包复制到Spark的jars目录,以及启动HBase和Hadoop的必要步骤。确保在运行spark-submit脚本前,正确设置环境,避免运行时出现错误。

9319

9319

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?