近几年Python是越来欲火了而且它的使用范围的确比较广而且感觉相对java更贴近生活(说的就是你爬虫老哥),我们可以用python来做很多有意思的东西,有时候也可以大大的提高工作效率,话不多说,开搞。

软件准备:

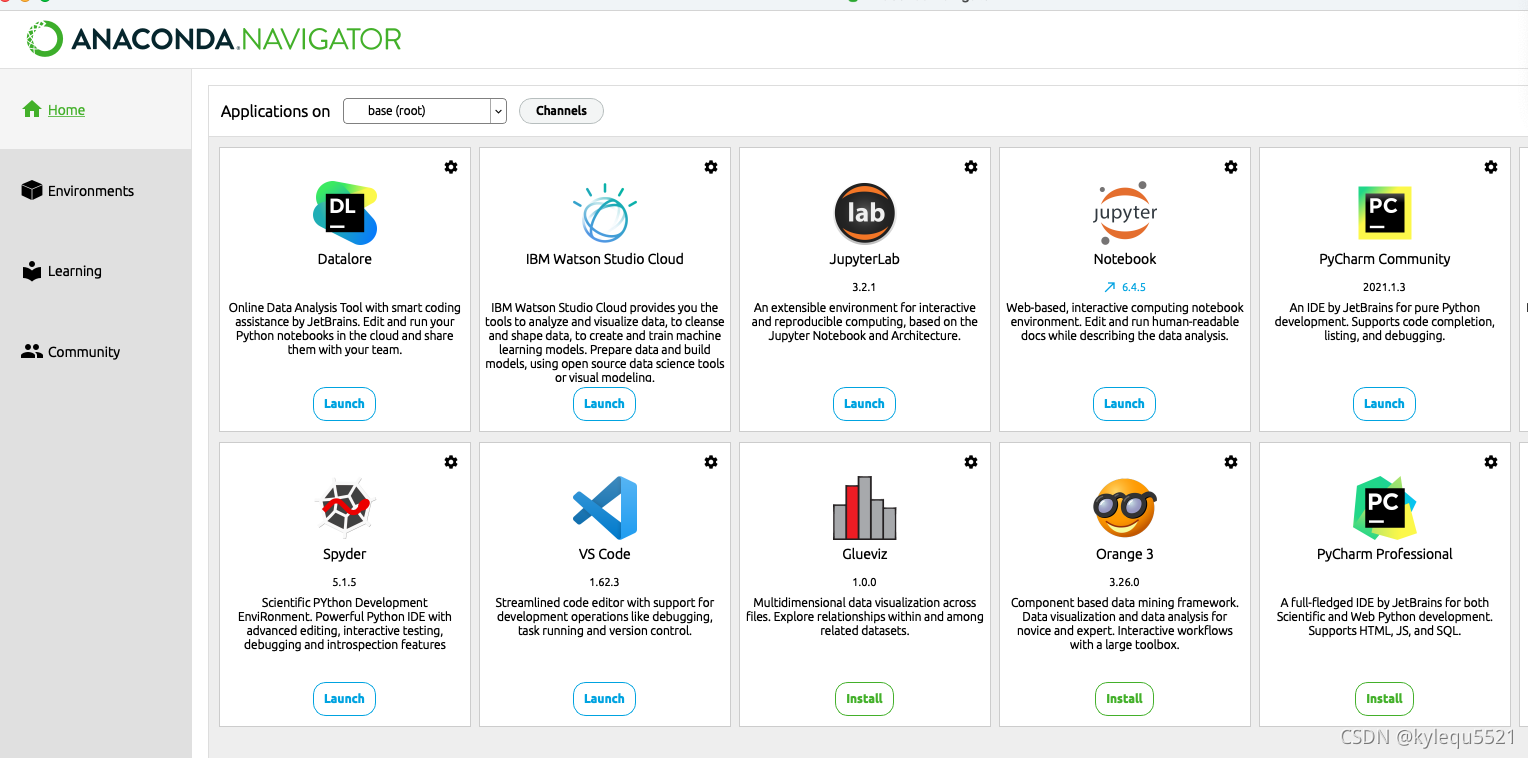

Anaconda:

安装地址:Installation — Anaconda documentation

说明:

- 管理python版本,比如python2, python3

- 管理python的本地环境,比如base, qa, prod

- 管理python按照的依赖包

PyCharm IDE

下载地址: 下载 PyCharm:JetBrains 为专业开发者提供的 Python IDE

如果你已经装好了Anaconda可以直接在里面一键按照IDE

项目测试

- 打开PyCharm 新建一个python项目(因为我这边是local项目懒得一直切换环境所以就设置一个base环境,然后所有的项目都公用这个)

本文介绍了如何安装和配置Python开发环境,包括Anaconda的安装和管理不同Python版本及环境,以及PyCharm IDE的使用。通过Anaconda可以方便地管理依赖包,而PyCharm则提供了便捷的项目管理和代码执行功能。对于初学者,Python的易用性和广泛的应用使其成为理想的选择,尤其在爬虫和自动化任务中。熟悉Python基础语法将有助于提升工作效率。

本文介绍了如何安装和配置Python开发环境,包括Anaconda的安装和管理不同Python版本及环境,以及PyCharm IDE的使用。通过Anaconda可以方便地管理依赖包,而PyCharm则提供了便捷的项目管理和代码执行功能。对于初学者,Python的易用性和广泛的应用使其成为理想的选择,尤其在爬虫和自动化任务中。熟悉Python基础语法将有助于提升工作效率。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

725

725

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?