[1]LayerDrop: https://arxiv.org/abs/1909.11556

[2]DistillBERT: https://arxiv.org/abs/1910.01108

[3]TinyBERT: https://arxiv.org/abs/1909.10351

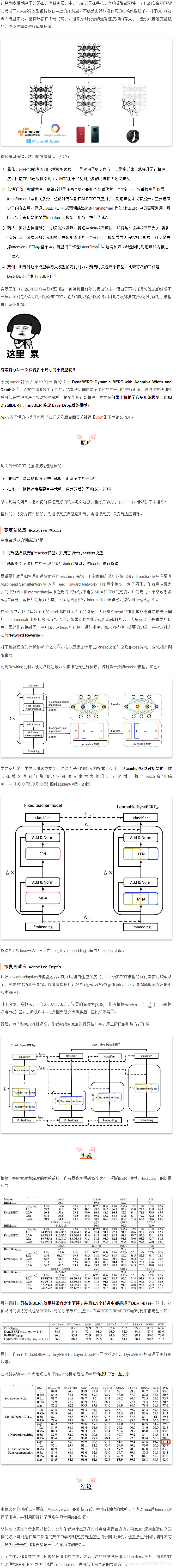

[4]DynaBERT: https://www.researchgate.net/publication/340523407_DynaBERT_Dynamic_BERT_with_Adaptive_Width_and_Depth

[5]Analyzing multi-head self-attention: https://arxiv.org/abs/1905.09418

[6]Minilm: https://arxiv.org/abs/2002.10957

DynaBERT和fastbert bert 速度提升

最新推荐文章于 2025-06-12 09:00:45 发布

本文综述了多种深度学习模型压缩技术,包括LayerDrop、DistillBERT、TinyBERT、DynaBERT等方法,旨在降低计算成本并提高模型效率。通过模型剪枝、量化、知识蒸馏等手段,这些技术在保持较高准确率的同时显著减小模型大小。

本文综述了多种深度学习模型压缩技术,包括LayerDrop、DistillBERT、TinyBERT、DynaBERT等方法,旨在降低计算成本并提高模型效率。通过模型剪枝、量化、知识蒸馏等手段,这些技术在保持较高准确率的同时显著减小模型大小。

8506

8506

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?