第一章:MaxKB部署

MaxKB = Max Knowledge Base,是一款基于大语言模型和 RAG

的开源知识库问答系统,广泛应用于智能客服、企业内部知识库、学术研究与教育等场景。

maxkb官网,首先我们先部署一个maxkb,官网支持离线、在线等方式部署,详细可以查看官网教程,这里介绍一下在线部署

1 部署要求

服务器配置

部署服务器要求:

操作系统:Ubuntu 22.04 / CentOS 7.6(7.4版本亲测也可以) 64 位系统 CPU/内存:4C/8GB 以上

磁盘空间:100GB

端口要求

在线部署 MaxKB 需要开通的访问端口说明如下:

22 SSH 安装、升级及管理使用

8080 Web 服务端口 默认 Web 服务访问端口,可根据实际情况进行更改

2 在线快速部署

MaxKB 支持一键启动,仅需执行以下命令:

这里注意,官网的部署命令在实操过程中发现docker会跟服务器网络有隔离,如果你的ollama与maxkb不在一个网络,配置的时候会提示API域名无效,经过验证需要再docker启动命令上加

–network host 来共享主机网络。

Linux 操作系统

以下/home可以改为自己实际目录,看数据盘在哪个目录。

docker run -d --name=maxkb --network host --restart=always -p 8080:8080 -v /home/.maxkb:/var/lib/postgresql/data -v /home/.python-packages:/opt/maxkb/app/sandbox/python-packages registry.fit2cloud.com/maxkb/maxkb

Windows 操作系统

windows未验证,请自行尝试!

docker run -d --name=maxkb --restart=always -p 8080:8080 -v C:/maxkb:/var/lib/postgresql/data -v C:/python-packages:/opt/maxkb/app/sandbox/python-packages registry.fit2cloud.com/maxkb/maxkb

待所有容器状态显示为healthy后,可通过浏览器访问 MaxKB:

最后把下面地址映射出来即可。实际也可以自己修改8080端口,不再赘述。

http://目标服务器 IP 地址:8080

默认登录信息 用户名:admin 默认密码:MaxKB@123…

第二章:ollama部署

ollama部署其实很简单,两个命令就行了。

ollama官网下载

linux服务器执行下面命令开始下载ollama

curl -fsSL https://ollama.com/install.sh | sh

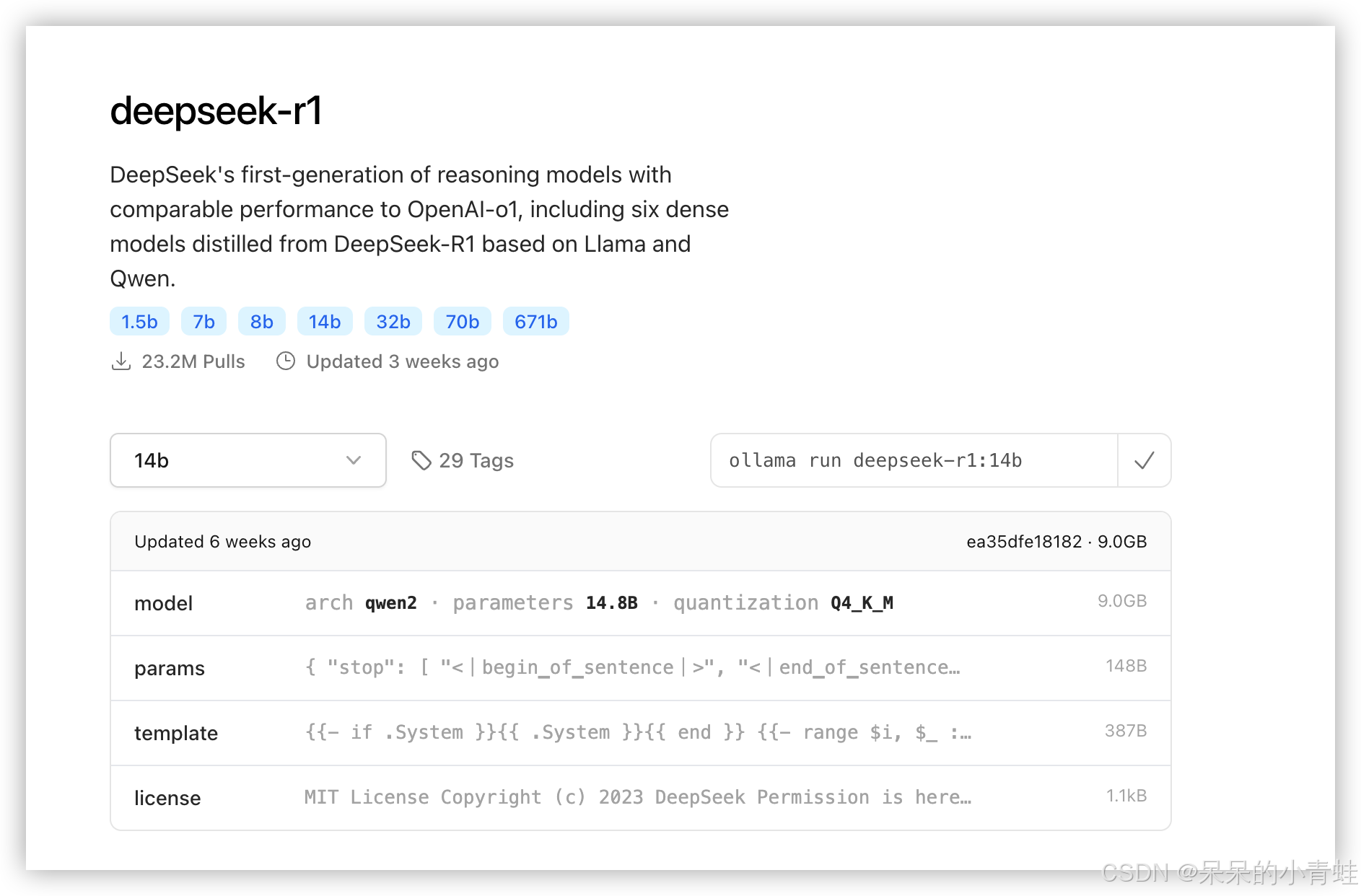

下载完成后访问ollama官网查找自己喜欢的大模型,比如deepseek

模型选择

如下载 14B的语句

ollama run deepseek-r1:14b

复制命令执行后就可以了。但是默认下载的是占用根目录空间,linux更改ollama路径可以参考下面的方法。

这里要注意,我们经常需要把ollama安装在数据盘,所以需要更改下载的路径,以下是修改ollama默认路径的方法和开启全网段访问

1、创建新的模型存储目录:

首先,创建一个新的目录作为模型存储路径。例如,创建/data/ollama/models目录: sudo mkdir -p /home/ollama/models

- 更改目录权限: 确保新目录的权限设置正确,允许Ollama访问和写入:

sudo chown -R ollama:ollama /home/ollama/models

sudo chmod -R 775 /home/ollama/models

3、修改Ollama服务配置文件

编辑服务配置文件: 使用文本编辑器(如vim)编辑Ollama服务的配置文件:

sudo vi /etc/systemd/system/ollama.service

修改配置内容:

在[Service]部分的Environment字段后,添加新的Environment字段,指定新的模型路径:

Environment=“OLLAMA_MODELS=/data/ollama/models”

完整的配置示例如下:

[Service]

Environment="OLLAMA_MODELS=/data/ollama/models"

Environment="OLLAMA_HOST=0.0.0.0"

Environment="OLLAMA_ORIGINS=*"

重载配置并重启Ollama服务重载系统服务配置:

sudo systemctl daemon-reload

重启Ollama服务:

sudo systemctl restart ollama.service

查看服务状态:

sudo systemctl status ollama

#启动deepseek

ollama run deepseek-r1:14b

第三章:MaxKB配置ollama

配置模型

本地的api key 随便填个字符即可。如果遇到提示API 域名无效,参考第一章相关内容。

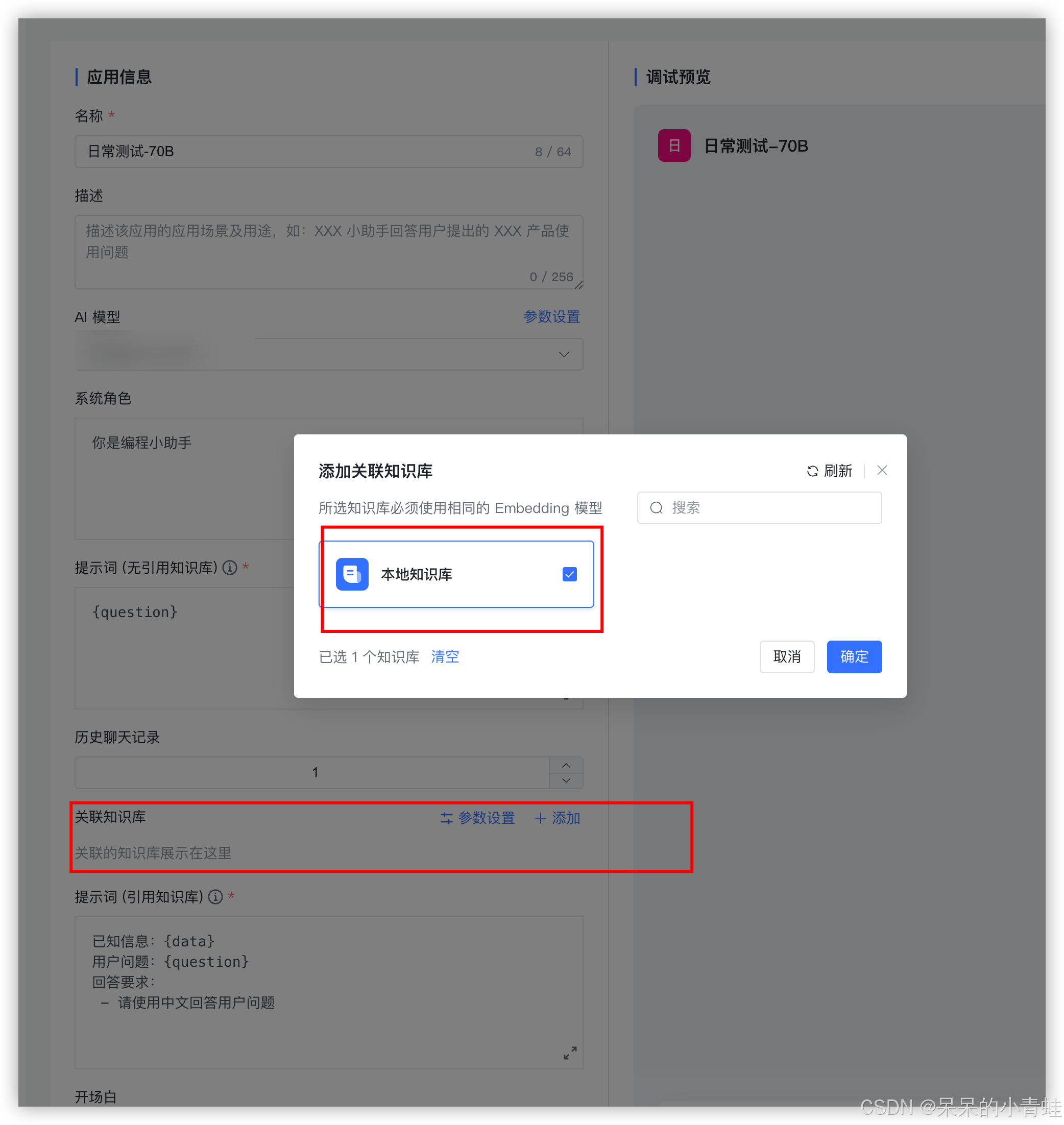

创建知识库

根据后续界面上传本地文档

等待分段后,点击开始导入。

等待索引成功后添加应用就可以关联这个知识库了。

创建应用

剩下就是选择刚刚配置的大模型,编写一些话术,不再赘述。然后就可以点击应用进行预览,设置api key ,这样就可以对外开放安全的api了。

也可以直接复制他的内嵌代码到想要集成的应用里面

接下来点击演示就可以开始对话测试了

至此结束,祝各位顺利完成部署。

创作不易,望一键三连。

3302

3302

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?