#[TOC] 深度学习的一些重要概念、

在学习《深度学习入门》的过程中,接触到一些重要概念,先记录如下:

- 感知机:单层感知机只能解决线性问题;要解决复杂的非线性问题,可以通过叠加多层感知机来实现

- 神经网络的权重和偏置的设定也遵循一定的规律:relu函数使用He氏初始值,而sigmoid 和tanh函数使用Xavier初始值

- 各种激活函数: relu, sigmoid, tanh, 阶跃函数

- 输出层的设计:回归问题使用恒等函数,分类问题使用softmax函数

-

学习率,轮数(epoch), 批处理(batch size)

-

矩阵乘法,导数,计算图

-

正规化(normalization), 正则化(regularization), 预处理(pre-processing), 后处理(post-processing), 过拟合(over fitting), one-hot encoding

-

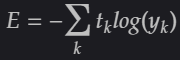

损失函数: 交叉熵误差(cross entropy error) 和均方误差(mean squared error)

-

数据随机抽取,前向传播,后向传播

-

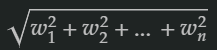

损失函数优化: 梯度下降法(SGD),Momentum, AdaGrad, Adam, 学习率衰减 , L1/L2范数

-

使用Batch Normalization, Dropout

-

在卷积神经网络里的im2col函数

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?