WebRTC音频引擎的实现代码主要分布在如下几个源码目录中:

webrtc/audio

webrtc/common_audio

webrtc/media/engine

webrtc/voice_engine

//音频编解码

webrtc/module/audio_coding

//接收端混音

webrtc/module/audio_conference_mixer

//音频输入输出设备

webrtc/module/audioDevide

//音频预处理(消回音、自动增益、降噪等)

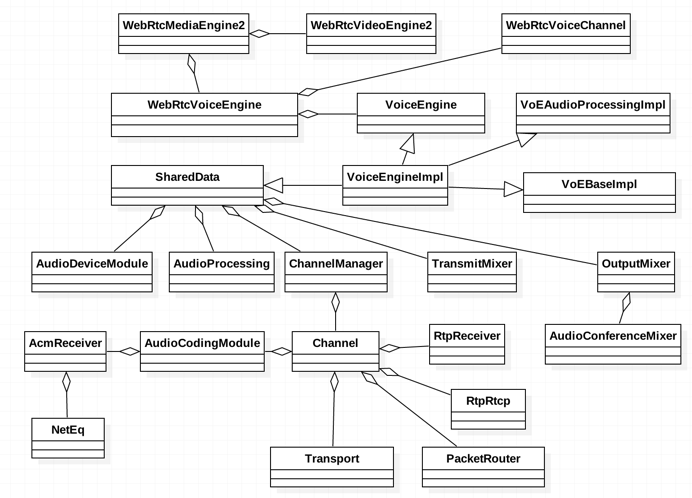

webrtc/module/audio_processing语音引擎架构图:

重要的几个类:

VoEBaseImpl;

SharedData:聚合类,包含一些重要的对象;

Channel:负责一路音频数据的重要操作,包括音频数据的前处理(消回音、降噪、自动增益)、编解码、发送、接受、后处理(混音)

VoEBaseImpl是连接底层音频采集播放模块AudioDeviceModule和音频引擎内部音频通道Channel的重要纽带。它实现三个接口:VoEBase负责创建Channel、启动/停止音频数据的发送/接收;AudioTransport负责AudioDeviceModule模块和Channel之间数据传送,包括采集后的音频数据发送到Channel进行编码、从Channel拉取解码后的音频数据进行播放;AudioDeviceObserver负责把AudioDeviceModule工作过程中出现的错误和警告向上层报告。

内容部分参考:

本文深入探讨WebRTC音频引擎架构,覆盖音频采集、预处理、编解码、网络传输及混音全过程。介绍核心模块如AudioDeviceModule、AudioProcessing、AudioCodingModule的功能与交互。

本文深入探讨WebRTC音频引擎架构,覆盖音频采集、预处理、编解码、网络传输及混音全过程。介绍核心模块如AudioDeviceModule、AudioProcessing、AudioCodingModule的功能与交互。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

653

653

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?